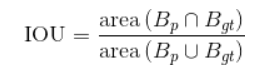

1. iou

iou由预测的包围盒与truth包围盒的交集,除以它们之间的联合区域(p代表预测框,gt代表真值框)

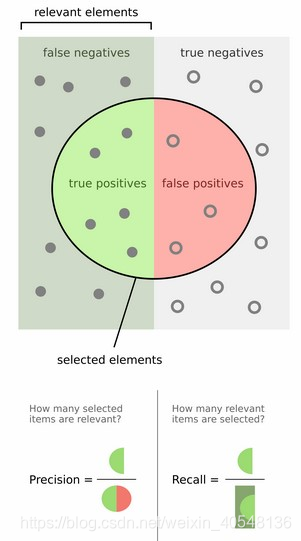

2. precision(查准率)recall(查全率)

precision/recall是针对于所有图片的某一类来说。

使用训练好的模型得到所有测试样本的confidence score,假设有20个测试样本,排序结果如下:

我们将上面数据对应到下图,选择top-5预测模型好坏,那么,圆圈内预测的真值(true positives + false positives)对应的就是top-5的结果,true positive就是id为2 4的照片,false positives是指id为13 19 6的照片。圆圈外gt_label为1的则是false negatives,gt_label为0的则是true negatives。

那么,这个例子中Precision=2/5=40%,意思是对于car这一类别,我们选定了5个样本,其中正确的有2个,即准确率为40%;Recall=2/6=30%,意思是在所有测试样本中,共有6个car,但是因为我们只召回了2个,所以召回率为30%。

3. AP(平均精度)

AP也是针对所有图片内的某一类的。

AP有两种算法:

第一种算法:首先设定一组recall阈值,[0,0.1,0.2,…,1],然后对每个recall阈值从小到大取值,同时计算当取大于该recall阈值时top-n所对应的的最大precision,这样,我们就计算了11个precision。AP即为这11个precision的平均值。这种方法英文名叫做11-point interpolated average precision。

第二种算法:假设N个样本有M个正例,我们会得到M个recall值(1/M,2/M,…,M/M),对于每个recall值r,该阈值对应top-n的最大precision,然后对这M个precision取平均值得到AP。

上图为top-20,随着recall的增加,precision随之变化,当遇到正样本时,recall才变化,遇到负样本时,recall不变,当前最大precision也不变,相应的precision-recall曲线如下:

4.mAP(平均精度均值)

mAP的对象是所有类的图片,衡量的是训练的模型在所有类别上的好坏。C为类数目。

本文深入解析目标检测任务中的关键评估指标,包括IoU、Precision、Recall、AP及mAP,阐述其计算方法与意义,帮助理解模型性能。

本文深入解析目标检测任务中的关键评估指标,包括IoU、Precision、Recall、AP及mAP,阐述其计算方法与意义,帮助理解模型性能。

9万+

9万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?