DeepSeek Coder 是由 DeepSeek AI 推出的一系列代码生成模型,旨在解决编程中的各种任务,如代码生成、补全、调试和优化等。以下是对该模型的详细分析:

模型背景与特点

-

模型规模与训练数据:

- DeepSeek Coder 系列模型从头开始训练,覆盖了超过80种编程语言,总参数量从1B到33B不等,其中包含基础版和指令调优版。

- 模型基于高质量的代码数据集进行训练,包含约2万亿个 token,其中87%为代码数据,13%为自然语言数据,支持中文和英文。

-

性能表现:

-

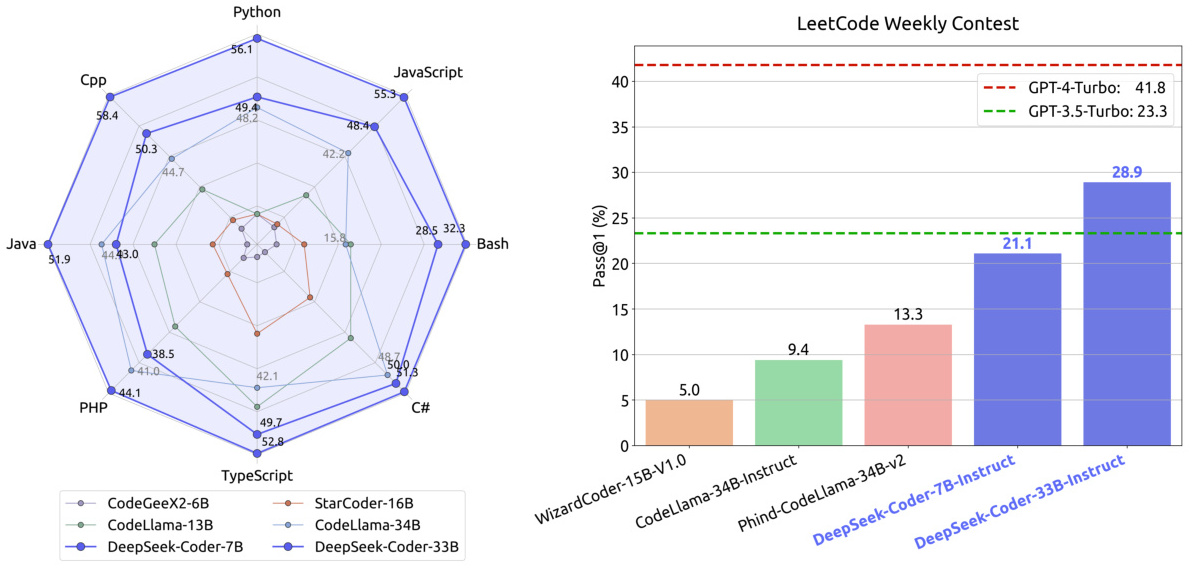

在多个编程任务中,DeepSeek Coder 的表现优于其他开源模型,例如 CodeLlama 和 StarCoder。例如,在 LeetCode 周赛任务中,DeepSeek Coder-7B-Instruct 的平均得分高于其他模型。

-

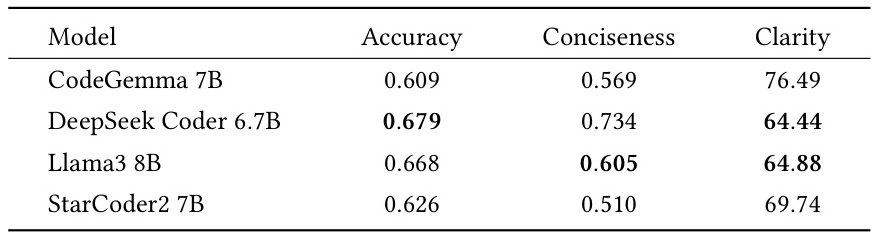

在代码生成任务中,DeepSeek Coder 的准确率、简洁性和清晰度均表现良好,例如在 Python 代码生成任务中,其准确率为0.679,简洁性为0.734。

-

-

功能与应用:

- DeepSeek Coder 不仅可以生成代码,还能修复错误、编写 SQL 查询、生成测试样例,并支持多种编程语言。

- 它还支持多语言环境下的代码生成和调试,适用于复杂项目开发和日常编程任务。

-

最新进展:

- DeepSeek Coder V2 是该系列的最新版本,采用了混合专家(MoE)架构,支持更大的上下文窗口(最大128K tokens),并显著提升了编码和数学推理能力。

- DeepSeek Coder V2-Lite 是其轻量级版本,参数规模为16B,支持338种编程语言,适用于更广泛的编程场景。

技术细节与优化

-

模型架构:

- DeepSeek Coder 基于 Transformer 架构,通过掩码跨度预测(MSP)策略和指令微调技术进一步提升了代码生成能力。

- 模型在预训练阶段引入了存储库级别的数据,以增强跨文件代码生成能力。

-

性能优化&#x

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2719

2719

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?