重启机制(Cosine Annealing with Restarts)是一种结合了余弦退火(Cosine Annealing)和热重启(Warm Restarts)的学习率调度策略,其主要目的是通过动态调整学习率来优化神经网络的训练性能。这种机制在多个领域和任务中被证明能够显著提升模型的收敛速度和最终性能。以下从多个角度详细分析其对模型性能的影响:

1. 帮助模型跳出局部最小值

余弦退火通过逐渐降低学习率,使模型能够更深入地探索损失函数的曲面,从而更容易找到全局最优解或更优的局部最小值。而热重启则通过在训练过程中定期重置学习率至较高值,使模型能够重新开始优化过程,从而跳出当前的局部最小值。这种结合策略能够有效避免模型陷入局部最优,提高模型的泛化能力。

2. 加速收敛

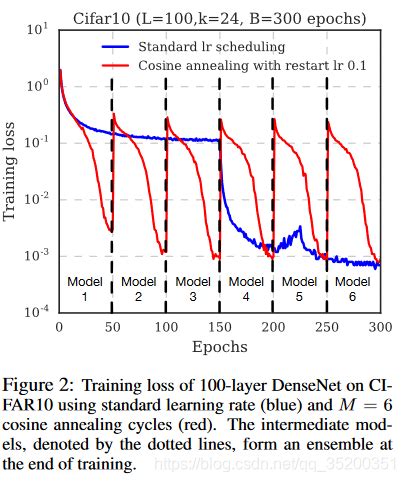

重启机制通过在每个重启周期结束时重置学习率,使模型能够在新的学习率下重新探索损失曲面。这种策略不仅提高了模型的收敛速度,还减少了达到收敛所需的迭代次数。例如,在CIFAR-10和CIFAR-100数据集上的实验表明,使用带有热重启的余弦退火策略(SGDR)可以比传统的学习率策略减少约2~4倍的训练周期,同时在多个基准测试中取得了更好的性能。

3. 提高模型的鲁棒性和泛化能力

重启机制通过在训练过程中引入随机性,使模型在不同的学习率下进行优化,从而增强了模型对不同数据分布的适应能力。例如,在跨语言翻译任务中,通过结合MixUp数据增强和热重启余弦退火策略,模型展示了更强的鲁棒性和泛化能力。此外,重启机制还被证明能够提高模型在复杂任务中的表现,如图像分割、语音合成和生物信息学中的蛋白质结构预测等。

4. 减少过拟合风险

重启机制通过动态调整学习率,能够有效减少模型在训练后期因学习率过低而导致的过拟合问题。例如,在化学分子预测任务中,通过结合余弦退火和热重启策略,模型在验证集上的表现更加稳定,避免了因训练时间过长而导致的过拟合。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1911

1911

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?