简介:多任务分支深度学习结合了深度学习和多任务学习的优势,通过共享特征提取和任务特定优化,提高解决多任务问题的效率和准确性。在计算机视觉和自然语言处理等多个领域中,这种模型能够同时处理多个相关任务,提升性能并减少冗余计算。尽管面临挑战,例如任务冲突和资源需求增加,但通过优化策略,可以有效应对并推动AI技术的发展。

1. 多任务分支深度学习定义与优势

随着AI技术的飞速发展,多任务分支深度学习作为一种先进的学习方法,在处理复杂任务和信息时表现出了显著的优势。它的核心是同时训练一个深度学习模型来完成多个相互关联的任务,这不仅提高了模型的利用率,而且还能通过任务间的知识共享提升性能。

1.1 多任务分支深度学习的定义

多任务分支深度学习是一种利用单个深度神经网络同时解决多个不同但相关的任务的技术。该方法侧重于模型的多任务能力,即模型不仅要能识别和处理多个任务,而且要能在这些任务间高效地共享信息和学习到的知识。

1.2 多任务分支深度学习的优势

采用多任务分支深度学习的优势主要体现在以下几个方面:

- 资源优化 :通过共享网络层,可以减少重复的计算和存储资源消耗。

- 学习效率提升 :多任务学习能够加速模型收敛,减少训练时间。

- 性能增强 :任务间知识共享有助于提升模型在各个任务上的表现,尤其是对于数据稀少的任务,多任务学习可以显著提高其性能。

在接下来的章节中,我们将深入了解深度学习的基础理论,探讨其在人工智能中的角色,以及多任务学习如何通过不同的训练策略和应用实例来实现知识共享和性能优化。

2. 深度学习在人工智能中的角色

2.1 深度学习基础理论

2.1.1 神经网络与反向传播算法

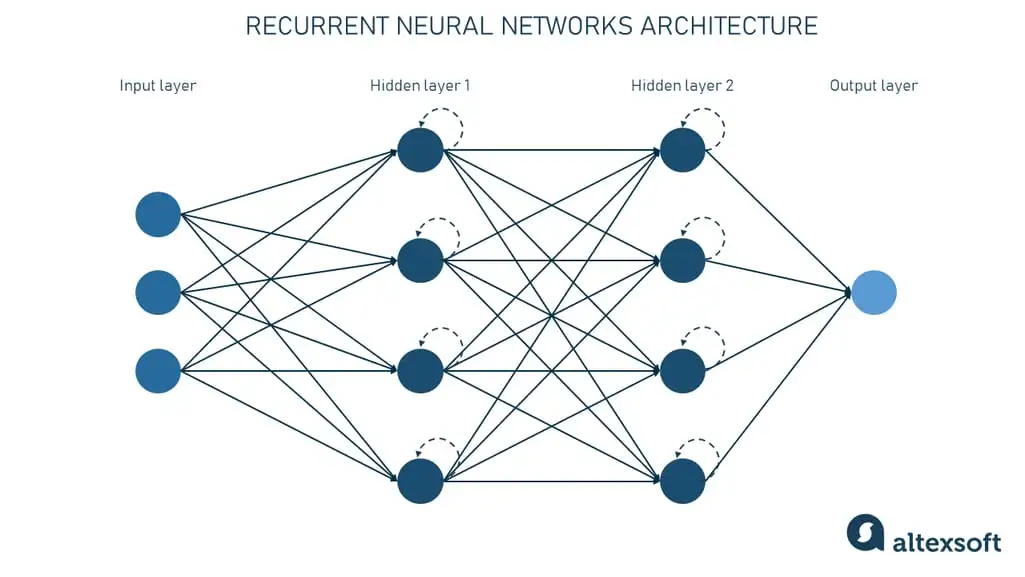

深度学习的核心是模拟人脑处理信息的机制。神经网络是一种旨在模仿人脑结构和功能的信息处理模型,它由许多简单的、相互连接的处理单元(即神经元)组成。每两个神经元之间的连接都有一个权重值,这些权重值决定了信息在网络中的流动。

反向传播算法是训练神经网络的一种有效方法,它基于链式求导法则来高效计算梯度。通过这个算法,模型能够自动调整各神经元间的权重,最小化损失函数,使得网络的输出与实际数据之间的误差尽可能小。

import numpy as np

# 模拟一个简单的神经元输入输出过程

def sigmoid(x):

return 1 / (1 + np.exp(-x))

# 假设输入层有两个神经元,输出层有一个神经元

input_layer = np.array([0.5, 0.2])

weights = np.array([0.3, -0.2])

bias = 0.1

# 前向传播计算输出

output = sigmoid(np.dot(input_layer, weights) + bias)

print("输出层输出:", output)

上面的代码中, sigmoid 函数用于模拟神经元的激活函数,输入层与权重向量相乘,再加上偏置项后,再通过 sigmoid 函数进行非线性变换得到输出。

2.1.2 深度学习的激活函数与损失函数

激活函数是神经网络中非常重要的组成部分,它决定了输入与输出之间的非线性关系,使得网络能够学习和表示复杂的函数。常见的激活函数包括Sigmoid函数、Tanh函数、ReLU函数等。

损失函数用于衡量模型预测值与实际值之间的差异,它反映了模型的性能。在深度学习中,常用的损失函数包括均方误差(MSE)、交叉熵损失等。

def mse_loss(y_true, y_pred):

return np.mean((y_true - y_pred) ** 2)

# 假设真实的输出和预测的输出

y_true = np.array([0.6, 0.8])

y_pred = np.array([0.55, 0.75])

# 计算损失值

loss = mse_loss(y_true, y_pred)

print("损失值:", loss)

上述代码中定义了MSE损失函数,并计算了真实输出与预测输出之间的损失值。

2.2 深度学习在不同AI领域的应用

2.2.1 图像识别

图像识别是深度学习在计算机视觉中的一个主要应用,借助于卷积神经网络(CNN),深度学习模型可以高效地从图像中提取特征并识别不同的物体。

2.2.2 语音识别与合成

深度学习在语音识别领域同样取得了重大进展,模型可以将语音信号转化为文本信息。与此同时,深度学习也被用于语音合成,使得机器能够模拟人类的发音。

2.2.3 强化学习与机器人技术

深度学习与强化学习结合,使机器人能够在环境的反馈中学习并优化自身的策略。这在游戏、机器人控制等领域均有显著的应用。

深度学习技术推动了人工智能的发展,它在多个领域的应用证明了其强大的学习和泛化能力。在下一章节中,我们将深入探讨多任务学习的理论基础,了解如何通过深度学习实现知识共享与任务间的协同进步。

3. 多任务学习与知识共享

多任务学习(MTL)是一种旨在利用多个任务之间的关系,共同训练模型以提高每个任务性能的技术。在这一章节中,我们将深入了解多任务学习的理论基础,探讨其在知识共享中的优势以及如何设计有效的训练策略。

3.1 多任务学习的理论基础

3.1.1 多任务学习的定义和动机

多任务学习是一种机器学习范式,它通过同时训练一个模型来执行多个相关任务,期望模型能够通过学习任务间共享的表示来改善所有任务的性能。其动机主要源自以下两点:

- 知识共享 :不同任务之间往往存在共通性,多任务学习旨在捕捉和利用这些共性,以促进知识在任务间的流动和共享。

- 数据效率 :在某些任务中可用的数据量可能较小,而多任务学习能够使得模型从相关任务的数据中学习通用的特征,提高模型对少量数据的学习能力。

3.1.2 知识共享机制与优势

多任务学习的知识共享机制主要表现在以下两个方面:

- 参数共享 :不同任务共享网络的一部分参数(如卷积层或循环层的权重),这有助于模型更好地泛化至未见过的数据。

- 特征重用 :各个任务可以利用其他任务学到的特征,这不仅减少了模型的复杂度,还提高了单个任务的性能。

多任务学习的优势包括:

- 提升性能 :通过多任务学习,模型通常能在一个或多个任务上获得更好的性能。

- 减少过拟合 :共享的网络结构促使模型学习更具有泛化性的特征表示,从而降低过拟合的风险。

- 数据利用效率 :多任务学习可以使模型从较少数据的任务中获益,通过任务间的知识转移提升学习效果。

3.2 多任务学习的训练策略

3.2.1 硬参数共享与软参数共享

在多任务学习中,参数共享是一种重要策略,它可分为硬参数共享和软参数共享:

- 硬参数共享 :在多任务网络中,共享层的参数被所有任务共享。这种方法的直观理解是,共享层学习到的特征是任务无关的,而任务特定层则负责从这些共享特征中提取任务相关的信息。

- 软参数共享 :软参数共享则更加灵活,每个任务都有自己的参数集合,但通过某种正则化项(如L2正则化或KL散度)鼓励任务间的参数相似。这允许不同的任务拥有一定程度的参数差异,以更好地适应各自的特点。

3.2.2 多任务学习的损失函数设计

多任务学习的性能在很大程度上取决于损失函数的设计。损失函数需要平衡各任务间的性能,常用的策略有:

- 加权损失 :为每个任务分配不同的损失权重,通常根据任务的重要性和难度动态调整。

- 梯度剪切 :通过剪切负梯度(对损失函数进行梯度下降)来平衡任务间的贡献,防止某一任务主导整个优化过程。

- 平衡策略 :例如使用最小-最大损失函数,使所有任务损失最小化的同时,也追求任务间的损失均衡。

3.2.3 任务之间的关系建模

有效建模任务间的关系是多任务学习成功的关键。常见的关系建模方法有:

- 多任务网络结构 :如使用共享-私有的网络结构(Shared-Private Network Architectures),直接在网络中体现任务间的关系。

- 基于注意力的机制 :引入注意力机制,使模型能够根据任务的不同需求动态调整对于共享特征的侧重。

- 图神经网络 :使用图神经网络来模拟任务间的复杂关系,实现更灵活的任务相关性学习。

为了进一步了解多任务学习的复杂性,我们可以从以下几个方面更深入地讨论这一话题。

4. 计算机视觉中的多任务学习应用

计算机视觉(Computer Vision, CV)是人工智能领域的一个核心分支,它致力于使计算机能够从图像或视频中提取信息,并理解视觉世界。多任务学习在计算机视觉中的应用极大扩展了算法的能力,使其能够同时处理多个视觉任务并从中受益。接下来将深入探讨多任务学习在视觉任务中的表现,以及在自动驾驶领域的应用实例。

4.1 多任务学习在视觉任务中的表现

多任务学习通过联合训练能够显著提高任务的性能。在计算机视觉任务中,多任务学习展现了对视觉信息的深入理解能力。

4.1.1 图像分类与目标检测

图像分类(Image Classification)是将输入图像分配给某个类别的任务,目标检测(Object Detection)则不仅需要识别图像中的物体,还需要定位这些物体。多任务学习通过共享特征提取层,使得分类任务和目标检测任务可以相互辅助,提升模型的整体性能。

# 示例代码块:使用PyTorch框架进行图像分类和目标检测的多任务学习

import torch

import torch.nn as nn

from torchvision.models.detection import FasterRCNN

from torchvision.models.detection.faster_rcnn import FastRCNNPredictor

class MultiTaskModel(nn.Module):

def __init__(self):

super(MultiTaskModel, self).__init__()

# 定义共享的特征提取层

self.backbone = torchvision.models.resnet50(pretrained=True).features

# 定义分类任务头部

self.classifier = nn.Sequential(

nn.Linear(2048, 1024),

nn.ReLU(),

nn.Linear(1024, 10) # 假设有10个分类

)

# 定义目标检测任务头部

num_classes = 2 # 假设有2个类别需要检测

in_features = 2048

self.detector = FasterRCNN(torchvision.models.resnet50(pretrained=True), num_classes)

def forward(self, x):

# 前向传播共享特征提取层

x = self.backbone(x)

# 分类任务的输出

classification_output = self.classifier(x)

# 目标检测任务的输出

detection_output = self.detector(x)

return classification_output, detection_output

# 模型实例化和训练省略...

在上述代码中,我们首先定义了一个包含共享特征提取层的多任务学习模型,该模型同时具备图像分类和目标检测的能力。分类头部使用了一个简单的全连接层结构,而目标检测头部使用了预训练的 FasterRCNN 模型。

4.1.2 视觉跟踪与分割

视觉跟踪(Visual Tracking)是实时追踪视频序列中的目标,而图像分割(Image Segmentation)则是将图像中的每个像素分配到特定的类别中。多任务学习在这些任务中可以共享高层特征表示,使模型更有效地处理视频中的连续帧数据。

4.2 实例分析:多任务学习在自动驾驶中的应用

自动驾驶是计算机视觉应用的集大成者,涉及多个视觉任务,如识别交通标志、行人检测、车道线识别、车辆跟踪等。

4.2.1 自动驾驶中的视觉识别任务

在自动驾驶系统中,视觉识别任务是实现车辆导航和决策的核心。多任务学习能够整合这些视觉任务,使得系统能够更准确地感知环境,提高驾驶的安全性。

flowchart LR

A[输入图像] --> B[共享特征提取层]

B --> C[分类任务]

B --> D[目标检测]

B --> E[视觉跟踪]

B --> F[图像分割]

C --> G[输出分类结果]

D --> H[输出检测框]

E --> I[输出跟踪路径]

F --> J[输出分割图]

style G fill:#f9f,stroke:#333,stroke-width:2px

style H fill:#f9f,stroke:#333,stroke-width:2px

style I fill:#f9f,stroke:#333,stroke-width:2px

style J fill:#f9f,stroke:#333,stroke-width:2px

通过上述流程图,我们可以直观地看到多任务学习模型在自动驾驶视觉识别任务中的数据流动路径。多个视觉任务共享同一个特征提取层,这不仅可以减少计算成本,还可以提高识别的准确性。

4.2.2 多任务学习在场景理解中的角色

场景理解(Scene Understanding)在自动驾驶中至关重要,涉及到对驾驶环境的全面解读,包括道路类型、交通状况、潜在障碍物等。多任务学习模型通过综合处理多种视觉任务,能够更准确地构建起对当前驾驶场景的完整认知。

# 示例代码块:使用PyTorch框架进行场景理解的多任务学习

class SceneUnderstandingModel(nn.Module):

def __init__(self):

super(SceneUnderstandingModel, self).__init__()

# 定义共享的特征提取层

self.backbone = torchvision.models.resnet50(pretrained=True).features

# 定义场景理解任务头部

self.scene_predictor = nn.Sequential(

nn.Linear(2048, 512),

nn.ReLU(),

nn.Linear(512, 3) # 假设场景有3种类型

)

def forward(self, x):

# 前向传播共享特征提取层

x = self.backbone(x)

# 场景理解任务的输出

scene_output = self.scene_predictor(x)

return scene_output

# 模型实例化和训练省略...

在上述代码中,我们定义了一个用于场景理解的多任务学习模型。该模型使用共享的特征提取层,专注于对当前场景类型的预测。

通过这样的多任务学习方法,自动驾驶系统可以在同一个模型中处理多个视觉任务,降低了对资源的需求,同时提升了对驾驶环境的感知能力。这对于实现实时且准确的自动驾驶系统至关重要。

多任务学习的引入使得计算机视觉在自动驾驶等复杂应用中得到了极大的增强。通过共享特征表示和联合优化,模型能够在各个任务中相互促进,实现更优的性能。随着算法和硬件技术的进一步发展,多任务学习将在计算机视觉领域扮演越来越重要的角色。

5. 自然语言处理中的多任务学习应用

5.1 自然语言处理的多任务挑战

在自然语言处理(NLP)中,语言模型是基础构建块。它们通常被设计为处理单一任务,如文本分类或命名实体识别。然而,现实世界的语言使用场景复杂多变,多种语言任务往往需要共享相同的基础知识,例如对语言结构的理解。多任务学习(MTL)在NLP中的应用,正是为了应对这一挑战。

5.1.1 语言模型与任务相关性

多任务学习在NLP中的一个关键挑战是确定哪些任务可以或应该一起学习。任务相关性是这个问题的一个重要考量因素。相关任务通常共享底层语言特征和模式。例如,在机器翻译和语言建模任务中,两者都受益于对语言序列结构的深入理解。任务的相似性有助于在训练期间促进参数的共享,从而提高学习效率和模型性能。

5.1.2 多任务学习中的注意力机制与上下文嵌入

另一个在NLP中采用MTL时的挑战是使用注意力机制和上下文嵌入。注意力机制允许模型动态地关注输入序列的不同部分,这对于诸如机器翻译这样的任务至关重要,因为它可以增强模型对关键信息的理解能力。在多任务学习环境中,注意力机制可以被共享或为每个任务专门定制,这取决于任务的特定需求和数据特征。同时,上下文嵌入,如BERT模型中的嵌入,能够捕获词语在不同上下文中的细微差别。在多任务设置中,共享上下文嵌入可以使模型更好地泛化到未见过的数据。

5.2 多任务学习在NLP中的实践案例

多任务学习在NLP中的应用正变得越来越普遍。以下两个实例展示了如何在实际问题中应用多任务学习。

5.2.1 机器翻译与文本摘要

机器翻译和文本摘要虽然任务不同,但都需要理解语言的语义和结构。多任务学习可以在这两个任务之间共享知识,提高翻译质量和摘要内容的连贯性。例如,通过一个共享的编码器-解码器架构,模型可以同时学习如何从源语言生成目标语言的句子和如何从长篇文档中提取关键信息。一个研究案例展示了使用联合训练的多任务模型在翻译任务上的精度提高,并且在文本摘要任务上的表现也得到了改善。

5.2.2 情感分析与问答系统

情感分析和问答系统涉及理解用户输入的意图和情感。多任务学习可以帮助模型在学习判断文本情感的同时,也学习如何正确回答问题。通过对这两种任务进行联合训练,模型可以更好地理解和处理复杂语境,从而在问答任务中提供更准确和更人性化的回答,在情感分析任务中识别出更微妙的情感变化。

多任务学习在NLP领域的发展,不仅推动了模型效率的提升,而且为处理语言的复杂性提供了新的视角。通过共享语言任务之间的知识,多任务学习可以更好地模拟人类语言理解和生成的复杂过程,进而提高机器在各种语言任务中的表现。然而,尽管已经取得了一定的进展,如何设计出既能高效处理多任务,又能适应不断变化的语言环境的模型,仍然是当前NLP研究中的一个重要课题。

简介:多任务分支深度学习结合了深度学习和多任务学习的优势,通过共享特征提取和任务特定优化,提高解决多任务问题的效率和准确性。在计算机视觉和自然语言处理等多个领域中,这种模型能够同时处理多个相关任务,提升性能并减少冗余计算。尽管面临挑战,例如任务冲突和资源需求增加,但通过优化策略,可以有效应对并推动AI技术的发展。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?