阅读提示:

本篇文章于2023年底尝试挖掘并探寻以ChatGPT为代表的LLMs和以AlphaGO/AlphaZero及当下AlphaDev为代表的Alpha系列之间的AR和RL思想的背后底层理论及形式上的统一,同时尝试基于去年OpenAI暴露出的project Q*可能的关于推理过程学习再到系统①(快)思考与系统②(慢)思考的形式化统一的延展性思考,以展望当下面向未来AGI路径可行性...正如前几日AI一姐李飞飞教授所说,人工智能即将迎来它的「牛顿时刻」...

本篇文章拟分为「上篇」「中篇」「下篇」,因为文章内容整体比较冗长,也许会给大家造成一定的阅读困扰,但仍希望大家能够阅读下去,内容上尽量采用简单通俗的表述,其中文章囊括了诸如强化学习「RL」、自回归「AR」大语言模型「 LLMs」等技术领域深刻内涵思考,穿插关联了丰富的计算机科学/数学/物理学/哲学/心理学等领域跨学科内容,回顾了人工智能近现代发展历史,并在部分章节中以作者视角回顾总结过去一年中大模型给自己带来的思想冲击...大家如有疑问困惑和不同看法也非常欢迎评论指正或直接如流探讨,感谢!

本文原创作者: 吕明

如流ID:lvming01

Wechat:lvming6755

知乎:吕明 - 知乎

想回顾「上篇」的小伙伴请参考如下链接:

融合RL与LLM思想,探寻世界模型以迈向AGI/ASI的第一性原理反思和探索「RL×LLM×WM>AI4S>AGI>ASI」 (qq.com)

「中篇」

「系统一 · 快思考与系统二 · 慢思考」的本质&阐释:

细心的读者可能会在上篇的内容预告与中篇内容的更新中对比发现,将「系统一 · 快思考与系统二 · 慢思考的本质&阐释」与「LLM×RL本质&阐释」做了先后调换(相信大家从这里也能推断出「中篇」和「下篇」的撰写是在发布「上篇」后才进行撰写的,并没有提前写好:),之所以进行调换,更多考虑是能够从更根本的问题出发。通过深入的探究快与慢思考的表象的差异性和智能的普遍性,能够帮我们更加深刻的去理解推理或思考这一过程本质,并在此基础上形成一定的基础理论观点或假设,更好的对「LLM×RL本质&阐释」内容进行阐释,在阐释过程中将会发现与本节中所提及的系统二慢思考有着很大的影射和关联。

另外,在正式进入本节正式内容阐释之前,考虑到「上篇」中部分内容较为晦涩难懂且内容繁杂,因此想上来就开门见山的为读者抛出一些相对明确的观点,这样在后续的step by step阐释中通过这样一个引子帮助读者能够有一个更好的阅读预期。

我想以前几天前(2024年3月)我在知乎的一个回答来抛出这一观点:

题主问题:

大模型的本质就是预测下一个词是什么,所有的涌现或者智能都是基于此。那么人类的思维是不是也是这个样子呢?看样子有点像,因为类似思维链的技巧(一步步的思考等)其实对大模型和人类都有效。

更进一步的问题是,如果没有语言那么人类还能产生理性的思维么?

我的回答:

如题,我觉得人类的思维很有可能是基于此种tokenize的预测模式的,只不过tokenize的结果及过程形式会有一点不同,但回归第一性原理来思考,本质上是一样的。

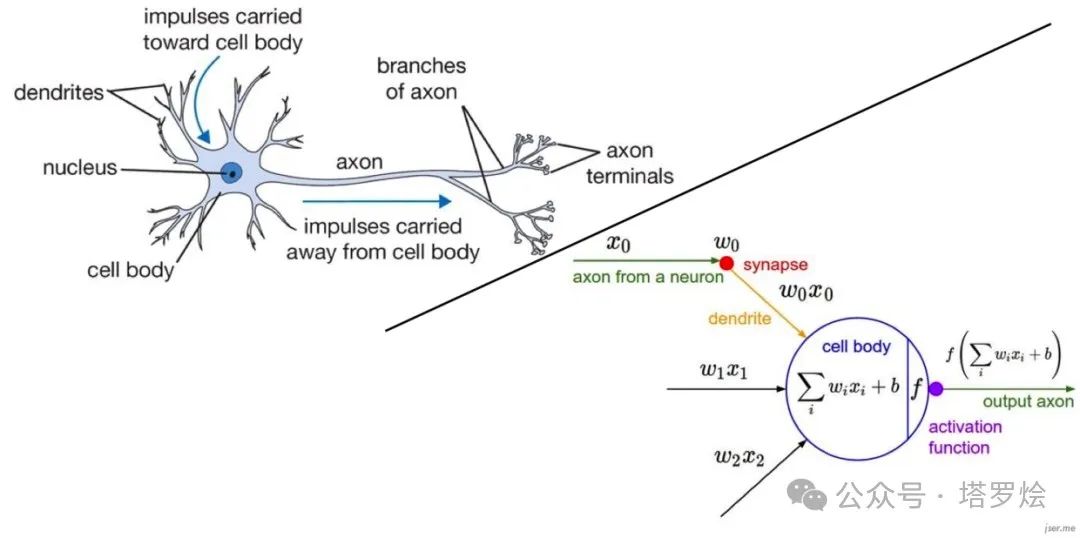

另外从系统①(快思考)与系统②(慢思考)两者之间的内涵上来看其实也能侧面映射出当前LLM与人类的思维内涵存在着某种联系。任何模型在进行推理时,本质上都是对从一个状态(特征/过程)空间映射到另一个状态(决策/动作/甚至慢思考中的规划与反思…)的符号化(离散表征)或向量化(连续表征)空间,而这种映射其实模拟一下人类思考的思想试验也是类同的,而LLM模型网络内部和有研究表明的人类大脑,即其实亦是从一层神经元到下一层神经元的映射(神经元信号激活),比如这种映射可以表征对状态特征的提取,事物的具象到抽象,状态所对应的决策/行动...而这映射两端的不同空间表征是可以任意的且客观存在的,且随着人类行为的反馈亦机器的监督学习来建立关联的,当然这取决于“大自然”赋予人类的偏好决策与行动空间,就像人类赋予机器对应的任务监督模式与决策空间。

因此回到上述系统①和系统②,系统②相对于系统①,其实本质也都是同一的,只不过系统②在神经网络激活(信号正向传播)过程中,经历了不同的映射层,甚至在LLM所驱动的Agent中的规划,反思,如COT,TOT,GOT,AOT,BOT,XOT等策略过程亦是属于中间过程的不同表征空间的一种映射,只不过在映射的过程中通过in context上下文给予了提示(比如COT的step by ste..),而这种提示prompt有可能会激活(这里的「激活」在两者思维或运算推理过程中的数学本质上即是指将输入侧的信息向量化表征通过模型正向传播计算即数学变换)人类大脑神经元和模型中间网络神经元的信号传递的路径(当然路径是丰富多样的,并且模型或人类大脑在过程学习训练中可以呈现出上述泛*OT的这种模式)。

因此,对于上述所说的in context learning也好还是prompt leaning也罢其实对于人类和机器的推理与思考或直觉来说也是某种程度的同一。

当然LeCun提出了另外一种实现像人类智力能力的AGI-世界模型,强调模型在中间抽象层的构建,但我始终认为通过采用有效的训练与学习方法,模型在网络空间隐层中,是可以习得这些抽象概念的逐层映射推理表示的,关键采取什么样子的训练方法以学习到这种更抽象的类人能力甚至是超越人的抽象模式,也许LLM+RL强化学习是一条路径,包括引入相应的过程奖励函数,以及构造足够抽象可形式化推演的模拟环境以进行有效的self play(如围棋或数学证明)。→ 这里又会遇到另一个问题:这些虚拟环境与真实世界环境的空间可表征有多大差距,是否能通过某种方法进行逼近?当然即便无法有效完美逼近,在虚拟环境中所习得的抽象推理或决策(本质上是上述说的模式映射)亦可以通过迁移实现模型的的泛化。

最近也在进行相关方面的思考和持续探究,也写了一些内容,分享给你,希望能有所帮助:...即是本篇「上篇」

因当时时间有限,主要以答题的目的进行了一些观点的阐述,表达上可能会有一些不严谨或表达逻辑上的偏差。

知乎链接:大模型的本质就是预测下一个词是什么,所有的涌现或者智能都是基于此。那么人类的思维是不是也是这个样子呢?- 知乎

在上述题主的问题中,其实包含对LLM的三层疑问或思考:

疑问一:Tokenize对于LLM以及人类的智能意义?

疑问二:思维链 · COT的意义?引申出「系统一 · 快思考与系统二 · 慢思考」的本质思考。

疑问三:人类语言Language的本质思考。

对于疑问一,在「上篇」中的最后一部分中,其实已经向大家进行了相关讨论与说明,随着业界和学界对Tokenize认知逐渐加深,Token is all you need已经被大家所共识,它不光是从传统辨别式小模型向生成式大模型演进的一条必经之路,而且从tokenize的广义内涵上来说也为AI通往AGI之路打开了一条门缝儿,比如后续的sora针对CV数据的patches创新 · 就像Token一样将多种模态符号表示(代码语言、数学形式语言、自然语言)统一起来一样。

Tokenize可以说与人类在这个世界中的规划与思维决策到具体的行动甚至细微的动作决策,与经典物理规律中从微观粒子的运动作用到宏观现象表现等有着本质上的普遍相同性。我们可以试想一下,LLM的next token predict虽说是依据之前文本序列进行下一个token · 字/词的分类概率预测(也对应有回归性预测),但这种概率预测本质上亦是一种微观层面的决策输出,最终实现的连续token输出·即生成,step by step地形成了对应的宏观行动决策「这里栓个扣子,不知大家有没有看到step by step?是的,这个东西又出现了,其实本质上step by step即是从微观推理到宏观涌现的一种模式,在接下来的深入系统二 · 慢思考的探索过程中,tokenize已然是其可实现的底层逻辑,是为基础,也建立出系统一与系统二的普遍性本质基础」。

对于疑问三(为了铺垫本章节的主题,我们将疑问二暂且放在最后进行统一的阐述),语言(英文:Language)作为人类进行沟通交流的表达方式,也是人与人交流的一种工具,更是文化与知识传播的重要载体。尽管人们可以通过图片、动作、表情等可以传递人们的思想,但是语言是其中最重要的,也是最方便的媒介。而这种方便性的体现正式由于语言本身作为符号化表征能够具有非常强大的动态扩展性以及概念抽象性。

对于语言的动态扩展性上来说,可以结合人类的历史发展上来进行观察,随着社会、人文、科技等多元化的发展,语言也是在不断变化和调整的,而对于可符号化的一种信息可传播或加工的形式,语言带来了对这个世界进行抽象表征的更好的动态扩展性,从而推动语言符号对抽象概念的更确切的表征。

对于语言的概念抽象能力上,我们可以看到,在人类沟通活动、知识传承、思维探索过程中,甚至是现在人与机器的互动访问中,语言始终起着关键而又核心的媒介作用。为了能够帮助大家更深刻的认识到语言在人类世界中的关键作用,想举例罗列一下,当然这部分非本文和核心观点,若自觉冗长的话,大家可自行跳出这部分的阅读,了如语言所体现出的如下性质:

「指向性」:语言具备指向性,语言的指向性使语言的含义描述可以指向对应的事、物。如:具体的实体-树、人等,抽象的概念-上、下、圆、方等,逻辑表述-与、或、非等,行动与策略-规划、反思、判别等。同时,语言的指向性受人为认可的事实。例如,“人”可以表示真实的“人”,但如果不认可其表示“人”转换另一个符号那么语言的指向性就会转换到另一符号上。因此,我们看到,某种意义上,语言的这种「指向性」是能够指对真实世界客观事物的一种概念化表达,而正因为这种概念化表达,才能够通过语言这一符号化表示建立人与世界的认知关联。也就明白了前一阵子王小川为何要在内部强调在有限的资源下要聚焦在all in LLM上,用LLM来链接一切,而对类似sora的模型投入要慎之又慎。

「描述性」:语言的描述性是语言含义的体现,语言具备描述性是语言能够交流的重要体现。语言的描述性受语言的指向性变化。如:人/大人/小大人,人/人民/人民的等。当然,描述性本身也是对这个世界另一种抽象事物的一种概念化指向。

「逻辑性」:语言是一种有结构、有规则的指令系统。语言的逻辑受语言的指向描述而变化。如:我是一个中国人/我像一个中国人,1+1=2/1*1=1,this is an apple/this is a car等。在上述语言的「指向性」中,能力体会语言这种单一的词、字符号化可以指向真实世界的某一个概念,然而在这个世界中,事物亦是可以组织或者事物间是有着逻辑上的关联和结构的,因此除了抽象概念的一对一映射指向,语言作为一种序列组织结构,在序列的这种形式化表征上,可以体现出复杂的逻辑性或数学结构,实现对真是物理世界的进一步抽象表征。比如在早期语言模型建模中经常用到过的RNN、LSTM,当前LLM的Transformer模型结构,正式对这种语言序列性所体现出的逻辑机构进行的适配。当然图结构作为一种非欧符号化表征,GCN模型也是对知识图谱符号的一种建模结构适配。这里有兴趣的读者可以再延申一下思考:世界上是否存在除了自然语言、变成语言、数学语言等其它形式的符号化表征的存在,如果存在,那么用于机器学习建模的模型结构应该是什么样子的呢?同时,对于非碳基生物来讲,语言是否像能够对人类使用一样,进行得那么顺畅和友好?「这里同样再栓个扣子,不知大家是否还记得在上篇论述AMIE的过程中,提到了语言或其它符号的分布或构象所衍生出的探索语义空间的更深一层的表征潜力,关联LLM的pre-traning到super alignment,再到杨植麟所提到的LLM在进行pre-traning到alignment过程中的scaling law本质,我们似乎能够体会到未来通往AGI的道路并非如此简单,这也是本篇文章想要表达的核心观点之一,也是希望能够探寻RL与LLM的本质普遍性,试图建立一种尽最大努力将真实世界所有事物进行有效压缩的路径,如RL×LLM的融合。当然在这之前,我们需要探明不管是基于语言的符号化表征体系,还是真实物理世界体系所蕴含的表征空间还存在多少潜在知识和未知可能,而这些有可能存在于物理真实世界与虚拟数字世界中的多样化不同的构象与分布当中」

「语言的交互性」:物质与物质之间的交流需要建立一定的联系,无论其是否相关。而两个非相关的实体要建立联系就必须采用一定的方式。而语言沟通是采用一套具有统一编码解码标准的声音(图像)指令输出,从而使得生物(人)与生物(人)获得沟通。同时,正由于语言所具备的这种天然的交互性,使得除了表面上可以在两个实体之间进行信息传递与交互外,从另一个角度来看待这一过程,可以进一步放大语言在真实世界中的分布表征,并通过这种对语言分布的进一步的放大,使得其所蕴含的真实世界知识内涵(压缩的世界知识)的表现形式更加多样化。

所以,我们看到上述有关语言的相关概念及意义的描述,回到题主的原始问题三「如果没有语言那么人类还能产生理性的思维么?」,我想除非找到一种更加丰富的能够表征“理性”的工具或媒介,也许在没有语言情况下,很难建立起如此繁杂、抽象的概念大厦,也就无法到达柏拉图《理想国》当中的理念世界。或者说语言是为了智能体理解更高级别抽象的概念而必然存在的符号表征媒介。

问题三——终于来到了「系统一 · 快思考与系统二 · 慢思考」这一观点的探索和思考了,我想仍然采用一种自身经历回顾的叙事角度,先为大家介绍一下我最初从刚刚开始接触这一观点,到随着大模型的进一步发展进行的一系列思考,再到如今出现的一些客观实例,最终进行这一领域问题的本质归纳与猜想。

要进行「系统一 · 快思考与系统二 · 慢思考」的阐释,就不得不提及最初提出这个观点的一位研究者:丹尼尔·卡尼曼(Daniel Kahneman),某种程度上正是由于他在2012年出版的《思考,快与慢》这本书,才使得去年Andrej Karpthy(前OpenAI雇员)站在讲台上用生动形象的心理学研究视角为大家阐释chatGPT通过COT或TOT进行few/zero-shot learning的过程。当时记得在2013年前后有过翻阅这本书的经历,主要原因是由于当时年轻的自己业务对一些关于人类认知科学方面的事物比较感兴趣,偶然间在北京西单图书大厦角落里发现了它,但在模糊的记忆中记得当时这本书给我留下的一些印象是读起来比较晦涩难懂(可能跟自己的专业背景差异太大吧,依稀记得这本书里面的主要内容都是从心理学的视角上进行解释的),很多章节都没有进一步深入读下去且进行思考,在快速阅览了前面的目录和前两个章节后,转而投入拐角处的另一本当时的畅销书《失控》-作者:凯文·凯利 KK,这本书相信大多数70/80后都有阅读过,并对其中的某些新颖观点产生了瞪大双眼似的浓厚兴趣,比如书中提及的“涌现”,是的,ChatGPT刚刚推出带给大家更多惊艳其背后即是其“涌现”能力。当然,现在回想过去“错失”的这本《思考,快与慢》,其实倒也没有什么特别的遗憾,主要是当时确实也没有更多的科学实践或者工程技术能够将书中所提及的人类思考的这一过程能像如今的大语言模型LLM一样被如此近似形象化的呈现出来。

第一部分:“两个自我”,作者介绍了人类思考过程中的两个自我,即快速思考和慢速思考。作者强调了这两种思考方式在决策和思维中的重要性,并指出了它们的优缺点。看起来就经验和直觉的快速思考与LLM的next token predict在直觉上感觉很类似,慢思考感觉是基于多次LLM next token predict下驱动的Agent或RAG的推理模式,而这本身也是由人类规划、分析、反思等行为通过tokenize prompt来step by step实现的。

第二部分:“代价”, 作者讨论了快速思考和慢速思考的代价。虽然快速思考更快、更自然,但它也容易受到偏见和错误的影响;慢速思考更准确、更深入,但它需要更多的时间和精力。作者介绍了许多有关思维效率和效果的实验,并提供了一些方法和技巧来平衡这两种思考方式的代价。这也与基于LLM的next token predict(慢)和Agent(快)在推理精度上的行程匹配。

第三部分:“偏见”,作者探讨了许多思维偏见和错误,如确认偏见、可得性偏见、群体偏见等等。这些偏见都会影响我们的决策和思考,导致错误和失败。作者提供了许多避免这些偏见的方法和技巧,并强调了审慎和警惕对于思考和决策的重要性。关于偏见这部分看似没有体现出与当前LLM在推理和应用上的端倪,但我想这里可能还要给大家留一下一些待思考的印记:首先如果这里的“偏见”是指在LLM预训练阶段通过采用了“偏见”的训练样本造成偶发性错误,那问题还是比较好理解,但如果是一种更加泛化性的“偏见”,比如前一阵子Gemini生成人像的翻车事件,那这里面可能就有一些玩味了,我想可能要从更宏观的面向pre-training或RLAIF的整体任务样本数据分布上看待整个事情了,请参考在「上篇」中AMIE或本篇中上述有关完整真实世界语言符号分布或构象的提及。

第四部分:“选择”,作者讨论了决策和选择的过程。他提出了许多有用的方法和技巧,如使用“透明度”和“热力图”等工具来帮助人们做出更好的决策。作者还强调了选择和后悔的问题,并提供了一些策略来帮助人们避免后悔和错误的决策。这也是一种慢思考的方式,当前不管是基于RAG还是Agent中的反思都有所体现。

第五部分:“自我”,作者探讨了自我和思维的关系。他介绍了情绪对思维的影响、自我控制和欲望的作用,并强调了自我认知和情绪管理对人类成功和幸福的重要性。作者还讨论了自我和共情的关系,并提供了一些建议和方法来帮助人们更好地理解和掌控自己的思维和情感。

总体来说,《思考,快与慢》是一本关于人类思维和决策的重要著作,它深入探讨了人类思维的复杂性和多样性,并提供了许多有用的方法和技巧来帮助人们改善思考和决策的效果。它不仅适用于个人,还适用于组织和社会,并对当前人工智能认知领域为人们提供了更深入的理解和认识的一种可能。

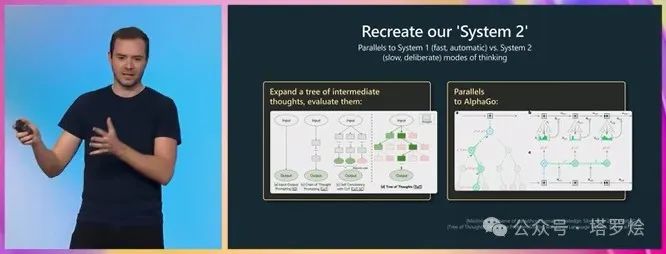

从《思考,快与慢》这本书所阐述的内容可以看出,其中不乏一些观点,为当前的LLM推理应用甚至是人类认知模式给出了一些指引和洞察,也正因为此,前OpenAI雇员Andrej Karpthy与去年5月份在微软Build大会演讲后半段中,首次提出了系统二思想运用于ChatGPT深度推理的一些场景,并提出了当时应用ChatGPT在一些深度推理、反思以及自我认识方面的局限。如Andrej Karpthy在会上发言提及:

“基本上,这些Transformer就像标记模拟器。它们不知道自己不知道什么,它们只是模仿(预测)下一个标记;

它们不知道自己擅长什么,不擅长什么,只是尽力模仿(预测)下一个标记;

它们不反映在循环中,它们不检查任何东西,它们在默认情况下不纠正它们的错误,它们只是对标记序列进行采样;

它们的头脑中没有单独的内心独白流,它们正在评估正在发生的事情;

特别是如果任务需要推理,不能指望Transformer对每个标记进行太多推理,某种形式上必须真正将推理分散到越来越多的标记上;

例如,不能向Transformer提出一个非常复杂的问题并期望它在一个标记中得到答案。(用于计算的)时间不够;「个人见解:本质上,复杂类问题或需在模型进行训练任务过程中的样本不足或为零导致的泛化能力不够或无法完成对其中pattern的泛化学习」

这些Transformer需要标记来思考,我有时喜欢这样说;

这是一些实践中运作良好的事情:例如,可能有一个few-shot prompt提示,向Transformer显示它在回答问题时应该展示其工作,如果您给出几个示例,Transformer将模仿该模板,然后它就会在评估方面做得更好;

此外,您可以通过说“let's think step by step"从Transformer中引发这种行为,因为这使Transformer变得有点像展示它的工作。

而且,因为它有点进入一种显示其工作的模式,它会为每个标记做更少的计算工作,因此它更有可能成功,因为随着时间的推移,它的推理速度会变慢

...”

针对上述LLM当前存在的问题,前OpenAI雇员Andrej Karpthy也是在那次微软Build大会演讲中首次提出了「系统一 · 快思考与系统二 · 慢思考」的不同认知模式,并通过列举COT和当时刚刚发布的TOT(本次演讲的一周前)运行方式,提出需要对模型生成内容进行反复采样,并得出最终“答案”的可能这一本质。同时Andrej Karpthy也列举了AlphaGo比较酷的策略引擎中所隐含的MCTS的过程。

大家看到这里,不知是否也逐渐意识到了这种系统二·慢思考似乎与AlphaGo训练机制或者说与RL的训练逻辑有着一些比较深刻的底层联系,我想这也是我当时选择以LLM与RL融合为出发点,逐步探究系统二·慢思考的本质逻辑,再到世界模型构建的可能途径,最终通过AI4S,突破科学领域突破,激发LLM更深层次潜力的最初原因之一。

在接下来对「系统一 · 快思考与系统二 · 慢思考」的持续探寻中,我想先为大家分享一下我在接触到Andrej Karpthy那次对外演讲的前后,自己在快·慢两种思维推理模式的逐步探索、反思、洞察...的这一连串的思考经历与过程记录,如下:

【友情提示】下面的内容记录在叙述形式上有点碎片化,且由于是按照时间线进行记录,难免会造成一些在行文整体结构上混乱,因此如下内容请大家谨慎阅读,如遇不适,请快速跳过。不过还是希望跳过的伙伴能够反过来在对如下过程记录进行散文式阅读,因为毕竟在字里行间中隐含着很多本文的核心思想的由来和提示,甚至是非常核心的内涵见解。

【2023.5.25】关于人类思考模式COT与ChatGPT推理模式两者间的思考(Andrej Karpthy演讲分享前一周)

COT的中间思考模式或确切的说思考链路,是否能优雅的平滑嵌入到LLM自回归式生成当中来?方法是怎样的?LLM的自回归的网络结构是否可行?是否存在更加匹配的网络模型结构更适合推理链路的嵌入或整合?除了模型结构外,要达到这种目的,如何找到完备的训练方法和目标、如何寻找适合的训练任务和与之匹配的训练环境,如何构建匹配的数据样本或数据分布?甚至是否会存在一种全新的推理链范式?就像人在有些时候进行深度慢思考过程也不完全是现在这种类似LLM的自回归的多个简单直觉交互式或提示过程。

其中的关键点在于:“如何优雅的平滑嵌入”,将思考链就像COT中的prompt方式或in context learning模式那样,在模型的神经网络隐层中自行模拟COT的过程,而不用其它的额外的提示输入的方法。

有趣并有意义的是:如果上述可行,那意味着模型在学习过程中也能将不同领域的更加抽象的推理模式进行泛化掌握,从而实现将复杂而抽象的数学抽象知识或思维方法快速迁移到物理、化学、生命科学等学科领域。

延展:是否可采用类p-tuning,零/小样本学习方式或RLHF进行构建这种长推理链的任务模式并对LLM进行基于系统二·慢思考的训练?亦或者是还有其它的任务构造和训练方法?这里面可能考虑的关键点在于①训练任务的构造以及与之关联的外部环境的模拟?②训练任务所囊括的数据的多样性以及数据某种程度分布的全局性(全局性指:便于囊括更加多样、完备的推理链模式,因为这里有个假设:不管是推理模式还是思维模式,会存在对多个任务的多种模式)。

顺着上面的思考路径,昨天读到了一篇基于LLM生成事件schema模式的文献以及一偏论证RLHF质量与数量及模拟人类构建RLHF机制的文献,产生了延展思考:对于泛SFT或者是指令微调也好(这是未来两种优化模式),基于LLM隐含了大量复杂而抽象的知识的前提下,在pre-training 和 SFT两者间未来如何取向统一与平衡的目标,即是否存在一种趋势或模式:【预训练尽可能广和深的学习到复杂抽象知识(或者叫模式),SFT更多承担领域表象知识】又或是反过来,能够想到的是:预训练可能承担学习深入复杂更加抽象的知识更优,原因是:他的泛化与迁移能力更便捷和优雅。

【2023.5.30】基于今天OpenAI联合创始人Andrej Karpthy(截至本文发稿已从OpenAI离职)在内部演讲的报告内容:

1. 提到的人类快思考和慢思考:基于这一问题,作者举了个长链思考的问题(两个州的人口对比输出的人的内心思考路径vs模型预测下一个标记的模式),这里给我的第一个启示是:未来是否会出现一种新的长链推理范式,在RLHF层,在其中过程中人们或机器通过标注反馈多种模式,构建模型的推理步骤或思考路径决策(与之形成对比的是现在这种看似简单粗暴、通用表象的next token预测,当然这不是绝对的,因为NLP符号包罗万象,其为符号化到token化形成了囊括真实世界在概念或理念世界:出自柏拉图《理想国》的一一映射)为表征态进行对应的慢推理模式训练,NLP的符号化与推理步骤和思考路径的符号化对比也许是一个更精细、更丰富且的符号表达集合,且包含了推理步骤和思考路径的符号化表征(除非推理路径会思考决策无法用NLP符号化模态生成或表达),顺着这个思路,也许针对模型在推理复杂问题的粗粒度可解释性也将在这种新的范式中解决。另外,Andrej在文中所说的基于提示的长链思考的人类系统二也很有启发,他是基于prompt工程来进行任务的拆解,但这里会出现另外一种看似完全不同的思路:基于AlphaGO的强化学习MCTS。还有一个思考就是通过RLHF简单粗暴的训练TOT(思维树),因为思维树的生成意味着能带来更多抽象的特征识别或模式识别。即,能不能找到一种能让其自动学习处理思考的范式-如可以沿着系统一的模式进行step by step的延展。以及这种本质上是否是一样的呢?如将系统二像系统一一样建立起模型训练学习到推理的端到端统一范式?还是说系统一与系统二本质上完全不同?

2. 没有进行RLHF的基础模型生成内容的多样化思考:①可能人类感知世界,理解世界,生成决策就是一个大的斗状形状,上面提到的生成决策其中的经过RLHF后的一类可能是抽象能力,当然随着不同RLHF机制,会有不同的能力与抽象能力并列;第②个思考是:在生成(输出侧)可能对RLFH之前的基础模型会有更多想象不到的价值,因为基础模型熵大,融合了更多知识和元素(处于上述提及的感知+理解世界这一阶段,其实最开始的输入熵是最大的,中间层经历了一些熵减,毕然会损失一部分熵,但这种损失也是一种智能的过程,是否也是不可避免,毕竟又跟后面的决策有关),回过头来说:基于RLHF之前的基础模型的经过一定抽象和总结的多样化输出是否会为最终的chat模型(即RLHF之后的模型)提供更多prompt或COT呢?是否是一种新的模式或范式呢呢?ps:针对这一段的思考,在「上篇」结尾处”传统模型AI与LLM模型在任务相关要素及特征空间上的形象对比“的图示及对应的解释中进行了更进一步的思考修正和调整说明。

【2023.5.31】今天清晨接着昨日人Andrej Karpthy内部演讲内容,在上班途中想到的几个点:

①这个世界中是不是只有人类那样的系统一和系统二的两种思考模式?有没有额外的第三、四种思考模式?如果有,它们是什么样子的?为什么有?如果没有,为什么没有?系统一和系统二就能代表思考或认识模式的全部了吗?为什么?

②如何将抽象的这种思考推理链的”知识“在某种隐式的模式下进行表征和激活,如在LLM的跨多层Transformer到next token predict中表征,如在模型推理过程中将模型中所蕴含的知识和模式【定向或精准】激活或泛化出来?是否可行?或者说是组织出来?当前看可以将prompt作为一种手段,难道只有prompt这一种手段吗?其中的知识和模式仅仅是碎片化不可单一解读的编码,但又蕴含着知识,钥匙则是这种语言符号化表征组织方式或者说是某种Xi→Yj(Xi为输入token序列,Yj为输出token序列,也可表示为推理链tokenize)的多种模式的映射构象集,会有不同的组织路径或组织模式(以信息论中的理论来看,看似是一种信息熵减的过程模式),取决于模型内部神经网络的信号传导路径(神经元正向计算)。

③想到论文摘要作为输出,论文原文作为prompt,需求作为输入,构建RLHF是否是一种可行的推理思维链熵减模式?

④能否尝试构建一种训练推理一体化范式:模型会自己遵循某种方式建立长链思考范式,神经网络标记预测是一类思考模式(对应系统一),连续prompt是另一类思考模式(对应系统二),两种方式是否可优雅的融合?还有没有其他思考模式?

⑤或者说更进一步的,现在的pre-taining+SFT+RLHF是否是一个面向TOT的合理范式吗?应该不是,他只更适合系统一,系统二应该有别的E2E范式,taining+SFT是粗暴的嵌入(学习)各种具象抽象支持,RLHF是浓缩,熵减的生成;亦或是,TOT本身就不存在TOT E2E的这种范式。有几种可能的上述解决模式:(1)基于模型网络结构的改造,(2)基于分片监督训练任务的,(3)???

⑥解决上述E2E TOT的技术路径可能需要采用某种技术手段,做出模型在transform网络结构推理层面的改良或替代,以模型参数的足够容量和灵活性对标取代采用prompt提示输入的效果,当然前面我们提到这种模型中参数的改变变量与prompt输入的变化变量在数学变换本质上可能是一直的,在数理运算逻辑上存在较大的差异。之所以提出⑥这一种可能,还是因为基于NLP这种通用,普遍性符号化表达的多样性与开放性。

【2023.6.1】

接着昨天的思考,针对于系统二的E2E的COT或TOT,如果是以LLM当前这种自回归的开放符号表达形式即tokenize下完成推理的,冥冥之中其与当前ChatGPT系统一的LLM模式在生成上本质是一样的,无非是生成的复杂度会更高,带来的模型训练参数,或中间隐层及输出层的熵的量更大。本质上,可以把模型中间神经网络层·NN中的隐式推理模式统一为tokenize·标记化,底层神经元的正向传播计算本质上都是某种复杂程度的数学变化,比如傅里叶变化或更进一步的希尔伯特空间坐标变换或其它..

【2023.6.2】

针对E2E第二系统推理模型网络结构的设计,可能需要依据直觉经验或稍加理性(类似理性洞察)对网络结构进行设计与调整,lora也好,MOE也罢,甚至在muti-head层进行改良,使得针对关键token的关键组合被模型有效捕捉到并传递或扩散到多层或更宽广的神经元上。同时,训练时任务形式的改进(非预测下一个token的方式)是否也可以更好的满足对系统二E2E的推理呢?这里为了方便读者阅读,补充一个非当时即当下撰文思考的内容:即sora的扩散模型·diffusion model是否是一种合理的针对系统二·慢思考过程表征的模型网络结构的改良呢?后面将会为大家举一个近期的采用扩散语言模型进行E2E链式思考推理的论文「Diffusion of Thoughts:Chain-of-Thought Reasoning in Diffusion Language Models」。

【2023.6.7】关于知识增强与E2E·COT深度推理的本质洞察所带来的探索与思考

沿着前几天的E2E 系统二·慢思考的逐渐理解...

①看到大模型在医疗场景的对齐所采用的知识增强模式,似乎洞察到了一种不同以往精细化知识增强(比如Baidu Enire系列的多任务知识增强)的一种粗暴式知识增强模式;

②这种知识增强模式与类E2E·COT本质相同,即E2E·COT本质在做对齐时也是一种知识的增强,并将知识融合嵌入到模型网络参数中,接着又深入思考了下系统二·慢思考的这种知识增强范式中所隐含的内涵,如模型参数量(宽度和深度),模型参数所嵌入的知识内涵维度、抽象层级、知识映射或关联的粒度以及不同于表象的这种知识增强,或叫“内涵增强”?这部分是否需要再拿海量预料预训练还是需要在RLHF阶段进行人类强标注呢?前者(熵增)可能提升的空间在于更多知识的潜入,后者(熵减)体现在抽象能力的归纳,但在某种系统二的深度推理模式下,这种抽象能力的归纳又会激发出更多的信息熵(生成丰富的知识),因此是不是关键环节就在于这个深度推理链上呢?ps:同样,针对这一段的思考,在「上篇」结尾处”传统模型AI与LLM模型在任务相关要素及特征空间上的形象对比“的图示及对应的解释中进行了更进一步的思考修正和调整说明。

另外一方面,回归到in context learning和模型SFT两种本质推理范式上,E2E深度推理某种程度上是实现了自动参数激活代替了外界人工定制的prompt工程,当然这种自动参数激活可能也需要某些更深层次隐含的提示或input。

回过头来总结一下前面的E2E深度推理模式的意义:通过模型的感知激活,能够对思考链进行上面所说的深度思维路径增强,而不用人工去工程化地定义一些思考模式,思考范式,思考步骤,思考循环,这些都是模型参数在其中E2E过程中自动激活或扩散完成的,甚至模型在进行E2E训练中,结合input,prompt,output会自动学习这些隐含的抽象模式,而这些高度抽象的思考模式内涵可能是人类无法理解、逆向的、即AGI(通用人工智能)甚至ASI(强人工智能)的一种路径。当然这里也有许多不小的挑战,就是如何构建一个有效而美丽的训练任务范式,除了现有的SFT,RLHF外,是否还有其他学习范式,包括解决如何将推理模式通过学习潜入参数,学习过程是完全E2E的还是分阶段的,训练数据集与RLHF的差异有多大等等。

总结一下:

本质上的生成输出层的熵增熵减平衡问题;

深度推理模式E2E学习问题和必要性问题;

In Context Learning与SFT在本质上的一致性问题;

基于In Context Learning与SFT的本质一致前提,才可能有深度推理E2E的实现可能与意义。

延展:试想一下为什么GPT5没有安排排期呢?确实是GPT4已经对表象知识掌握的足够多了吗?如果是的话,那个双向漏斗图(自己之前在纸张上随便图画打的一个草稿,见下图)是不是得调整成枣核状?大模型在预训练阶段实现的是更多表现知识的表达嵌入,需要更深层的网络以及每层更宽广的参数,而在RLHF层则是包含两种推理模式:①抽象归纳层,②基于①的生成式小漏斗。

【重点思考结论&假说】所以,是不是上述E2E深度推理的模型构建重点在于类RLHF上的改良,形成①+②这种E2E模型网络结构的创新改造,比如在②中通过类attention机制,将①与多层预训练层进行拼接。

【重要内涵补充】:上述第二系统的基于E2E的深度思考链的真正内涵在于模型是否能一次性的给出通过模型参数端到端深度推理的实现,以等同替代于COT或TOT的那种分片或分段式的不断补充prompt以通过指令input方式行程的最终生成结果(答案),即万物皆可NN参数化,比如简单的基于表象知识的参数化,抽象内涵的参数化,甚至如这里的连续深度COT+prompt参数化,不同的参数在不同层进行激活和关联影响,比如在n层参数中激活了针对这一任务的某个思维逻辑,而这个思维逻辑本身作为与任务描述的输入又会激活下一层更深层的逻辑...以此类推

【2023.6.8早】关于E2E · 系统 · 慢思考的本质洞察

模型在生成结果前的深度思考链(当然这种思考链亦是模型生成的结果)与中间的模型参数隐式动态传播感觉是相关的(可以说是真实世界事物或知识->模型参数的映射·本质是将物理世界的规律通过多种复杂且匹配的数学变换进行模拟),生成的内容蕴含了知识推理的过程,因此针对多样化的生成结果可以反馈给模型参数推理模式,比如COT,TOT,反思、引入知识嵌入动作,这些本质上等同的思考模式,都可以通过SFT或最终的类似RLHF机制(或者是某种RL模式?)将上述多样化的内涵思辨型知识通过训练参数反馈更新到模型参数当中来,使得模型本身除了具备表象知识外,还具备深层次的内涵抽象推理性知识或模式。我想做到这一步才能说AI模型向人类认知又迈出了关键一步吧。当然这种模式是否也可以形成强AI的一条路径呢?

回顾前不久OpenAI联合创始人Andrej Karpthy的报告,不管针对COT还是Self-consistency,甚至是TOT,又或者是plug-in这些长思考的模型推理认知模式,在其报告中都没有体现出这种E2E的思考,不知原因在哪里还是说他们是说破不到破,闷声憋大招的节奏?呃...这倒符合他们的一贯CloseAI的风格...

基于上述本质问题的思考,OpenAI可能会对当前系统一思考模式的chatGPT进行升级和迭代,形成面向系统二的E2E模型学习构建GPT的第二范式,也许会产生类似之前的Prompt learning,in-context learning,instructGPT,SFT,RLHF等一系列新的创新涌现。

同时,回归本质问题,只要模型参数容量足够大、计算范式足够匹配、训练任务足够贴切,原(信)则(仰)上,模型是可以容纳编码并解析生成包括COT、TOT、Self-consistency、Knowlege-Enhance一切事物的,因为NLP is everything-NLP目前是最优的多样化符号表达形式,即:NLP可以对诸如COT、TOT、Self-consistency、Knowlege-Enhance这些抽象概念进行形式化符号表达及生成,既然生成了,就意味着思考了,即在模型中进行多层神经元参数激活及信号传递了。

【2023.6.8晚】关于AGI的E2E长推理的继续探索

①上接前文,这种E2E系统二类人长链推理模式是否也是一种折中,他生成的推理链,归纳链,反思链等是否是推理得出答案的客观必须在的一环呢?有没有其它思维模式(非人类或超越人类现有认知模式)或根本不存在这种长链模式的存在呢?而上述这种存在是否可以通过另一个完全E2E的的方式通过超大样本,超大多样性的推理任务样本数据仅通过输入和输出将中间的非或超人类推理模式硬拟合到模型参数中呢?!

②可否将反思等规划模式转为化某种模型网络结构,实现E2E呢?如反思后发现自己没有理解问题或无法做出应答就不去答,而模型又会强化这部分能力让模型换一种思路去努力应答,并在反思中,通过第三种思路去印证。

③【阶段性总结】:感觉我所理解的上述E2E更多是体现在让模型中的参数或神经元真正的按照推理链扩散或被激活起来,实现模型网络结构中的参数更加复杂的多级模式计算(数学变换),而COT,TOT,autoGPT,HuggingGPT,plugin更多是在推理形式维度上生成单层维度(这里的单层级维度本质也是推理深度:因为在模型网络结构参数中实际上是多级的·因为毕竟是DNN嘛,,但这种的特征层面的多层级没有涌现出推理中也许没有学(泛)习(化)出复杂而抽象的推理逻辑的多级映射模式)。即 推理真正的在模型参数的正向传播中涌现出隐式抽象长链推理。

【2023.6.9】关于E2E·系统二训练过程的延展思考

上接昨天8号晚上思考的神经元多层级推理映射的内涵,有三点想法再进行一下理解剖析:

①本质上,当前的基于系统一的LLM的某种程度的单层级推理映射更多是粗粒度的特征匹配映射(Simple Pattern),比如红的-火焰,蓝色-大海,而上述思考的E2E·系统二是采用更精细化、深度的多层级抽象逻辑推理(如COT/TOT/*OT)的映射拆解,即 将推理模式的映射等同于某种特征映射,本质上跟上述特征类型映射一致,都是映射,将两种不同模态形式化符号表达merge到一起,因此要实现E2E的学习,在预训练上首先可能需要建立这种多层级、精细化tokenize样本,以进一步学习掌握这种通用的精细化逻辑推理层级。同时,在SFT上,亦需要进一步熵增这种深度多层级精细化表达;

②另外,昨天思考的生成COT/TOT等显性的这些中间逻辑思维链是否作为在训练时从输入到输出的中间必要环节中,是否可以完全进行E2E从输入到输出结果,使得COT/TOT等思维链隐含在神经网络结构中的一种训练范式是否可以这样:第一步先准备精细化多token映射数据样本集,用做对通用思维链的抽象特征学习;第二步:限定模型中某些参数(这里的意义在于限定最基本、最抽象的通用思维模式),使用其它粗粒度映射样本集进行FT,这样是否就可以在模型推理中实现了基于隐性神经网络参数表达dw多层级信号传递连续精细化思考路径过程?同时还具备了多样性任务的适配,并且降低了精细化数据标注成本。

③针对现在的prompt提示词的单跳激活(第一系统)推理模式,当换了一个提示词,就会在模型网络中实现参数激活扩散的范围性转移,但这种转移是以prompt作为输入为提示发生偏移的,其中并没有体现出在模型神经网络结构中神经元的多层级推理链激活传递范式,而可能只是实现了多抽象层知识表达的一种推理传递,虽然这种知识特征层级的多跳信号激活传递可能也是与推理链多跳本质相同。

↑ 以上是我在接触到Andrej Karpthy那次关于ChatGPT应用和技术展望的内部演讲内容的前后,自己在快·慢两种思维推理模式的逐步探索、反思、洞察...的这一连串的思考经历与过程记录。这里要感谢一些能够坚持看下来这篇颇有Long Context的文章的小伙伴儿,确实也是希望通过这种Long Context的呈现,通过分享给大家在去年中我对「系统一 · 快思考与系统二 · 慢思考」的内心探索历程,能够更好的向下启发接下来本小节第一性原理的核心观点。

在进入基于第一性原理的核心观点探索之前,正好于近期阅读到了两篇个人认为比较有代表性的关于E2E建模系统二·慢思考推理模型的论文(终于:),借此也分享给大家:

其中一篇是香港大学发布思维扩散DoT:Ye, J., Gong, S., Chen, L., Zheng, L., Gao, J., Shi, H., ... & Kong, L. (2024). Diffusion of Thoughts: Chain-of-Thought Reasoning in Diffusion Language Models.https://arxiv.org/pdf/2402.07754.pdf

这篇论文应该正好赶上了近期火爆的rosa借助采用diffision models的思想,代替传统LLMs AR的方式的尝试,接下来在这里简单介绍一下这个模型所采用的方法:

随着扩散模型因在视觉领域的成功和相对于自回归模型的独特建模优势而在文本处理中引起了兴趣,有很多研究者也提出并尝试了基于扩散模型的一些看法和实践,如Gulrajani & Hashimoto 强调了扩散语言模型中的规模化法则,Ye展示了扩散模型在经过指令调整和规模化后能够处理复杂任务。因此,接下来的一种尝试变成:扩散语言模型能否也利用CoT风格的技术来获得增强的复杂推理能力?

因此作者提出了思维的扩散方法(DoT),一种为扩散模型量身定制的固有链式思考方法。本质上,DoT逐渐更新表示隐藏空间中思维的一系列潜变量,允许推理步骤随时间扩散。从方法论角度来看,DoT与最近提出的隐式CoT方法有相似之处,后者通过跨transformer层学习隐藏状态中的思维,以提高自回归CoT生成的时间效率。CoT、隐式CoT和DoT的对比示意图如下图所示。

在实践中,DoT在每个扩散时间步t迭代地对数据点施加高斯噪声,其中t从t = 0(最少噪声)运行到t = T(最多噪声),然后训练去噪模型从噪声数据中恢复干净数据。为了针对复杂查询,DoT不使用基于梯度的分类器引导,而是使用无分类器引导训练和采样去噪模型,以提供更可靠的控制信号。

DOT的流程如上图所示。受到扩散模型在文本生成中成功的启发,作者探索它们在特定任务中的推理能力及其相对于自回归模型的潜在优势。作者首先观察到Plaid模型中默认的基于梯度的引导无法进行精确的条件设置,因为模型不能完全恢复每个条件token。这在数学推理中尤其重要,因为它期望基于问题陈述中的确切token(例如,数字)进行推理,而不是更紧凑的梯度信号。为此,作者在Plaid的微调过程中采用了DiffuSeq风格的无分类器条件设置。这产生了DoT的原型,其中所有的推断都是通过一次性的逆向扩散过程生成的,所有条件token都被固定。具体来说,在训练和采样过程中,问题上下文与理由(链式思考推理路径)z0 = EMB([s; r1...n])被串联起来,且部分噪声仅施加于理由部分zt,保持s作为条件锚定。通过多步去噪过程DoT从扩散模型的内在自我修正能力中受益。为了进一步提高自我修正能力,作者设计了一个计划采样机制使得在训练阶段暴露并纠正自生成的错误思维。具体地,对于任何连续的时间步s, t, u,满足0 < s < t < u < 1,在训练阶段zt是从q (zt | z0)中采样的,而在推理过程中则是从q(zt | fθ (zu; u))中采样的,其中fθ是一个重新参数化Eq[z0|zt]的去噪神经网络。这种暴露偏差可能会阻碍模型在生成过程中从错误思维中恢复,因为模型fθ只在从标准数据扩散的zt上训练。为了缓解这个问题,对于时间步t,作者随机采样一个之前的连续时间步u ∈ (t, 1],并执行模型前向传递以获得预测的z0。然后采样zt以替换损失计算中的常规值。与自回归模型的计划采样相比,DoT中的这种机制帮助模型考虑全局信息从错误中恢复。

同时,作者进一步提出了DoT的多通道(MP)变体,称为DoTMP,该变体以一个接一个的思维范式生成理由。这种方法分离了多个理由的生成,并引入了因果归纳偏差,使得后续的理由可以在生成过程中被先前理由的更强条件信号所引导。具体来说,在第一轮中,作者通过模型生成第一个理由r1。然后将r1与s作为条件[s; r1]连接起来,通过模型采样得到r2。通过多次迭代,可以得到最终答案。

作者首先从头开始训练DoT以完成数字乘法任务作为初步调查,如下表所示。可以观察到,ChatGPT和精简版的隐式CoT模型都无法达到100%的准确率。GPT-2可以通过微调达到高准确率,但在CoT过程中牺牲了吞吐量。有趣的是,从头开始训练的DoT能够在将扩散采样步骤设置为1的情况下,保持显著的吞吐量同时达到100%的准确率。随后作者从头开始在GSM8K上训练DoT,但只能达到5.61%的准确率,这低于GPT-2的微调版本。作者认为,这主要是由于从头开始训练DoT时缺乏预训练的自然语言理解能力。这就是为什么作者开始通过使用预训练的扩散模型进行进一步的微调探索。

接下来作者将DoT扩展到预训练的扩散语言模型Plaid 1B并在更复杂的推理任务上进行评估,即GSM8K。在下表中,与不使用CoT/DoT相比,自回归模型和扩散模型在使用CoT或DoT进行微调时都显示出显著提高的性能。这表明增加的计算(推理时间)带来了实质性的好处。DoT,与隐式CoT有类似的公式,但展现出比它更显著增强的推理能力,可与微调CoT模型的GPT-2相媲美。多通道DoT表现略优于单通道版本,而后者更高效。

在微调Plaid 1B时,作者探索了几种替代方案并进行了如表3所示的消融研究。使用GSM8K增强数据集继续预训练Plaid 1B并使用基于梯度的条件进行推理,对于在下游任务上微调扩散LM来说不是一个好选择,因为推理任务需要更具体的指导。

我们看到,这篇文章采用diffusion的思想对问题上下文及链式思考推理路径z0 = EMB([s; r1...n])进行过程学习采样,并在其中通过一些tricks进行施躁和降噪的梯度修正。

Think:也许未来的E2E系统二·复杂推理模型会将当前LLM这种自回归模型被扩散模型(源自于CV领域的扩散施噪方式)所取代?如diffsion拥有着先天的某种优势?又或者AR与Diffsion两者间实现某种程度或技巧上的平滑结合?再或者后来随着理论的进一步探索,人们发现两者间本身就存在着底层本质逻辑的一致性,无非是根本的底层不同的数学变换模式或方法上的差异?即跨transformer的中间隐状态表征与高斯施躁到降噪的数学变换具有相同的本质普遍性?比如AR在一直狂奔于scaling law下,其跨transfomer层的表征也将逼近diffusion式的推理。

另外一篇是斯坦福大学和Notbad AI Inc的研究人员开发的Quiet-STaR,让AI学会“思考”再“说话” Quiet-STaR: Language Models Can Teach Themselves to Think Before Speaking.https://arxiv.org/pdf/2403.09629.pdf

值得注意的是,这篇论文所提出的模型名字非常有意思「Quiet-STaR」,似乎预示着什么..论文中的Quiet-STaR 是以一种通用和可扩展的方式学习推理的语言模型。与上一篇不同,论文中将更多精力聚焦在推理任务数据上而非E2E模型结构或训练方法上。通过在多样化网络文本中隐含的丰富推理任务的范围上进行训练,而不是狭义地专门为特定数据集进行训练,Quiet-STaR 指引了更健壮和适应性更强的语言模型的方向。论文的结果证明了这种方法的潜力,Quiet-STaR 在提高下游推理性能的同时生成了具有质量意义的理由。论文相信这也开启了许多潜在的未来方向 - 例如,可以尝试对思考进行集成,以进一步提高对未来token的预测。此外,如果语言模型能够预测何时思考是有用的,例如通过在预测之前放置混合头,那么预测的混合权重可以用于在生成过程中动态分配计算资源。

通常,语言模型可以通过对问答数据集进行采样推理来自行训练其推理能力,即尝试回答问题、在推理导致正确最终答案时对其进行训练,然后重复该过程迭代解决更困难的问题。然而,从策划的问答数据集进行训练限制了推理的规模和普遍性。问答数据集,尤其是高质量的数据集,需要经过深思熟虑的策划,并且天生只能涵盖一部分推理任务。因此,论文扩展了STaR - 语言模型不是学习在特定任务(如数学问答)上推理,而是训练语言模型生成推理来帮助它从大型互联网文本语料库推断未来文本。因此,论文允许语言模型从语言中存在的多样化任务中学习。这建立在当前语言建模范式的一个基本直觉之上,即"语言模型是无监督的多任务学习者"。因此,与STaR一样,论文利用语言模型现有的推理能力来生成理由,并使用基于REINFORCE的奖励对语言模型及其生成的理由进行训练。论文将这种技术称为Quiet-STaR,因为它可以被理解为"悄悄地"应用STaR,训练模型在说话之前思考。

问题:论文发现平均来看,语言模型预测任意token的能力几乎没有改进。但是,当论文可视化相对改进的分布时,发现在更困难的token上改进是不成比例的。这反映了一些文本token实际上更难,而且受益于更深思考。论文试图提供一些关于改进发生的token类型的见解。换句话说,虽然在示例中思考似乎有助于许多token,但检查表明它不成比例地有助于预测回忆相关信息有用的token,比如适用定理的名称或证明下一步的开始。值得注意的是,这与 Prystawski 等人(2024)提出的框架非常契合。

另外,论文中尝试了验证性任务,这项任务的几个方面都有可能引入不稳定性。首先,也许最重要的是,生成的思考(或思考token)的效用是思考到其对语言预测的贡献的映射的函数。论文探索的一个解决方案是使用 Gumbel-Softmax 技巧和一个直通估计器 ,但是在许多连续的 softmax 操作中,论文观察到梯度消失。基本上,从 LM 输出到下一个token预测的映射越复杂,论文观察到的不稳定性就越多。另一方面,当论文在没有任何插值的情况下训练,即消除混合头并仅使用思考后的语言模型预测时,模型很快学会简单地忽略思考(论文没有看到任何下游任务的泛化

最后,论文总结到:虽然思维链提示和论文的方法之间存在自然的相似之处,但它们本质上是正交的。在思维链中,用户会积极提示模型“大声思考”,否则使用其普通的生成分布;而 Quiet-STaR 则会在每个token处安静地思考,生成的推理链的分布被其有效训练。这两种方法很可能是互补的。例如,在可能提示语言模型使用思维链的情境中,没有任何阻止论文允许模型在输出每个token的推理之前进行思考。论文进行了一个初步实验,表明内部隐式推理可能使模型能够生成更有结构和连贯性的思维链。

通过对上述两篇论文的核心观点进行总结,我们发现其两篇论文中都在尝试将中间推理过程与原始问题上下文进行联合采样,以对其隐空间状态的中所表征的推理(思维)的潜变量进行学习,即“过程学习”,不同的是两者所采用的模型结构及数据样本各有差异和独特性。同时,为了更深入的探究「系统二·慢思考」认知模式的本质,而不应仅仅停留在对思维的表征学习和其潜在变量对思维的简单表示这一静态表象层面,如这里提到的表征学习和潜变量的表示在认知推理过程中是如何体现和运用的?因此,我们需要跨越「系统二·慢思考」的这种更长程的认知推理过程的中回归第一性原理,寻找在两篇论文中的各自所尝试使用的创新训练方法和学习模式,与「系统二·慢思考」这种认知能力在底层有着哪些本质的联系。

如在香港大学发布思维扩散DoT中所提及的:「本质上,DoT逐渐更新表示隐藏空间中思维的一系列潜变量,允许推理步骤随时间扩散」中,其「潜变量」「隐藏空间」「思维」其对于模型系统二的推理或思维路径的背后更底层的本质是指什么?

为了更进一步探索背后的本质问题,为了方便大家回顾阅读,我将本节开篇的我的那条知乎回答再为大家贴到此处,避免大家频繁滚动页面对照。

知乎我的回答:

如题,我觉得人类的思维很有可能是基于此种tokenize的预测模式的,只不过tokenize的结果及过程形式会有一点不同,但回归第一性原理来思考,本质上是一样的。

另外从系统①(快思考)与系统②(慢思考)两者之间的内涵上来看其实也能侧面映射出当前LLM与人类的思维内涵存在着某种联系。任何模型在进行推理时,本质上都是对从一个状态(特征/过程)空间映射到另一个状态(决策/动作/甚至慢思考中的规划与反思…)的符号化(离散表征)或向量化(连续表征)空间,而这种映射其实模拟一下人类思考的思想试验也是类同的,而LLM模型网络内部和有研究表明的人类大脑,即其实亦是从一层神经元到下一层神经元的映射(神经元信号激活),比如这种映射可以表征对状态特征的提取,事物的具象到抽象,状态所对应的决策/行动...而这映射两端的不同空间表征是可以任意的且客观存在的,且随着人类行为的反馈亦机器的监督学习来建立关联的,当然这取决于“大自然”赋予人类的偏好决策与行动空间,就像人类赋予机器对应的任务监督模式与决策空间。

因此回到上述系统①和系统②,系统②相对于系统①,其实本质也都是同一的,只不过系统②在神经网络激活(信号正向传播)过程中,经历了不同的映射层,甚至在LLM所驱动的Agent中的规划,反思,如COT,TOT,GOT,AOT,BOT,XOT等策略过程亦是属于中间过程的不同表征空间的一种映射,只不过在映射的过程中通过in context上下文给予了提示(比如COT的step by ste..),而这种提示prompt有可能会激活(这里的「激活」在两者思维或运算推理过程中的数学本质上即是指将输入侧的信息向量化表征通过模型正向传播计算即数学变换)人类大脑神经元和模型中间网络神经元的信号传递的路径(当然路径是丰富多样的,并且模型或人类大脑在过程学习训练中可以呈现出上述泛*OT的这种模式)。

因此,对于上述所说的in context learning也好还是prompt leaning也罢其实对于人类和机器的推理与思考或直觉来说也是某种程度的同一。

当然LeCun提出了另外一种实现像人类智力能力的AGI-世界模型,强调模型在中间抽象层的构建,但我始终认为通过采用有效的训练与学习方法,模型在网络空间隐层中,是可以习得这些抽象概念的逐层映射推理表示的,关键采取什么样子的训练方法以学习到这种更抽象的类人能力甚至是超越人的抽象模式,也许LLM+RL强化学习是一条路径,包括引入相应的过程奖励函数,以及构造足够抽象可形式化推演的模拟环境以进行有效的self play(如围棋或数学证明)。→ 这里又会遇到另一个问题:这些虚拟环境与真实世界环境的空间可表征有多大差距,是否能通过某种方法进行逼近?当然即便无法有效完美逼近,在虚拟环境中所习得的抽象推理或决策(本质上是上述说的模式映射)亦可以通过迁移实现模型的的泛化。

如上所述,在回答中的前半部分,表述了对「系统二·慢思考」的一种认知推理形式上的阐释,对应的思维扩散DoT论文中所提及的「潜变量的表示或表征」,实际上体现的是在推理过程中位于不同状态空间的中的隐状态的动态过程映射,且映射两端的不同状态空间所表示的状态内涵包罗万象,如模型输入侧的像素空间、符号序列空间,模型隐空间层的不同特征变换空间、决策动作空间、推理思维空间,再到模型输出的结果侧的tokenize表示空间,其中在模型中的多个隐空间层,在形式表示上存在着对多层特征的抽象与变化过程,以及对多步骤的思维推理模式的演绎过程。而这种过程或模式,进一步抽象为更为简单的数学形式化表达则即是:建立潜变量对神经元信号状态(w·h)的抽象表示,在推理过程中进行数学变换操作,最终通过变换计算得出最终的结果,即形成了潜变量对某种状态空间状态的表征这一动态过程,如下图所示:

因此,结合本节内容逐步探索和进一步阐释,站在回归第一性原理思考的基础上,到了为各位伙伴们尝试针对「系统一 · 快思考与系统二 · 慢思考」这一概念进行本质性总结的时候了,我的阐释内容如下:

本节核心要点归纳与阐释:

「系统一」和「系统二」对于模型在推理过程中的底层映射与变换逻辑其本质上是相同的,其中「系统一」中所囊括的基本的事物的特征、知识和规律与「系统二」中所囊括的任何推理过程、思维路径和算法策略等均是可以被模型统一编码(或压缩)到多个状态空间层间形成状态组合映射与动态变换当中的,即模型统一实现对「现实物理世界空间」和「思维概念空间」到「模型隐状态空间」的表征。模型在推理过程在概念上体现出模型结构中不同状态空间层的「映射」,在数学上映射的过程即对应的数学「变换」,在形式上体现了多层神经元间的信号传递。两者在表象上的差异体现在模型训练的任务目标以及模型训练的数据分布构象的不同,如「结果」→「过程+结果」在训练目标和数据分布的差异。

在这里,如果上述本质的描述是能够自洽且被泛化的,那就意味着模型均可以通过建立这种空间状态映射机制,采用数学上的变换方法,对真实世界所存在的任何事物、现象甚至是人类脑海中的概念、逻辑、思维等进行某种程度的模拟,就像通过我们人类大脑或心灵一样,尝试用感性、理性的不同方法去思考、认知这个世界,将世界装入我们的内心世界并以此进行决策和行动。--- 这也是我在知乎上回答那位题主时当时内心的写照,也越来越感觉AGI离我们将不再遥远。

另外,在系统二的推理模式中,我们似乎能够找到将无限的”推理“压缩进模型内部即通过在模型的神经网络隐层中进行推理模拟,但这里我仍感觉我们应该进行稍微谨慎一点:这难是AGI最终实现的的其中一条路径吗?细想一下,人类的思考模式似乎也不是这种通过复杂的内在推理模式,但需要指出的是对于AI模型来说确实可以通过超过人类的这种内在的压缩或推理,在大部分领域超越人类,如当前LLM对世界通用知识的压缩某种程度上已经超越了人类。而无限压缩的这种模式在宏观的认识模式上似乎又存在着很多不同,如人类的推理和反思也是不断与外界交互反复多次的通过大脑神经皮层中的神经元进行信号传递激活并最终形成推理链完成推理的,这里与Agent的机制还是很类似的,因此,是否未来AI模型在通往AGI的路径中也需逐渐探索并最终达成模型E2E深度推理与类Agent推理机制的某种融合和平衡呢?

当然,本篇文章也希望能够为大家提供一种方法,以回归第一性原理的理性思考,去找寻事物间的一些本质普遍性与联系,在其中跑通底层逻辑的一些自洽性,这样在此基础之上,能够对不管是算法研究人员进行模型开发与建模,数据挖掘人员进行大规模的数据分析,认知应用产品设计人员来说,都能够更好的快速洞察到适合的探索路径中来。

本节尝试为各位读者阐释我对「系统一 · 快思考与系统二 · 慢思考」的理解和浅见,即便我们洞察到对于模型来说,似乎找到了对任何世界事物的压缩、编码或者模拟的可能,但即便如此,在通往AGI的路途中,也依然充满着一些荆棘和挑战,除了上述所说的E2E深度内化推理与Agent机制平衡的不确定之外,比如在接下来,对于需要考虑如何找到一个适合于模型的学习或训练方法,如何设定一个适应性、匹配性足够灵活的任务目标,如何发现或构造如此完备的数据样本在分布和构象上使得与上述中的那些学习方法和任务训练目标实现优雅的匹配也是十分重要的!接下来我将在下一个小节「RL与LLM融合的本质&阐释」中与大家一起进一步进行探索这方面所涉及的一些核心本质问题。

RL与LLM融合的本质&阐释:

在上一小节中尝试的探索了「系统一 · 快思考与系统二 · 慢思考」这一本质问题,自己也越发感觉AGI的进一步可能走进现实,但仍然面临着诸多挑战,包括如何找到一个完备的模型训练目标和用于模型学习所匹配的数据样本构象。

我们不得不将思路牵引至AI发展历史的长河当中,向上追溯人类在AI领域的发展历程的探寻中来,尝试发现一些端倪。当然这里肯定不会为大家展开全部的历史脉络,而是带着本节所抛出的问题,尝试发掘在AI历史长河中容易被人们所忽视的一些关键节点。当然,对于庞杂的历史,作者的阅历和认知能力肯定都是十分局限的,且接下来一些历史上梳理与见解也会以自己的阅历经验和主观的感受去进行回顾,势必会忽略一些非常关键且具有里程碑意义下的历史内容,这里先跟大家抱个歉,确实能力所限,不过也会尽量在过程中尝试将自己的一些观点和想法带给大家,希望能为大伙也提供一些方面的补充。

首先,按照历史发展顺序,站在人类AI发展史上,我想先从三个世纪之前的近代古典主义哲学蓬勃发展的时代说起,可能有人会问:欸?人工智能的开始场景不是都应该从古希腊哲学时代的亚里士多德的三段论来说吗?这里我要为大家解释下,我主观认为的三段论带给我的启发感觉更适合从逻辑学的源头开始追溯的好,当然逻辑本身也与认知或智能有着千丝万缕的联系,但我还是倾向于将其定位在演绎法下的逻辑推理的范畴,作为一种符号化推理的视角看待。当然在本篇全文的「下篇」中,当然还是会追溯到古希腊哲学世界,寻找有关智能的一些起源和给我们的启示,就不在本小节中展开了。

是的,既然从三个世界前的近代古典主义哲学时代说起,我想有大部分读者已经结合要讨论的主题猜到那一位哲学巨匠了:伊曼努尔·康德(德文:Immanuel Kant)。

那么之所以要从康德说起(当然这里还是夹杂着作者自己的一些主观认识和感情色彩),主要是来源于其代表作品《纯粹理性批判》、《实践理性批判》、《判断力批判》三部曲,其三部作品对于其在哲学认识论上的思想包含如下内容:(提示:考虑到不同小伙伴的阅读体验和感受,下面一段可自行省略..)

“纯粹理性教导人们人类知识是以经验为基础的,但实践理性认识到在心灵中还存在一个先验的观念,不受经验的支配,它假设了人类自由、上帝和不朽这些观念一因此,他一边区分唯物主义和唯心主义的不同,一边又试图找到两者之间结合的纽带。”

“纯粹理性”是指独立于一切经验的理性,“批判”是指对纯粹理性进行考察。康德为该书冠以这一名称,是为了弄清人类认识的来源、范围及其界限。

康德的批判哲学的认知论:对人类认识能力本身的这种分析就进入了认识论的领域,因为这种分析本身已经是一种认识。康德在《纯粹理性批判》中所提出的认识论的总问题是:先天综合判断是如何可能的。在他看来,一切知识都基于判断,因为单个的表象或概念是无所谓真假的,只有把两个表象或概念连接起来形成一个判断(如“这朵花是红的”),才有真假问题,才构成知识。判断可以分为两大类:一类是分析判断,一类是综合判断。所谓“分析判断”是指这样一类判断,判断的宾词原本就蕴含于主词之中,实际上是把早已蕴含在主词之内的东西解释出来而已,如“三角形有三个角”。显然,这类判断具有普遍必然性,但由于宾词只是对主词的解释,并没有增添知识的内容,因而并不是严格意义上的知识。所谓“综合判断”是指这样的判断,宾词并不包含在主词之中,是后来世人通过经验加在主词上的,如“物体是有重量的”。显然,这类判断能够扩展世人知识的内容,帮助世人认识世界,因而只有综合判断才是真正的知识。综合判断虽然是知识,却不一定是科学知识。“综合判断”还可以划分为“后天综合判断”与“先天综合判断”。只有“先天综合判断”既能够扩展世人的知识,又具有普遍必然性,它才是最终使世人能够不断获得新的可靠的科学知识的根据。

...

因为篇幅原因不为大家做过多的关于康德的哲学思想的展开,这里之所以将康德引入到本节作为追溯人工智能历史长河中的第一站,正是因为康德在上述三部曲中所体现在人类对认知论上的统一以及指导性见解,也为欧洲哲学史上带来的重大转折意义。

我们发现,在其对人类认知和知识的思考中,会为很多当前人工智能和认知科学发展带来借鉴意义:

如:他认为人类先天地具有这一套认识形式,才能把感觉材料组成知识。如果没有这套主体的认识形式,我们就不可能得到普遍必然的科学知识,也就是说不可能认识客观世界。这个看来似乎是荒谬的先验论,实际上比旧唯物论从哲学上说要深刻,从科学上说要正确。近代科学已经证明,认识并不象旧唯物论所理解那样,是一种从感觉、知觉到概念的循序渐进的单线简单过程。不是那种被动的、静止的、镜子式的反映。

在这里,我们发现他将认知与获得知识紧密的联系起来,我们试想一下,这里的“认识形式”是不是有一种感觉指向了AI的模型训练过程,即模型如果理解世界、认识世界,而“知识”则对应于人类在理解了世界的知识后,所能进行的推理、决策和行动。在这里,虽然对于神经网络模型来说,“知识”看起来并没有在认知推理过程中间呈现出一种符号化形态,其主要是融合在网络模型中的正向计算过程中,但并不能说“知识并不存在”,模型也可以通过生成能力侧面呈现出在推理过程中所运用的知识,就像人类在进行某类复杂任务的决策过程中,会运用先验知识辅助判断。

又比如,在康德的关于批判哲学的认知论思想中,其认为“一切知识都基于判断,因为单个的表象或概念是无所谓真假的,只有把两个表象或概念连接起来形成一个判断(如“这朵花是红的”),才有真假问题,才构成知识”。在这里我们是否可以试着对比一下AI在进行监督学习训练过程中所使用的Xi-Yj的数据样本集,其中Xi到Yj需要建立明确的监督信号,在康德表述中体现为这种“判断”。

我想无论当时康德的认知论思想对于人类开始现代认知学研究以及人工智能领域研究起着多大的作用,但至少也能够为先贤们建立一定的指引和信念的吧,作者本人在阅读康德的理论时,能够明显的感受到在某些深入的思考中,能够洞见其哲学思想的影子且甚至能够有些时候让我幡然醒悟,如康德的”先验辩证论“思想中所提及的知识的”彻底性“上,也为我对先前和当下对AGI的认识和定义,有着不一样的思考。

当然,在康德的整体关于认知论的宏大思想中还有诸多观点,由于篇幅和主题原因就不在这里为大家一一呈现了,包括对于“先验感性论”、“先验分析论”、“先验辩证论”、“实践理性的共设”等内容。大家如果感兴趣的话可以自行从其它渠道进行阅读和学习,个人也非常期待能与大家针对这一领域进行更多充分的互动和讨论学习。

接下来,让我们加快点速度,将时间推移到近现代-20 世纪 40 年代和 50 年代,其中计算机科学的发展为人工智能的研究奠定了基础。随着计算机技术的进步,人们开始尝试使用机器来模拟人类思维和解决问题的能力,并找到了人工智能的真正的机器载体。

在近现代几十年中,人工智能发展迅猛,从1950年英国数学家阿兰·图灵(Alan Turing)提出了著名的“图灵测试”算起,到1956年的达特茅斯会议,从符号主义学派的专家系统到链接主义学派的感知机和神经网络,从深度学习的高速发展到当前的大语言模型的爆发式发展,在这短短几十年之间,人工智能发展经历的三起二落,以及技术突破所带来的阶段性不同程度的爆发。在快速发展的过程中,我们当然也无法遗忘在过程中众多巨人所为未来开创的具有重大意义的里程碑事件。

在这里我试图列举几个我认为为当下人工智能发展带来重大意义的事件和技术:

1、20世纪50年代,纽维尔和西蒙开发了一个名为“逻辑理论家”(Logic Theorist)的程序,该程序能够证明数学定理。此后,他们又开发了“通用问题求解器”,用于解决各种问题。

意义:符号学派的代表,其开发的“逻辑理论家”(Logic Theorist)的程序,在当时为形式化证明打开了一扇大门,70年后我们发现,当前LLM在尝试进行的复杂数学定理证明是否又能与其建立某种更深层次的联系?

2、20世纪60年代,美国心理学家弗兰克·罗森布拉特提出了感知机模型,这是一种具有学习能力的神经网络。

意义:连接主义学派的开创,为DNN这一意义深远的学习范式开启那扇窗。

3、AlexNet

意义:AlexNet的出现标志着神经网络的复苏和深度学习的崛起。

4、AlphaGO战胜李世石

意义:

在围棋这一复杂领域AI第一次战胜人类,神来之笔37步,也预示着在其它的复杂领域上AI在与人类的智能对比的进一步突破的可能

强化学习(RL)大放异彩

5、ChatGPT

意义:就不多说了,ps:这里之所以放IIya的照片是为他对GPT所做的贡献,对AGI的敬畏以及对AI未来安全的谨慎态度的敬意。

以上列举了作者本人认为的在人工智能发展历程中,有重大意义和影响的一些事件或技术突破,当然,为了聚焦到我们本小节的「RL与LLM融合的本质&阐释」这一本质问题的探索,从题目中我们也可以发现结合当下LLM这一技术路线发展面临的瓶颈似乎与RL多少更加相关一些。(这里并不是说之前的感知机、AlexNet、Transformer甚至是Logic Theorist并不重要,他们都为当前的LLM的发展打下了非常坚实的基础)

正如在「上篇」中的开头部分,我们从Alpha系列开始讲起并在「上篇」中的中间部分详细对AlphaGO和AlphaZero进行方法回顾,对Algorithm Distillation (AD)方法给我们的启迪所带来的进一步的探索和思考,以及介绍了AMIE中所采用的基于self-play环境下的RL思想及内涵。我们现在似乎能够感觉到LLM与RL在当下与未来会存在某种联系。

在「上篇」中的最后,我们尝试对LLMs的本质进行探查中,我们了解到最初的LLMs在scaling law下,最终突破了临界点达到了能力的涌现,但这种自回归的序列标记预测的模式(AR prediction+tokenize),是否能够最终在更多人类历史数据样本和进一步扩大模型参数并扩展算力的基础上突破新的瓶颈呢?在这里,我们发现出现了三个方面的问题:

1、当前LLM似乎无法满足像系统二·慢思考那样,在开始进行next token prediction前,进行提前的规划或反思,正如前OpenAI雇员Andrej Karpthy与去年5月份在微软Build大会演讲后半段中所说提及的那样:

“基本上,这些Transformer就像标记模拟器。它们不知道自己不知道什么,它们只是模仿(预测)下一个标记;

它们不知道自己擅长什么,不擅长什么,只是尽力模仿(预测)下一个标记;

它们不反映在循环中,它们不检查任何东西,它们在默认情况下不纠正它们的错误,它们只是对标记序列进行采样;

它们的头脑中没有单独的内心独白流,它们正在评估正在发生的事情;

特别是如果任务需要推理,不能指望Transformer对每个标记进行太多推理,某种形式上必须真正将推理分散到越来越多的标记上;

例如,不能向Transformer提出一个非常复杂的问题并期望它在一个标记中得到答案。(用于计算的)时间不够;“「个人见解:本质上,复杂类问题或需在模型进行训练任务过程中的样本不足或为零导致的泛化能力不够或无法完成对其中pattern的泛化学习」

LLMs对于系统二的局限性思考:

「自主模式下的局限性」:LLMs在自主模式下(即没有外部验证或提示的情况下)并不能生成可执行的规划。即使是最先进的LLM(如GPT-4),在没有错误并达到目标的情况下生成的规划平均只有约12%是可用的。这表明LLMs可能只是做近似的规划检索,而不是真正的规划。

「无法自我验证」:LLMs无法验证自己生成的规划,因此无法通过自我批评来改进。尽管有人认为即使LLMs不能一次性生成正确的解决方案,通过迭代提示,它们可能会通过“自我批评”来提高准确性。但研究表明,LLMs在验证解决方案方面并不比生成解决方案表现得更好。

「知识获取与执行规划的混淆」:有研究表明LLMs具有规划能力的论文实际上混淆了从LLMs中提取的一般规划知识与可执行规划之间的区别。规划任务需要不仅仅是规划领域知识,还需要能够将这些知识组装成一个可执行的规划,考虑到子目标/资源的相互作用。LLMs通常在提取规划知识方面做得很好,但这并不意味着它们能够生成可执行的规划。尤其是超级复杂的规划由于LLMs本身这种next token prediction的局限,以及在pre-traning和alignment方面对数据分布构建的挑战,使得很难完成复杂规划任务。

「对自我改进的误解」:有研究声称LLMs可以通过生成规划、自我批评规划然后使用这些规划来自我改进(例如通过生成合成数据来微调自己)。然而,由于LLMs无法验证自己的解决方案,这种自我改进的方法实际上可行性未知。

2、人类过去200年所积累的历史记录数据将会马上枯竭,届时将无法为LLM持续训练提供更多的历史数据,且即便基于LLM构建了大规模稳健的数据飞轮反馈机制,恐怕在之上所反馈的可用于LLM持续训练的数据也远远无法满足数量要求(因为在scaling law,训练一个更大的参数的模型则需要指数级倍数据样本量用于模型训练,同时对算力需求也是按照数量级增长的,对于算力的需求增长又将会引来另一个要素问题:能源)。同时,Moonshot AI杨值麟在近期的访谈中针对上述问题所给了一些看法和解释:

“AI 本质就是一堆 scaling law..今天能看到最好的模型是 10 的 25 到 26 次方 FLOPs 这种规模。这个数量级接下来肯定还会持续增长,所以我认为算力是个必要条件,因为机器学习或者 AI 研究了七八十年,唯一 work 的东西其实是 scaling Law,就是放大这几种生产要素。

你需要一个同时满足 scalability 和 generality 这两点的架构,但今天其实很多架构已经不满足这两条了。transformer 在已知的 token space 符合这两条,但放大到一个更通用的场景,也不太符合。数据也是一个生产要素,包括整个世界的数字化,和来自用户的数据。

现在“吃”的是 base model 的 scaling law,未来可能会去“吃”用户这个数据源的 scaling law。

因为其实 alignment 也有 scaling law,它肯定是可以被解决的,只要你能找到对的数据。AI 本质就是一堆 scaling law。

一个值得被 scale up 的架构是基础,这个架构首先得支持不断加入更多数据,然后数据才会真的成为瓶颈。我们现在说的数据瓶颈,从文本模态上,2024 年就会遇到,但多模态数据的引入进来会把这个问题推迟 1-2 年。

如果视频和多模态的卡点解决不了,那文本的数据瓶颈就会很关键。这点上其实我们也有些进展 —— 如果限定了问题,比如数学或者写代码,数据是相对好生成的。通用的问题现在还没有完全的解法,但是存在一些方向可以去探索。

统计模型没有什么问题。当 next token prediction 足够好的时候,它能够平衡创造性和事实性。

到了 GPT-6 这一代,掌握合成数据技术的玩家会体现出明显差距。因为数据其实有两种,一种是做 pre-training 的数据,另外一种是获取成本更高的 alignment 数据。如果掌握了数据生成技术,alignment 的成本可能会降低好几个数量级,或者能用一样的投入产生更大的几个数量级的数据,格局就会发生变化。

我觉得 2025、2026 年可能是很重要的 milestone —— 模型的大部分计算量会发生在模型自己生成的数据上。

26 年的时候也许模型用于推理的计算量会远远大于训练本身,可能花 10 倍的成本去推理,推理完之后花一倍的成本来训练。会出现新的范式,推理即训练,而且这个推理不是为任何用户服务的,只为自己本身的合成数据服务。

出现这种情况的话,能源的问题也解决了,因为推理是可以分布式的。而且它不违背定律,本质还是个能源守恒。只不过我把计算范式改变了,让能源能够以分布式的方式解决。”

3、大家可以做一下思想试验,即便我们拥有足够多的历史数据,足够的算力以及能源基础,那么LLMs会继续在未来几年scaling law下持续狂奔嘛?又会出现很多我们预想不到的智能涌现,最终达到AGI,甚至超过AGI实现ASI?

Think:我想先为大家做一下这方面的思想试验,我在想很多RL学习中所运用的算法比如AlphaGO在围棋中的复杂决策,是否能够通过在近乎无限的大量数据中习得泛化经验吗?当然如果数据确实是无限的,那么对于pre-training来说其代价是否太高了?而对于alignment来说,则会面临数据alignment本身的诸多挑战,如:如何找到完备的alignment的匹配的样本数据,alignment过程中的数据多样性的保障,合成数据看起来能带来解决上述两方面的问题,但合成数据是否能在生成的数据过程中涌现出新的洞察或知识,以便在训练中被模型习得?

另外,对历史真实世界数据的采样,是否仅仅是学习人类过去已经先验并总结过知识并形成的最终文本表征的结论,其对应的本质等价于这些知识或结论最终仍是来自于真实世界数据的的分布或构象上的表征,而这种历史数据的分布或构象似乎无法通过模型的自回归生成式模式习得到人类在现实世界中未曾见到、更深刻的洞见以及新的知识结构,似乎仅仅是对生成的语言分布概率做了重新排列或组合,并在这种重排列或组合的过程中反复利用已经掌握的泛化能力进行表象知识的发现、探索和链接,从而扩展了某种维度的知识结构。

因此,这里我们是否也会回归到对pre-training与alignment的本质区别的思考?是否在两者底层对数据的洞察层面上有着一定的内在联系?

针对上述三个问题,仔细品味之后,越发觉得三者之间背后有着某种隐含的联系,不知大家是不是也是这样认为的?

首先,我们尝试将问题1和问题3合并一期来看待,针对问题3中所提及的那个“预想不到的智能涌现”,以及当我尝试在做思想实验时体会到的AlphaGO所面对的复杂决策情景,再到alignment中所面对的一系列挑战等,是否可以通过系统二·慢思考的方式得到解决?

通过近期在学术上的多篇论文前沿探索,结合早期关于COT、TOT、AOT、XOT等规划策略类思想并结合Agent框架的理念,同时一些其它领域科研工作者使用GPT-4作为辅助工具对本领域研究探索及取得的突破,以及文章「上篇」中开头部分介绍的AlphaDev模型来看,似乎系统2正在尝试突破解决上述问题3。

而在上一节「系统一 · 快思考与系统二 · 慢思考」中我们提到,系统一与系统二在本质上具有底层逻辑的一致性,我们似乎有可能也找到不同于LLMs那种采用AR next token prediction的训练方法亦或不改变AR模式而对训练数据的分布和构象进行调整以实现模型E2E自主复杂推理过程。但在这之前,我们当然也忽略不了一个关键的事情,即在上一节中提到的「系统一与系统二两者在表象上的差异有可能体现在模型训练的任务目标以及模型训练的数据分布构象的不同,「结果」→「过程+结果」在训练目标和数据分布的差异,即 如何找到一个适合于模型的学习或训练方法,如何设定一个适应性、匹配性足够灵活的任务目标,以及如何找寻甚至构造完备的数据样本在分布和构象上使得与上述系统二中满足复杂长链推理的那些学习方法和任务训练目标优雅的匹配?正如杨植麟所说:"只要你能找到对的数据,AI本质就是一堆scaling law"。

我们发现上述内容也将问题2中所面临的部分问题联动了进来,即数据在scaling law上所面临的瓶颈。因此,当能够采取某种方式解决问题1和2之后,其联动引发的对数据的资源重组、价值延展及要素定位有可能会进一步改变当前的数据可用训练资源体系的现状。

因此,目标似乎变得逐渐清晰起来,我们要找到一种方法,为模型达到下一次智能涌现或者持续突破涌现的边界,找到一个适合于这种模型学习或训练的新范式,设定一个适应性、匹配性足够灵活的任务目标,发现或构造一个足够完备且可持续的数据样本体系使得在样本的分布和构象上与上述中的那些学习范式和任务目标实现优雅的匹配。(前面高亮的这段话其实是提前向各位读者们明确出了基于第一性原理思考的可能的技术实现路径,如果小伙伴们不是特别理解,下文的探索中将会为各位道出其缘由)

我们回到LLMs与RL上来,为什么要将LLMs与RL联系到一起呢?在上面问题3中,我们目前看到LLMs正在开足马力将人类历史数据进行快速的学习(大规模pre-training+SFT),但可以预见的是这些全网开放数据将会被耗之殆尽,那么下一步算力将会聚集在alignment层面上,我们知道ChatGPT在进行RLHF时,确实也耗费了不少成本和算力(当然RLHF所消耗的算力与pre-training难以相提并论且RLHF更多是需要人类进行较高成本的标注且针对RM训练才能work的)。

但即便如此,我们发现,从ChatGPT到GPT3.5甚至GPT4.0,其在深度逻辑推理、复杂计算、科研探索等领域仍存在着较大的局限性,我的观点猜想是当时ChatGPT在进行最后阶段的RLHF时也有可能仅仅是在做一些通用泛化上的alignment(通用泛化这里仅指在跨表象领域中的所提取出的某种维度的浅层共性Pattern),如整体上基于QA交互层面对生成内容的交互性、合理性、安全性、风险性等进行对齐,当然在对齐数据的标注筹备中亦是要体现更加全面、多样化的场景通用性。

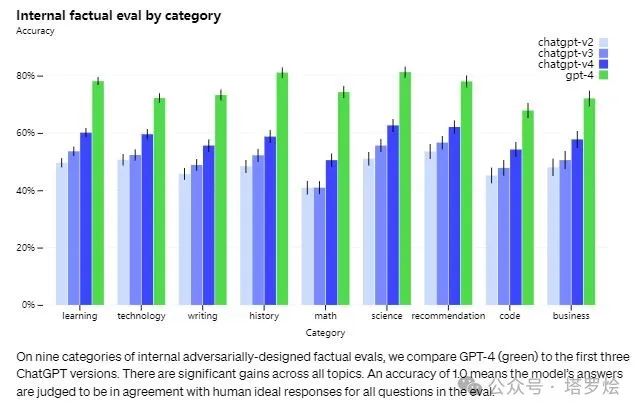

如在GPT-4的官方技术报告中我们可以得出(https://openai.com/research/gpt-4):GPT-4 尽管功能很强大,但它和早期的 GPT 模型有相似的局限性,有时候会虚构事实并作出错误的推理。大家在体验 ChatGPT 的时候可能也发现了,它对稍微大一点的场景设计容易出现上下文衔接不上的问题。前几句回复还能保持和当前场景融合,越到后面越会脱离当前场景做一些新的设计,并且这些设计并不符合当前的场景。OpenAI 表示,在每次迭代中都会改进,这也是 ChatGPT 开放使用的意义,在训练中持续优化。这些问题 GPT-4 虽然没有完全解决,但是相对于以前的模型,在我们的内部对抗性真实性评估中,GPT-4 的得分比 GPT-3.5 高 40%。

同时,GPT-4有时会犯简单的推理错误,这些错误似乎与跨多个领域的能力泛化问题相关,或者在接受用户明显的虚假陈述时过于轻信。有时它会像人类一样在难题上失败,例如在它生成的代码中引入安全漏洞。GPT-4 也可能自信地在其预测中犯错,在可能出错时不注意仔细检查工作。有趣的是,基础预训练模型经过高度校准(其对答案的预测置信度通常与正确概率相匹配)。然而,通过我们目前的训练后过程,校准减少了。

因此,从上述内容中,我们也可以猜想GPT-4的能力似乎主要来自预训练过程,原因是更多的性能提升聚焦在很多基准性能的评测上,如RLHF 并不会提高考试成绩这类基准。与之前的 GPT 模型一样,GPT-4 基础模型经过训练可以预测文档中的下一个单词,并且使用公开可用的数据(例如互联网数据)以及我们已获得许可的数据进行训练。这些数据是网络规模的数据语料库,包括数学问题的正确和错误解决方案、弱推理和强推理、自相矛盾和一致的陈述,并代表各种各样的意识形态和想法。

那么,我们如何找到一种方法能够再一次将GPT-4所面临的上述问题进行解决呢?这种解决方法是否还将遵循于scaling law呢?看起来在pre-training阶段,随着历史数据资源的临界点的到来将会马上遇到scaling的瓶颈,那么在做RLHF的alignment方面呢?RLHF与Pre-traning之间又有着怎么样的本质联系或差异呢?

在回答上述疑惑前,我们不妨先将LLMs当前所遇到的问题放一放(因为毕竟OpenAI对外的技术报告并没有非常清晰的阐明其中的技术细节),转向RL上面,而且在RL与RLHF上似乎两者之间也有着一些联系。

在文章「上篇」中开头部分以及中后部分,我们针对Aphla系列和AMIE等模型进行了比较详细的技术拆解分析,我们似乎能够隐约的得出一些洞察:

-

RL过程能够通过基于某一环境动态模拟(博弈/self-play)而产生新的数据样本,而这些数据正因为来自于某领域内的模拟且模拟过程记录的意义局限性而没有被系统所大量的记录;

-

正因为RL的这种学习机制,在学习过程中模型学习/压缩的知识形态(如围棋中的行动策略/代码逻辑/数学推理..)更加抽象且在RL过程中时产生的中间数据记录表征与人类自然语言文本符号化表征分布有着很大的差异;

-

综合上述1&2的洞察,似乎能够得出,RL过程模型学习到的知识(这里指RL任务的特定策略、推理性知识等)与以往从现实世界所记录的数据进行监督或自监督训得的模型所压缩的知识应该是弱相交的;

因此,依据上述三个方面的洞察或猜想,我们自然的将LLMs与RL想到了一起,用RL去进一步增强LLMs的泛化能力与领域知识,但同时我们仍然会遇到另一个问题,RL与LLM看起来是两种完全不一样的训练模式,两者的结合是否可行?如何去做?

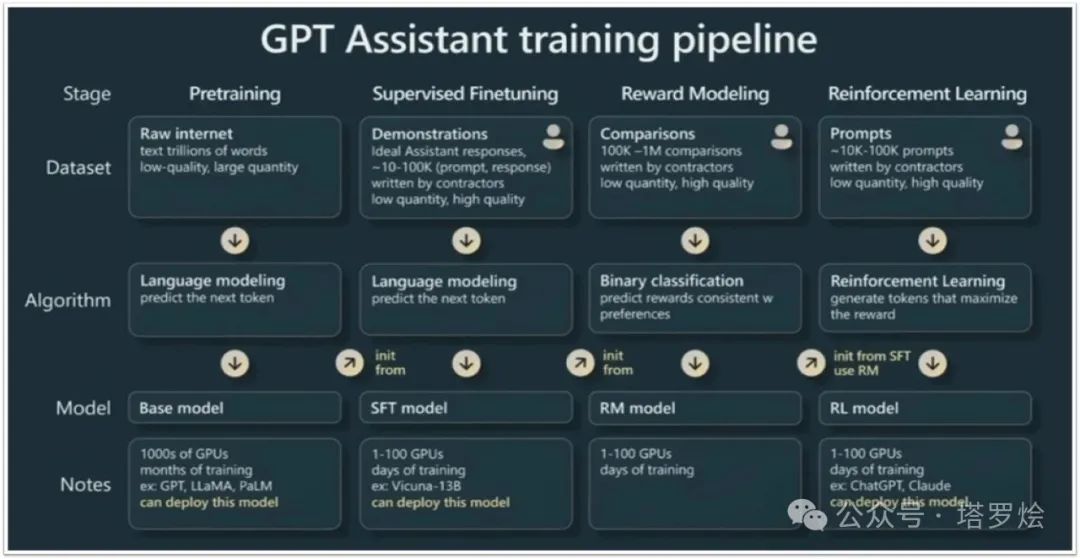

再次回到文章「上篇」中,对于AlphaGO和AMEI模型的详细介绍中,我们其实已经能够找到RL与LLMs在训练过程中的一些本质共性—均是对目标函数进行梯度求导,只不过目标函数的设计以及数据样本的构建来源与模式会有一定的差异性,需要通过一些工程化的技巧去进行粘合,最好的例子就是ChatGPT的RLHF(RLHF本质上就是一种简单环境模拟形式的RL呀,与传统RL形成略微差异或创新的是其中增加了额外Reward Model用于训练+判别)。因此在ChatGPT发布后,通过其发布的公开技术报告中,包括模型训练的四个阶段:Pretraning、Supervised Fineting、Reward Modeling、Reinforcement Learning(后两个阶段即是RLHF),通过分阶段任务设定与对齐封装,最终完成对自回归(AR)模型+强化学习(RL)模型的融合训练与迭代,当然这里运用了迁移学习

前面我们曾提及,“即便ChatGPT在进行最后阶段的RLHF时也有可能仅仅是在做一些通用泛化上的alignment(通用泛化这里仅指在跨表象领域中的所学习到的某种维度的浅层共性Pattern),如整体上基于QA交互层面对生成内容的交互性、合理性、安全性、风险性等进行对齐。”可以想象LLMs最终阶段所采用的RLHF远远没有达到像围棋(AlphaGO)、数学定理证明(AlphaGeometry)、代码策略(AlphaDev)等RL模型那样高度抽象泛化能力的学习,诚然这也取决于其RLHF的思想还是基于符号tokenize在语言交互的范畴上来完成RL的,并通过额外训练一个Reward Model来进行奖励的反馈(对于RL来说稍稍略显僵硬但实用,同时也受限于语言交互的tokenize的局限所致)

因此,除了上述RLHF基于语言交互的场景过程中内容生成交互性、合理性、安全性、风险性等考虑之外,为了进一步加深模型复杂推理以及领域深度泛化能力的学习,相对确定的路径是建立LLMs与RL的对齐封装,这里会涉及到数据tokenize描述的统一、self-play模拟的规划、以及相关Policy Network & Value Network & RM & Loss Function的设计、随机搜索策略结合任务代价的考量等。

一些关于RL所涉及的基本概念就不为大伙不做过多介绍了,RL相关技术非常成熟且学习材料都很好获得,这里着重强调一下与LLMs融合上进行self-play的模拟规划方面:

众所周知,RL在围棋和虚拟游戏场景下具有天然的适配性,取决于其封闭的模拟场景下丰富的可扩展探索空间及有限且规范的行动决策规范,因此,这也意味着在RL训练时可以遵循着一定的模式即反馈机制来完成策略的持续学习,当然在训练过程中也要着重考虑探索空间的大小以及行动决策的复杂性已采取一些搜索策略或网络结构的优化及取舍。

但当将RL思想迁移至NLP场景时,我们可能需要重新反思并定义一下self-play模拟的边界以及空间探索及行动决策的内涵,以便可以将思想灵活迁移并运用。如LLMs在RLHF过程中,单独训练一个RM进行判别来完成目标函数的逼近,并基于人类少量标注并提示模型内容生成的方式完成另一种形式的对搜索空间的探寻采样(与self-play有一些形式上的类似)。另外,在文章「上篇」中,我们所介绍AMIE是通过构建Muti-Agent的方式完成对self-play场景的构建,并通过多角色交互探寻与反思的机制完成对场景的模拟,并将基于多角色交互生成的数据用于模型下游的SFT,以学习长交互模式,即属于RLAIF。

另外针对问题1中关于系统二·慢思考过程中的长链推理,除了可以基于人类历史所积累的“慢思考”思维数据进行模型训练以习得思维表征外,亦可以利用RL思想,将多步搜索探寻步骤纳入到模型训练过程中以表征过程决策。

但是,这样就结束了吗?远远没有..而且相信大家还会有如下诸多疑惑和底层本质问题的不解。

-

基于RL对LLMs的增强是否能够实现对最终模型泛化结果的性能保证?

-

如何对RL中的self-play模拟场景的规划体现完备性?RL的self-play在场景的广度和深度探索上的所容纳的数据多样性如何保证?

-

RLHF与RLAIF对于self-play

-

RL在对齐pretrained LLMs之前,针对RL所涉及的领域场景和训练后泛化能力的预期及对LLMs的后RL效果如何把握?

-

RL是否能够做出对模型跨领域能力迁移的保障?有没有一些预评估策略或机制?

-

RLHF/RLAIF对Pre-trained LLMs具体做了哪些目标的优化?Pre-training对于模型来说学到的是哪些知识?RLHF和Pre-training有啥本质的区别?

上述问题尝试从两个维度的思考为大家提出一些思路,当然并不能完全彻底的解决上述问题。

1、首先是RL的这种self-play对LLMs所带来的价值意义与价值边界问题的思考

-

我们知道对于围棋和其它对弈类游戏的self-play内部中均有自己系统内的完备规则以及策略集合,而这些self-play内与外部用于pretrain LLMs的大量历史数据(文本类数据)来说,直觉上两者间所蕴含的「泛化能力集」应该有着很大的不同。因此,如果可以合理的将self-play所蕴含的泛化能力迁移到LLM中,将有效增强其领域泛化边界。但我们判断在一个大的领域范畴中,比如数学形式化证明体系,其所包含的泛化能力范围及边界到底能有多大上面可能会有不小的挑战,因为泛化能力当前很难采用某种形式化的手段进行洞察并有效表示,因此我们可能需要通过其它如整体的策略集合大小、状态集合大小来进行某种估算。

-

另外,多个不同的self-play模拟空间中其各自的「泛化能力集」直觉上应该也有很大不同,因此在采用RL self-play进行超级alignment过程中为了促进模型通用泛化能力的提升,应该进行更多self-play场景模拟构建并保障多样化的数据alignment。

这里提出一个新概念和新假设,①新概念:泛化能力集,代表某一个领域的泛化能力的集合,泛化代表了某种现象到概念的抽象,因此我们通常在掌握或能够利用泛化能力的意义在于,我们可以举一反三,即并能够针对看似不同类型的问题,按照回归第一性原理的思路从底层逻辑上去归纳总结;②新假设:我们假设这个完整世界内存在很多泛化性,而不同领域内的泛化性有相关性也有领域内的独立性。

-

不过也不排除领域内世界的泛化能力与领域外世界的诸多场景是重合的甚至是有着某种泛化依赖的,如比较特殊的数学,我们知道数学的形式化证明体系,可以说对于物理、化学、生物等多学科甚至是多领域交叉学科背后的理论都有数学方法作为基础支撑,同时其各自领域内的复杂计算和推理也都离不开数学的形式化证明体系。因此,直觉上,数学应该是未来LLMs需重点关注学习的领域。这一点其实与人类也很相似 “一般数学好的同学,理科应该都不太差”

-

前面我们有提到,ChatGPT所进行的RLHF本身其实也是一种简单形式的self-play(这种self-play在其中的模拟环境对规则、策略和奖励所构成的反馈机制上,与传统大家所认知的RL self-play似乎有着感性的差异,是否是有本质的差异不确定)。那么对于RLAIF来说,我们知道,之前我们所认为的RL之所以能够为LLMs带来增强,主要是其所拥有的「泛化能力集」的差异化优势,如围棋中通过不断探索、试错(MCTS)来增强决策能力,而对于RLAIF来说,如具体拿Muti-Agent举例,每个Agent在基于交互协作的环境中所生成的决策和内容均是依赖于当前最优模型内在的知识和先验泛化能力(先忽略Agent对LLM的限定因素),因此,这里会出现一个问题:看起来RLAIF合成模拟的数据,并没有为LLMs进行下一步的alignment带来新的知识与泛化洞察能力的提升,也就是我们前面所说的「泛化能力集」差异化优势。然而事情真的是这样的吗?有几个事情我们是能够看到的:

-

①在Muti-Agent情境下,我们形成了复杂多轮会话以及协作行动过程,是的「过程数据」,是否意味着我们为系统二进行有效大规模的过程学习提供了一条路径,虽然在Muti-Agent下,每一步agent的交互协作均是其背后驱动的LLMs依据原有内化的知识来进行决策的,但我们发现通过多轮复杂决策生成的过程性内容记录,其数据整体所呈现出的语言结构与模型之前用来进行预训练或SFT的数据样本的整体分布和构象有着较大的不同,因此这种数据样本分布的不同对于模型来说也会必然捕捉到这种分布并加以学习,即过程学习,也是一种新策略的学习;

-

②针对RL能否对LLMs起到增强和提升,主要取决于LLMs能否从RL过程中习得新的策略,新的策略的另外一种判别就是其新策略的生成不依赖于历史数据样本以及模型依据自身知识和泛化能力推理生成的内容,即足够新颖,如AlphaGO在训练过程后期就不会再依赖人类历史先前的棋局来进行参考,而是通过自博弈的方式快速创新着子策略,并快速反馈奖励,而AlphaGO最终的目标是赢得棋局;因此,从另一种RL运行模式的视角完整的来看,Muti-Agent在得到一个复杂的任务后(任务目标),是否每一次的Agent交互也是在像围棋着子一样在进行策略的尝试与搜索(注意:而这种每小一步的探索或者尝试可能是依据于上下文背景或者子目标的,而非整体目标!这意味着,从宏观目标上来看,这便是对于整体目标出现了新的泛化方向的尝试,不管这种未知的泛化在未来期间所呈现的过程、形态是什么,这里的泛化导向因受muti-agent影响,应该是朝着多步骤决策方向去的呼应①),而对于这个Muti-Agent来说,其最终奖励即是其最终任务结果达成目标。

-

可能有伙伴看了这里会有点绕或者困惑,稍微也跟大家解释下自己的看法:其实这里①和②本质过程是一样的,学习目标也是一样的,所习得的中间泛化能力也是一样,只不过①是站在LLMs这种自回归式的过程学习的视角上,将我们的注意力拉到了对生成的数据样本分布上来,而②则是从RL策略搜索的角度

2、RL中的self-play或RLHF或RLAIF等反馈机制对于LLMs alignment过程的本质探寻

这个思考其实在于探寻RL可能对于LLMs进行了哪些优化及改良,其中路径是怎样的且最优的呢?这个问题本身属于一个在对齐领域的比较有挑战的问题,之前OpenAI在RLHF领域也没有分享更多的技术细节,因此在这里我有一些不太成熟的想法尝试跟大家碰撞一下:

ps:不过还是要在这之前跟大家提前说下,下面的这段内容更多是针对上述问题偏发散一些的思考,对,即Diffusion Thinking,因此可能就像Diffusion Modeling那样,过程中可能引入一些noise,不过我也会尽量控制nosie的扩散分布并在最后强化降噪:),如果大家这里读起来有些困惑,那绝不是大家的问题,而是在于我并没有找到更好的方法进行表述,大家可以忽略这小段内容,直接跳到后面的结论性阐释部分。

-

如果RL下的self-play亦或者HF/AIF能够尽可能多的带给我们一些历史真实世界数据所没有的、未见的、新的洞察或泛化的可能,那么alignment是会遵循scaling law的。尽管其中的数据也是AI合成的(也夹杂包含着模型本身的知识,习惯和泛化性),但新的环境和在去做alignment的过程中也许会将领域的泛化性进一步增强而出现领域内的“涌现”

-

换句话说,在真实物理世界中,泛化性(或抽象概念)本身也有数量,特性,囊括度,在真实世界的分布性等特点的,因此分别在pre-training与alignment过程中,其实也是体现了两种对这个世界泛化性的学习(这种学习也是在token化中完成对齐或映射的),而之所以现在的LLM需要在后边的环节完成RLHF或RLAIF,表明在真实世界中这种人类历史所沉淀的文本符号表征即token的自然序列排列所体现的分布(训练后表现为常识性或领域性浅层表象知识)比某种需alignment方式才能获得的泛化能力的数据分布相比太丰富了,或者说需采用RLHF或RLAIF进行alignment的数据样本太稀缺了。比如生成内容的安全性,系统②的推理模式,复杂的数学推理或自然科学的探索洞察即AI4S。

-

某种意义上来说,两种不同的token构象或分布,在更大的尺度上的目标逼近过程中(比如pre -training或super alignment)其整体目标函数的差异会很大,而这也可能跟LLM的next token predict模式相关,换句话说,将上述两种不同的token序列构象或分布形式化表述为拓扑图结构,即便在大比例token间的短跳是一致的(这里的短跳一致指形式化表示为其中的一种AIF或self play下合成的数据因为采用pre-training模型生成next token predict,在短距离的数据或token分布上不会有太大差异),而如果这种AIF或self play合成的数据样本远小于真实世界样本,那么基于整体数据分布或构象对于整个token分布态会有非常的大差异,因此其在训练过程中所习得的泛化模式也是不相同的,即整体目标差异导致的泛化差异,即 构象/分布不同,目标不同。另外,这种长尺度整体的分布结构可能是由多个小的泛化结构组合,激活,嵌套,放大,抑制而来。

以上,通过回顾AI的发展历史,理清了AI的发展脉络以及每个关键里程碑的意义,通过尝试剖析以ChatGPT为代表的LLMs的技术内涵和思想,发现LLMs当前的局限以判断未来潜在的能力涌现趋势和实现路径,同时隐约间发现以Alpha系列为代表的RL思想在解决专业性领域复杂问题体现出的深层泛化能力的惊艳,并尝试以第一性原理为思维方法,通过一步步对当前LLMs通往AGI可能路径的阻碍、差距等进行探索、分析,我们似乎能够基于本质上的洞察捋清一些内容和思路,并最终在下方进行一些总结和阐释:

本节核心要点归纳与阐释:

-

存在一个大的开放的tokenize的世界。

-

在这个世界中存在着可用token表征的多种模式(pattern)的泛化映射结构或者可以等效于tokenize世界中存在着自然合理的token间映射组织的分布(distribution)或构象(conformation)。

-

★ 这里所说的token间映射的分布或构象在感觉在数学上暂且可结合当前微分拓扑学和数据科学中的数据流形分布或流形嵌入等相关理论来进行抽象表述。因为涉及到一些比较底层的数学抽象概念,且理论的完备性似乎还在途中,这里就不为大家进行详细解释了,相关理论内容大家可以自行搜索作为补充理解,或私下交流探讨 · 这部分相关观点大家也可以参考顾险峰教授关于所创立的跨领域学科「计算共形几何」中相关的理论描述。不过可以稍微延展一点的思路是:是否可以将深度学习中关于数据科学中的数据流形分布概念扩展到认知科学中的认知流形分布呢?其实上面所描述的pattern的概念即是对认知分布的一种表达体现。

如上图所示,一个流形(manifold)代表一个拓扑空间S

DDL中的分类问题涉及的流形探寻轨迹

-

而这种distribution或形式化出的pattern则通过tokenize表征了这个世界的现象和规律。

-

这个规律包含了在人类看来简单似直觉的可通过系统一快速映射的pattern,也囊括了复杂的需通过系统二逐层映射的pattern(但这里需要注意,在现实世界中这种复杂的逐层推理映射也可以强行转化提炼成直觉的单层pattern映射,但猜想这样的pattern在世界中的泛化性分布可能会受到改变和影响)。

-

简单的pattern包括语言的问答交互,交互过程中的直觉反馈,直觉包括简单的结论性先验知识问答,生物的行动条件反射。

-

复杂的pattern包括数学、物理学、生物学的定理证明,科学的pattern(理论)发现,复杂的工程开发,复杂的生物过程和思维过程...等等还有太多太多。

-

因此当前LLMs也好还是RL本质上都是在tokenize的世界中理解这个世界的distribution和探索世界的pattern。

-

需要说明的是:这种pattern是否有限或无限现在无法判断,但从直觉上来感受应该是极大的。

-

因此LLMs在进行pre training时对数据的pattern探索所面临的scaling law相比这个世界上更加广泛的patterns来说感觉并不算什么,因为LLMs这种自回归(AR)的语言模型在尝试通过学习全人类历史数据做pre training时探寻的更多是那些简单的pattern(当然这也并没有说明这些人类所沉淀下来的历史数据都仅仅暗含一些简单pattern,更多原因是取决于next token prediction的自监督模式以及所考虑的高昂的数据标注成本没有将其中所隐含的深刻内涵pattern所挖掘出来),而对于未来的alignment来说则是囊括了更广泛的tokenize世界的探索和对齐,以找到更多的pattern,因此我不知IIya所提及的超级对齐以及杨植麟所认为的alignment的scaling law是不是也在隐含预示着这些,甚至关于Q star很多的传言和猜想(真的很想看到它当前的进展以及底层的训练机制和模式)。

-

而RL似乎提供了额外的一种模拟和数据记录模式,通过self-play和奖励反馈,能够系统性的逐步探寻tokenize世界中隐含的未发掘pattern。

-

当然,这种tokenize世界中的pattern泛化映射,某种程度上来说也是对现实物理世界的一种形式化模拟,在某些复杂领域与数学公式、物理定理,化学方程式如出一辙所体现出的内涵表征如出一辙,甚至是用另一种形式化符号加以表征,因此,我认为,未来的LLMs+RL+...是最终那能够构建起世界模型并通往我们当前所普遍认为的AGI的。

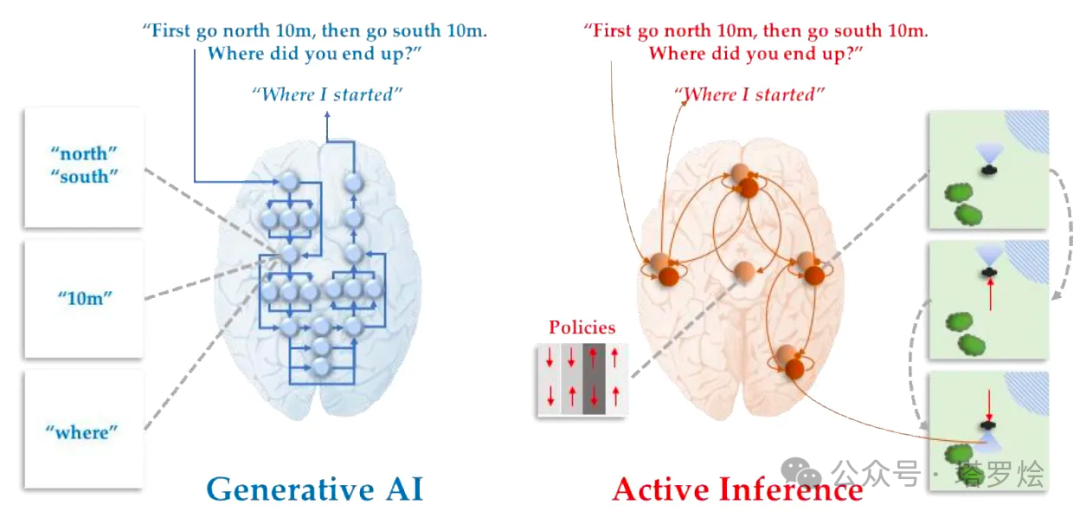

在本小节中,我们尝试针对「RL与LLM融合的本质&阐释」,洞悉了通过将LLM与RL在「任务构建、目标学习以及在进行监督学习过程中对数据样本分布或重构」等方面的一些内涵关联,并尝试性的提出了「RL与LLM融合探寻AGI」的路径可能以及两者间在底层的本质逻辑,但这里我们对AGI的理解和定义可能仍需要持谨慎的对待和持续探索的态度。比如回到LLMs的自回归(AR)生成式(Generated)的这一模式,是否能够达到人类处于不同环境所天然具备的主动思考、主动推理甚至是行动上的条件反射?这种主动性是内化在LLMs当中的还是在其之外的?如果是内化在LLMs之中的,那么如何体现或者建模这种主动性行为?如下是一些延展性思考:

Think:针对主动性/自主性问题,LLM的「自回归(AR)生成式(Generated)的这一模式」在未来是否可采用diffusing的这种方式或采用跨多层transformer去表征模拟主动推理中的“主动”,因为“主动”本身的内涵在某种意义上也是属于推理过程范畴的。如果是可能的,那是否可以通过对主动和推理的表征去模拟人类主动推理这一行为模式?

ps:加上了“主动”是不是就会出现了另一个「系统三·主动思考」?

世界模型的内涵:

提到「世界模型World Models」,我想先跟大家从概念上的澄清。在Sora刚刚发布不久时,除了能够输出高质量的视频之外,OpenAI 更是将 Sora 定义为一个「世界模拟器world simulators」。在这里呢,我往常直觉上理解的「世界模型World Models」与「世界模拟器world simulators」还是有一些区别的,但并没有做对这两者比较深入的思考。

直到Sora的发布,我才聚焦到这两个概念上来。在我当前的理解上,这两者应该是指的同一个概念,均是对「客观真实物理世界做时空映射」,但是,这里所说的映射的内涵和形式方法方面会有差别。

如在内涵上一种是对于客户世界模拟底层的物理定律及原理、化学反应、生物互作甚至是抽象概念;另外一种是针对一些表象特征,比如热效应的火焰、爆炸以及流体力学的水流的形态等,这类模拟通常不会进行对深层次的分子动力学进行模拟,因为微观分子动力学的复杂性可能无法采用当前的模拟技术准确映射和计算,但会取其中,选取其它维度特征进行表象模拟,如形态、趋势等,当然这类模拟在对应物理世界的映射真实性上存在差距。

在形式和方法上,按照不同的模拟复杂性,人们通常也会采取不同的模拟方法,一种是构造物理规律模型 · 力学模型,使用数值计算的方法,求解动力学方程等;另一种会通过类似神经网络的方法通过其中的梯度下降在神经参数中隐式地学习物理规律表征-如Sora。

另外,这里所阐述的两种形式方法其实是对应传统符号主义学派和连接主义学派的不同人工智能行行动路径,同时,也对应到上面模拟世界内涵的两种方式(底层规律/表象特征)。

我们看到前一阵子业界围绕Sora是否是「世界模拟器world simulators」争论很多,包括LeCun、nVDIA高级研究科学家 Jim Fan等顶级科学家以及什么智库总编的相关研究者,甚至不久前人民大学围绕“Sora到底懂不懂物理世界”组织了辩论赛。如大家所见,业界以及学界已经围绕Sora进行了很多探讨或争论,并每方都提出了一些自己的富有洞见的核心见解,相信各位读者小伙伴也都对两方的各自主张以及主张背后下的理论依据有了自行的判断,因此,在这一节当中,我就不再将围绕Sora和世界模型World Models的技术内涵方面进行过多分析和阐述了,还是一样,基于对上述我对「世界模型World Models」的理解,我先抛出我的一些观点和想法,然后在后面摘取一些各位研究者的一些阐述要点加以解释说明,最终还是希望大家能最终回归本质,思考背后底层的逻辑。

我的观点:

「我还是认为Sora经过最终不断的进化迭代,是能够实现最终无限逼近对物理世界的模拟(映射)的,与人类认知世界的方式本质一样。」

依据如下:

首先我们回到本节开始我对「客观真实物理世界做时空映射」上来,在这样的一个认知前提下,我想不管是两种分别对物理世界映射内涵的差异(表征物理规律vs表征表象特征)还是两种对映射形式和方法上的差异(物理模型vs神经网络),背后可能的本质是一致的。

这里大家可能会提出不同的观点:“在之前的观点中你不是说过Sora经过最终不断的进化迭代,是能够实现最终无限逼近对物理世界的模拟的”吗?既然是逼近那就是近似,怎么能严格的说这种“”神经网络通过梯度下降在神经参数中隐式学习物理表征“”与“”基于仿真物理规律真实模拟“”背后的本质是一致的呢?

我的解释是这样的:

首先大前提是我们讨论的范畴都是“模拟”,“模拟”的范畴意味着存在着并不是真实的,因此我认为无限逼近的这种说法与模拟本身不冲突。

另外,大家可以想象一下,基于符号主义的技术实现路径不也是一种模拟吗?也并不是完全在客观真实世界当中复制或克隆出一个对应的实体,即也是在数字世界中或人类内心中(站在人类对物理世界理解看待的视角)模拟(映射)出一个实体或客观snapshot。

同时,这里也有另外一个问题,那就是这种模拟的真实性对于真实物理世界足够完备的吗?在物理规律上随着经典力学收到来自广义相对论和量子场理论的冲击,客观确定性这件事情目前至少在理论层面是存疑的,我们物理学在当前还未触达终极最终理论前,我想不管是曾经的经典力学、还是现在的量子场论这些理论,本质都是通过数学符号化+形式化表达来完成对客观物理世界刻画的,即便是经典力学领域,也有无法表征并解决的诸多计算复杂性问题,如“流体动力学”求解析解,甚至在这一领域近期很多研究人员在尝试使用数据驱动的方式如数值方法或近似解法如机器学习来求解热动力学方程。

即便在不久的将来我们探寻到了最终理论,并能够通过优雅的数学形式对客观真实世界进行精准表达与刻画,但其仍是概念世界中的数学形式而非客观存在实体,即是模拟或映射。

因此现在的问题是,现在“通过梯度下降在神经参数中隐式学习物理表征”与“基于仿真物理规律真实模拟”两者间哪个最能逼近对真实世界模拟了。

回到关于两者间的本质问题,对于通过数学形式抽象出概念进行物理规律的仿真模拟底层本质上即是计算,只不过计算的初始是基于给定的一套先验的定理或计算公式(如重力学方程或流体动力学方程),将变量(如流体的状态量)引入完成计算,在计算过程中会涉及复杂的数学方法和形式变换;同样,经过梯度下降并在神经网络隐藏参数中完成了对物理现象的表征后,再进行模型推理时,仍是某种形式的计算(通过训练过程中去优化模型的函数即找寻更好的能拟合数据的规律),区别是计算的方式不同以及初始表征变量的不同。当然这里仍然有一个问题尚待解决,就是:这两种计算模式本质上是否存在着不同?

为了解决上述遗留的问题,我想从另外一个看起来不是很严谨的角度尝试为大家做一下阐释:

对于上述两种形式模拟的本质,首先我们先看基于符号抽象化的这种对依赖人类理性认识总结归纳出的物理规律进行公式化或定理化推理计算模拟过程,大家可以想象一下,这些人类理性认知的物理规律也是通过人类在历史的长河中不断对现实世界的观察实践,甚至是主动反复试验后总结归纳出的抽象概念或模式,那么谁又晓得在这个过程中人类大脑的神经元是做了怎样的事情呢?从脑神经科学上来看,目前也是基于电信号对神经元的刺激形成了模式激活而形成的对客观世界的映射反馈,我想这至少与连接学派为代表的神经感知网络看起来更加类似吧,而并不是上帝在人类出生时就将一个物理公式植入到大脑当中等着人类未来自己去寻找和发现。

所以我认为,某种程度上,另一种基于神经网络数学计算逼近的模拟过程,在其神经网络隐层中(如Sora通过patches表征即在网络隐层进行某种目标导向的数学变换)本质上亦会抽象表征出客观物理规律、公式和某种未知的模式,甚至是人类未知的某些复杂的偏微分方程,再依据这些隐性表征进行前向传播即模拟推理(这里与通过符号规则化对物理规律仿真模拟等效),只不过当前人类无法按照自身的认知模式(或者是自身认知的局限性所导致)理解和解释隐层中各个神经网络参数的内涵,但我想对于模型来说(如sora)如果肯做,也一定能按照人类所能理解的认知模式将抽象的公式、定理等向人类呈现出来。

这里通过一个思想实验,尝试向大家假设了Sora中间隐层计算的过程,我相信通过一定的目标函数设定,是能够以某种形式将中间结果即所谓人类理性的物理概念、规律等通过看似优雅的数学公式作为结果输出生成的,只不过当前Sora的架构是E2E端到端的

通过上述表述,我想大家是否能够多少理解为什么我在上面说的两者模拟方法在本质上是一致的表述呢?

另外,我想也进一步向大家阐明,Sora至少在其对世界模拟采取的方法上可以算是真实世界物理模拟器,只不过还需在scaling law之下,借助更多的算力对更大体量的真实数据不断观察训练取得进一步突破并有可能最终呈现出在人类还未理解底层物理规律的情况之前突然向人类展示出让人类意想不到的世界真实表象,比如时间倒退回到上世纪初,Sora也许能够在爱因斯坦发表广义相对论前,就已经向人类直接呈现出水星轨道近日点进动的精确描述了。

「站在巨人的肩膀上」当然这里我想再与大家分享一些截取引用相关研究者们关于围绕Sora探讨的一些主题发生和见解供大家回顾思考:

文章部分内容引用机器之心整理报道

关于模拟假设:

Sora 发布后,AI 领域的知名学者纷纷发表对模拟假设的看法。其中英伟达高级研究科学家 Jim Fan 将 Sora 描述为「数据驱动的物理引擎」,他的解释为 Sora 通过大量视频的梯度下降在神经参数中隐式地学习物理引擎。Sora 是一个可学习的模拟器或「世界模型」。

每个人都同意 Sora 是一个令人印象深刻的模型。但除了生成逼真视频之外,Sora 还有更深层的属性吗?OpenAI 团队似乎这样认为,他们在技术报告中称,Sora 获得了规模化的「模拟能力」,并通过动态相机运动、遮挡、物体存继性和视频游戏模拟来实现场景一致性。

OpenAI 得出结论,这些功能表明了,视频模型的继续扩展是开发物理和数字世界,以及生活在其中的物体、动物和人的高性能模拟器的一条有希望的路径。

我们可以将这一说法称为模拟假设,但该假设的问题在于它太模糊了。对于视频生成模型而言,模拟物理世界实际意味着什么?哪些证据可以支持这一说法?让我们一一来解答。

Sora 必须学习一些隐式的文本到 3D、3D 转换、光线追踪渲染和物理规则,以便尽可能准确地对视频像素进行建模。Sora 还必须学习游戏引擎的概念才能满足目标。

物理引擎术语有些令人困惑,尤其考虑到 Sora 可能是在虚拟引擎 5 的场景中接受训练的。我们首先需要澄清一点,即没有人(包括 Jim Fan)认真地暗示 Sora 在推理时确实有一个循环的物理引擎。换句话说,Sora 不会利用虚拟引擎的函数调用来生成视频。

这不仅仅因为我们完全不清楚它是如何工作的(资产、动画从哪里来),还因为 Sora 是一个 DiT 模型,而这些根本不是 DiT 的工作方式。

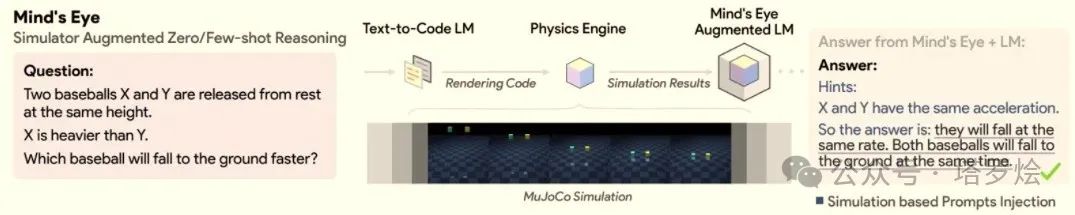

这里需要提一下,让神经网络调用物理引擎是以前尝试过的事情,但不是为了视频生成,而是为了物理推理。

另外,此前,Ruibo Liu 等人(谷歌大脑团队、达特茅斯学院)在 2023 年发表的一篇论文《Mind's Eye: Grounded Language Model Reasoning through Simulation》中增强了一种语言模型,通过使用物理引擎(DeepMind 的 MuJoCo)模拟可能的结果,来提高在物理推理问题上的性能,并使用这些模拟的结果作为 prompt 中的提示。

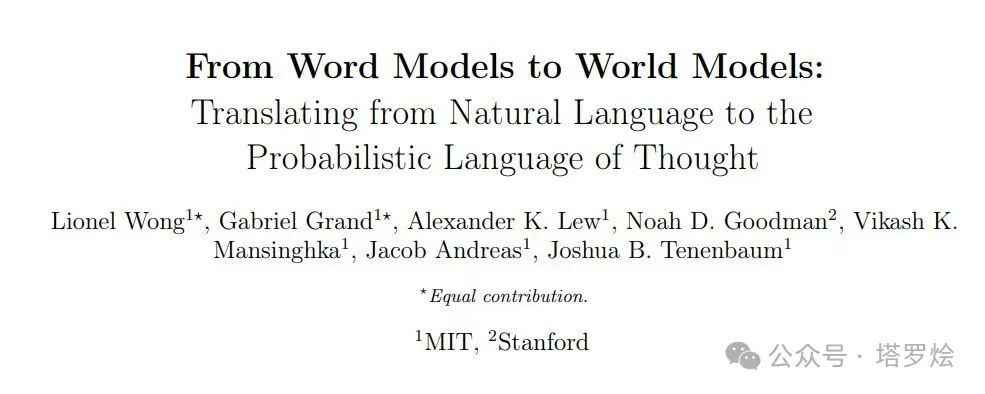

此外,MIT 的 Josh Tenenbaum 实验室对这一工作进行了探索,使用语言模型将自然语言查询转换成概率编程语言中的代码表达式。为了能够对语言中描述的物理现象进行推理,Lionel Wong 及其同事将一个物理模拟引擎集成到了这个框架中。

他们在概率生成程序中添加了一个 Simulate_physicals 函数,该函数采用指定对象属性(如位置和速度)的初始符号场景状态,并返回场景属性,这些属性在物理、建模运动和碰撞情况的基础上随时间更新。此外通过将物理模拟添加为函数调用,语言描述可以转换为查询,并对描述的物理情况如何随时间推移发挥作用进行推理。

这显然与 Sora 的做法相差甚远,Sora 是一个端到端的神经网络,而不是一个神经符号系统。那么,我们该如何理解 Sora 类似于模拟物理世界的「数据驱动的物理引擎」这一说法,来自谷歌 DeepMind 的高级 AI 总监 Nando de Freitas 表示,有限大小的神经网络在任何情况下可以预测接下来会发生什么的唯一方法是:学习促进此类预测的内部模型,包括直观的物理定律。

看来我们越来越接近模拟假设的明确定义了:在拥有有限参数集的端到端神经网络架构之上的足够好的视频生成模型,在训练中应该能够获得物理世界的内部模型。这是这类神经网络生成任意场景中的一致和逼真视频的最有效方法,也可能是唯一方法。

那么,Sora 是否真的从 2D 视频中归纳出物理定律呢?如前所述,这看起来可能就很荒谬。比如 Sora 会以某种方式获得热力学定律的内部模型,这似乎令人难以置信。游戏引擎通常也不模拟这些法则, 它们可能会模拟热效应(火灾、爆炸)和功(如物体克服摩擦移动),但这些模拟通常是高度抽象的,并不严格遵守热力学方程。并且游戏引擎也根本不需要这样做,它们的重点是渲染场景的视觉和交互可信度,而不是严格的物理准确性。

那么,Sora 是否真的从 2D 视频中归纳出物理定律呢?如前所述,这看起来可能就很荒谬。比如 Sora 会以某种方式获得热力学定律的内部模型,这似乎令人难以置信。游戏引擎通常也不模拟这些法则, 它们可能会模拟热效应(火灾、爆炸)和功(如物体克服摩擦移动),但这些模拟通常是高度抽象的,并不严格遵守热力学方程。并且游戏引擎也根本不需要这样做,它们的重点是渲染场景的视觉和交互可信度,而不是严格的物理准确性。

Sora 会做类似的事情吗?在回答这个问题之前,我们需要谈一谈直观物理学。

直观物理学:

什么是直观物理学呢?对于人类而言,不仅仅是受过训练的物理学家,还包括外行甚至是婴儿,这些人都对物理世界有直观的理解。这就是认知科学家称为直观物理学的东西:一种快速、自动的日常推理,让人们知道各种物体相互作用时会发生什么,不需要有意识地思考物理计算。

研究表明,婴儿已经对物理世界的各个方面产生了稳定预期认知,包括物体持久性(即使看不见也知道物体的存在)、坚固性(物体不会相互洞穿)以及内聚力(物体是一起移动的连接整体)。即使在很小的时候,婴儿似乎也期待物体遵守某些物理原则,并将这些期望推广到新的物体,而不是必须单独学习每个特定物体的独特性。这是我们与生俱来的「核心知识」的一部分,而不是发展过程中学到的东西。

总之,人类很小的时候就非常善于理解物理世界及规则,无论与生俱来、还是后天习得,或者二者兼而有之。

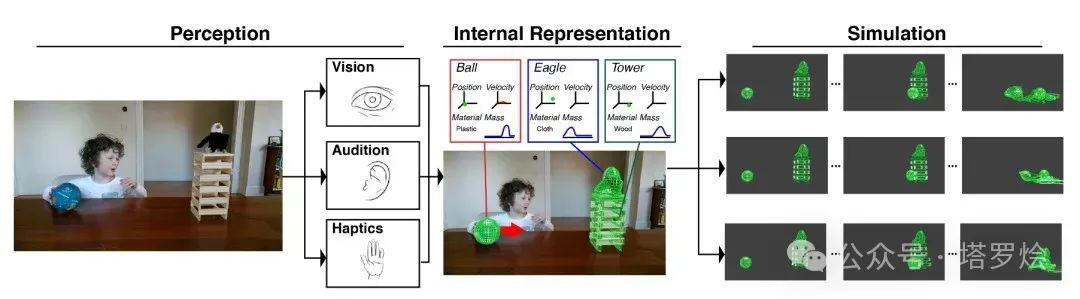

如何做到的呢?认知科学中有一个重要假设:人们使用直观物理引擎(intuitive physics engine,IPE)在心理上模拟物理事件。该引擎近似现实中的物理动力学,并类似于计算机游戏中的物理引擎。

当我们观察物理场景时,可以根据嘈杂的感知证据来构建对物体、属性和作用力的心理表征,然后运行内部模拟来预测接下来发生什么。

更准确的说,IPE 是一种生成因果模型,通过对不精确但大致准确的物理原理的随机模拟,将不可观测的物理变量和不确定性映射成可观测的物理现象。IPE 表示物理场景中物体的潜在物理变量(如质量、摩擦力、弹性)。这些变量不能直接观察到,但控制了物体在场景中的行为方式。

这里只关注对 IPE 假说的一个反对意见,它与视频生成模型的争论尤其相关。一些研究人员认为,人们对物理场景的判断有时仅取决于表面的视觉特征,而不是底层的物理特征。比如仅在静态图像上训练的 ResNet-50 等深度神经网络可以判断积木塔的稳定性,其表现可与成年人媲美。此外,人们被发现依赖积木塔的外观,而不是摩擦等物理约束,儿童则完全忽视形状。

IPE 假说支持者的普遍反应是,依赖启发式的证据可以简单地解释为限制 IPE 模拟的边界条件和机制。没有任何模型会声称自己可以无限制地使用物理模拟来处理所有抽象推理,近似是不可避免的。

因此我认为底线是:至少对于人类而言,人们很容易通过假设 IPE 的存在来解释直观的物理推理,而该 IPE 使用近似原理对物理场景进行概率心理模拟。这一假设仍然存在争议,并且有支持和反对的证据。但是,模拟假设至少有一个相对合理且经过深思熟虑的案例,还有丰富的实验文献支持。有了这些背景,接下来我们谈谈世界模型。

世界模型:

「世界模型」一词是技术术语之一,其含义已被逐渐淡化,以致在实践中变得难以描述。

2018 年,Ha David、Schmidhuber Jürgen 合作撰写了一篇名为《World Models》的论文,在这篇文章中,世界模型包含一个感知组件,用于处理原始观察并将其压缩为紧凑编码。

Ha 和 Schmidhuber 关于世界模型的研究影响了后来许多作品。

我们以最近的研究来举例,几天前,Google DeepMind 推出了参数为 110 亿的基础世界模型 Genie,可以通过单张图像提示生成可玩的交互式环境。在如下动图中,谷歌先使用 Imagen2 生成图像,再使用 Genie 将它们变为动态方式。

另一位推崇世界模型的是 Yann LeCun,曾经提出了一种名为 JEPA(联合嵌入预测架构)的框架,在这一框架下,世界模型是一个内部预测模型,描述世界如何运作:

除此以外,在 Sora 模型发布的当天,Meta 推出了一个全新的无监督「视频预测模型」——V-JEPA,与 JEPA 一脉相承。

V-JEPA 和 Sora 之间的主要区别之一是它们各自的学习目标,以及这些目标可能对其潜在表示产生的下游影响。Sora 接受了像素空间中帧重建的训练,而 V-JEPA 接受了潜在空间中特征预测的训练。在 LeCun 看来,像素级生成目标不足以引发对世界中的规划和行动有用的抽象表示。

综合来看,人们对世界模型的理解略有不同。在强化学习(RL)中,世界模型主要关注以智能体为中心的预测,以及基于智能体行为对环境状态的模拟。在 Yann LeCun 对自主机器智能的构想中,世界模型同样关注以智能体为中心的预测,不过这里的预测是通过自监督在潜在空间中学习得到的。无论是生成模型、RL 模型还是 JEPA 模型,它们都没有达到因果推理文献中对世界模型强大因果概念的高标准。至于像 Sora 这样的视频生成模型,我们可以通过观察图像生成模型来寻找线索。

再看Sora:

与用于图像生成的潜在扩散模型一样,Sora 是根据视觉输入进行端到端训练的。训练和生成都不是明确地以物理变量为条件的。Sora 从根本上不同于使用物理引擎来运行模拟的复合模型。此外,Sora 在感知、预测和决策模块之间没有内置分离。

除此以外,Sora 与 Ha & Schmidhuber 的世界模型也有很大不同,它不会基于离散行为、观察和奖励信号的历史来运行模拟。在这方面,OpenAI 的技术报告在讨论通过提示生成视频示例时提到了《我的世界》(Minecraft),这有点误导。

Sora 可能模拟了离线强化学习中的智能体策略,但与 Genie 不同,Sora 没有接受过从视频中诱发潜在动作的训练,并且输出也不以此类动作为条件。

然而,我们不能排除这样一个假设,Sora 是一个世界模拟器 —— 或者,稍微不那么夸张,在较弱意义上,它是一个世界模型。

然而这种观点受到了包括 LeCun、Gary Marcus 等在内的多位 AI 大佬的反对,这些批评者指出,Sora 生成的视频中公然违反了物理原理。不过 OpenAI 承认了这些局限,并提供了一些失败示例。例如,在下面示例中,人们可以看到明显的时空不一致,包括生成的视频违反重力、碰撞动力学、坚固性和物体持久性。

事实上,Sora 输出的结果很明显会在直观物理上出错。如果非要说 Sora 是一个较弱意义上的世界模型,那么它肯定不是一个完美的模型,甚至在各个方面都不完整。

与用于生成图像的潜在扩散模型一样,Sora 生成视频的过程并不发生在像素空间中,而是发生在潜在空间中 —— 时空 patch 潜在表示被编码的空间。

这一信息很重要,因为很多研究者认为 Sora 只是学习在逐帧像素变化中插入常见模式。Sora 架构中编码器和解码器之间发生的所有事情都发生在潜在空间中。对于 Sora 来说,直观物理相关的属性的潜在表示对于早期的生成过程(甚至在早期的扩散时间步长)具有因果效力,这并非难以置信。

「中篇」的回顾与总结:

-

以上在本篇中我们通过剖析LLMs,World Models,RL等模型和思想分别在「系统一 · 快思考与系统二 · 慢思考」、「RL与LLM融合的本质&阐释」以及「世界模型的内涵」等方向尝试以回顾第一性原理的思考方法探寻围绕在这些主题背后的本质问题,尝试阐释我们所生活的这个真实世界中所呈现,模拟,还原拼接的各种形式的pattern,包括系统一、系统二中的直觉与推理pattern,RL中的AI4S的过程pattern,World Models/Sora中的物理世界模拟的pattern,因为篇幅过于冗长,为了能像大家表达作者的核心观点,并作出如下更核心一点的观点总结和提炼:

-

LLM所拼接的是人类交互、反应、判别,大部分系统一思维决策的pattern。

-

World Models或Sora所拼接的是真实世界直管物理现象的pattern,当然由于其在拼接过程中涉及了更广泛的物理现象的囊括,因此在未来随着模型不断的进化迭代其隐层必然在无限逼近对底层世界规律的模拟。

-

而LLMs+RL+…这种模型结构或未来的某种具身智能中的E2E模型在不断与真实世界环境持续交互、迭代、进化的过程中通过更多样化的目标反馈和结构表征,使得其能够形成逐渐无限的拼接世间万物的pattern,当然类人或某种智能体的主动行为和意识在这种持续的拼接过程中也将最终涌现。

大家也可以访问作者知乎:融合RL与LLM思想,探寻世界模型以迈向AGI「中·下篇」 - 知乎 (zhihu.com)以及

微信公众号「塔罗烩」融合RL与LLM思想,探寻世界模型以迈向AGI「中·下篇」 (qq.com)

进一步了解详细内容,感谢大家,欢迎讨论!

722

722

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?