关于L0、L1和L2范数

所有的范数都可以用闵可夫斯基距离(也叫

L

−

P

L-P

L−P 范数)公式求得,闵可夫斯基距离公式:

L

p

=

(

∑

1

n

x

i

p

)

1

p

,

x

⃗

=

(

x

1

,

x

2

,

.

.

.

.

,

x

n

)

L_p =(\sum_{1}^{n} x_i^p)^\frac{1}{p}, \vec x=(x_1,x_2, ....,x_n)

Lp=(1∑nxip)p1,x=(x1,x2,....,xn)

L0 范数( ∣ ∣ x ⃗ ∣ ∣ 0 ||\vec x||_0 ∣∣x∣∣0)按照闵可夫斯基公式可知会带开0次方,但是开0次方无法计算,所以一般L0范数就是指一个向量 a ⃗ \vec a a 中非 0 0 0 元素的个数。L0范数很难优化求解.L1范数( ∣ ∣ x ⃗ ∣ ∣ 1 ||\vec x|| _1 ∣∣x∣∣1)指向量中各个元素绝对值之和.

L 1 = ( ∑ 1 n ∣ x i ∣ ) , x ⃗ = ( x 1 , x 2 , . . . . , x n ) L_1 =(\sum_{1}^{n} |x_i|), \vec x=(x_1,x_2, ....,x_n) L1=(1∑n∣xi∣),x=(x1,x2,....,xn)L2范数( ∣ ∣ x ⃗ ∣ ∣ 2 ||\vec x|| _2 ∣∣x∣∣2)指向量各元素的平方和然后求平方根.

L 2 = ( ∑ 1 n x i 2 ) , x ⃗ = ( x 1 , x 2 , . . . . , x n ) L_2 =\sqrt {(\sum_{1}^{n} x_i^2)}, \vec x=(x_1,x_2, ....,x_n) L2=(1∑nxi2),x=(x1,x2,....,xn)

名字带L2 的一些名词解释

-

L 2 L2 L2损失函数,也叫L2 Loss,也被称为最小平方误差(LSE):

L = ∑ i = 1 n ( y i − f ( x i ) ) 2 L = \sum_{i=1}^{n} (y_i - f(x_i))^2 L=i=1∑n(yi−f(xi))2

它是把目标值 y i y_i yi与估计值 f ( x i ) f(x_i) f(xi)的差值的平方和最小化,和L2范数相比不需要开平方。一般回归问题会使用此损失. -

岭回归(Ridge Regression)和 L 2 L2 L2的关系

岭回归

岭回归并不是使用了 L 2 L2 L2损失函数的回归,而是在损失函数后面加了 L 2 L2 L2正则项。一般来说,回归的表达形式是:

y ^ = ∑ j = 1 n w j x j + b \hat y=\sum_{j=1}^{n} w_j x_j + b y^=∑j=1nwjxj+b

一般情况下,使用最小二乘法求解上述回归问题的目标是最小化如下的式子:

w = a r g m i n w ∑ i = 1 n ( y i − y ^ ) 2 w=argmin_w \sum_{i=1}^{n}(y_i-\hat y)^2 w=argminwi=1∑n(yi−y^)2

那么,岭回归就是要在上述最小化目标中加上一个惩罚项:

w r i d g e = a r g m i n w ∑ i = 1 n ( y i − y ^ ) 2 + λ ∑ j = 1 n β j 2 w^{ridge}=argmin_w \sum_{i=1}^{n}(y_i-\hat y)^2+\lambda \sum_{j=1}^{n}\beta_j^2 wridge=argminwi=1∑n(yi−y^)2+λj=1∑nβj2

或者表示成范数的形式:

w r i d g e = a r g m i n w ∑ i = 1 n ( y i − y ^ ) 2 + λ ∣ ∣ β j ∣ ∣ 2 w^{ridge}=argmin_w \sum_{i=1}^{n}(y_i-\hat y)^2+\lambda ||\beta_j||^2 wridge=argminwi=1∑n(yi−y^)2+λ∣∣βj∣∣2

这里的 λ \lambda λ也是待求参数。也就是说,岭回归是带L2范数惩罚的最小二乘回归. -

L 2 L2 L2正则化(就是权重衰减)

搞懂L2正则化

l2范数求导_L1和L2 详解

一般来说,监督学习可以看作最小化下面的损失函数:

1 N ∑ i = 1 N L ( y i , f ( x i ) ) \frac{1}{N} \sum_{i=1}^{N}L(y_i, f(x_i)) N1i=1∑NL(yi,f(xi))

L 2 L2 L2正则就是在损失函数后面加一个 L 2 L2 L2正则化项来最小化模型的结构损失。

1 N ∑ i = 1 N L ( y i , f ( x i ) ) + λ ∣ ∣ w ∣ ∣ 2 \frac{1}{N} \sum_{i=1}^{N}L(y_i, f(x_i)) + \lambda||w||^2 N1i=1∑NL(yi,f(xi))+λ∣∣w∣∣2,其中 λ \lambda λ就是权重衰减系数

注意:L2正则化是加上参数向量的平方和,不完全等价L2范数 -

权重衰减

权重衰减,学习率衰减

L2正则化的目的就是为了让权重衰减到更小的值,在一定程度上减少模型过拟合的问题,所以权重衰减也叫L2正则化。 -

欧式距离

欧式距离衡量的是多维空间中两个点(每个点都是一个向量表达的)之间的绝对距离。也可以理解为:m 维空间中两个点之间的真实距离,或者向量的自然长度(即该点到原点的距离)。在二维和三维空间中的欧氏距离就是两点之间的实际距离。具体的计算公式如下:

d i s t ( X , Y ) = ∑ i = 1 n ( x i − y i ) 2 dist(X, Y)=\sqrt{\sum_{i=1}^{n}(x_i - y_i)^2} dist(X,Y)=i=1∑n(xi−yi)2

注意:欧式距离的计算类似于L2范数的计算,都需要开根号 -

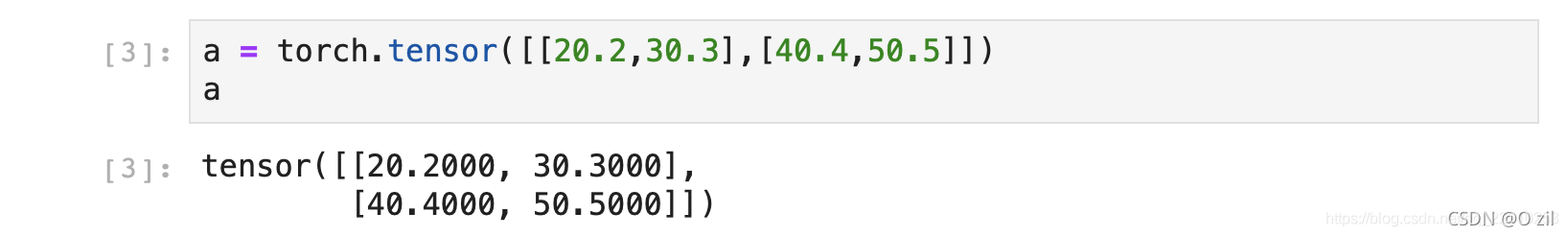

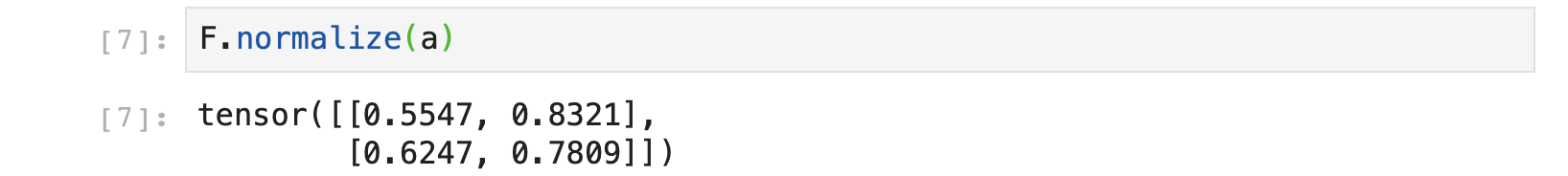

L2-Norm,也叫L2归一化, 将一组数变成 0-1之间, pytorch调用的函数是F.normalize,也就是矩阵的每个数与他所在的行向量的L2范数的比值。

参考:L2-norm

L1和L2的正则化特性

参考: L1,L2正则化

正则化的作用

正则化的主要作用是防止过拟合,对模型添加正则化项可以限制模型的复杂度,使得模型在复杂度和性能达到平衡。

常用的正则化方法有L1正则化和L2正则化。L1正则化和L2正则化可以看做是损失函数的惩罚项。所谓『惩罚』是指对损失函数中的某些参数做一些限制。 L1正则化的模型建叫做Lasso回归,使用L2正则化的模型叫做Ridge回归。

1、L1范数和L2范数为什么可以避免过拟合?

加入正则化项就是在原来目标函数的基础上加入了约束。当目标函数的等高线和 L1, L2 范数函数第一次相交时,得到最优解。

L1范数:L1范数符合拉普拉斯分布,是不完全可微的。表现在图像上会有很多角出现。这些角和目标函数的接触机会远大于其他部分。就会造成最优值出现在坐标轴上,因此就会导致某一维的权重为0 ,产生稀疏权重矩阵,进而防止过拟合。

L2范数:L2范数符合高斯分布,是完全可微的。和L1相比,图像上的棱角被圆滑了很多。一般最优值不会在坐标轴上出现。在最小化正则项时,可以是参数不断趋向于0,最后获得很小的参数。

2、L1 和 L2 正则化

L1正则化表达式如下:

w

l

a

s

s

o

=

a

r

g

m

i

n

w

∑

i

=

1

n

(

y

i

−

y

^

)

2

+

λ

∣

∣

β

j

→

∣

∣

1

w^{lasso}=argmin_w \sum_{i=1}^{n}(y_i-\hat y)^2+\lambda ||\overrightarrow{\beta_j}||_1

wlasso=argminwi=1∑n(yi−y^)2+λ∣∣βj∣∣1

其中,

λ

∣

∣

β

j

→

∣

∣

1

\lambda ||\overrightarrow{\beta_j}||_1

λ∣∣βj∣∣1为 L1 正则化项, L1正则化是指权值向量

β

j

→

\overrightarrow{\beta_j}

βj 中各个元素的绝对值之和。

L2正则化项表达式如下:

w

r

i

d

g

e

=

a

r

g

m

i

n

w

∑

i

=

1

n

(

y

i

−

y

^

)

2

+

λ

∣

∣

β

j

∣

∣

2

2

w^{ridge}=argmin_w \sum_{i=1}^{n}(y_i-\hat y)^2+\lambda ||\beta_j||_2^2

wridge=argminwi=1∑n(yi−y^)2+λ∣∣βj∣∣22

λ ∣ ∣ β j ∣ ∣ 2 2 \lambda ||\beta_j||_2^2 λ∣∣βj∣∣22 为L2正则化项,L2正则化是指权值向量w 中各个元素的平方和(然后再求平方根)。

3、L1 和 L2 正则化原理

模型的学习优化的目标是最小化损失函数,学习的结果是模型参数。在原始目标函数的基础上添加正则化相当于在参数原始的解空间添加了额外的约束空间, L1 正则就是加了 L1 约束, L2正则就是加了 L2约束。

上面的图,左面是 L2 约束下解空间的图像,右面是 L1约束下解空间的图像。

蓝色的圆圈表示损失函数的等值线。同一个圆上的损失函数值相等的,圆的半径越大表示损失值越大,由外到内,损失函数值越来越小,中间最小。 如果没有L1和L2正则化约束的话,w1 和 w2 是可以任意取值的,损失函数可以优化到绿色同心圆中心的最小值的,此时中心对应的 w1 和 w2 的取值就是模型最终求得的参数。但是填了L1和L2正则化约束就把解空间约束在了黄色的平面内。黄色图像的边缘与损失函数等值线的交点,便是满足约束条件的损失函数最小化的模型的参数的解。 由于L1正则化约束的解空间是一个菱形,所以等值线与菱形端点相交的概率比与线的中间相交的概率要大很多,端点在坐标轴上,一些参数的取值便为0。L2正则化约束的解空间是圆形,所以等值线与圆的任何部分相交的概率都是一样的,所以也就不会产生稀疏的参数。

4、正则化参数

λ

\lambda

λ

对L2正则来说,它也叫权重衰减,所以正则化参数也叫权重衰减参数。

2681

2681

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?