第一章 绪论

1.1 引言

机器学习研究的主要内容:关于在计算机上从数据中产生“模型”的算法,即“学习算法”。

“模型”泛指从数据中学到的结果。

1.2 基本术语

- 数据集,作为数据记录的集合,其中每一条是关于一个事件或对象的描述(即示例);

- 属性(特征),反映事件或对象在某方面的表现或性质的事项;

- 属性值,属性上的取值;

- 属性空间(样本空间、输入空间):属性张成的空间;

- 特征向量,空间中的每一个实例。

表示含有

个示例的数据集,每个示例由

个属性描述,

称为“维数”。

从数据中学得模型的过程称为"学习"或"训练", 这个过程通过执行某个学习算法来完成。训练过程中使用的数据称为"训练数据",其中每个样本称为一个“训练样本", 训练样本组成的集合称为"训练集"。

- 当预测对象为离散值,称为“分类”任务;当预测对象为连续值,称为“回归”任务;

- 将数据集中的数据分成若干组,每组称为一个“簇”,即聚类任务。

- 监督学习 —— 分类与回归的代表

- 无监督学习 —— 聚类的代表

泛化能力 :学得模型适用于新样本的能力,称为"泛化" (generalization) 能力。

1.3 假设空间

归纳

从特殊到一般的"泛化"过程,即从具体的事实归结出一般性规律,例如,从已有的样例中学习;

演绎

从一般到特殊的"特化"过程,即从基础原理推演出具体状况,例如,公理和推理规则的推导。

1.4 归纳偏好

机器学习算法在学习过程中对某种类型假设的偏好,称为“归纳偏好”或简称为“偏好”;

“奥卡姆剃刀”(Occam’s razor)是一种常用的、自然科学研究中最基本的原则,即"若有多个假设与观察一致,则选最简单的那个”。

第二章 模型评估与选择

2.1 经验误差与过拟合

- 错误率,分类错误的样本数占样本总数的比例;

- 误差,学习器的实际预测输出与样本的真实输出之间的差异称;

- “训练误差"或"经验误差”,学习器在训练集上的误差;

- 泛化误差,在新样本上的误差。

- 过拟合,由于学习能力过于强大,以至于把训练样本所包含的不太一般的特性都学到了;(机器学习面临的关键障碍,无法彻底避免,只能缓解)

- 欠拟合,由于学习能力低下而造成的。

2.2 评估方法

测试集应尽可能与训练集互斥,即测试样本尽量不在训练集中出现,为在训练过程中使用过。

2.2.1 留出法

留出法(hold-out)直接将数据集D划分为两个互斥的集合,其中一个集合作为训练集S,另一个作为测试集T,即D= SUT, S∩T= ∅ .在S上训练出模型后,用T来评估其测试误差,作为对泛化误差的估计。

常见做法:将大约2/3 ~ 4/5的样本用于训练,剩余样本用于测试

注意:

- 训练/测试集的划分要尽可能保持数据分布的一致性,避免因数据划分过程引入额外的偏差而对最终结果产生影响;

- 在给定训练/测试集的样本比例后,仍存在多种划分方式对初始数据集D进行分割.

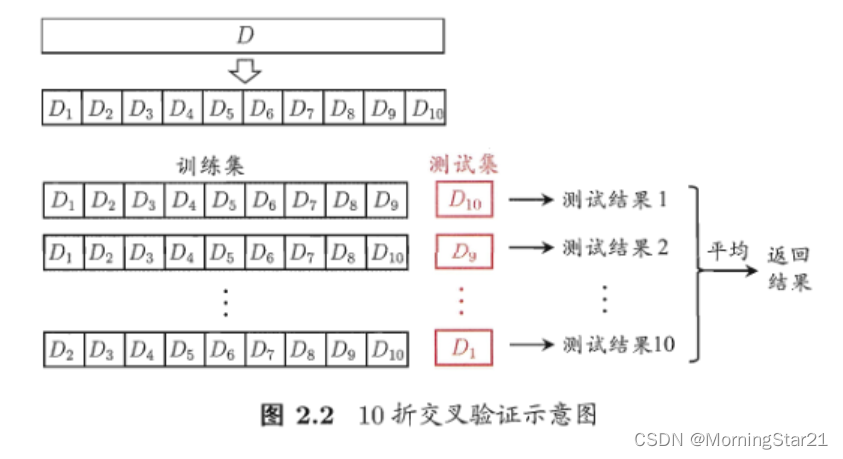

2.2.2 交叉验证法

“交叉验证法”先将数据集D划分为k个大小相似的互斥子集。每个子集Di都尽可能保持数据分布的一致性,即从D中通过分层采样得到。然后,每次用k-1个子集的并集作为训练集,余下的那个子集作为测试集;这样就可获得k组训练/测试集,从而可进行k次训练和测试。

通常把交叉验证法称为“k折交叉验证”。k最常用的取值是10,此时称为10折交叉验证;其他常用的k值有5、20等。

2.2.3 自助法

“自助法”以自助采样法为基础. 给定包含m个样本的数据集D,我们对它进行采样产生数据集D:每次随机从D中挑选一个样本,将其拷贝放入D’,然后再将该样本放回初始数据集D中,使得该样本下次采样时仍有可能被采到;这个过程重复执行m次后,我们就得到了包含m个样本的数据集D’,这就是自助采样的结果。

注意:

- 自助法在数据集较小、难以有效划分训练/测试集时很有用;此外,自助法能从初始数据集中产生多个不同的训练集,这对集成学习等方法有很大的好处.

- 自助法产生的数据集改变了初始数据集的分布,这会引入估计偏差.因此,在初始数据量足够时,留出法和交叉验证法更常用一些.

2.2.4 调参与最终模型

大多数学习算法都有些参数需要设定,参数配置不同,学得模型的性能往往有显著差别,因此,在进行模型评估与选择时,除了要对适用学习算法进行选择,还需对算法参数进行设定,这就是通常所说的“参数调节”或简称“调参”.

2.3 性能度量

2.3.1 错误率与精度

错误率是分类错误的样本数占样本总数的比例;

精度则是分类正确的样本数占样本总数的比例.

2.3.2 查准率、查全率与F1

对于二分类问题,可将样例根据其真实类别与学习器预测类别的组合划分为真正例TP、 假正例FP、 真反例TN、假反例FN四种情形,则显然有TP+ FP+TN+ FN =1样例总数。分类结果的“混淆矩阵”(confusion matrix).

注意:

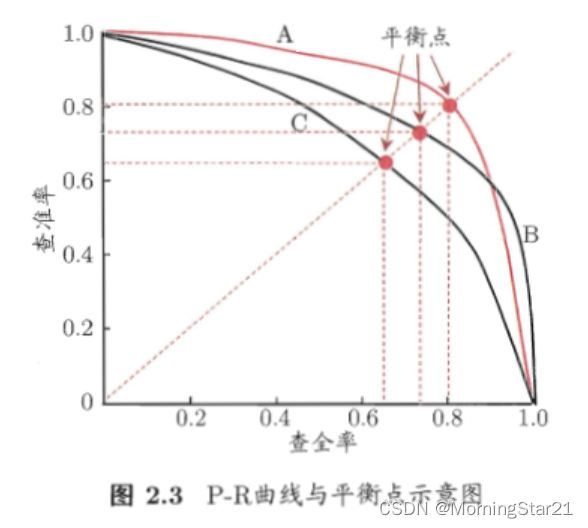

查准率和查全率是一对矛盾的度量.一般来说,查准率高时,查全率往往偏低;而查全率高时,查准率往往偏低.

综合考虑查准率、查全率的性能度量

在下图中,A将C的P-R曲线完全“包住”,表示A比C性能好。对于A与B,比较合理的判据是比较P-R曲线面积大小。此外,人们设计了“平衡点”作为度量。

“平衡点”(Break-Event Point,简称BEP),它是"查准率=查全率"时的取值.

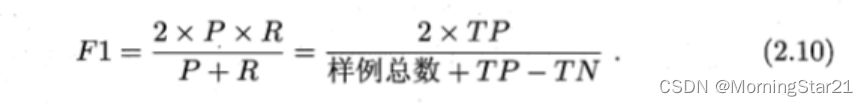

但平衡点BEP还是过于简化了些,更常用的是F1度量:

F1度量的一般形式–Fß’能让我们表达出对查准率/查全率的不同偏好,它定义为

其中 ß >O 度量了查全率对查准率的相对重要性. ß = 1 时退化为标准的F1; ß > 1时查全率有更大影响;ß < 1时查准率有更大影响.

633

633

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?