文章目录

前言

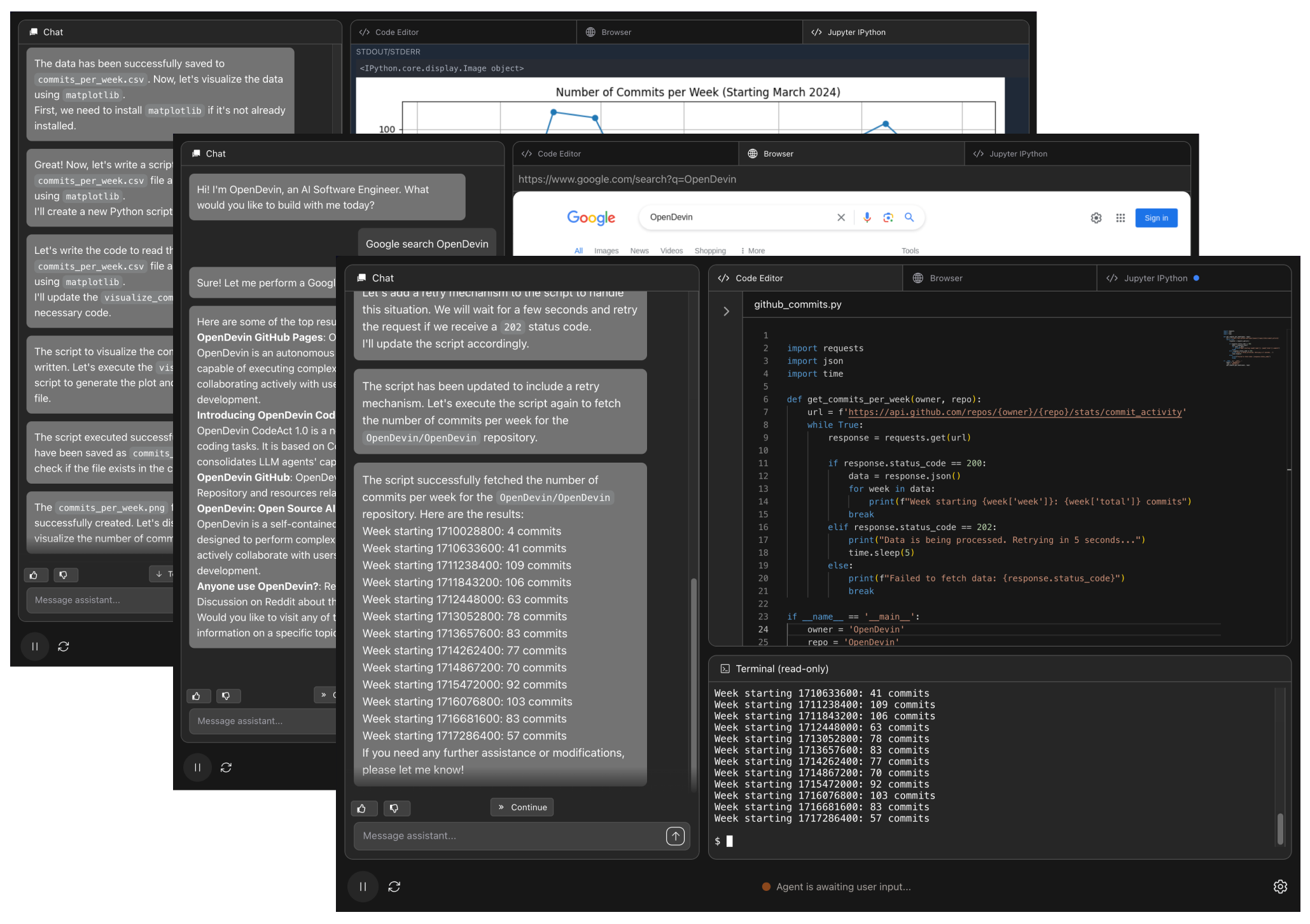

各位技术大咖、编程狂热者们,今天我要给大家揭秘一款绝对能让你秒变码界英雄的神器——OpenHands。这不仅仅是一个基于人工智能的软件开发代理平台,它简直就是你的私人智能小助手,帮你搞定从代码编写到命令行操作再到网页浏览的一切繁琐任务,效率翻倍不是梦!如果你也想解锁在Linux系统中安装并利用cporal内网穿透技术实现远程访问的新技能,那就跟着我一起探索这个神奇的‘魔法’吧!

1. Linux部署OpenHands

本篇文章演示环境:Ubuntu22.04

运行 OpenHands 最简单的方法是使用Docker进行部署,如果没有安装Docker,可以查看这篇教程进行安装:Docker安装——Linux、Windows、MacOS - cpolar 极点云官网

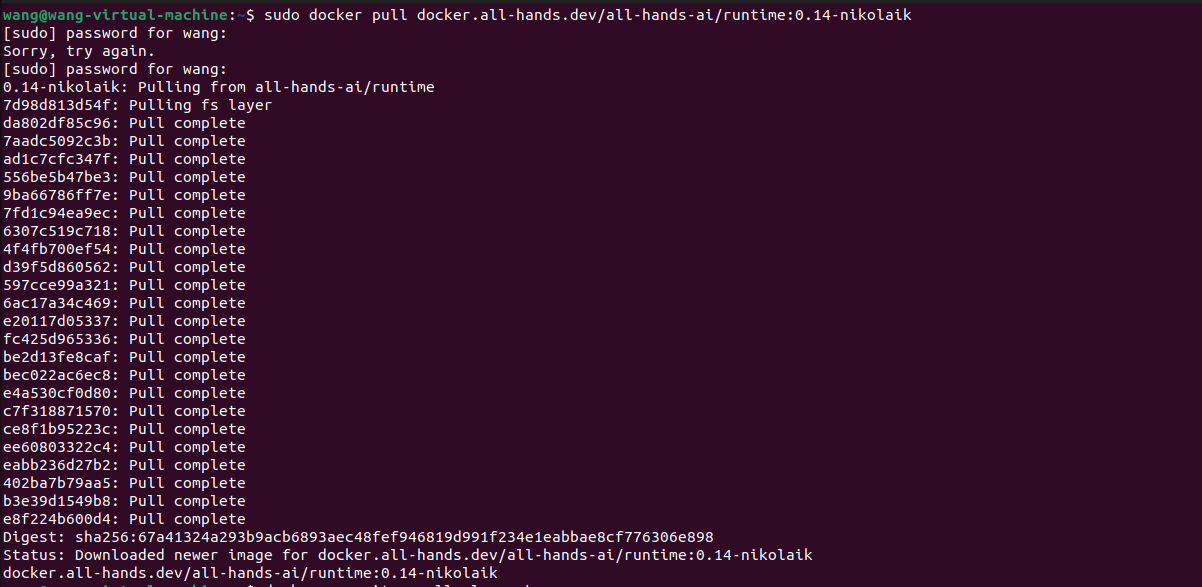

输入以下命令来运行以下命令拉取OpenHands镜像:

sudo docker pull docker.all-hands.dev/all-hands-ai/runtime:0.14-nikolaik

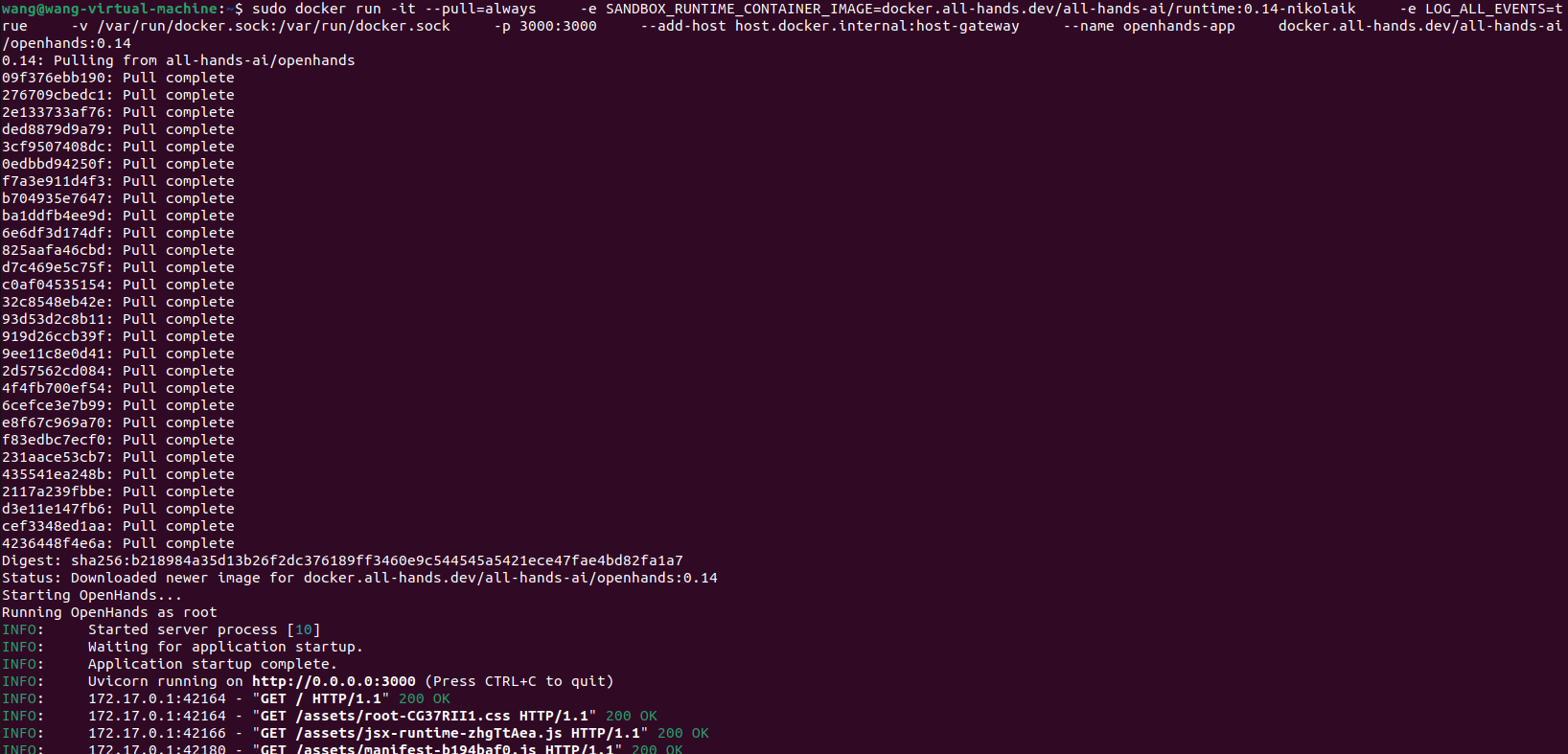

使用以下命令启动OpenHands容器:

sudo docker run -it --pull=always \

-e SANDBOX_RUNTIME_CONTAINER_IMAGE=docker.all-hands.dev/all-hands-ai/runtime:0.14-nikolaik \

-e LOG_ALL_EVENTS=true \

-v /var/run/docker.sock:/var/run/docker.sock \

-p 3000:3000 \

--add-host host.docker.internal:host-gateway \

--name openhands-app \

docker.all-hands.dev/all-hands-ai/openhands:0.14

打开浏览器输入 localhost:3000 启动并可以访问。

2. OpenHands功能介绍

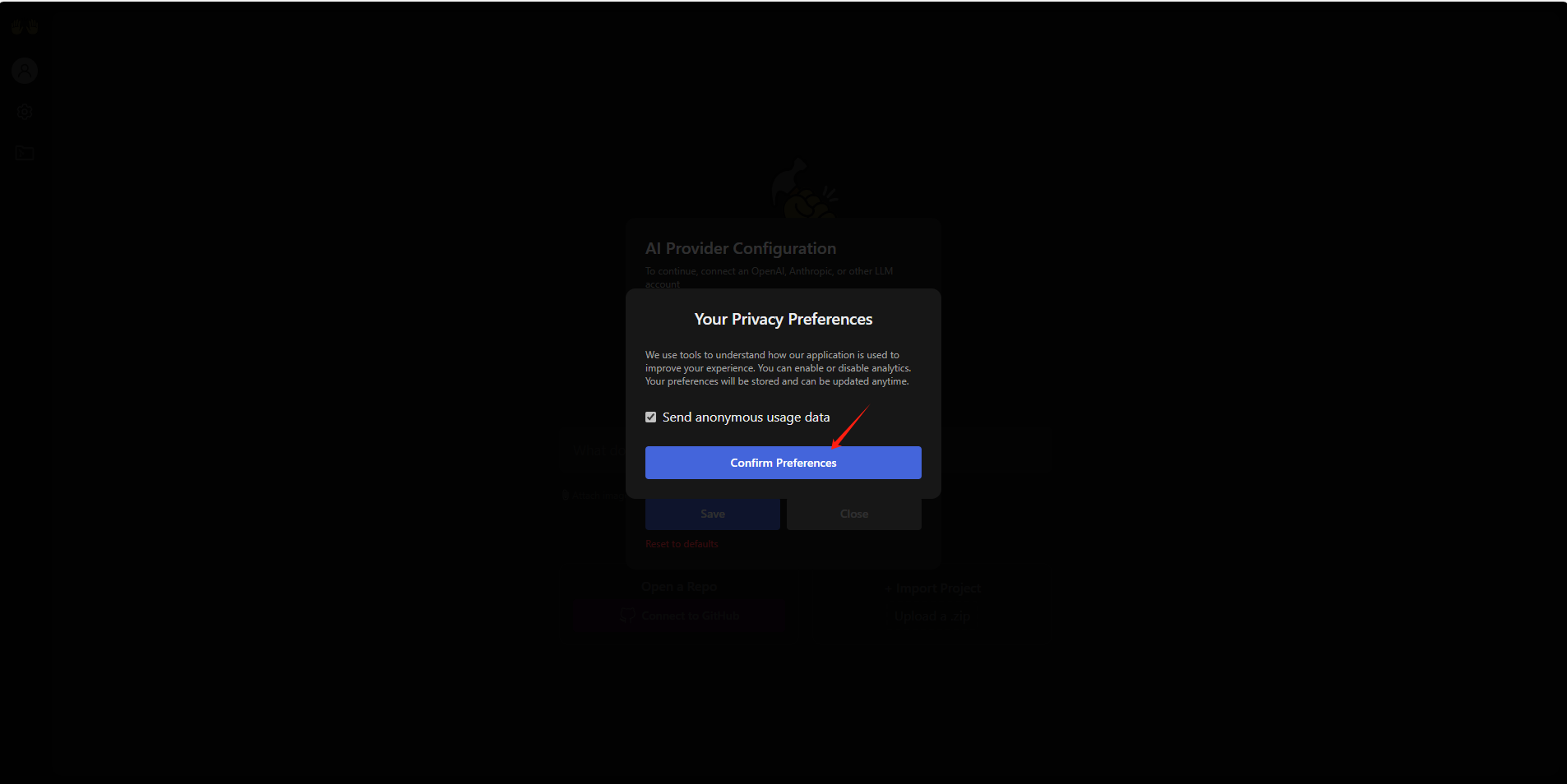

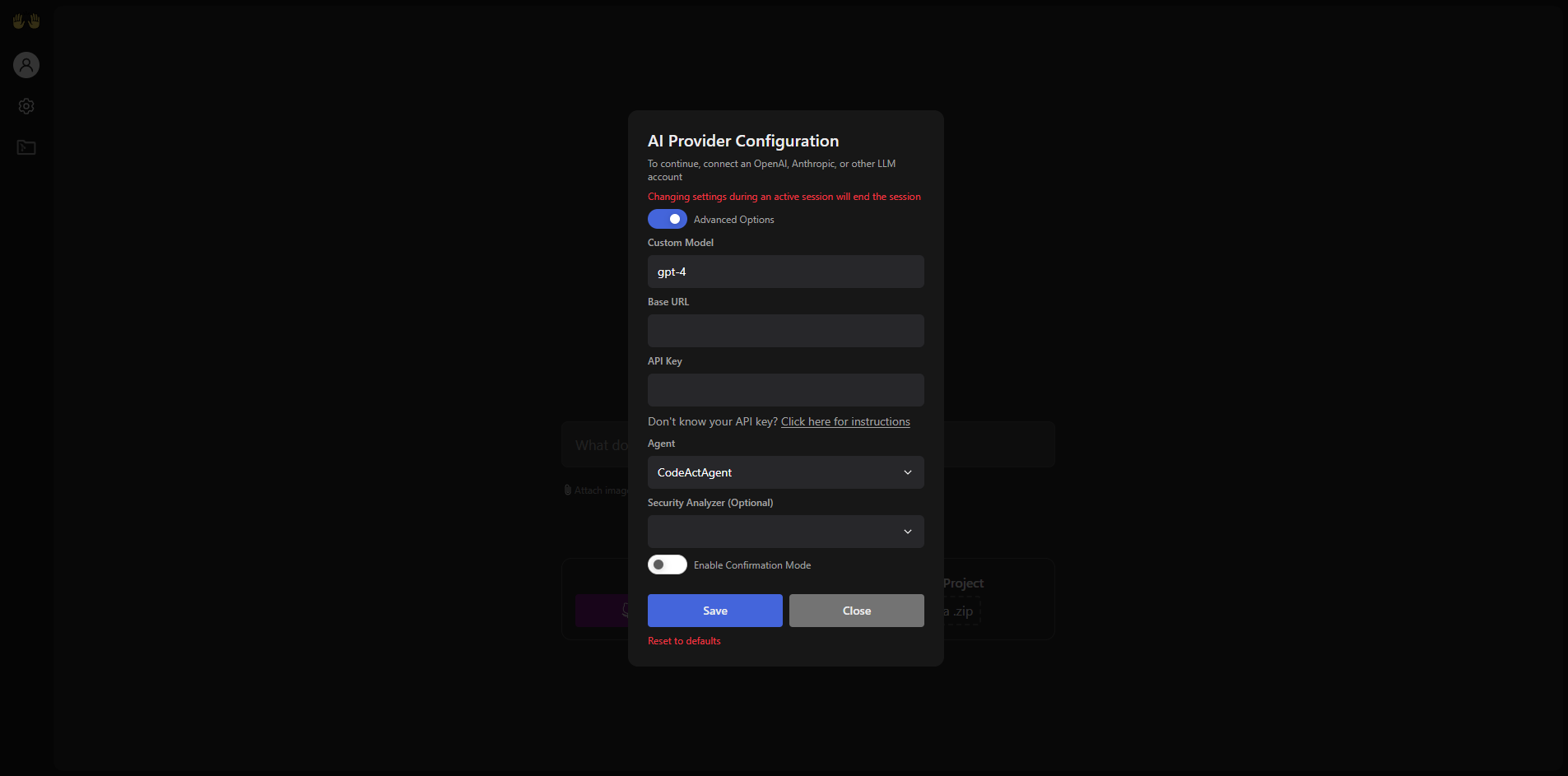

首次运行时,会弹出设置窗口。

用户需要选择LLM提供商、LLM模型并输入API密钥。

可通过点击UI中的齿轮图标随时调整设置。如需使用自定义模型,可在高级选项中手动输入模型名称和Base URL。

设置好后,点击Save保存

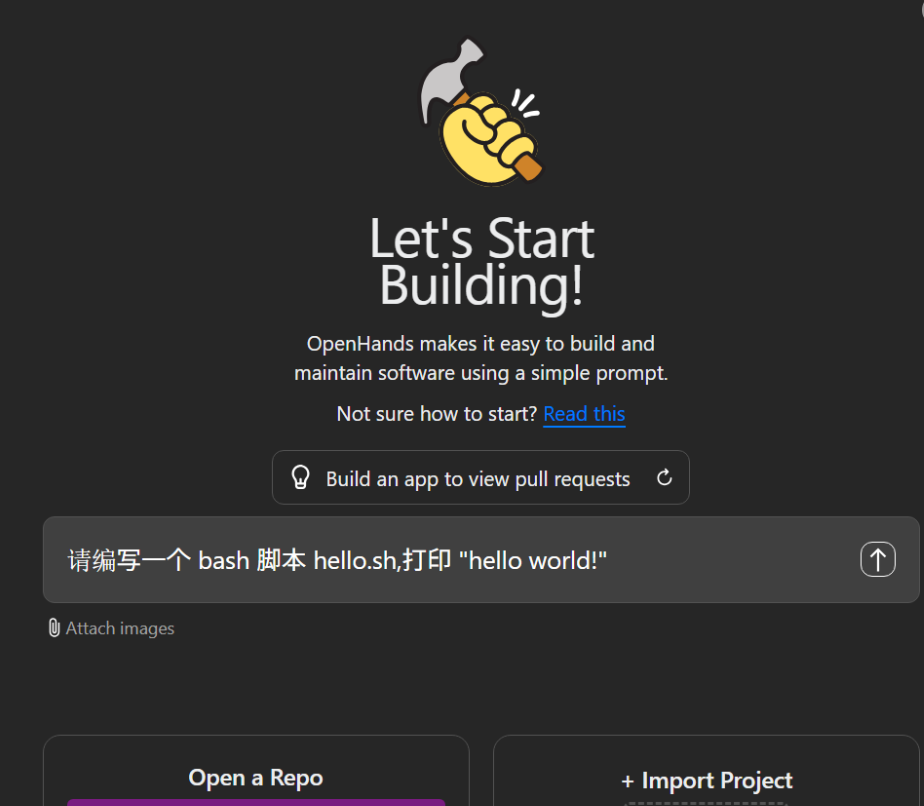

接下来验证下OpenHands,输入下提示词请求,例如:请编写一个 bash 脚本 hello.sh,打印 “hello world!”

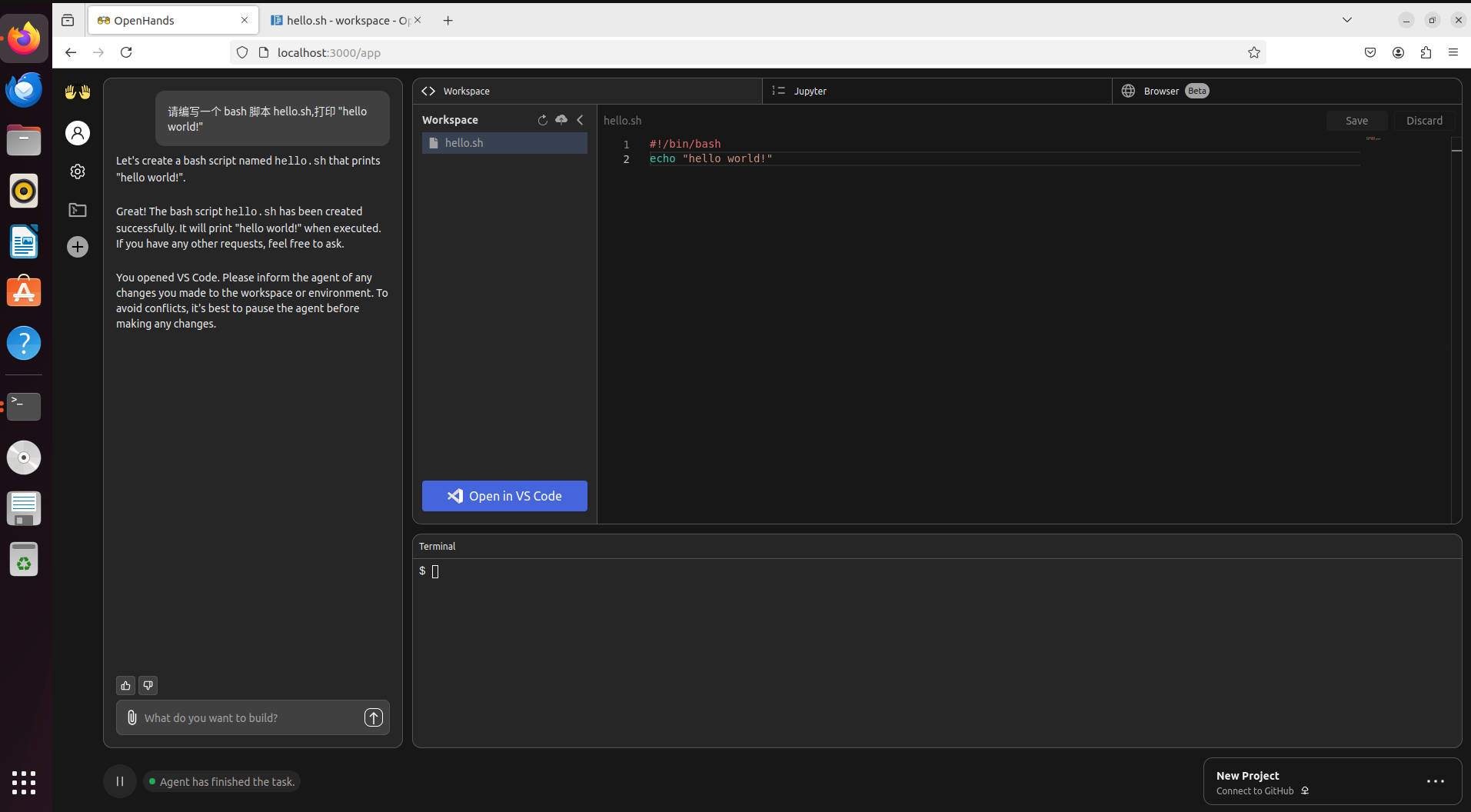

回到OpenHands,可以看到左侧显示提示词,右侧给出了对应回答

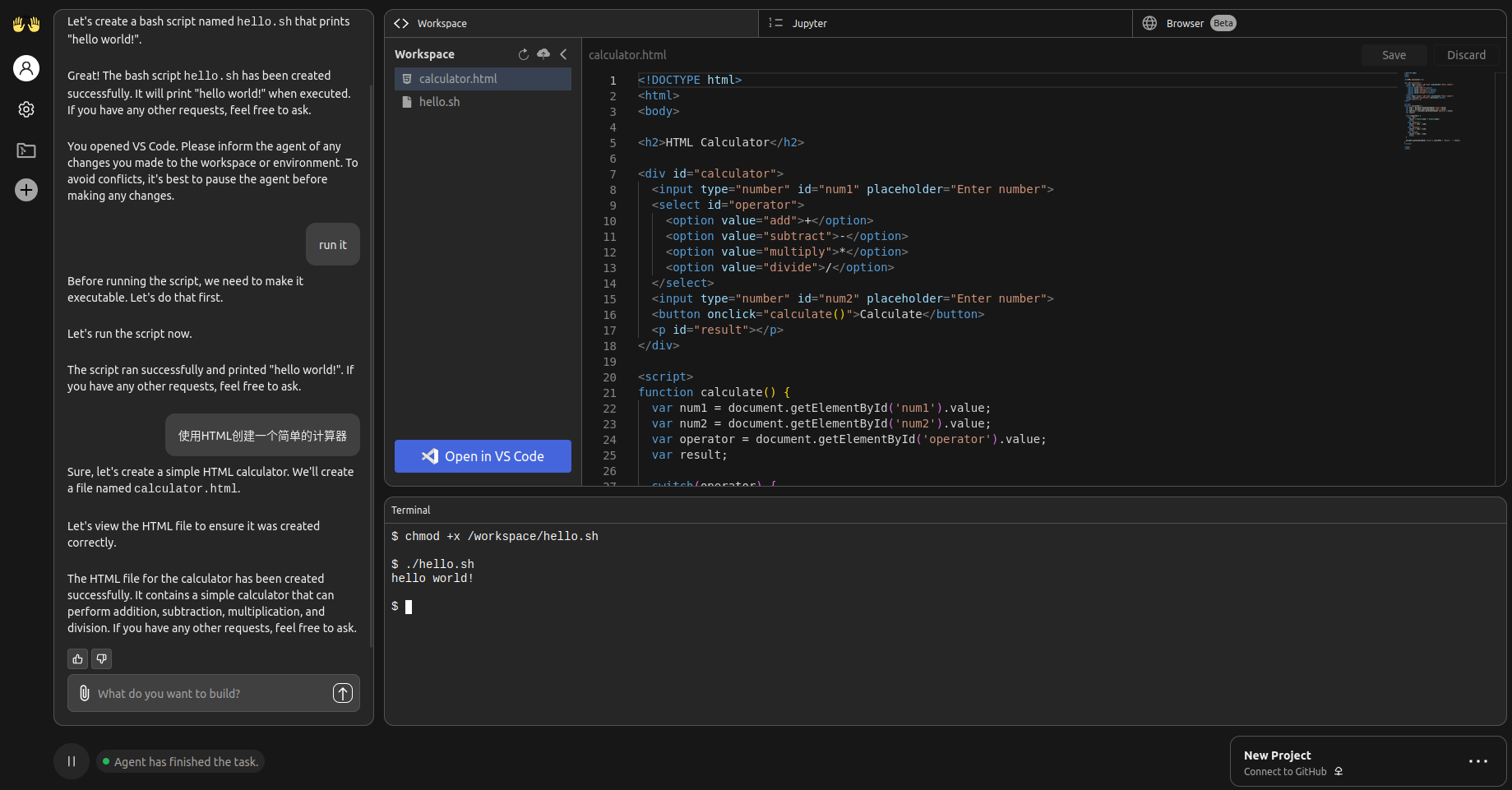

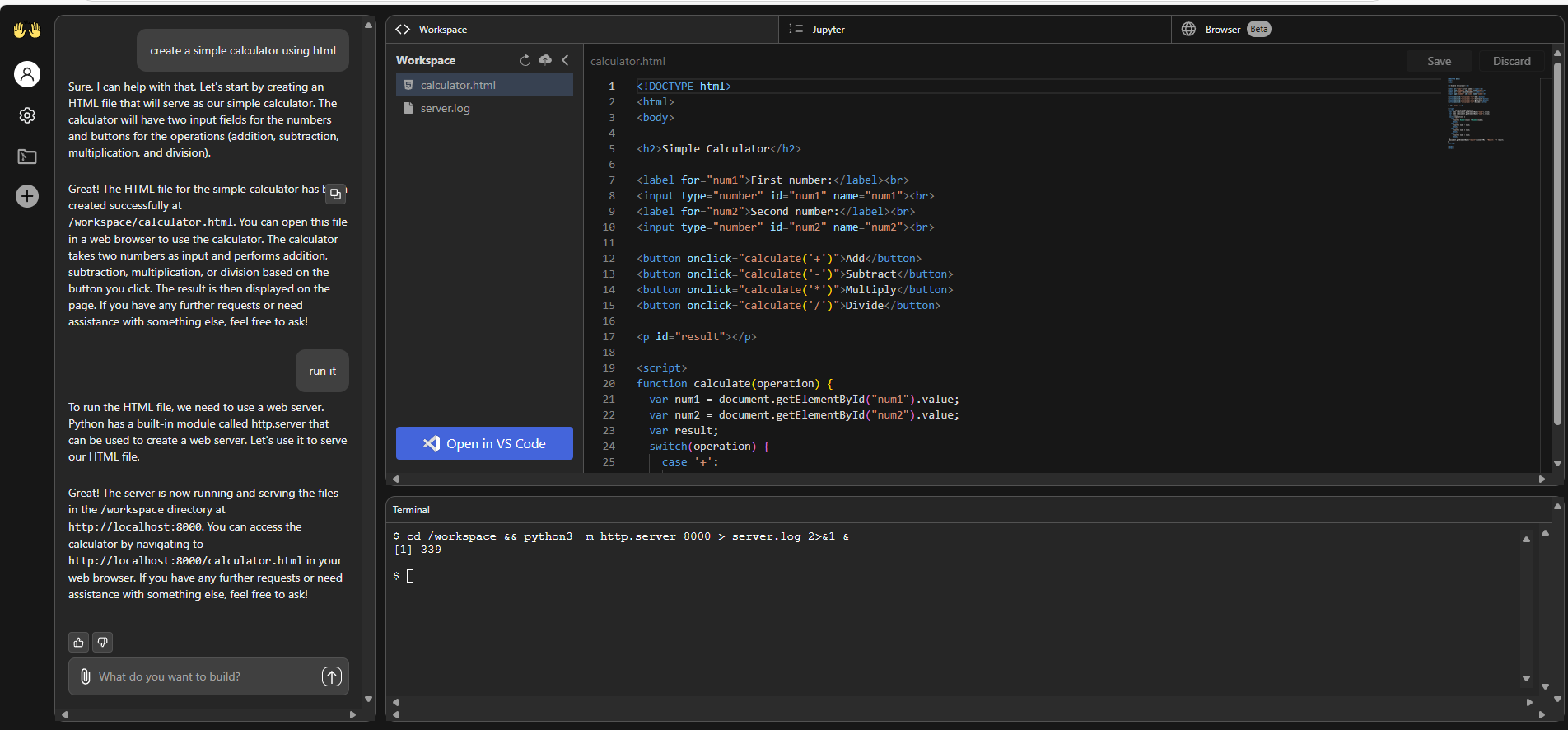

接下来我想让他使用HTML创建一个简单的计算器,点击生成,可以看到右侧出现了相应文件的代码

在输入框中让它运行这个项目,可以看到在对话框中输出了链接

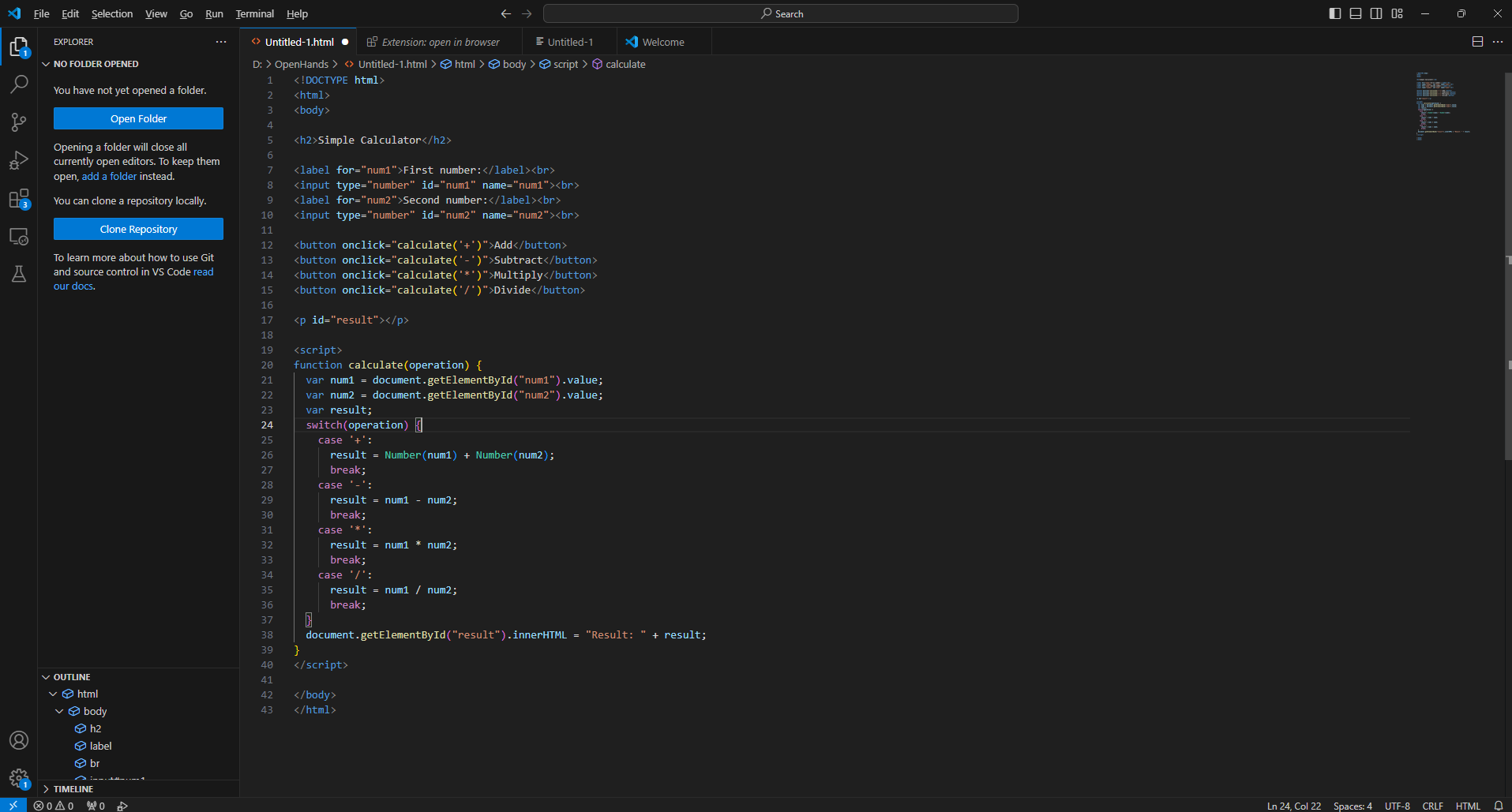

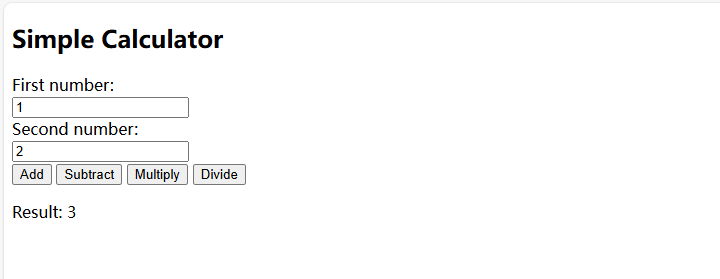

验证一下这个简单的计算器生成是否正确,这里我使用VsCode打开并运行代码。

一个简易的计算器就生成好了,如果不满意就可以回到OpenHands,继续输入要求生成新的代码。

虽然在本地环境中部署OpenHands已经能够显著提升你的开发效率,但如果你希望从任何地方都能随时随地访问这个强大的工具,就需要解决内网穿透的问题。这时,Cpolar就成为了你的得力助手。

Cpolar是一款功能强大且易于使用的内网穿透工具,它能够在几秒钟内将你的本地服务暴露到公网上。无论你是在办公室、家里还是在旅途中,Cpolar都能确保你能够轻松访问OpenHands,而无需复杂的网络配置或昂贵的服务器托管费用。

接下来教大家如何安装Cpolar并且将 OpenHands 实现公网使用。

3. 公网使用OpenHands

3.1 内网穿透工具安装

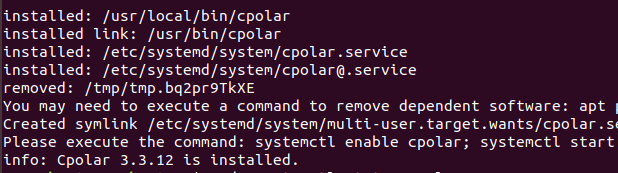

下面是安装cpolar步骤:

Cpolar官网地址: https://www.cpolar.com

使用一键脚本安装命令

sudo curl https://get.cpolar.sh | sh

安装完成后,执行下方命令查看cpolar服务状态:(如图所示即为正常启动)

sudo systemctl status cpolar

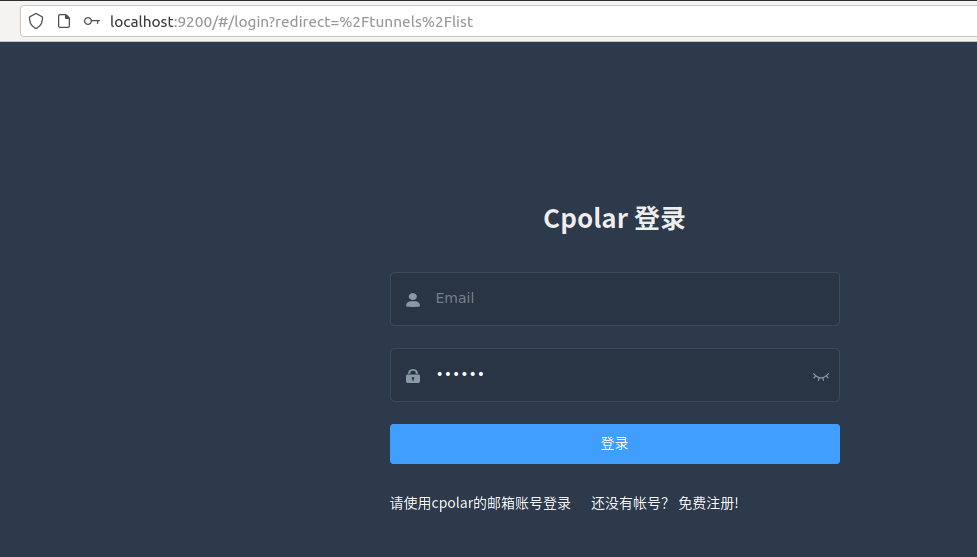

Cpolar安装和成功启动服务后,在浏览器上输入ubuntu主机IP加9200端口即:【http://localhost:9200】访问Cpolar管理界面,使用Cpolar官网注册的账号登录,登录后即可看到cpolar web 配置界面,接下来在web 界面配置即可:

3.2 创建远程连接公网地址

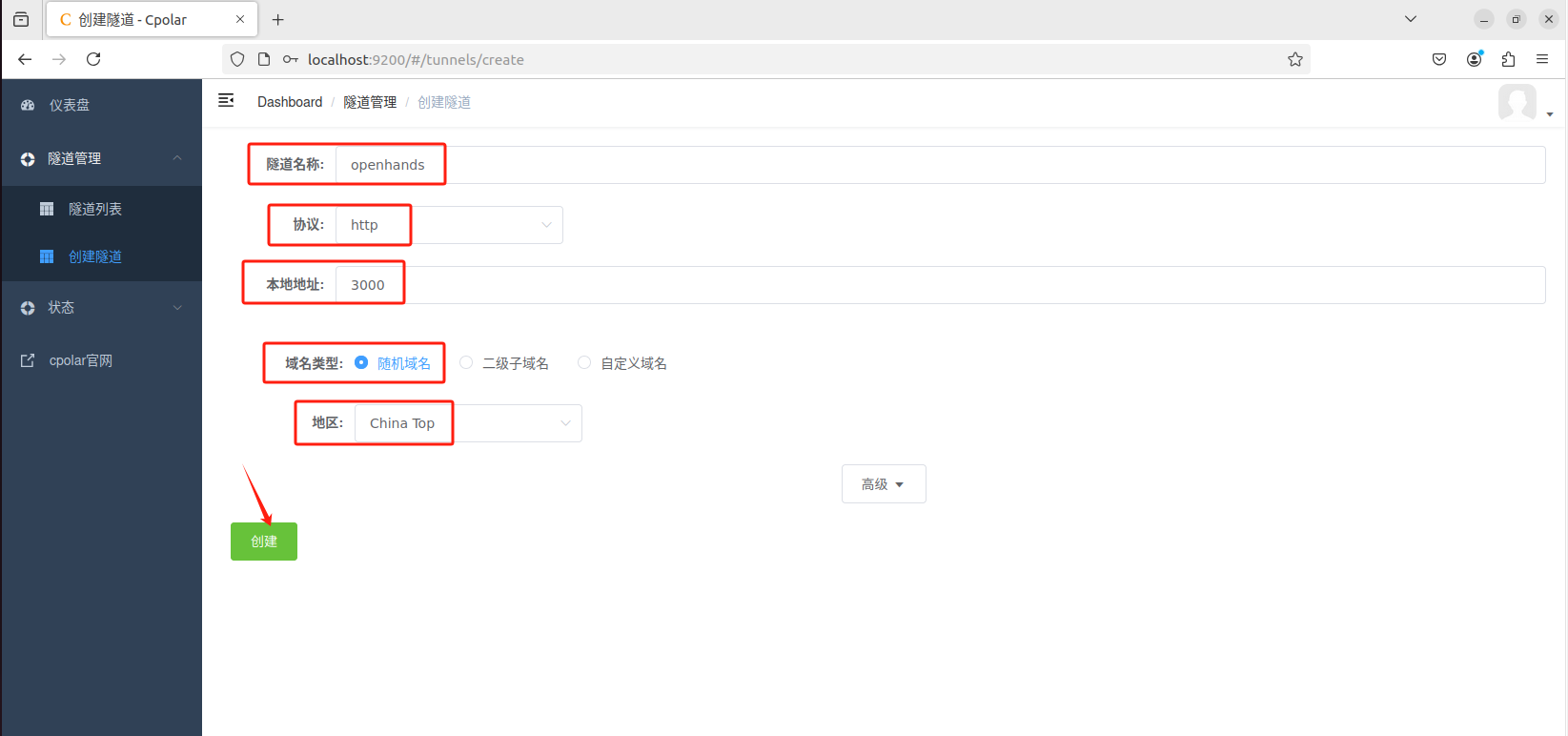

登录cpolar web UI管理界面后,点击左侧仪表盘的隧道管理——创建隧道:

-

隧道名称:可自定义,本例使用了: openhands 注意不要与已有的隧道名称重复

-

协议:http

-

本地地址:3000

-

域名类型:随机域名

-

地区:选择China Top

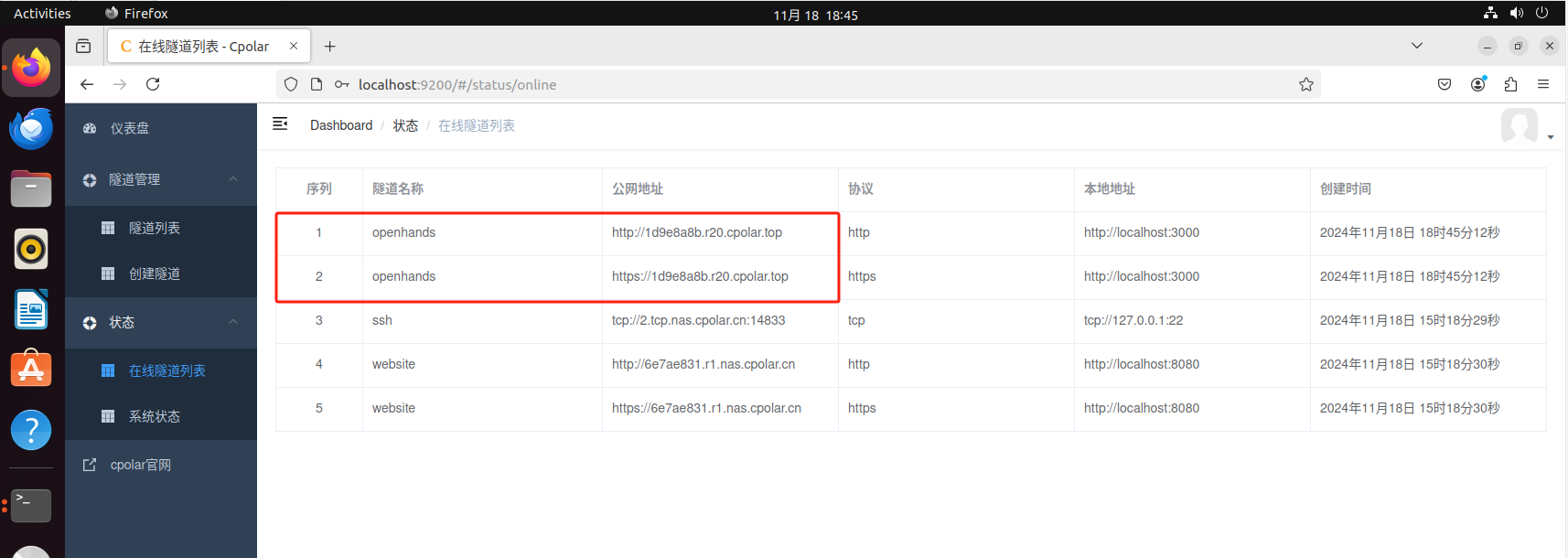

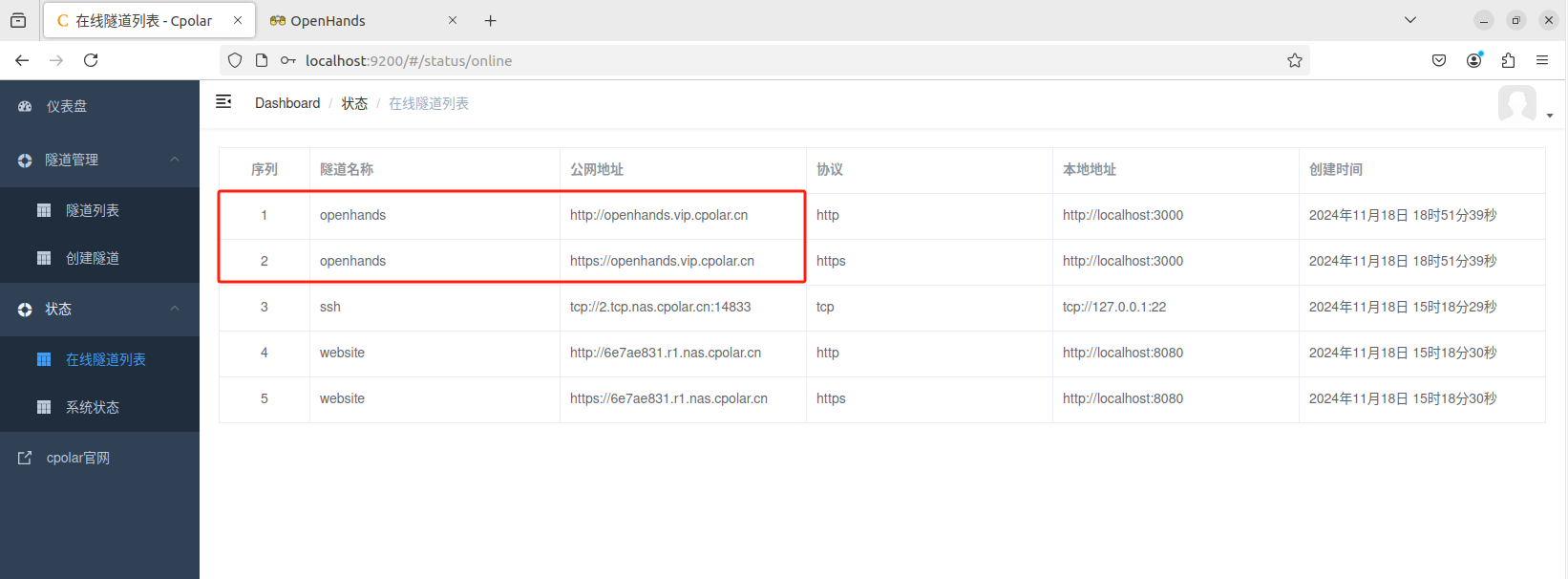

创建成功后,打开左侧在线隧道列表,可以看到刚刚通过创建隧道生成了两个公网地址,接下来就可以在其他电脑(异地)上,使用任意一个地址在浏览器中访问即可。

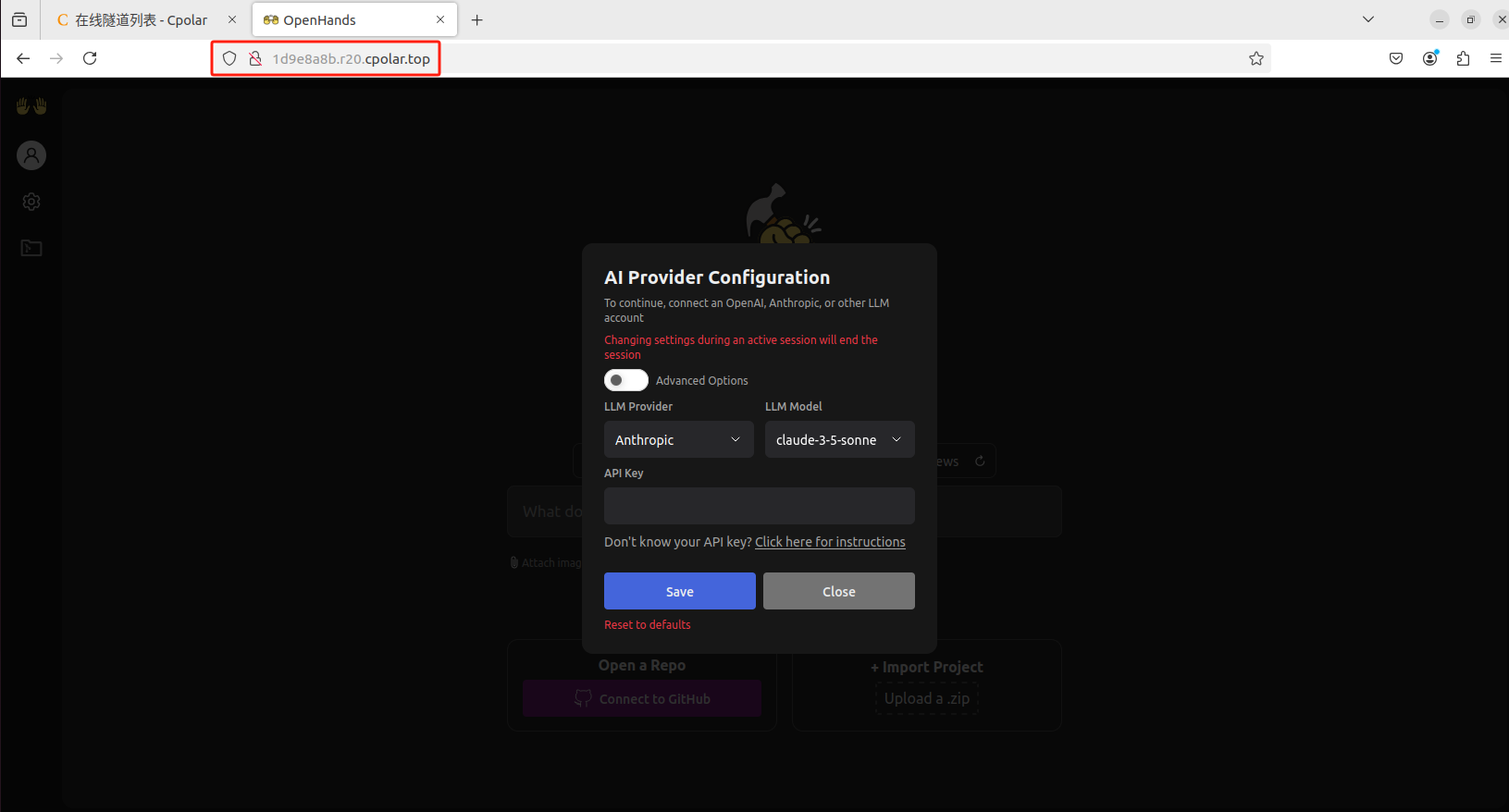

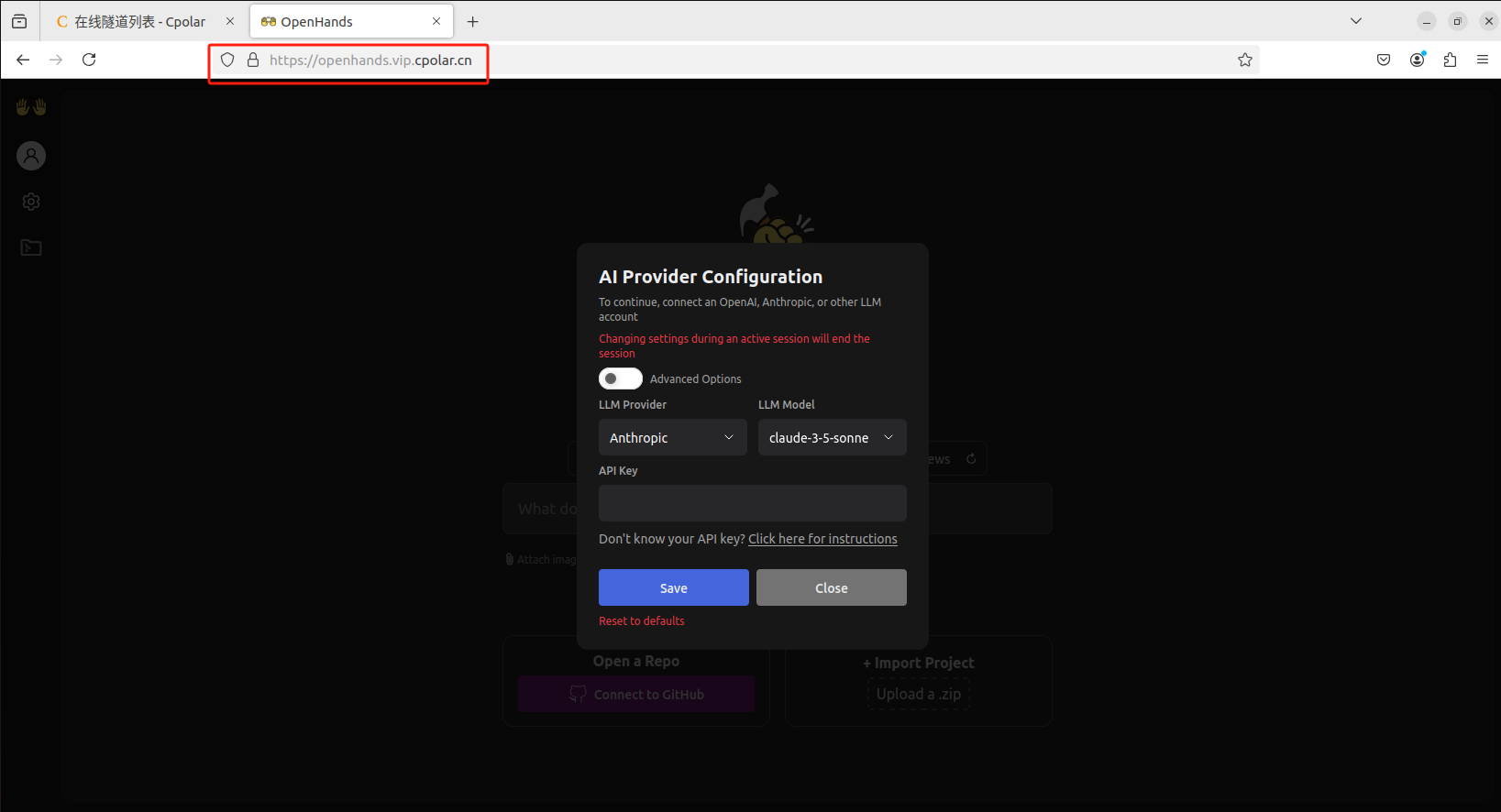

如下图所示,成功实现使用公网地址异地远程访问本地部署的OpenHands,跟上面一样,配置好模型即可使用。

使用上面的cpolar https公网地址,在任意设备的浏览器进行访问,即可成功看到OpenHands界面,这样一个利用公网地址可以进行远程访问的隧道就创建好了,隧道使用了cpolar的公网域名,无需自己购买云服务器,可节省大量资金。使用cpolar创建隧道即可发布到公网进行远程访问,新域名登录,可能需要重新登陆!

4. 固定OpenHands公网地址

由于以上使用cpolar所创建的隧道使用的是随机公网地址,24小时内会随机变化,不利于长期远程访问。因此我们可以为其配置二级子域名,该地址为固定地址,不会随机变化。

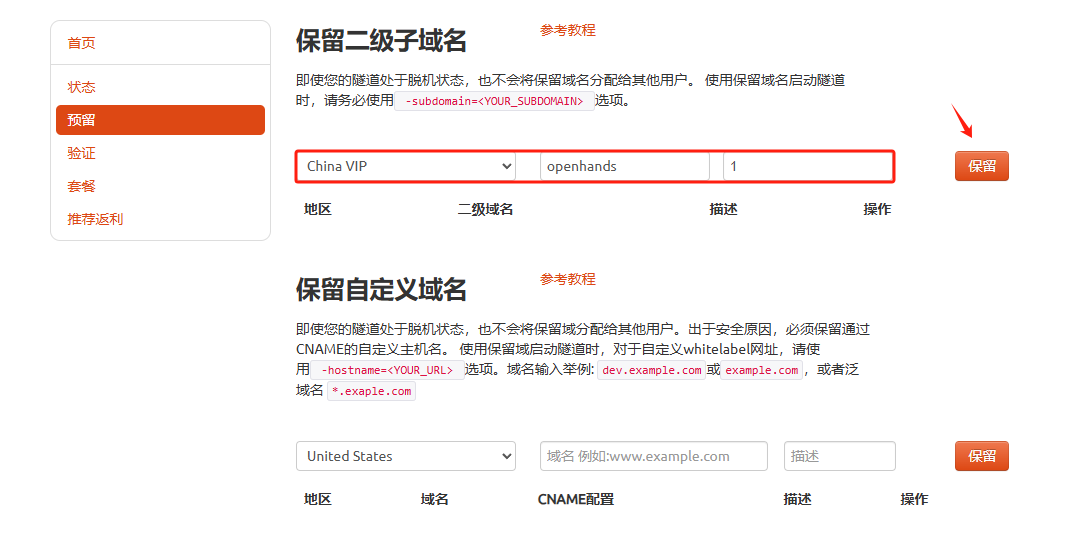

登录cpolar官网,点击左侧的预留,选择保留二级子域名,地区选择china vip,然后设置一个二级子域名名称,填写备注信息,点击保留。

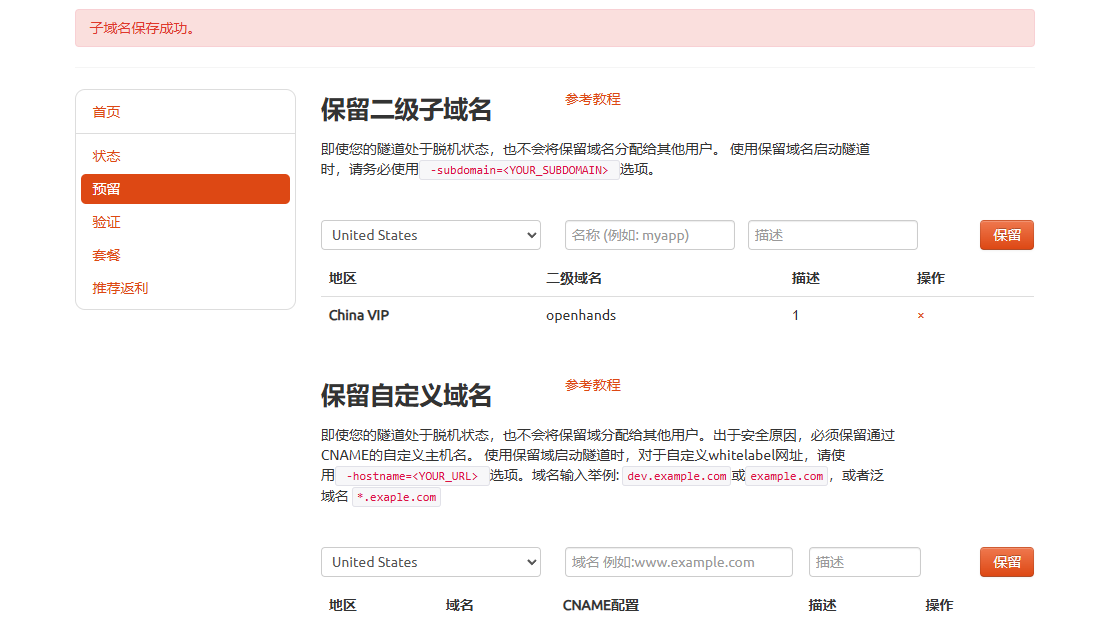

保留成功后复制保留的二级子域名地址:

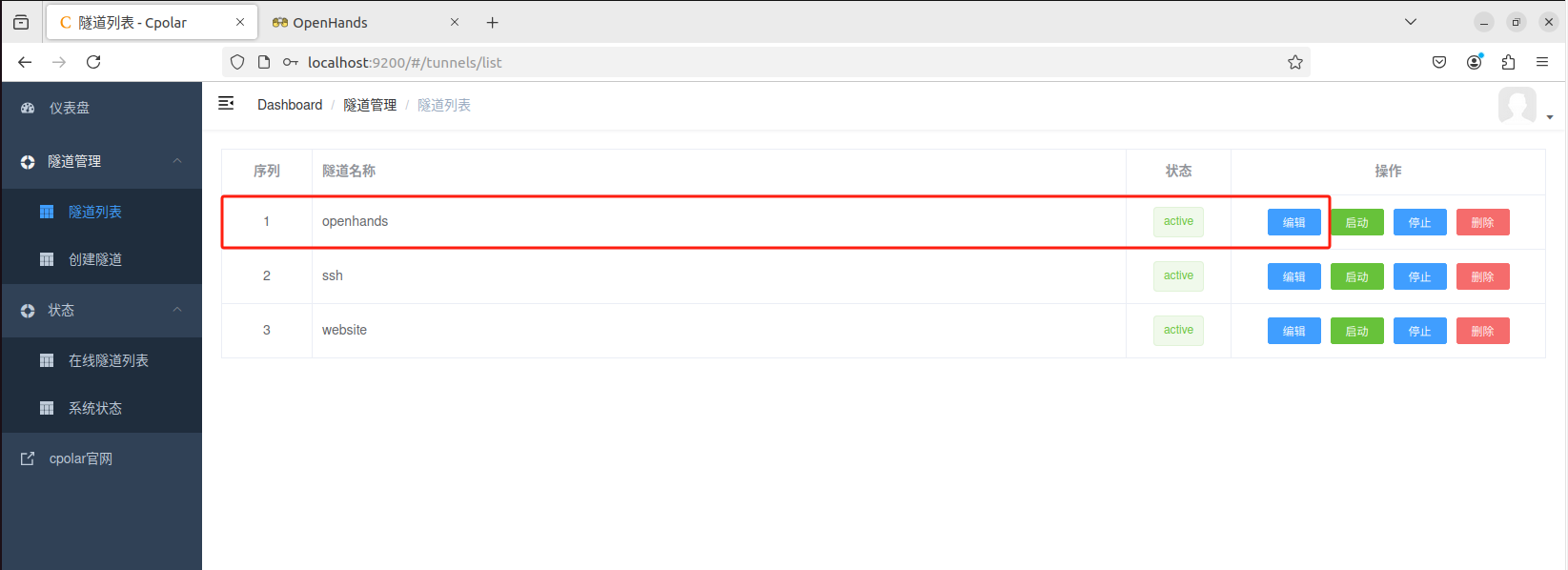

登录cpolar web UI管理界面,点击左侧仪表盘的隧道管理——隧道列表,找到所要配置的隧道,点击右侧的编辑。

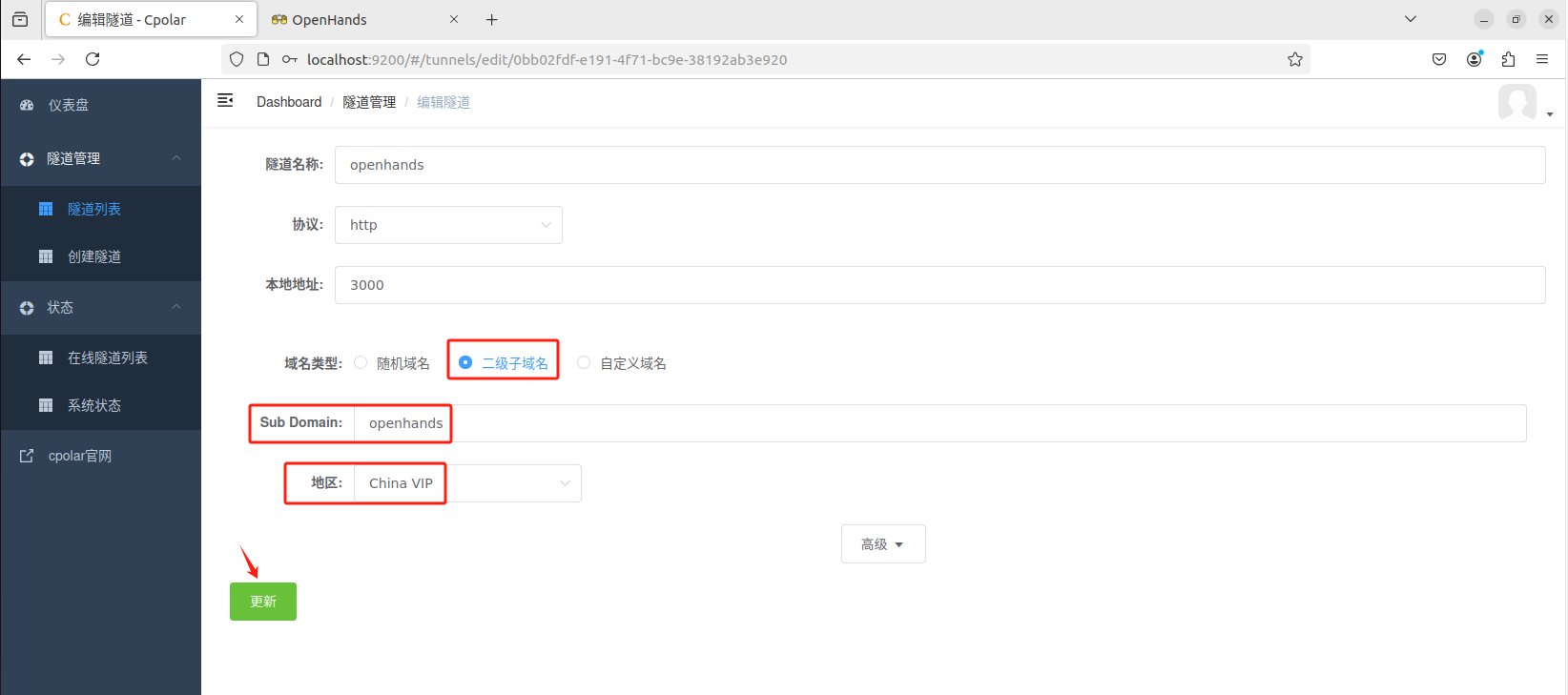

修改隧道信息,将保留成功的二级子域名配置到隧道中

-

域名类型:选择二级子域名

-

Sub Domain:填写保留成功的二级子域名

-

地区: China VIP

点击更新

更新完成后,打开在线隧道列表,此时可以看到随机的公网地址已经发生变化,地址名称也变成了保留和固定的二级子域名名称。

最后,我们使用固定的公网地址访问 OpenHands 界面可以看到访问成功,一个永久不会变化的远程访问方式即设置好了。

通过将OpenHands部署到Linux本地环境,并巧妙结合cporal实现公网访问,你现在已经获得了随时随地处理复杂开发任务的能力,简直就像拥有了超能力一样!这篇文章不仅希望能为你带来满满的技术干货,更希望能在你的编程之旅中添上一抹亮色。如果觉得有用的话,别忘了给这篇教程点个赞,让我们一起让更多小伙伴加入这场技术盛宴吧!

8966

8966

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?