摘要

大多数用于目标检测的知识蒸馏方法都是基于特征的,并且取得了较好的效果。然而,仅在特征模仿部分进行提取,并不能充分利用更精密的检测头设计来进行目标检测,特别是密集目标检测。本文提出了一种三重平行蒸馏(TPD)方法,可以有效地将检测头的所有输出响应从教师传递到学生。此外,克服了基于特征的蒸馏与基于响应的蒸馏的简单结合、效果增强有限的缺点。提出了一种分层重加权注意蒸馏(HRAD)方法,使学生在特征信息上比教师学到更多,并在检测头的分类—IoU联合表示与基于注意的特征之间进行互反馈。通过相互作用TPD和HRAD的优点,提出了一种面向密集目标检测的闭环统一知识蒸馏方法,使基于特征的知识蒸馏和基于响应的知识蒸馏实现了统一和互补。

介绍

目标检测中的知识蒸馏方法主要集中在基于特征的方案上,在特征映射中提取的特定区域存在差异。这种方法可以相对地保证学生从特征模仿中提取教师的知识,并且可以方便地应用于流行的目标检测器。然而,这种用于目标检测的蒸馏没有充分考虑检测头的重要信息,从而失去了更复杂的检测头设计用于目标检测,特别是密集目标检测的优势。(基于特征的蒸馏方法,没有考虑检测头的信息)

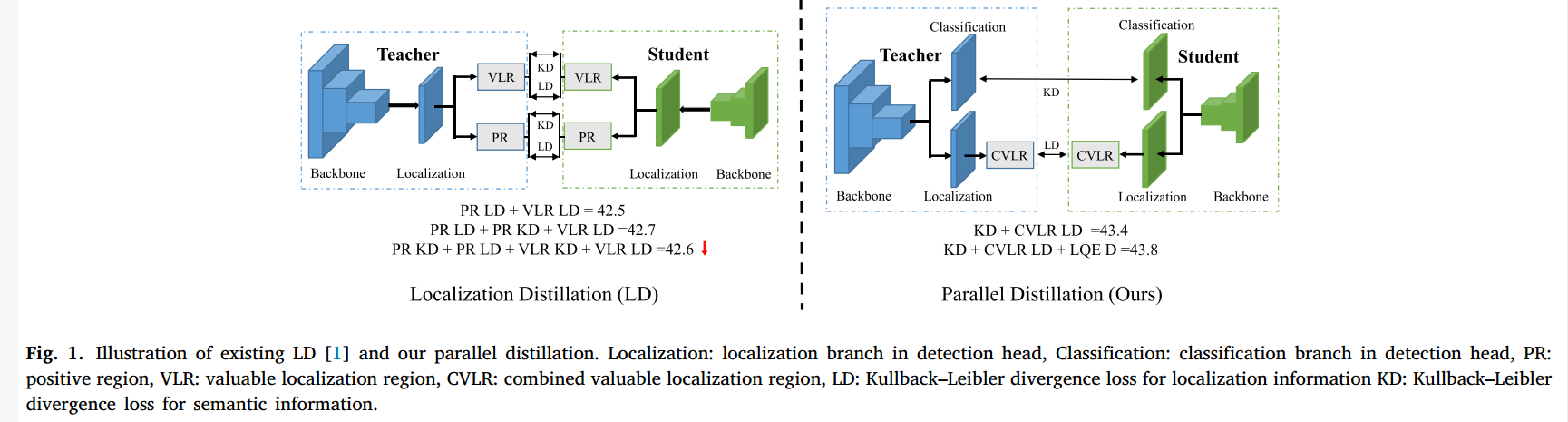

更好的检测头设计将决定基于相同骨干网的密集目标检测的最终性能差异,并最终获得比迄今为止非密集目标检测更多的效益。因此**,在知识蒸馏过程中如何充分利用检测头的输出响应成为关键问题**。LD采用基于response的蒸馏方法在检测头传递输出response。如图1左侧所示,提出利用定位分支的一般分布进行定位蒸馏。为了增强语义和定位信息,本文提出对positive 区域(PR)和有价值区域(VLR)分别使用LD损失函数和KD损失函数。然而,消融实验表明,纳入KD损失只会导致整体性能的边际改善,而纳入VLR的KD会导致整体性能下降。此外,LD在密集目标检测中的贡献明显低于基于特征的KD方法。因此,我们认为通过定位分支提取知识并在定位区域内合并单独的分类KD损失的影响可以忽略不计。

在本研究中,如图1右半部分所示,我们分别从整体并行结构和密集目标检测头中各支路平衡的角度,充分利用了并行检测头的输出response。此外,我们将定位分支的PR和VLR合并为组合VLR(CVLR),使蒸馏过程更加充分和高效。整个过程称为平行蒸馏。我们的方法超越了LD的结果,同时采用了简化的蒸馏损失函数,展示了我们的创新贡献之一。

根据以上分析,本文采用GFLV2的检测头结构,提出了一种新型的三重平行蒸馏(TPD)。基于这种竞争性的TPD,基于response的蒸馏可以与基于特征的蒸馏联合到并行检测框架中,以获得更好的结果。然而,当前主流的基于特征的知识蒸馏方法与基于response的TPD相结合,在整体性能上的提升非常有限。考虑到TPD与基于特征的蒸馏之间的互补作用,使学生能够超越教师的知识限制,提出了一种分层重加权注意蒸馏(HRAD),通过重新设计注意机制 ,将空间注意、通道注意与关系注意协同使用。

更重要的是,分类IoU联合表示是定位质量估计和分类的融合,从教师的检测头反馈到每一层注意特征。通过这种方式,不仅可以使特征在FPN的每一层中变得更有区域,而且还可以在检测头的分类-IoU联合表示与基于注意的特征之间实现互反馈。**对TDP和HRAD作为封闭的统一蒸馏,提出一种用于密集目标检测的闭环统一知识蒸馏(CUD)方法。**在这项工作中的主要贡献可以总结如下:

1、提出了一种充分利用所有分支输出response的三重平行蒸馏(TPD)方法,该方法能够实现基于response的方法,用于密集目标检测。

2、为了使学生网络在特征模仿方面比教师网络学到更多的东西,提出了一种分层重加权注意蒸馏(HRAD)方法。检测头的分类-IoU联合表示与基于注意的特征之间相互反馈,进一步提高了检测性能。

3、结合TPD和HRAD的优点,提出了一种闭环的统一蒸馏方法,使基于特征的蒸馏和基于响应的蒸馏实现了统一和互补。

相关工作

面向目标检测的知识蒸馏

基于特征的:与分类任务不同,检测任务中基于特征的蒸馏损失在正实例和负实例之间遇到极端不平衡。为了解决这一问题,Li等人尝试在Faster RCNN的区域建议网络(RPN)模型中进行蒸馏,通过RPN采样提取一定比例的正、负实例。随后,Wang等人认为选择整个RPN模块进行蒸馏不利于正、负样本的定义,提出了细粒度掩码,对基于真值边界盒计算的区域进行蒸馏。Guo等将前景和背景分开提炼,使其更有利于学生网络。

对另一种基于注意力的知识蒸馏的目标检测,提出了一种注意力引导的蒸馏和一种非局部蒸馏来平衡前景和背景之间的像素,进一步避免了对不同像素之间的关系缺乏蒸馏。Yang等提出了Focal 蒸馏和Global蒸馏。前者是迫使学生关注教师的关键像素和通道,后者是重建不同像素之间的关系。这些蒸馏被归类为基于特征的蒸馏的一个分支,因为其核心操作仍然主要集中在特征提取上。

基于response的:在基于response的对象检测知识蒸馏研究有限的情况下,LD提出了一种定位蒸馏(LD)方法,可以有效地将定位知识从教师传递给学生。然而,该方法没有充分考虑到密集目标检测器的所有输出响应。与最有效的基于特征的方法相比,结果相对缺乏竞争力。

**与上文分别使用基于特征的蒸馏和基于response的蒸馏不同,本研究将两种蒸馏结合使用,并采用交互反馈机制。**所提出的CUD有两种挑战需要解决:(1)基于response的蒸馏未能在检测头中充分提取出有用的输出响应。(2)单纯地将基于特征的蒸馏和基于response的蒸馏相结合所获得的性能提升是非常有限的。

所提出的工作

不同的研究表明,提取定位响应分布可以有效地将定位知识从教师传递给学生[1]。然而,研究也发现,有意义的知识不仅存在于定位分布的输出响应中,也存在于分类分支和定位质量估计过程中。这启发我们设计了如图2(蓝色虚线框)所示的三平行蒸馏(TPD),从检测头的整体结构角度充分利用了所有模型的分支。

为了让学生从教师的特征信息中获得更多的信息,本文还提出了一种分层重加权注意蒸馏(HRAD)方法。如图2所示(红色虚线框),所提出的蒸馏能够提取有效的特征注意力,并使用每层检测头的分类-iou联合表示对其重新加权。

将TPD和HRAD集成到一个端到端的闭环统一知识蒸馏(CUD)中,用于密集目标检测。而不是基于response和基于特征的蒸馏的简单组合,一个相互反馈机制已经被纳入拟议的CUD中,已获得显著的性能。我们的工作细节介绍如下:

用于密集目标检测的三重平行蒸馏

最流行的基于response的图像分类知识蒸馏被称为soft目标,这是一种软化输出分布的操作。具体来说,这个操作也意味着输入属于不同类别的概率,可以通过Softmax函数来估计。

其中为i类的Logit,并引入温度因子T来控制各个soft目标的重要性。当T=1时,函数等同于原始Softmax函数,当T=0时,趋向于狄克拉分布。 时,近似为均匀分布。为了使概率分布包含更多的信息,一般将T设置为>1以软化分布。衡量师生概率分布相似性的蒸馏损失可以写成:

时,近似为均匀分布。为了使概率分布包含更多的信息,一般将T设置为>1以软化分布。衡量师生概率分布相似性的蒸馏损失可以写成:

使用KL散度。

定位response蒸馏

为了直接模拟定位分支的最终分布预测,受[11,12]的启发,我们利用边界框任意分布的“一般分布”p(x),表示边界框的任意分布,以反应定位的不确定性。在这个分布中,边界框的每条边都可以表示为: ,它在预定义的输出范围

,它在预定义的输出范围 。同时,将域的连续范围转换为离散列表

。同时,将域的连续范围转换为离散列表 ,估计的边界框

,估计的边界框 可以表示为:

可以表示为:

然后,将边界框所有四条边的定位分支 的知识蒸馏表示为:

的知识蒸馏表示为:

与LD不同,LD分别在有价值定位区域(VLR)和正样本区域提取定位信息。本研究将VLR与正样本区相结合,具有简单、高效的特征。实验证明这种方法可以达到更好的效果。

分类response蒸馏

与定位分支的蒸馏相比,分类分支的蒸馏更简单,因为分类的输出最初是分布的形式。分类蒸馏 的损失函数表示为:

的损失函数表示为:

定位质量估计response蒸馏

通过提取由分布导向质量预测器(DGOP)得到的可靠定位质量估计(LQE)分数Q来指导分类c,进一步弥合了分类和定位分支之间的差距。考虑到LQE分数是一个离散值,我们采用L2 loss使学生网络更接近教师网络。将定位质量蒸馏的损失函数 定位为:

定位为:

其中 分别为GFLV2中教师和学生的DGQP子网和得到的定位质量估计分数。

分别为GFLV2中教师和学生的DGQP子网和得到的定位质量估计分数。

三重平行蒸馏损失

训练学生模型的总损失:

其中[11,12]中提出了前三个损失函数,分别是学生检测器的分类损失 、边界盒回归损失

、边界盒回归损失 和分布焦点损失

和分布焦点损失 。

。 表示TPD中的蒸馏损失

表示TPD中的蒸馏损失

面向密集目标检测器的分层重加权注意蒸馏

分层重加权注意蒸馏

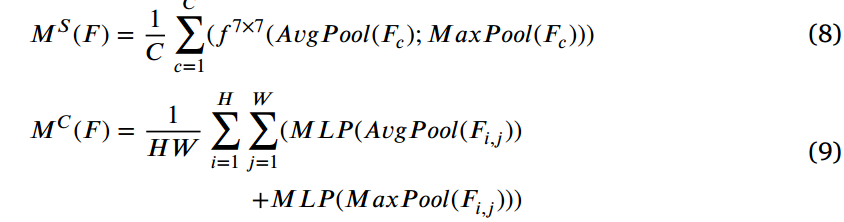

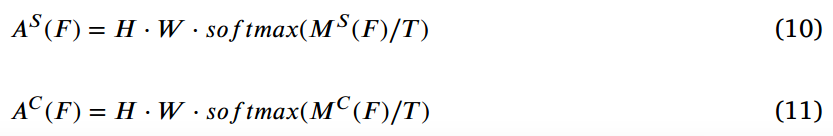

通常,基于注意力的蒸馏倾向于提取空间和通道信注意力的简单平均值,以提高检测性能。然而,采用SENet和CBAM等更先进的注意机制,直接蒸馏很难获得更好的结果。在我们的工作中,改进了一种基于CBAM的注意机制,并根据知识蒸馏的特点重新设计了模块。具体来说,由于基于特征的蒸馏通常将温度T设置为小于1,这是为了使特征的输出分布更陡峭。为了将输出的值域限制在[0,1]内,CBAM在同时提取平均池和最大池特征后使用sigmoid函数,这与蒸馏温度的设置明显矛盾。丢弃sigmoid函数,我们定义空间注意图 和通道注意图

和通道注意图 。

。

其中H,W,C表示特征的高度、宽度和通道。其中空间注意掩码 和通道注意掩码

和通道注意掩码 的表达式为:

的表达式为:

其中T为调节输出分布的温度超参数。

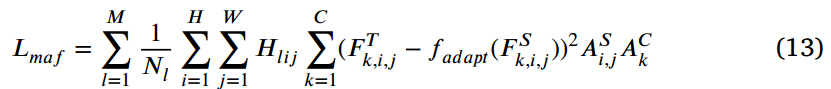

在获得有效的注意力特征映射后,引入从教师检测头的输出中获得的分层重加权因子G,以允许相应对每个FPN层的特征进行反馈。这不仅使蒸馏能够在检测头中纳入定位质量估计,而且使FPN的每一层之间更具区别性。如图2(绿色虚线框)所示,然后利用分类IoU联合表示的最大输出值对每个FPN层的特征进行重新加权。

这里l表示第l个FPN层, 表示分类IoU联合表示的输出类别,C为数据集中类别的个数,而整数

表示分类IoU联合表示的输出类别,C为数据集中类别的个数,而整数 为教师的概率,提出的混合注意特征损失

为教师的概率,提出的混合注意特征损失 定义如下:

定义如下:

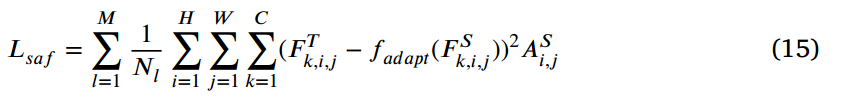

式中l表示第l个FPN层,M表示FPN层数,i,j,k表示特征图的宽度W,高度H和通道C。其中, 表示教师检测器和学生检测器的特征映射。其中

表示教师检测器和学生检测器的特征映射。其中 表示改进后的教师检测器的空间和通道注意掩码。

表示改进后的教师检测器的空间和通道注意掩码。

为了模仿教师检测器的空间和通道注意掩码,我们还提出了改进的通道和空间注意特征损失:

层次权重注意损失 是

是 的总和。

的总和。

Gc蒸馏

为了捕获图像中像素之间的关系,使用GcBlock。Gc loss  为:

为:

然后将上述损失合并为特征损失 。

。

用于密集物体检测的闭环统一蒸馏

基于特征的HRAD可以向检测头传递更多的特征信息,有利于基于响应的TPD。相应地,从检测头输出的分层重加权因子可以反馈给HRAD。这个过程类似于控制科学研究中的闭环控制系统,这启发了这种方法的名称,即用于密集目标检测的闭环统一知识蒸馏,其损失 为:

为:

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?