Partial Reinforcement Optimizer (PRO)

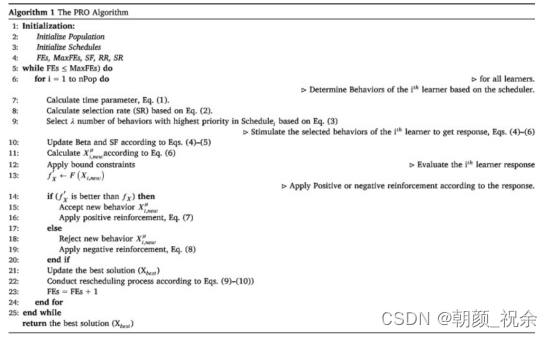

一种名为Partial Reinforcement Optimizer(PRO)的新型进化优化算法。PRO背后的主要思想来自进化学习和训练中的心理学理论,称为部分强化效应(PRE)理论。根据 PRE 理论,学习者在学习和训练过程中间歇性地强化以学习或加强特定行为。强化模式显着影响学习者在强化计划中的反应率和力量,这是通过适当选择强化行为和应用强化过程的时间来实现的。

为了将部分强化效应(PRE)理论的规则和概念映射到PRO算法的组件上,有必要将PRE理论建模为优化算法。

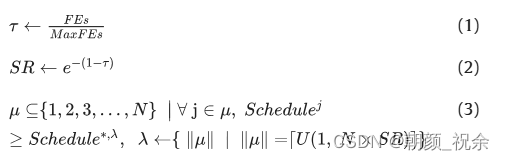

计划:计划的概念是需要加强行为的方式和时间,在不同的时间间隔内为数据结构建模,每个学习者都有特定的时间表。由于每个缩放器都代表特定学习者行为的分数/优先级,因此分数/优先级越高,在下一次迭代中被选中的机会就越大。此外,可变区间调度方案被建模为使用方程进行随机分析的动态机制。 (1)–(3)中。如何以及何时需要强化行为是一个变量,并在搜索过程中更新。因此,行为的子集,在每次迭代中为学习者选择附表 I 中优先级最高的。这样,首先,按降序对计划中的优先级进行排序,然后按第一个顺序排序使用式(3)选择项目数作为候选行为。

刺激:任何刺激学习者行为以引起反应的尝试都是通过应用改变所提议解决方案的决策变量的操作来建模的。应该注意的是,任何操作都可以用于刺激(改变)学习者的行为(决策变量)。在PRO算法中,以下操作用于生成新的解决方案,如方程中所述。(4)–(6)。

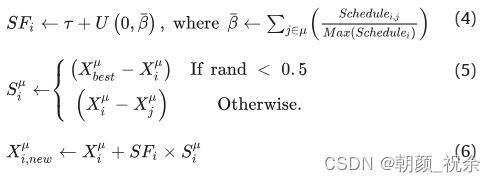

强化:为了概念化强化,我们使用以下机制来更新调度。然后应用正强化来增加特定行为的分数。学习者的目标函数,方程(7),被用作刺激阶段改善后的反应。

另一方面,当没有响应时,会应用负强化。在这种情况下,学习者的目标功能在刺激阶段后下降,导致特定行为的分数下降(方程(8))。在下一次迭代中,将选择得分较高的决策变量(行为)进行激励和强化。

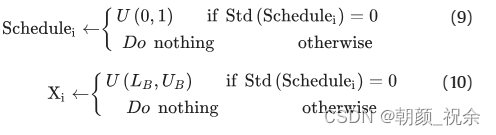

重新安排:这个概念是指在训练期间为学习者应用新计划的过程,当学习者持续接受所有行为的负强化时。在这种情况下,PRO 使用时间表的标准差 (Std) 作为指标来确定何时需要重新安排学习者。此机制通过使用方程来应用。

183

183

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?