目录

概念

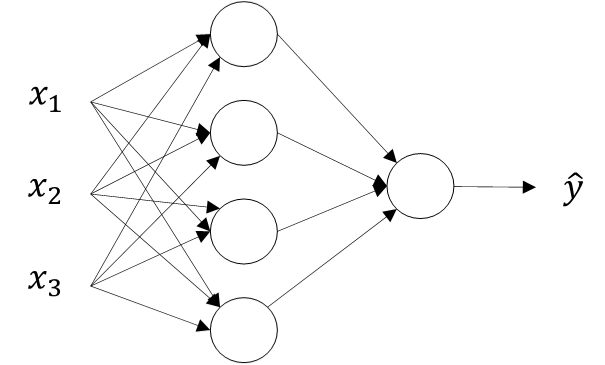

单隐藏层神经网络就是典型的浅层(shallow)神经网络,即只包含一层隐含层。

从左到右,可以分成三层:输入层(Input layer),隐藏层(Hidden layer)和输出层(Output layer)。输入层和输出层,对应着训练样本的输入和输出。隐藏层是抽象的非线性的中间层,这也是其被命名为隐藏层的原因。

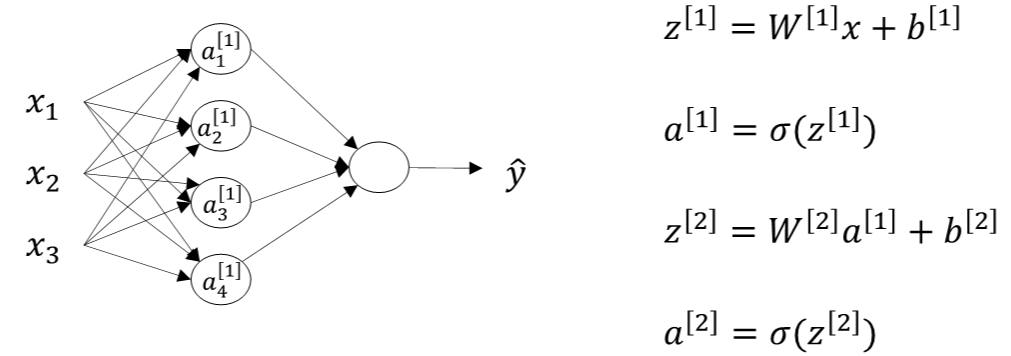

正向传播

通过输入层输入的值计算出隐含层和输出层的输出的过程,其中隐含层通过激活函数计算输出。

常用的激活函数有以下几个:

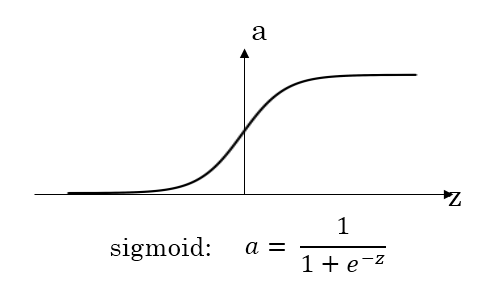

(1)sigmoid函数:二分类问题,一般选择sigmoid函数

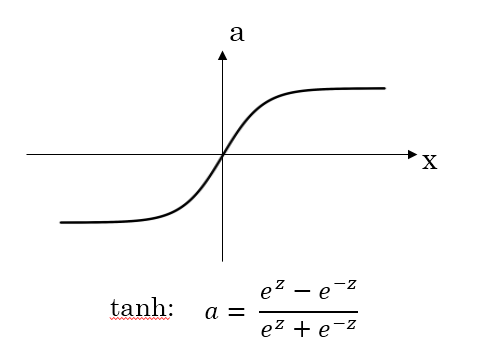

(2)tanh函数:相对于sigmoid函数来说表现要好一点,取值在【-1,1】之间,隐含层的输出就被限制在这个范围,起到了对数据归一化的操作。

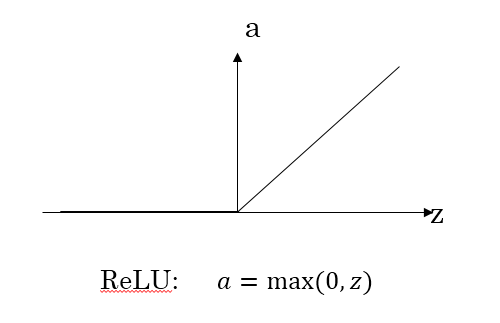

(3)LeLu函数:ReLU激活函数在z大于零时梯度始终为1;在z小于零时梯度始终为0;z等于零时的梯度可以当成1也可以当成0,实际应用中并不影响。对于隐藏层,选择ReLU作为激活函数能够保证z大于零时梯度始终为1,从而提高神经网络梯度下降算法运算速度。

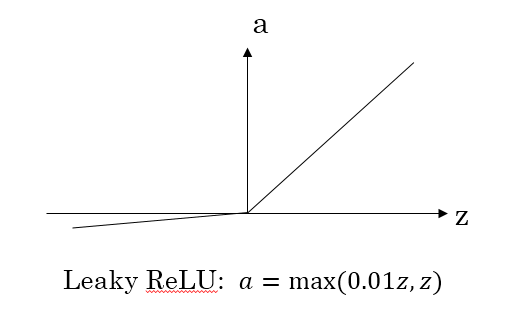

(4)Leaky ReLU函数

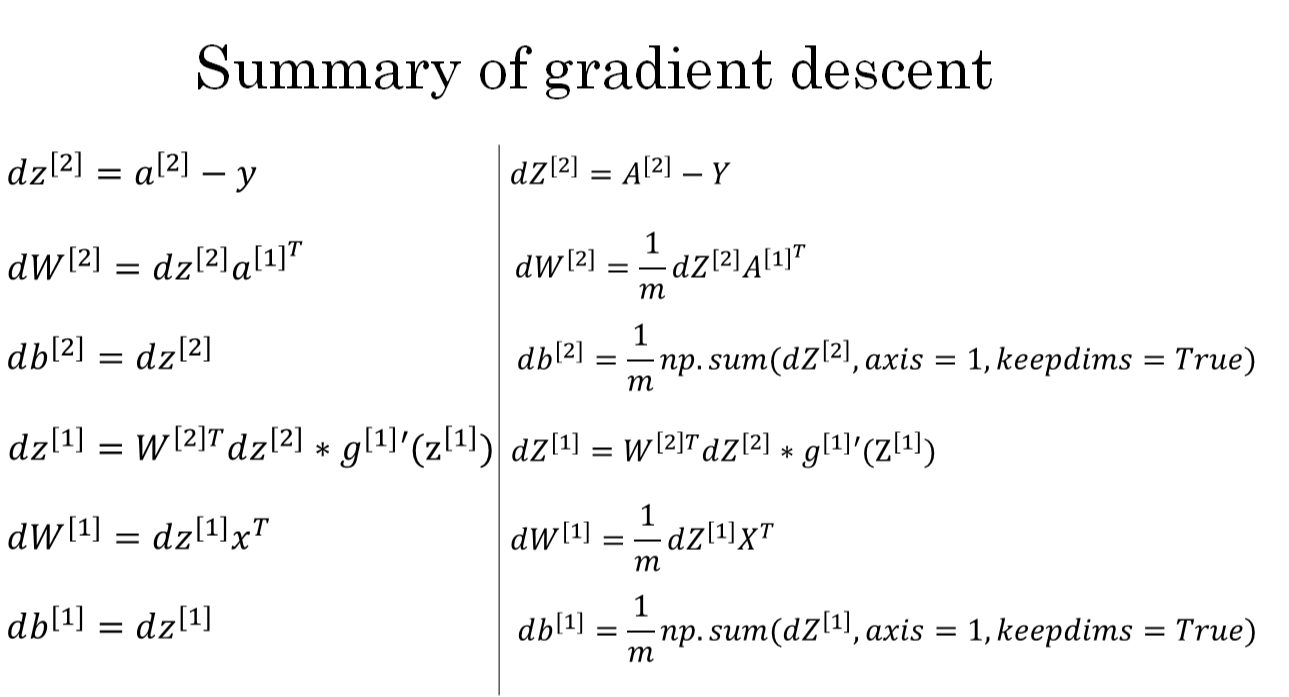

反向传播

反向传播主要是通过梯度下降法来改变权值和阈值的过程,梯度就是求导的意思

注意:神经网络模型中的参数权重W是不能全部初始化为零的,b可初始化为0

1334

1334

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?