目录

Tittle:3D Dilated Multi-Fiber Network for Real-time Brain Tumor Segmentation in MRI

轻量化网络节省计算开销的相关概念补充

深度可分离卷积

使用深度可分离卷积可以在准确率小幅下降的前提下,大大的减少模型的参数量和运算量。在实践当中常使用深度可分离卷积来代替普通卷积来轻量化网络,从而减少计算的开销

DW卷积(Depthwise Conv)

传统卷积和DW卷积对比图如下:

在传统卷积中,比如一个输入特征矩阵深度为3,我们使用4个卷积核进行卷积,并且每个卷积核的深度都与输入特征矩阵的深度是一致的,然后输出特征矩阵的深度是由卷积核的个数所决定的,图中采用了4个卷积核所以输出特征矩阵的深度就为4。

而在DW卷积中,每个卷积核的深度都是为1的,在DW卷积中每一个卷积核只负责对输入特征矩阵的一个通道进行卷积,然后再得到相应的输出特征矩阵的一个通道。因此卷积核的个数等于输入特征矩阵通道数也等于输出特征矩阵的通道数。

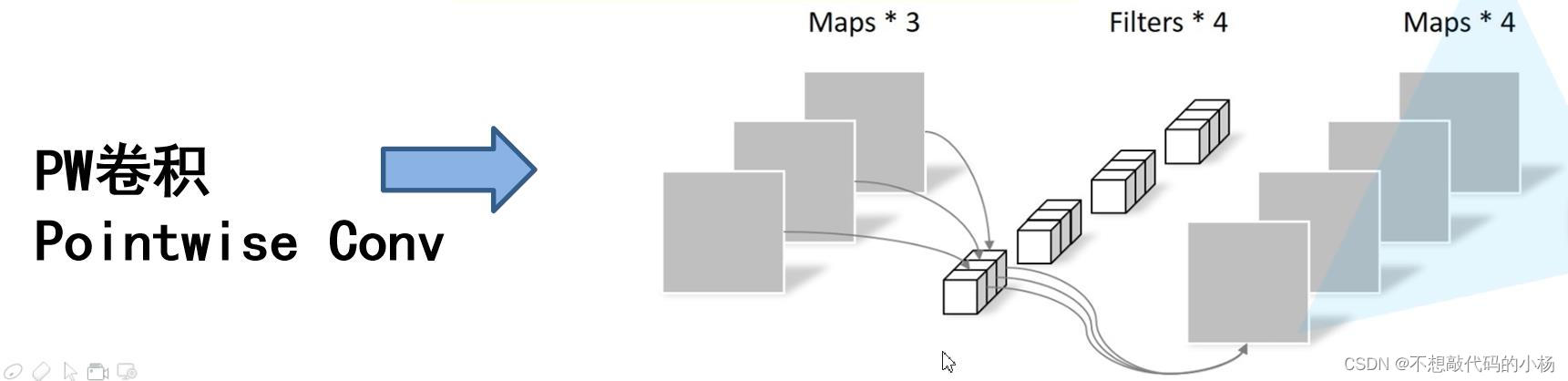

PW卷积(Pointwise Conv)

PW卷积的示意图如下所示:

PW卷积其实就是普通的传统卷积,只不过其卷积核的大小等于1而已。从上图中可以看出每一个卷积核的深度同样与输入特征矩阵的深度相同,然后输出矩阵的深度与卷积核的个数相同

DW卷积+PW卷积就是深度可分离卷积

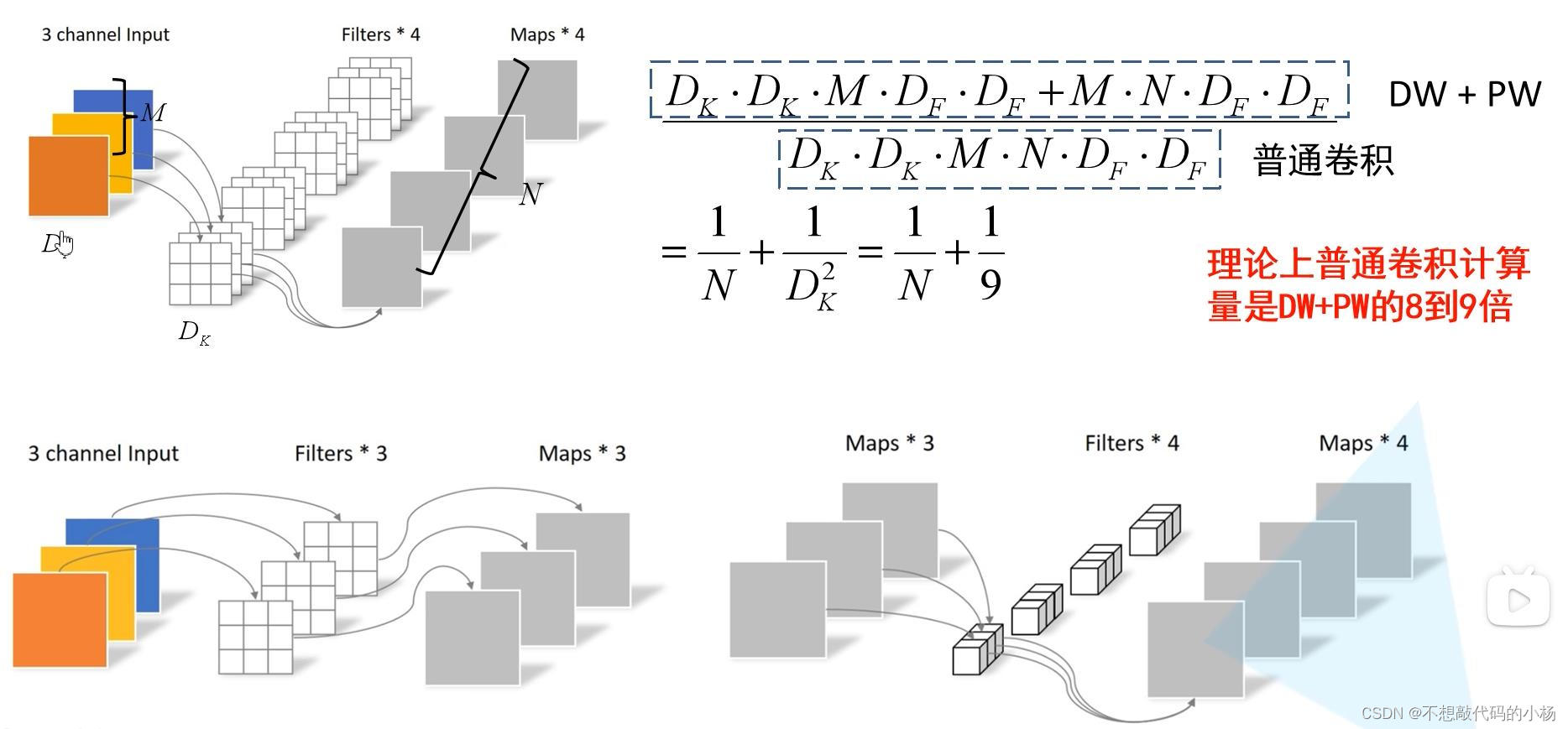

普通卷积和深度可分离卷积计算量对比

普通卷积的计算如下

图中的DF代表的是输入特征矩阵的高和宽,DK代表的是卷积核的高和宽。M代表的是输入特征矩阵的深度,N代表的是输出矩阵的深度

所以对于普通卷积的计算量=DK(卷积核的高)*DK(卷积核的宽)*M(输入特征矩阵的深度也就是卷积核的深度)*N(卷积核的个数)*DF(输入特征矩阵的高)*DF(输入特征矩阵的宽)--得到的就是普通卷积的计算量。

而对于深度可分离卷积的计算量来说=DW卷积的计算量+PW卷积的计算量

DW卷积的计算量=DK(卷积核的高)*DK(卷积核的宽)*M(一个卷积核只负责对输入特征矩阵的一个通道处理所以乘以的M是输入特征矩阵的深度)*DF(输入特征矩阵的高)*DF(输入特征矩阵的宽)

PW卷积的计算量=1*1(在PW卷积中卷积核的尺寸为1)*M(输入特征矩阵的深度也就是卷积核的深度)*N(卷积核个数)*DF*DF----PW卷积其实和传统的卷积类似只是其尺寸为1*1

经过对比传统卷积的计算量约是深度可分离卷积的8到9倍

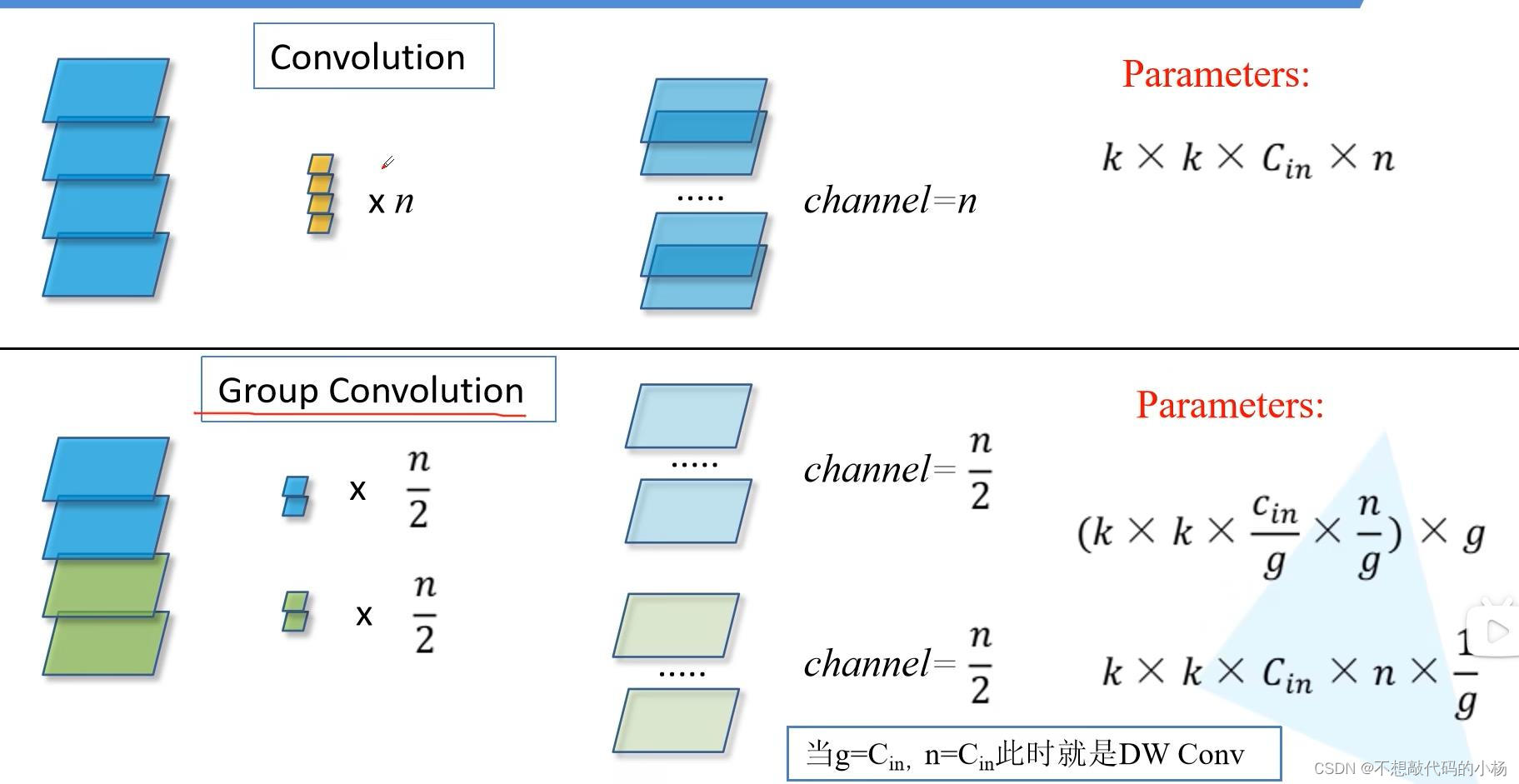

组卷积

普通卷积和组卷积的对比图如下:

普通卷积前面已经叙述过,固在此不再叙述

普通卷积的计算量=k(卷积核的高)*k(卷积核的宽)*Cin(输入特征矩阵的深度也等于卷积核的通道数)*n(卷积核个数)

对于组卷积:假设将输入特征矩阵的channel划分为2个组,然后对于每个组分别进行卷积操作。因此组卷积的计算量=k*k*Cin/g(这里的g是将Channel分为了g组)*n/g(指的是卷积核的个数)*g(总共有g个组)=k*k*Cin*n*1/g--可知使用组卷积的计算量是使用普通卷积的1/g

并且当g=Cin,n=Cin此时组卷积就是DW卷积

Tittle:3D Dilated Multi-Fiber Network for Real-time Brain Tumor Segmentation in MRI

Abstract--摘要

3D U-Net和V-Net采用3D卷积来捕获相邻Patch之间的相关性,但是由于使用了3D卷积导致了计算成本很高(而本文考虑解决的问题是降低3D网络的计算开销)

本文提出利用一组轻量级3D卷积网络组成的3D多纤维单元来显著降低计算成本,此外3D扩张卷积可用于构建多尺度的特征表示。

Introduction

尽管诸如FCN,U-Net等模型在脑肿瘤分割任务上表现不俗但是这些基于2D CNN的方法忽略了关键的3D空间上下文,因为大多数临床数据都是3D的。因此存在着将U-Net推广到3D上的例子,即2D 卷积-->3D 卷积。2D 池化-->3D池化。

本文提出的网络为3D扩张多纤维网络称为DMFNet,它建立在多纤维单元基础上,这个单元使用有效的组卷积,并引入了加权3D空洞卷积用于获得分割多尺度表示。

Method-方法

扩张多纤维单元(DMF单元)

组卷积是加速模型训练,轻量化网络防止过拟合的常用方法。虽然组卷积可以减少参数的数量,但简单的将常规卷积替换成组卷积可能会影响通道之间的信息交互能力并最终损害模型整体的学习能力。在本文中使用自适应加权扩张卷积扩展多纤维单元来捕获多尺度特征。

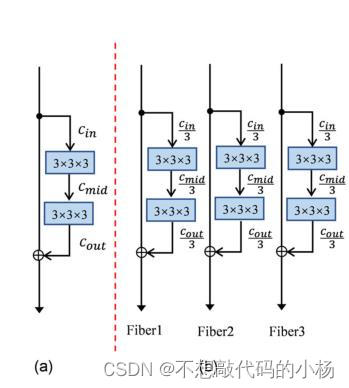

通道分组

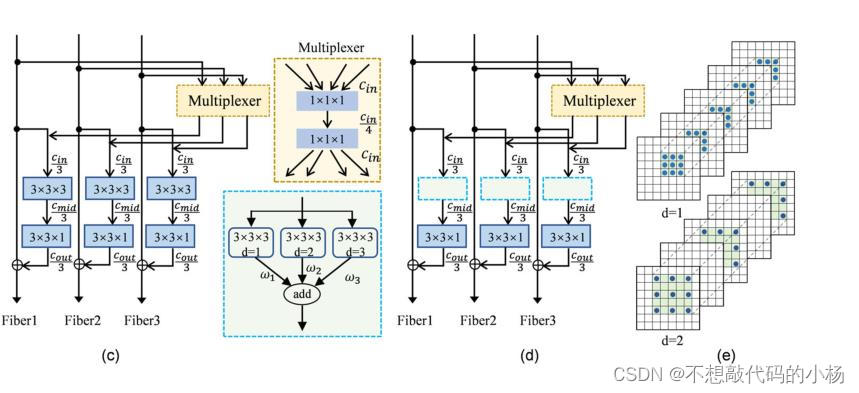

通道分组的想法是借鉴于组卷积,考虑将卷积通道拆分为多个组,可以减少特征图和内核之间的连接从而显著减少参数,其结构如图所示

常规的残差单元被分组为g个平行的残差单元称为纤维 ,在上图中被分为了3个纤维。应用组卷积的原理节省了计算开销。

复用器

为了促进不同纤维之间的信息交换,被称为多路复用器的1*1*1卷积用于不同纤维之间的信息路由。复用器由两个1*1*1的卷积组成,输入通道首先被压缩为Cin/4,然后膨胀到Cin。

使用扩张卷积的纤维

使用扩张卷积来捕获多尺度3D空间相关性,3个扩张纤维由3个3D扩张卷积分支组成,并为这三个分支分配了3个不同的权重,然后再让他们相加,这种加权和策略有助于从不同的视野选取最有价值的信息。其结构图如下所示:

在图中的(c)被称为 MF多纤维单元,图中的(e)被称为DMF扩张多纤维。

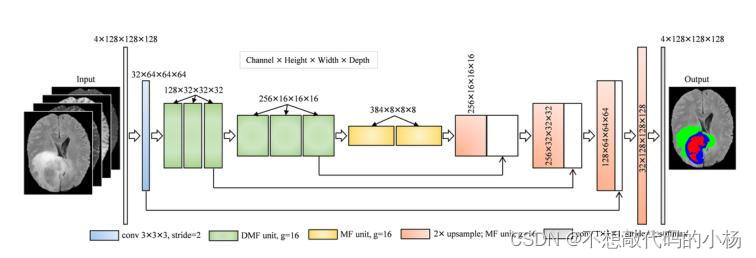

DMFNet网络架构

网络使用MF多纤维单元和DMF扩张多纤维单元作为网络的基本模块

网络在特征编码阶段,在前六个编码单元中应用DMF单元来实现多尺度表示,这得益于扩张卷积中不同大小的感受野。在解码阶段,来自编码器的高分辨率的特征与上采样特征相连接,采用三线性插值对特诊图进行上采样。此外在MF/DMF单元的每个卷积操作之前执行BN和Relu。

814

814

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?