FEDERATED OPTIMIZATION IN HETEROGENEOUS NETWORKS

算法

FedPro可以看作为FedAvg的通用化和重新参数化。

虽然FedAvg在异质性环境中取得了经验上的成功,但它并没有完全解决与异质性相关的潜在挑战。在系统异质性的背景下,FedAvg不允许参与设备根据其底层系统约束执行可变数量的本地工作;相反,简单地丢弃在指定时间窗口内无法计算E epochs的设备是常见的(Bonawitz等人,2019)。从统计角度来看,FedAvg在数据在设备间分布不一致的情况下存在经验差异(例如,McMahan等人,2017年,第3节)。不幸的是,在这种现实情况下,FedAvg很难从理论上进行分析,因此缺乏收敛性保证来表征其行为(详见第2节)。

FedProx通过增加一个近端项来缓解统计异构。(个人理解)

启发点:我们的不相似性描述是受求解线性方程组的随机卡兹马兹方法的启发(卡兹马兹,1993;Strohmer & V ershynin, 2009),类似的假设已被用于分析其他情况下SGD的变体(参见,例如,Schmidt & Roux, 2013;V aswani等,2019;Yin等人,2018)。我们提出的框架为异构联邦网络的优化提供了更好的鲁棒性和稳定性。

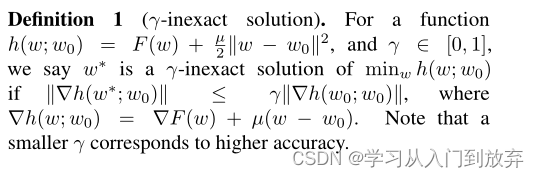

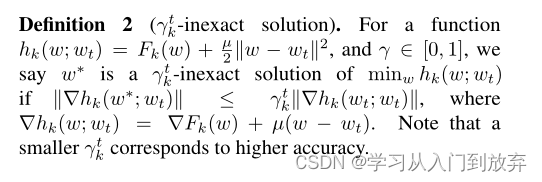

不精确性两个定义

这个是关于这个γ不精确的定义,定义1规定一个函数h,等于目标函数加近端项。如果带入ω星的h梯度的范数小于或等于γ乘以代入ω的h梯度的范数,则称这个h的最小值的γ不精确解为ω星。定义2是定义1的拓展,定义1中γ是一个统一的值,但是定义2中γ是一个变化的值,为不同设备和不同迭代,提供可变的γ。

收敛分析定义了B-局部差异,其允许统计异构性,为独立同分布假设下有界差异的推广。 如果这个期望小于或等于后面这个式子,那么就称Fk在ω为B-局部差异。当所有局部函数相同时,B(w)=1,其余B>1。B(w)越大,局部函数越不相似。

要求定义3中的差异有界,可得到收敛性分析用到的正式差异假设。精度过高会导致过拟合;虽然联邦学习不是IID样本,但并非完全无关。据此合理假设局部函数间的差异有界。

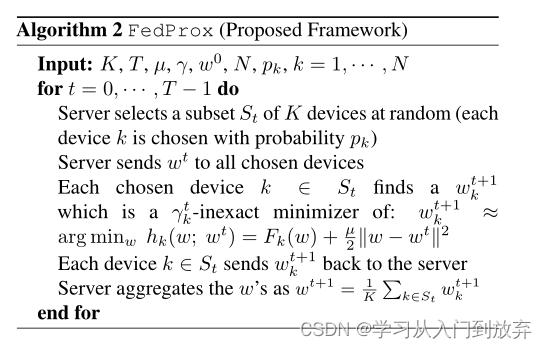

输入:K:参与训练客户端总数,T:通信轮次,μ:超参数

步骤与FedAvg类似,一样的中心服务器有一个初始化模型,然后把模型分发给选择的客户端,只是客户端在做迭代时多了近端项。(个人理解)

试验

首先是数据集,一部分是人造数据集,采用了与Shamir等人(2014)类似的设置,并增加设备异构性,其中α控制局部模型间差异,β控制局部数据间差异。另一部分是真实数据集,一个是MNIST,它是一个手写体数字的图片数据集,FEMNIST数据集,是专门给联邦学习用的基准数据集leaf的成员之一,Shakespeare是来自莎士比亚全集的一个数据集,sent140是来自Sentiment140 的推文的数据集。

1.人工合成数据集

详细见原文的附录C.1。(这个后来好像是收入了leaf也成为广泛认可的一个数据集了)

α控制本地模型之间的差异,β控制每个设备上的本地数据与其他设备上的数据的差异。

2.真实数据集

MNIST和FEMNIST(凸):为了施加统计异质性,将数据分布到1000个设备中,这样每个设备只有两位数的样本,每个设备的样本数量遵循幂定律。

Shakespeare和Sent140(非凸):关于Shakespeare,剧中每个会说话的角色都与不同的设备相关联。数据集、模型和工作负载的详细信息见附录C.1。考虑使用LSTM分类器对来自Sentiment140 (Go等人,2009)(Sent140)的推文进行文本情感分析任务,其中每个推特账户对应一个设备。

3.实施

评价指标:轮次

有比较不同数据集的效果,μ取值对收敛的影响,比较FedAvg和FedProx的效果(FedProx µ=0的方法对应于FedAvg)。

有阅读大佬更加详细的笔记【联邦学习论文阅读】FedProx(2018)Federated Optimization in Heterogeneous Networks

4.实验结果

(内容非全原文翻译)看第一行,橙色的线几乎被粉色的线覆盖,说明μ=0且0%落后设备时的FedProx等同于FedAvg,验证了它前面提出的算法的特殊情况;再看每一列,粉色的线要比橙色的线更加平稳,且落后设备越多,橙色的线波动越大,说明系统异构性越大,联邦平均算法的收敛性越差,相比之下FedProx的收敛性更好,与放弃受限设备相比,聚合受限设备有利于更快更稳定的收敛;对比每一张图中的蓝色和粉色的线,可以发现论系统异构性如何,适当的μ可以提高稳定性,使有点发散的地方收敛,在大多数情况下μ>0的准确性更高(特别是高度异构环境中)。

(内容非全原文翻译)研究了超参数μ的影响

第一行:在不存在系统异构的情况下,统计异构性对收敛的影响(固定E=20);四个图像的用的合成数据集的统计异质性从左到右是递增的上,可以看出来,随着数据异构性的增加,μ=0(FedAvg)收敛性变差,而μ>0可帮助解决此问题;第二行:使用B-局部差异度量方法(可衡量统计异构性),观察每个设备上的梯度变化;增加近端项会减小局部函数间差异性;差异度量与训练损失趋势一致,异构性越小,收敛性越好,进一步说明可通过设置μ来改进收敛性。(这个γ不精确的定义里面的γ它开源代码里面好像是随机取的,emmm个人感觉作用可能不大)

(内容非全原文翻译)这个其实就是想说明一个现象,改变μ可以得到更好的收敛效果,但是原文自己也写道没有找到数学理论可以得出如何找到可以让收敛效果最好的μ值。

1165

1165

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?