Federated Optimization in Heterogeneous Networks

1. 论文信息

- 论文题目: Federated Optimization in Heterogeneous Networks

Fedprox算法,plato小项目跑通并理解 - 作者:Tian Li, Anit Kumar Sahu, Manzil Zaheer, Maziar Sanjabi, Ameet Talwalkar, Virginia Smith

- 发表:Proceedings of Machine learning and systems, 2020

2. introduction

- 背景:联邦学习下,统计异构性和系统异构性问题亟待解决

- 挑战:高度的系统和统计异构性

- 解决的问题:

- 系统异构性(Systems Heterogeneity): 联邦学习中的设备(本地参与方)具有显著的系统特性差异。包括硬件配置、计算能力、网络速度等方面的差异。

- 统计异构性(Statistical Heterogeneity): 联邦学习中的数据在网络中的不同设备上分布不同(Non-IID)

- 贡献点:

- 提出FedProx算法

- 在目标函数中引入近端项,提高方法的稳定性

- 通过有界不相似假设在理论上证明收敛分析

- 通过实验证明了FedProx在异构网络中的优越性

3. 问题描述:System model/架构/对问题的形式化描述

4. 解决方法

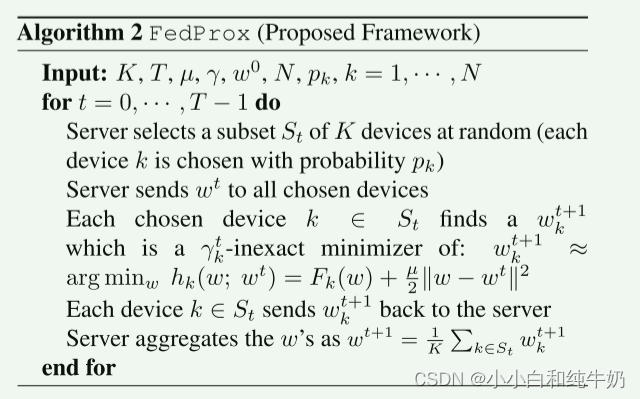

- 执行流程:

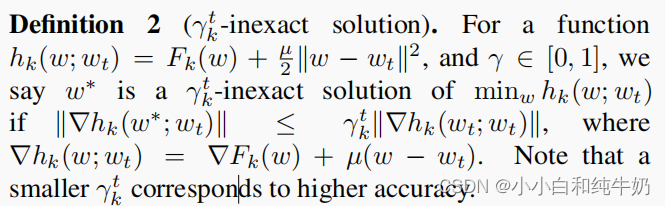

- 挑战问题怎么解决:

- 通过允许不经精确解w*解决FedAvg中轮次E固定引起设备不同算力下存在的掉队者问题,解决系统异构性

- 加入近端项保证局部训练模型不偏离全局模型过远,解决统计异构性

- 性能保证(performance guarantee):有界不相似假设(没看懂)

5. 效果:

- 实验设置:

-

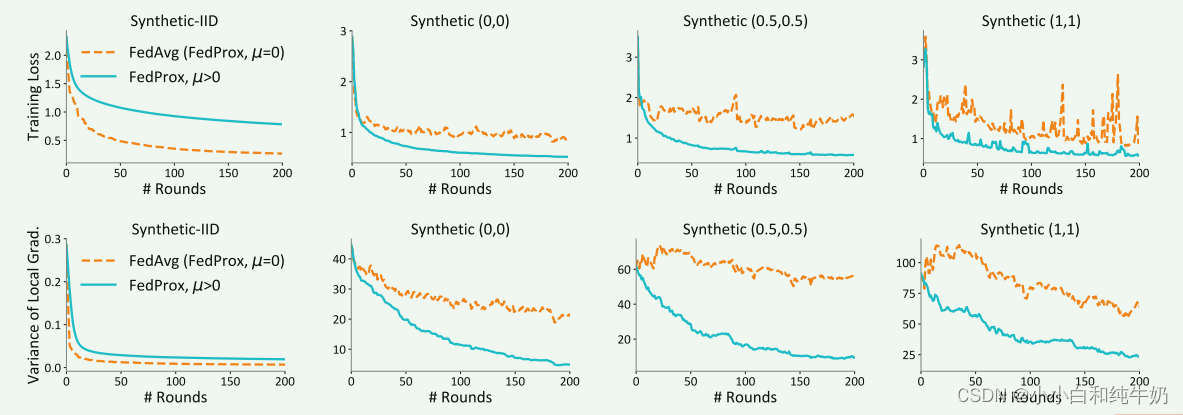

系统异构性:实验设定了局部迭代轮次E=20,再将低于E的轮次随机的分配0%,50%,90%的客户端。

-

统计异构性:规定固定的迭代轮次E(保证系统不异构)

-

影响收敛性的关键参数为:局部迭代轮数E,是否加入近端项𝜇≠0

- 对比实验 :FedProx在FedAvg的基础上改进,当u=0时就退化为FedAvg,以上两个实验就是在与FedAvg对比

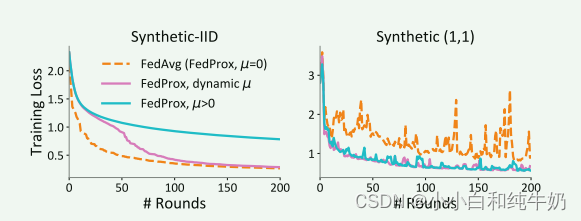

- 超参数确定实验

对于IID数据集,µ从1开始,对于其他Non-IID数据集,µ从0开始(这样的初始化对FedProx是不利的)。当连续5轮损失减少时,减少0.1µ,损失增加时,增加0.1µ。

一个大的μ 会迫使更新接近起始点,减缓收敛速度,小的μ 可能不会产生任何影响。

6. (备选)自己的思考:

论文对你的启发,包括但不限于解决某个问题的技术、该论文方法的优缺点、实验设计、源码积累等。

了解了什么叫基线

7377

7377

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?