### 回答1:

CGAN,全称为Conditional Generative Adversarial Networks,是一种在生成对抗网络(GAN)的基础上进行优化的算法,它可以根据传入的条件信息来生成特定类型的数据。在这个算法中,生成器和判别器都会接收一个额外的条件输入参数。

TensorFlow是一个广泛使用的深度学习框架,它提供了各种各样的函数和类来简化CGAN模型的实现过程。以下是一个使用TensorFlow实现CGAN的代码示例:

```

import tensorflow as tf

import numpy as np

# 定义生成器和判别器的输入形状

noise_dim = 100

label_dim = 10

# 定义生成器的函数

def make_generator_model():

model = tf.keras.Sequential()

model.add(tf.keras.layers.Dense(256, input_dim=noise_dim + label_dim, activation='relu'))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Dense(512, activation='relu'))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Dense(28 * 28 * 1, activation='sigmoid'))

model.add(tf.keras.layers.Reshape((28, 28, 1)))

return model

# 定义判别器的函数

def make_discriminator_model():

model = tf.keras.Sequential()

model.add(tf.keras.layers.Flatten(input_shape=(28, 28, 1)))

model.add(tf.keras.layers.Dense(512, activation='relu'))

model.add(tf.keras.layers.Dense(256, activation='relu'))

model.add(tf.keras.layers.Dense(1, activation='sigmoid'))

return model

# 定义损失函数

cross_entropy = tf.keras.losses.BinaryCrossentropy(from_logits=True)

def discriminator_loss(real_output, fake_output):

real_loss = cross_entropy(tf.ones_like(real_output), real_output)

fake_loss = cross_entropy(tf.zeros_like(fake_output), fake_output)

total_loss = real_loss + fake_loss

return total_loss

def generator_loss(fake_output):

return cross_entropy(tf.ones_like(fake_output), fake_output)

# 定义优化器

generator_optimizer = tf.keras.optimizers.Adam(1e-4)

discriminator_optimizer = tf.keras.optimizers.Adam(1e-4)

# 定义训练过程

@tf.function

def train_step(images, labels):

noise = tf.random.normal([batch_size, noise_dim])

with tf.GradientTape() as gen_tape, tf.GradientTape() as disc_tape:

fake_labels = tf.random.uniform([batch_size, 1], maxval=label_dim, dtype=tf.int32)

fake_labels = tf.one_hot(tf.reshape(fake_labels, [-1]), label_dim)

generated_images = generator(tf.concat([noise, fake_labels], axis=1), training=True)

real_output = discriminator(tf.concat([images, labels], axis=1), training=True)

fake_output = discriminator(tf.concat([generated_images, fake_labels], axis=1), training=True)

gen_loss = generator_loss(fake_output)

disc_loss = discriminator_loss(real_output, fake_output)

gradients_of_generator = gen_tape.gradient(gen_loss, generator.trainable_variables)

gradients_of_discriminator = disc_tape.gradient(disc_loss, discriminator.trainable_variables)

generator_optimizer.apply_gradients(zip(gradients_of_generator, generator.trainable_variables))

discriminator_optimizer.apply_gradients(zip(gradients_of_discriminator, discriminator.trainable_variables))

# 进行训练

EPOCHS = 100

batch_size = 128

generator = make_generator_model()

discriminator = make_discriminator_model()

for epoch in range(EPOCHS):

for i in range(train_images.shape[0]//batch_size):

images = train_images[i*batch_size:(i+1)*batch_size]

labels = train_labels[i*batch_size:(i+1)*batch_size]

train_step(images, labels)

# 生成一些带有特定标签的图像

noise = tf.random.normal([10, noise_dim])

cond_labels = np.eye(label_dim)[np.arange(10)]

generated_images = generator(tf.concat([noise, cond_labels], axis=1), training=False)

```

上面的代码中,我们定义了生成器和判别器的模型结构和优化器。在训练过程中,我们使用TensorFlow的`GradientTape`记录损失函数的梯度,并根据反向传播算法来更新模型的参数,最终得到一个可以生成特定标签图像的CGAN模型。

### 回答2:

CGAN是一种生成对抗网络,可以用来生成符合特定条件(如标签)的图像。 Tensorflow作为一款流行的神经网络框架,可以实现CGAN网络。本文将介绍如何使用tensorflow实现CGAN的简单示例代码。

首先,我们需要准备数据集和标签。这里我们以MNIST手写数字数据集为例,选择其中的数字4和9作为我们的标签。我们使用tensorflow内置的MNIST数据集,然后创建两个新的数据集,一个只包含数字4的图片,另一个只包含数字9的图片。

接下来,我们需要编写CGAN网络的模型。我们假设生成器和判别器都是以卷积神经网络作为基础。

生成器是一个卷积神经网络,输入为一个噪声向量和标签,输出为一个28x28的图像。为了获得更好的效果,我们采用了ResNet的结构。

判别器是另一个卷积神经网络,输入为一个28x28的图像和标签,输出为一个二元值,表示输入是否是真实的图像。同时,我们也采用了ResNet的结构来提高判别器的性能。

我们将生成器和判别器组合起来,并使用交叉熵损失函数来优化网络的性能。

最后,我们需要编写训练代码,对生成器和判别器进行训练。我们使用Adam优化器,对损失函数进行优化,并将生成的图像保存在本地文件夹中。

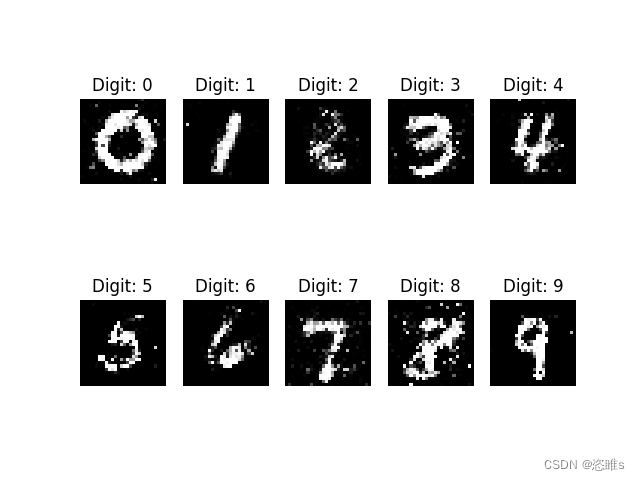

在运行训练代码之后,我们可以得到生成器生成的样本图像,观察生成的图像是否符合我们的标签条件,以此来评估CGAN网络的性能。

以上就是使用tensorflow实现CGAN网络的简单示例代码,该代码可以用于生成符合特定条件的图像。当然,如果要应用到更复杂的数据集和场景中,需要对代码进行相应的修改和优化。

### 回答3:

CGAN是一种深度学习模型,它能够生成新的图像数据,同时还能对生成图像的样式进行控制。在TensorFlow中实现CGAN的代码实例如下:

首先,需要加载一些必要的库,如numpy,matplotlib和tensorflow:

import numpy as np

import matplotlib.pyplot as plt

import tensorflow as tf

接着,定义生成器和判别器网络。生成器网络将输入的随机向量转化成一张图像,而判别器网络则将输入的图像打上真或假的标签:

def generator_model():

model = tf.keras.Sequential()

model.add(tf.keras.layers.Dense(7*7*256, input_shape=(100,)))

model.add(tf.keras.layers.Reshape((7, 7, 256)))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.Conv2DTranspose(128, (5, 5), strides=(1, 1), padding='same'))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.LeakyReLU())

model.add(tf.keras.layers.Conv2DTranspose(64, (5, 5), strides=(2, 2), padding='same'))

model.add(tf.keras.layers.BatchNormalization())

model.add(tf.keras.layers.LeakyReLU())

model.add(tf.keras.layers.Conv2DTranspose(1, (5, 5), strides=(2, 2), padding='same', activation='tanh'))

return model

def discriminator_model():

model = tf.keras.Sequential()

model.add(tf.keras.layers.Conv2D(64, (5, 5), strides=(2, 2), padding='same', input_shape=[28, 28, 1]))

model.add(tf.keras.layers.LeakyReLU())

model.add(tf.keras.layers.Dropout(0.3))

model.add(tf.keras.layers.Conv2D(128, (5, 5), strides=(2, 2), padding='same'))

model.add(tf.keras.layers.LeakyReLU())

model.add(tf.keras.layers.Dropout(0.3))

model.add(tf.keras.layers.Flatten())

model.add(tf.keras.layers.Dense(1))

return model

接下来,我们定义CGAN的训练过程。由于本次训练中将会用到真实图像和生成图像,因此需要定义d_loss和g_loss,使之能够同时对真实图像和生成的图像进行优化:

@tf.function

def train_step(images, labels):

noise = tf.random.normal([BATCH_SIZE, LATENT_DIM])

with tf.GradientTape() as gen_tape, tf.GradientTape() as disc_tape:

generated_images = generator([noise, labels], training=True)

real_output = discriminator([images, labels], training=True)

fake_output = discriminator([generated_images, labels], training=True)

gen_loss = generator_loss(fake_output)

disc_loss = discriminator_loss(real_output, fake_output)

gradients_of_generator = gen_tape.gradient(gen_loss, generator.trainable_variables)

gradients_of_discriminator = disc_tape.gradient(disc_loss, discriminator.trainable_variables)

generator_optimizer.apply_gradients(zip(gradients_of_generator, generator.trainable_variables))

discriminator_optimizer.apply_gradients(zip(gradients_of_discriminator, discriminator.trainable_variables))

在定义好train_step之后,我们可以通过循环来进行训练。在每个epoch结束后,我们会将生成器生成的示例图像和损失输出到终端:

def train(dataset, epochs):

for epoch in range(epochs):

for image_batch, label_batch in dataset:

train_step(image_batch, label_batch)

display.clear_output(wait=True)

generate_and_save_images(generator, epoch + 1, test_labels)

print ('Time for epoch {} is {} sec'.format(epoch + 1, time.time()-start))

display.clear_output(wait=True)

generate_and_save_images(generator, epochs, test_labels)

train(train_dataset, EPOCHS)

最后是完整的训练代码:

1526

1526

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?