前言

本笔记基于ChatGLM-6B开源网站 https://github.com/THUDM/ChatGLM-6B 完成ChatGLM的本地部署。首先电脑已经安装python3.10,anaconda,pycharm2022.3,如若使用本地网络会出现安装依赖失败、下载代码文件缓慢等问题,解决方法有两个,一是可以使用清华源安装依赖,下载模型;二是全程使用科学上网的方法,本次部署使用的方法是后者。

电脑基本信息:

电脑系统 windows 10

CPU intel W-2235

显卡 A5000 24GB

运行 内存128GB

一、环境安装

下载ChatGLM-6B 相关文件

1.先进入 https://github.com/THUDM/ChatGLM-6B下载源文件

2.然后进入https://huggingface.co/THUDM/chatglm-6b下载模型文件,并把文件保存在E:\Rui-Wu\ChatGLM-6B-main\chatglm-6b中。

创建环境

1.创建名称为ChatGLM的环境,并且python的版本是3.10以上。

conda create --name ChatGLM python=3.10

2.查看环境是否创建成功。

conda info --envs

会出现下面的情况,表示已经创建成功

所有的操作最好在项目的根目录下进行,即所下载ChatGLM的目录下进行。比如我所在的目录是E:\Rui-Wu\ChatGLM-6B-main。通过以下代码转换目录:

1.进入E盘

e:

2.进入目录

cd E:\Rui-Wu\ChatGLM-6B-main

如下图所示:

激活环境

环境创建完成之后,通过以下代码激活环境

activate ChatGLM

激活环境过后如下图所示

检查CUDA及显卡驱动

此步骤是为了后面能够成功的安装pytorch,在安装pytorch之前都要进行显卡驱动的检查。具体版本要求可通过csdn或者nVidia控制面板查阅。可通过如下代码检查驱动:

nvidia-smi

如下图所示可以查看驱动版本以及CUDA版本,出现下面的表格,则说明电脑以及安装显卡驱动以及CUDA,然后根据CUDA版本安装合适的pytorch版本。

安装pytorch

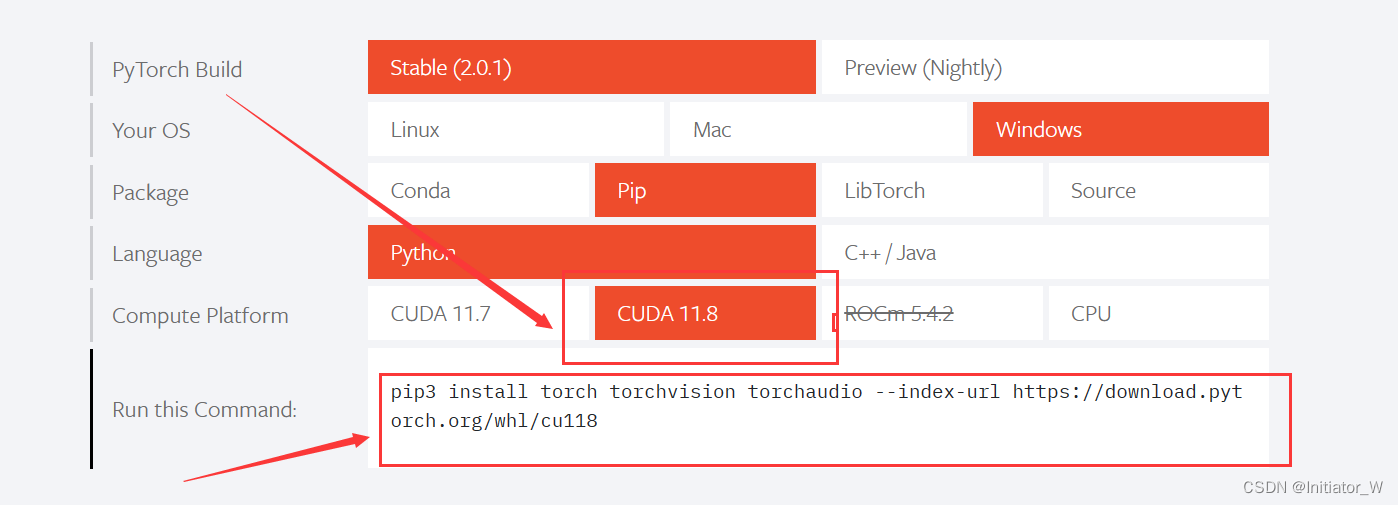

登录pytorch官网 ,如下图所示,选择合适的版本,CUDA版本要求不低于本电脑的版本即可,本次选择安装的是CUDA11.8的pytorch版本。然后复制最底下的代码,输入到anaconda中。

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

然后通过以下代码检查是否安装成功

pip list

如果出现下面的情况,则说明安装成功。后缀cu118表示cuda11.8版本的pytorch,同时也说明安装的是GPU版本的pytorch,如果安装成了CPU版本的pytorch,则后缀没有+cu118

安装依赖

通过以下代码安装ChatGLM-6B的依赖,这也是为什么要提前把目录切换到E:\Rui-Wu\ChatGLM-6B-main的原因,要不然找不到requirements.txt的文件。而且,依赖文件中的torch模块是only cpu的,因为在此之前已经安装过pytorch,所以要提前把依赖中的torch删除,如下图所示。

1.安装依赖

pip install -r requirements.txt

2.然后通过以下代码检查是否安装成功

pip list

二、网页版启动

通过anaconda启动

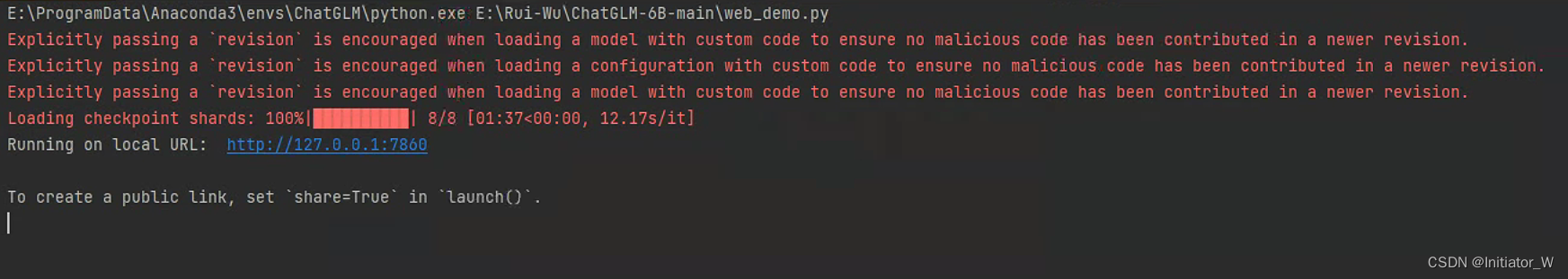

依赖中已经安装了gradio,可通过以下代码启动网页版demo。也可以通过pycharm启动,把pycharm环境改到ChatGLM以后,直接运行web_demo.py文件。(每次运行都会重新下载模型,因此启动比较慢)

python web_demo.py

如下图所示

修改模型

通过以上方法运行模型,每次都要重新下载模型文件,因此需要修改代码,以达到可以直接从本地加载模型的目的。

进入刚开始下载开源文件的文件夹打开web_demo.py文件,修改模型。如下图所示:

例如我的模型下载地址为E:\Rui-Wu\ChatGLM-6B-main\chatglm-6b,因此模型修改路径如下:

还可以按照电脑配置修改显存,如下图所示:

例如,若显存为6G

通过pycharm启动。

1569

1569

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?