1 CorED: Incorporating Type-level and Instance-level Correlationsfor Fine-grained Event Detection

论文来源:SIGIR 2022(CCF A类会议)

论文链接:https://dl.acm.org/doi/pdf/10.1145/3477495.3531956

便于理解:

1.1 摘要

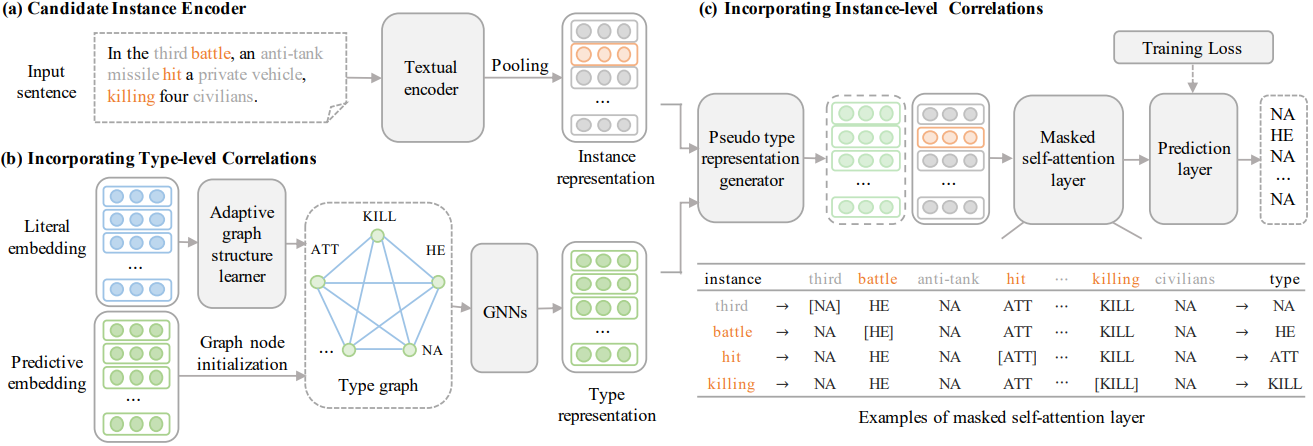

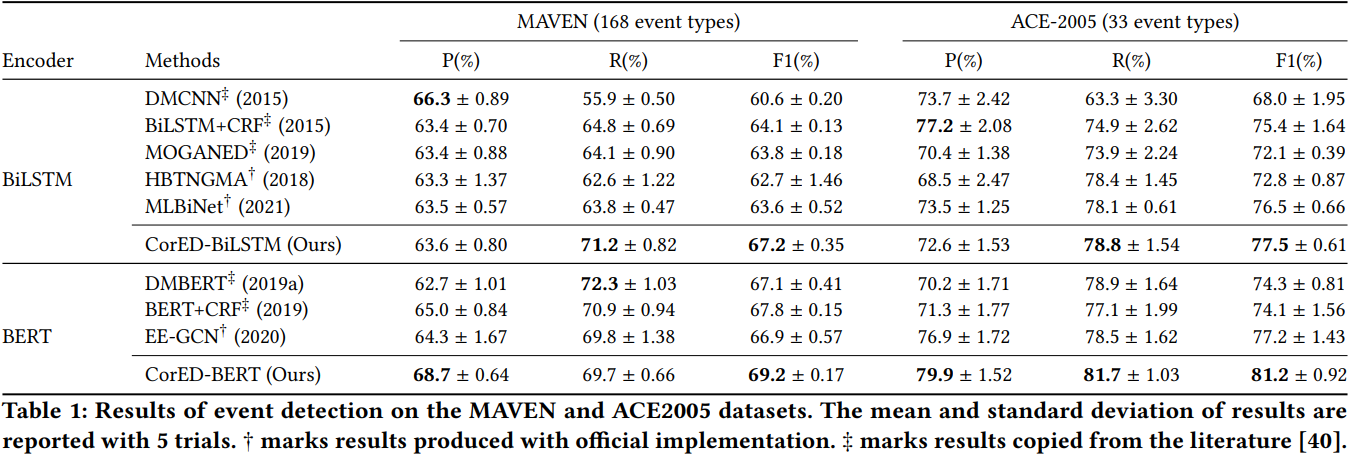

事件检测(ED)是信息抽取的一项关键任务,其目的是识别事件触发词,并将其分类为预定义的事件类型。在实际应用程序中,事件通常使用许多细粒度类型进行注释,这通常会出现long-tail类型性质和共现事件性质。现有的研究在没有充分利用的情况下探索事件相关性,这可能会限制事件检测的能力。本文同时结合类型级和实例级的事件相关性,并提出了一个新的框架,称为CorED。

具体来说,设计了一个自适应的基于图的类型编码器来捕获实例级的相关性,不仅从它们的训练数据学习类型表示,而且从它们的相关类型学习类型表示,从而导致信息更丰富的类型表示,特别是对于低资源类型。此外,设计了一个实例交互解码器来捕获实例级相关性,它预测基于上下文类型事件实例的事件实例类型,利用共现事件作为预测的显著证据。

在两个公共基准测试,MAVEN和ACE-2005数据集上进行了实验。实证结果表明,类型级和实例级相关性是统一的,模型在两个基准上都取得了有效性性能。

NA类型:没有引发任何事件类型

1.2 模型图

1.3 实验结果

2 Saliency as Evidence: Event Detection with Trigger Saliency Attribution

论文来源:ACL2022

论文链接:https://aclanthology.org/2022.acl-long.313.pdf

代码链接:GitHub - jianliu-ml/SaliencyED

便于理解:Saliency as Evidence: Event Detection with Trigger Saliency Attribution(ACL2022)_Rose sait的博客-CSDN博客

2.1 摘要

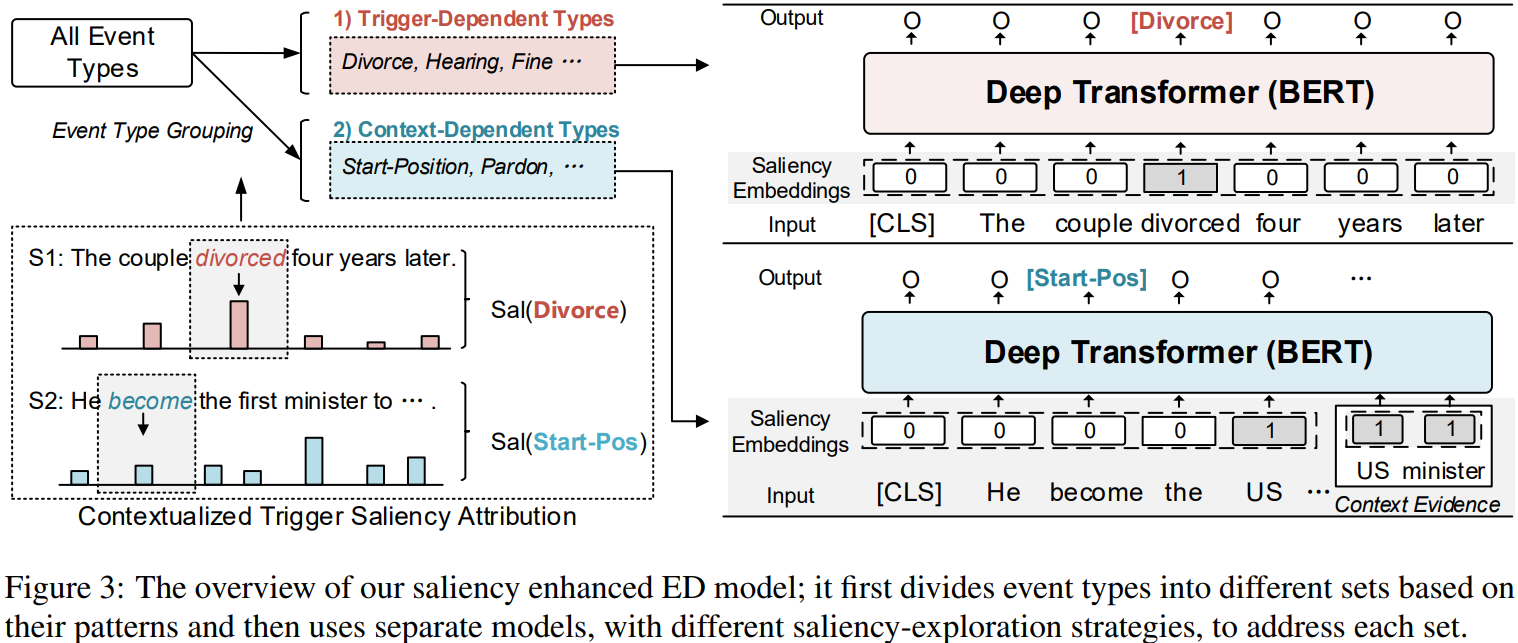

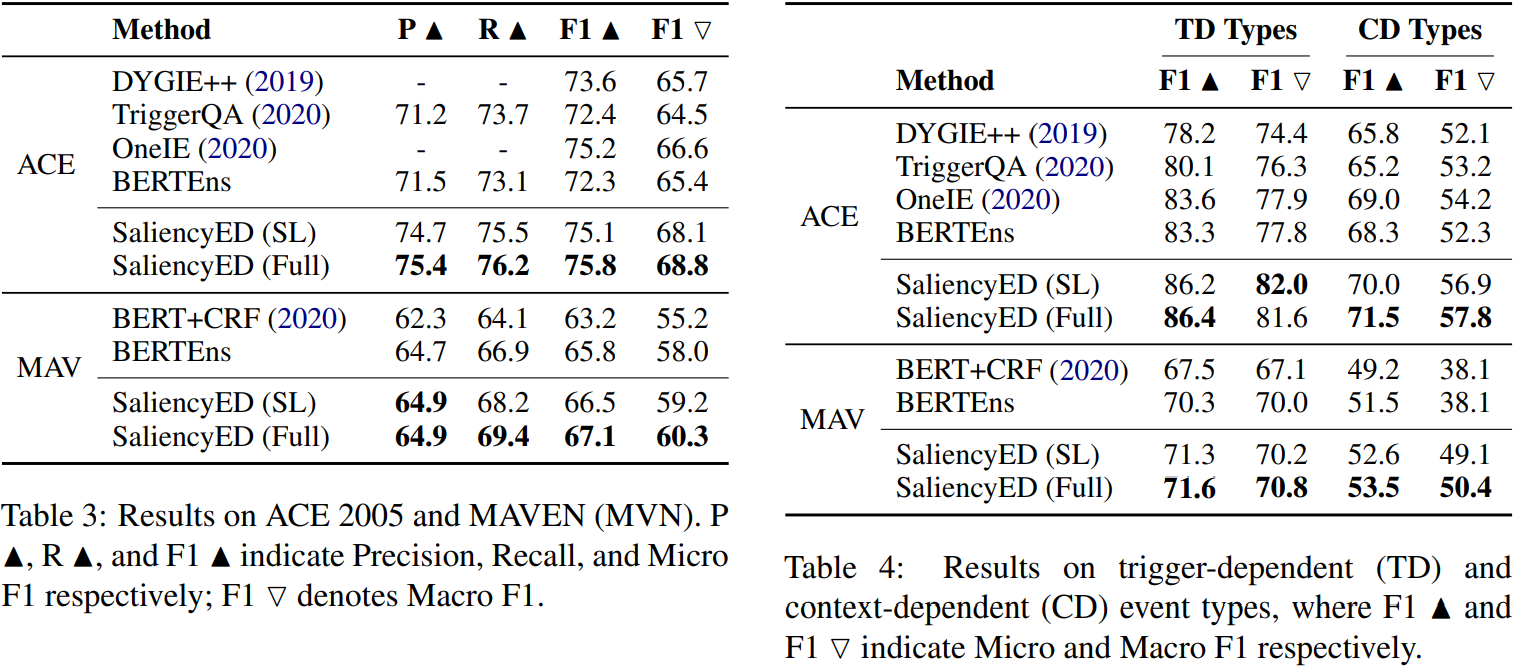

事件检测(ED)是事件提取的一个重要子任务,旨在识别文本中某些事件类型的事件触发词。尽管事件检测取得了重大进展,但现有的方法通常采用 "一个模型适合所有类型 "的方法,这种方法没有看到事件类型之间的差异,这项研究深入研究了这个问题,并提出了一个新的概念,即触发词显著性归因,它可以明确地量化事件的基本模式。在此基础上,我们为ED开发了一种新的训练机制,它可以区分依赖触发词和依赖上下文的类型,并在两个基准上取得了可喜的表现。

2.2 模型图

2.3 实验结果

3 Structured Prediction as Translation between Augmented Natural Languages

论文来源:ICLR2021

论文链接:https://arxiv.org/pdf/2101.05779.pdf

3.1 摘要

我们提出了一个新的框架,增强自然语言间的翻译(TANL),来解决许多结构化预测语言任务,包括联合实体和关系抽取、嵌套命名实体识别、关系分类、语义角色标记、事件抽取、共引用解析和对话状态跟踪。我们没有通过训练特定任务的鉴别分类器来解决这个问题,而是将其框架为增强自然语言之间的翻译任务,从中可以很容易地提取与任务相关的信息。我们的方法可以在所有任务上匹配或优于特定任务的模型,特别是在联合实体和关系抽取(CoNLL04、ADE、NYT和ACE2005数据集)、关系分类(FewRel和TACRED)和语义角色标记(CoNLL-2005和CoNLL- 2012)方面取得了新的最先进的结果。我们在对所有任务使用相同的架构和超参数来完成这一任务,甚至在训练单一模型同时解决所有任务时(多任务学习)时。最后的结果表明,我们的框架也可以在低资源环境下显著地提高性能,这得益于更好地使用标签语义的方法。

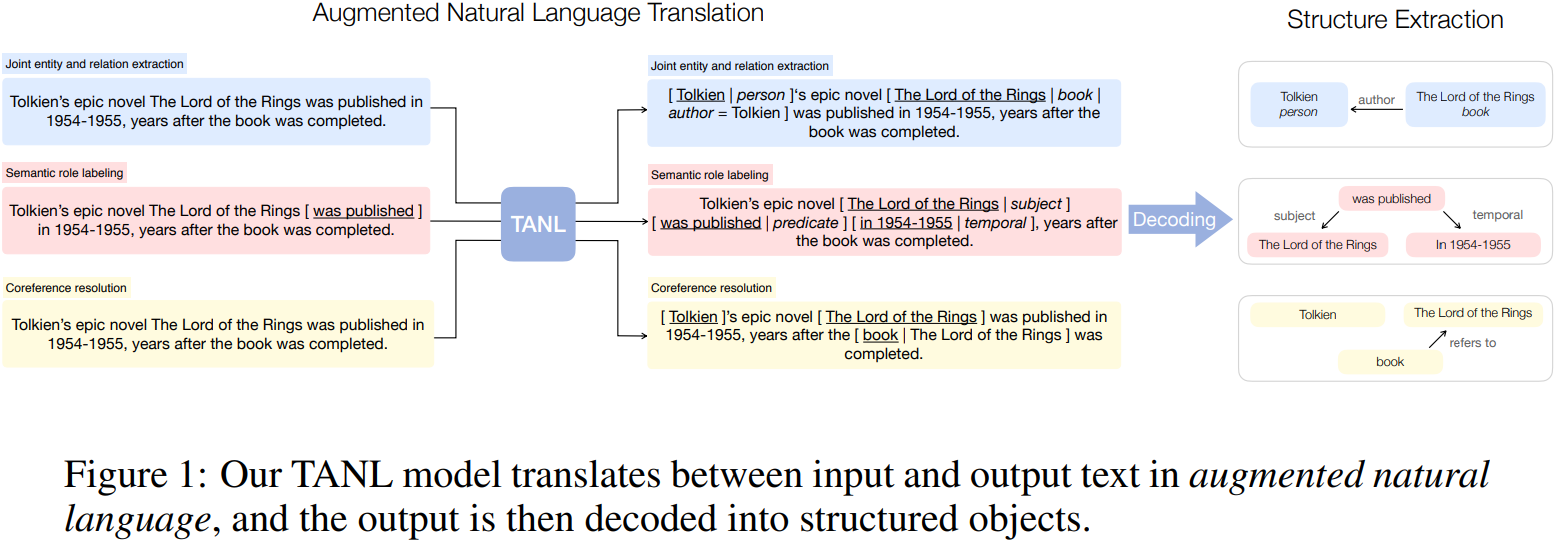

3.2 模型图

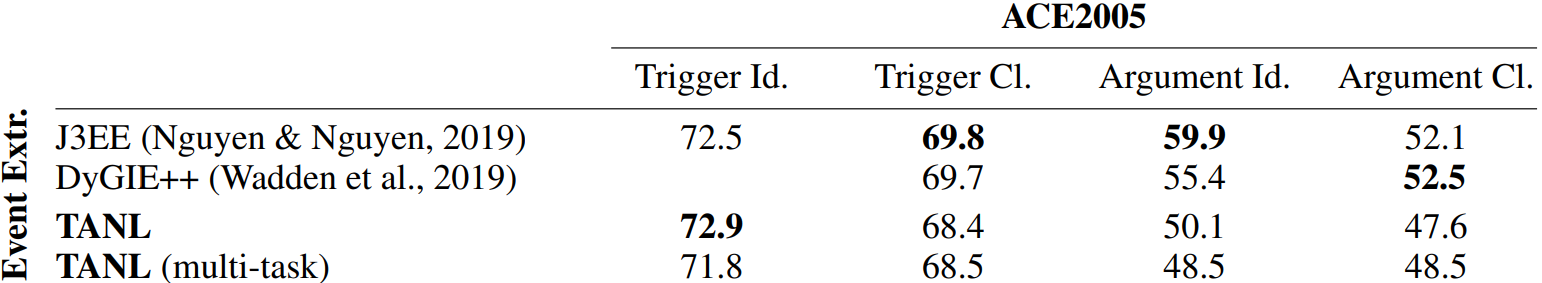

3.3 实验结果

4 Event Detection with Dual Relational Graph Attention Networks

论文来源:COLING2022

论文链接:https://aclanthology.org/2022.coling-1.219.pdf

4.1 摘要

最近的许多句子级事件检测工作都集中在丰富句子语义上,例如,通过多任务或基于提示的学习。尽管性能很好,但这些方法通常依赖于扩展标签的手动注释,或者需要领域专家来设计复杂的模板和规则。本文提出了一种新的基于对话的解释范式,以增强事件检测的句子语义。我们所说的基于对话的事件解释,是指以原始事件描述作为起始话语,通过一致的信息密集对话进行解释。我们提出了三种简单的对话生成方法,然后将其输出馈送到混合注意机制中以表征互补事件语义。在两个事件检测数据集上的大量实验结果验证了我们方法的有效性,并在基于对话的解释范式中提出了有希望的研究机会。

4.2 模型图

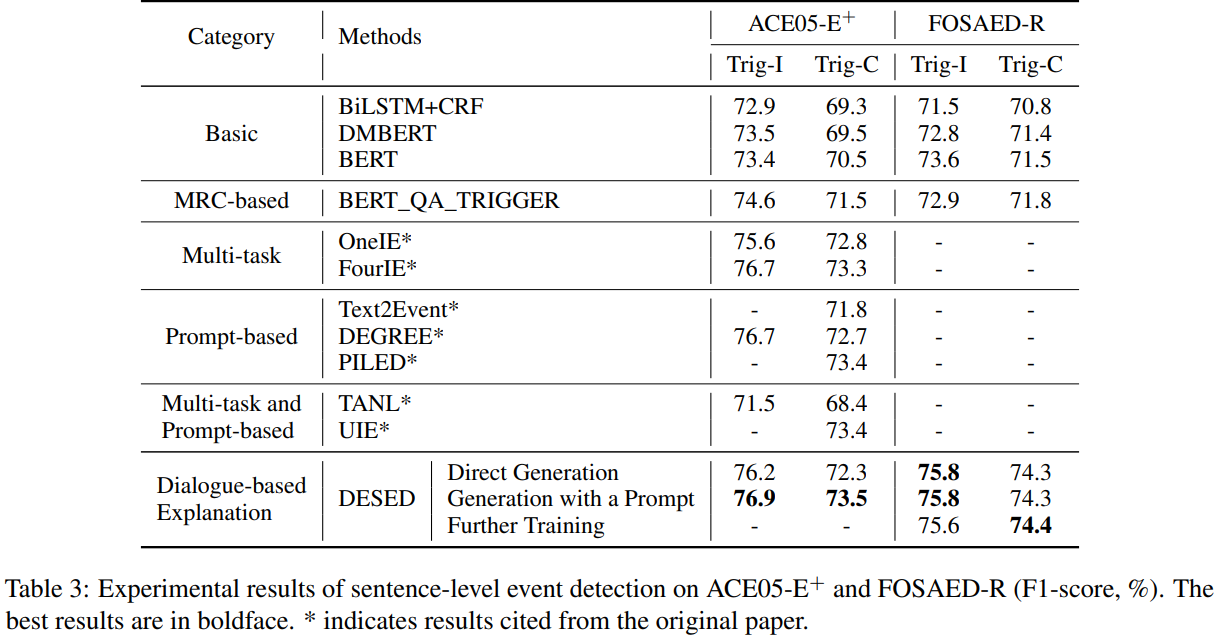

4.3 实验结果

5 KiPT: Knowledge-injected Prompt Tuning for Event Detection

论文来源:COLING2022

论文链接:https://aclanthology.org/2022.coling-1.169.pdf

代码链接:没找到

5.1 摘要

事件检测的目的是通过识别和分类事件触发器(最具代表性的单词),从文本中检测事件。大多数现有的工作严重依赖于复杂的下游网络,并且需要足够的训练数据。因此,这些模型可能在结构上是冗余的,并且在数据稀缺时表现不佳。基于提示的模型很容易构建,并且对于少量任务很有希望。然而,目前基于提示的方法由于没有引入与事件相关的语义知识(如词性、语义关联等),可能存在精度不高的问题。为了解决这些问题,本文提出了一种知识注入提示调优(KiPT)模型。具体来说,将事件检测任务表述为条件生成任务。然后,使用外部知识库构造知识注入提示,并利用提示调优策略对提示进行优化。大量实验表明,KiPT优于强基线,特别是在少量射击场景中。

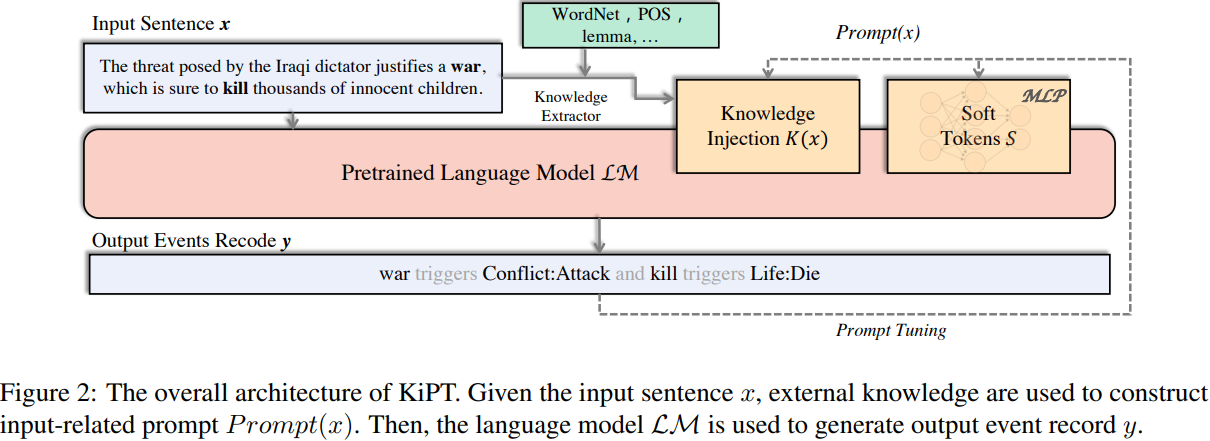

5.2 模型图

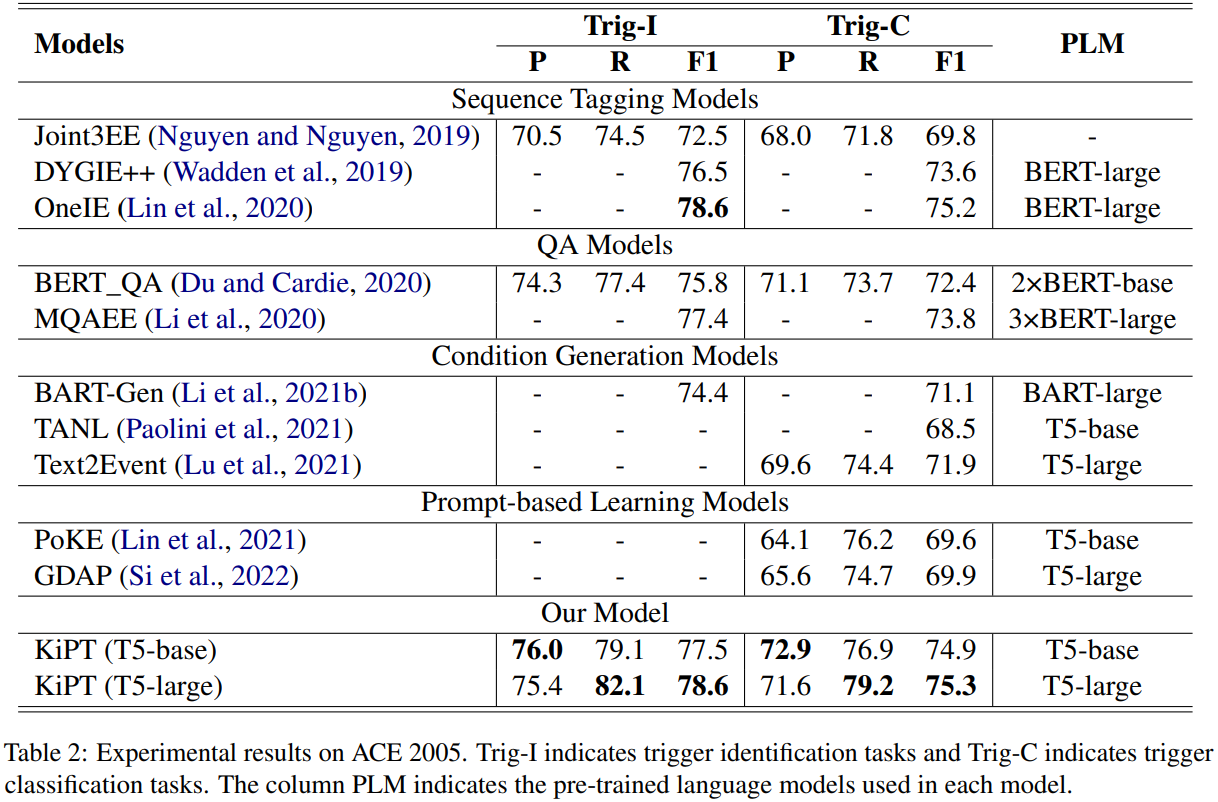

5.3 实验效果

6 Event Detection with Dual Relational Graph Attention Networks

论文来源:COLING2022

论文链接:https://aclanthology.org/2022.coling-1.172.pdf

6.1 摘要

事件检测是信息提取中的一项基本任务,其目的是从文本片段中识别特定事件类型的实例。大多数现有方法利用语法知识和一组语法关系来增强事件检测。然而,这些基于语法的方法的一个副作用是,它们可能混淆不同的语法关系,并倾向于引入冗余或噪声信息,这可能导致性能下降。为此,我们提出了一个简单而有效的模型DualGAT (Dual Relational Graph Attention Networks,双关系图注意网络),它利用句法和语义关系的互补性来缓解这个问题。具体而言,我们首先构建了一个对偶关系图,该图将句法和语义关系聚合到图中的关键节点上,从而可以从多个角度(即句法和语义视图)全面捕获事件相关信息。然后,我们采用增强关系图注意力网络对图进行编码,并通过引入上下文信息优化图的注意力权重,进一步提高了事件检测的性能。在标准ACE2005基准数据集上进行的大量实验表明,我们的方法明显优于最先进的方法,并验证了DualGAT相对于现有基于句法的方法的优越性。

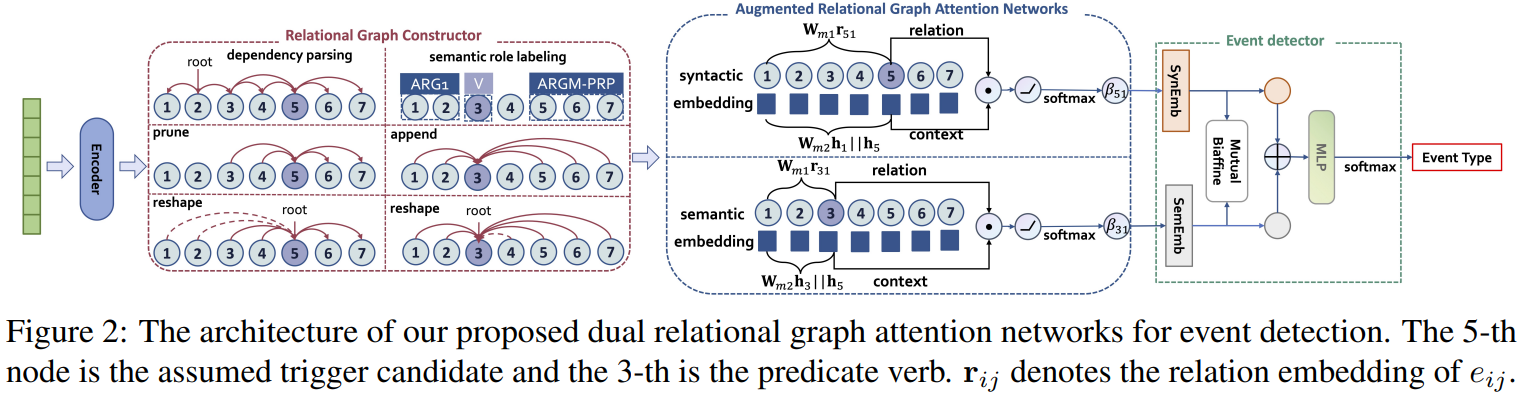

6.2 模型图

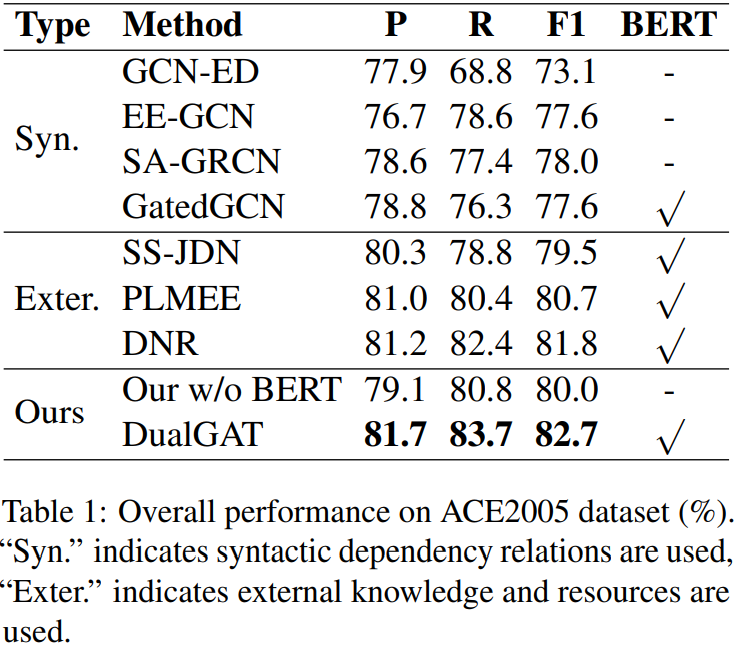

6.3 实验结果

1401

1401

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?