目录

算法11.3 Metropolis-Hastings算法的采样过程

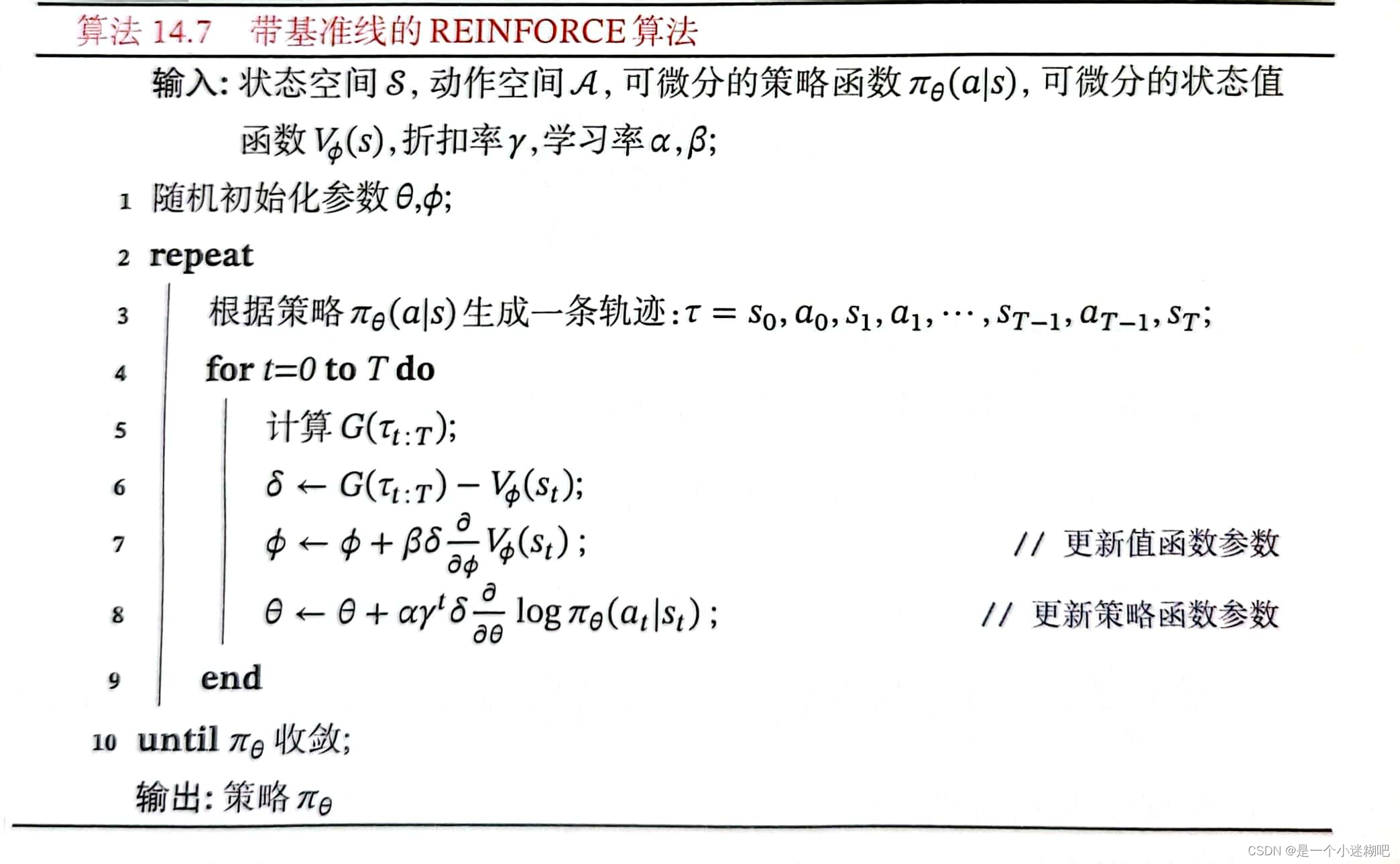

算法14.7 带基准线的REINFORCE算法

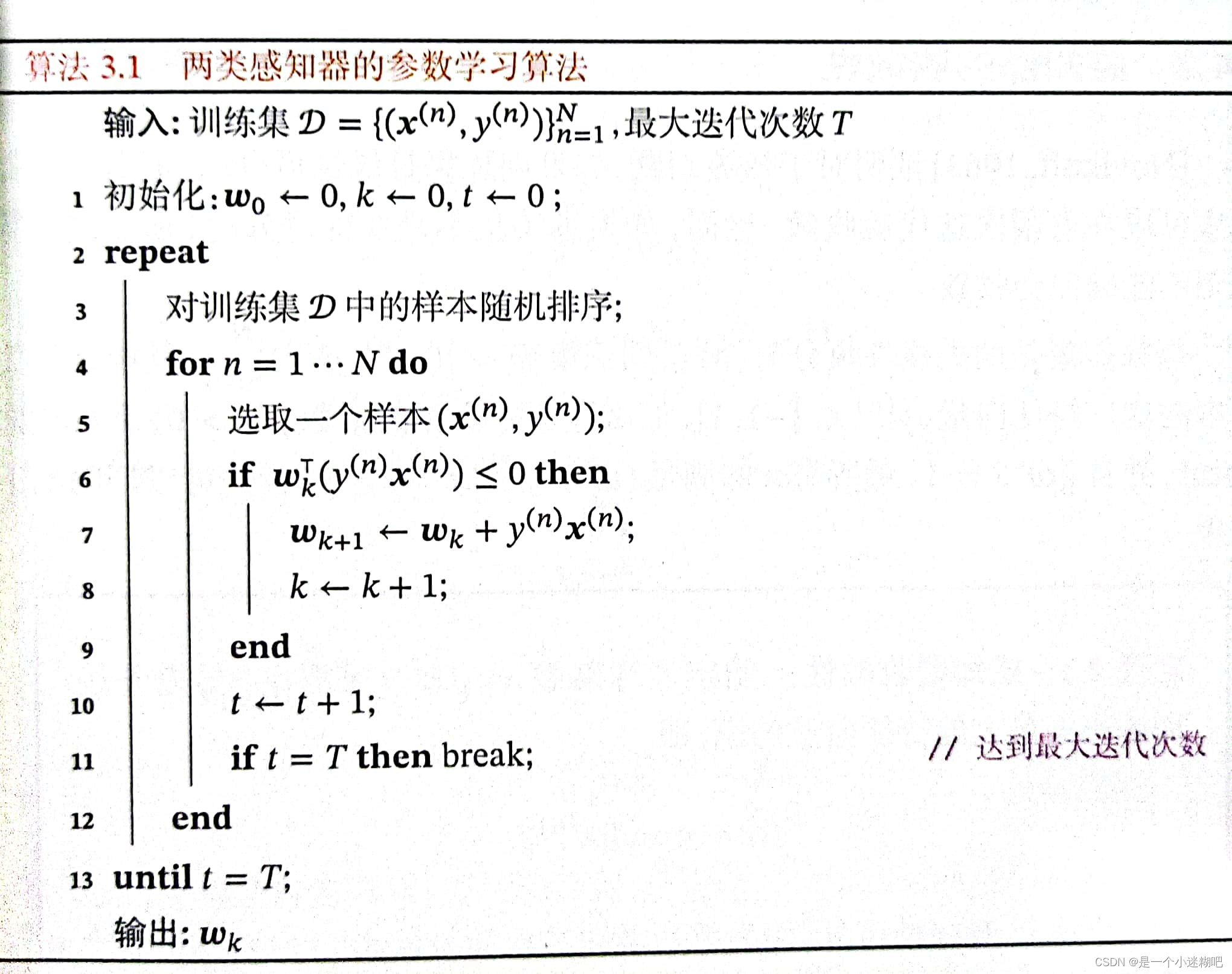

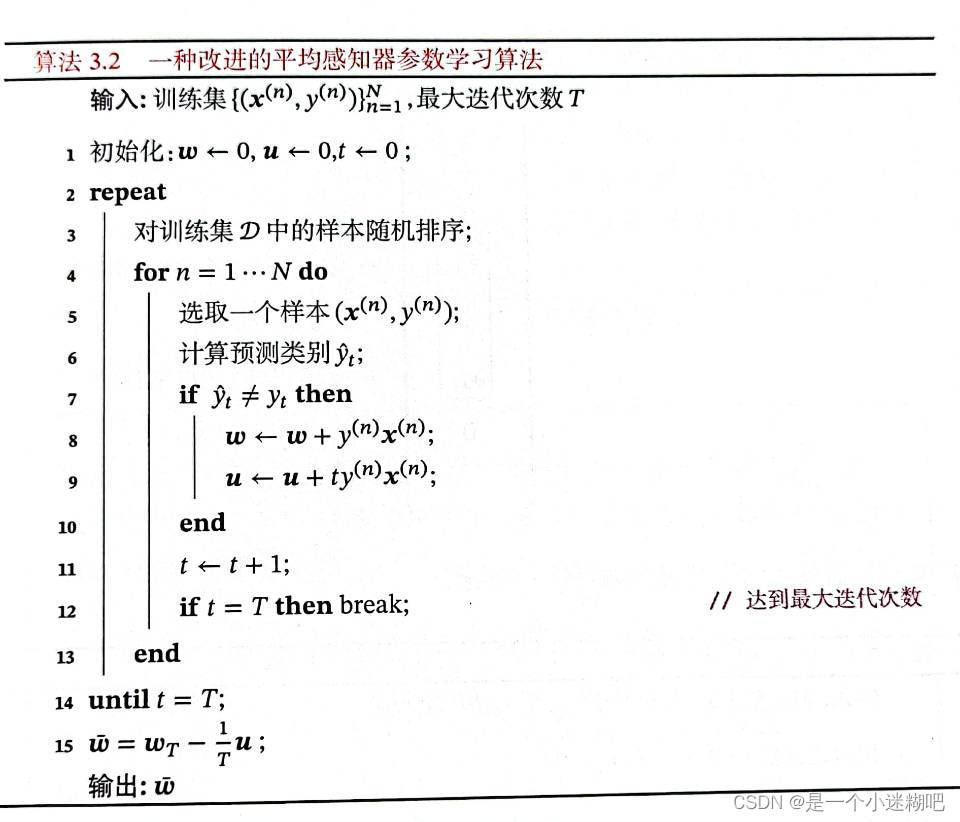

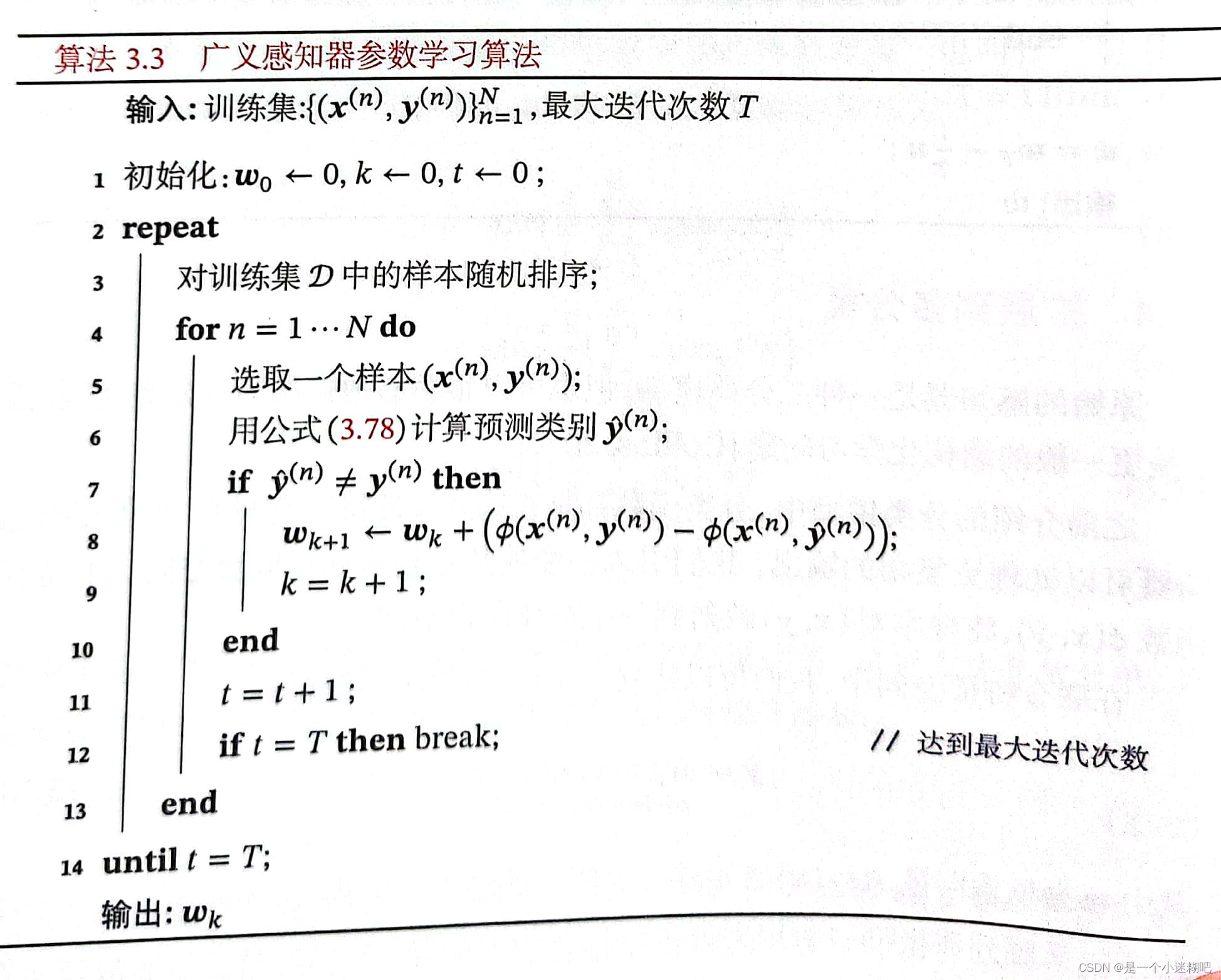

第三章 线性模型

算法3.1 两类感知器的参数学习算法

算法3.2 一种改进的平均感知器参数学习算法

算法3.3 广义感知器参数学习算法

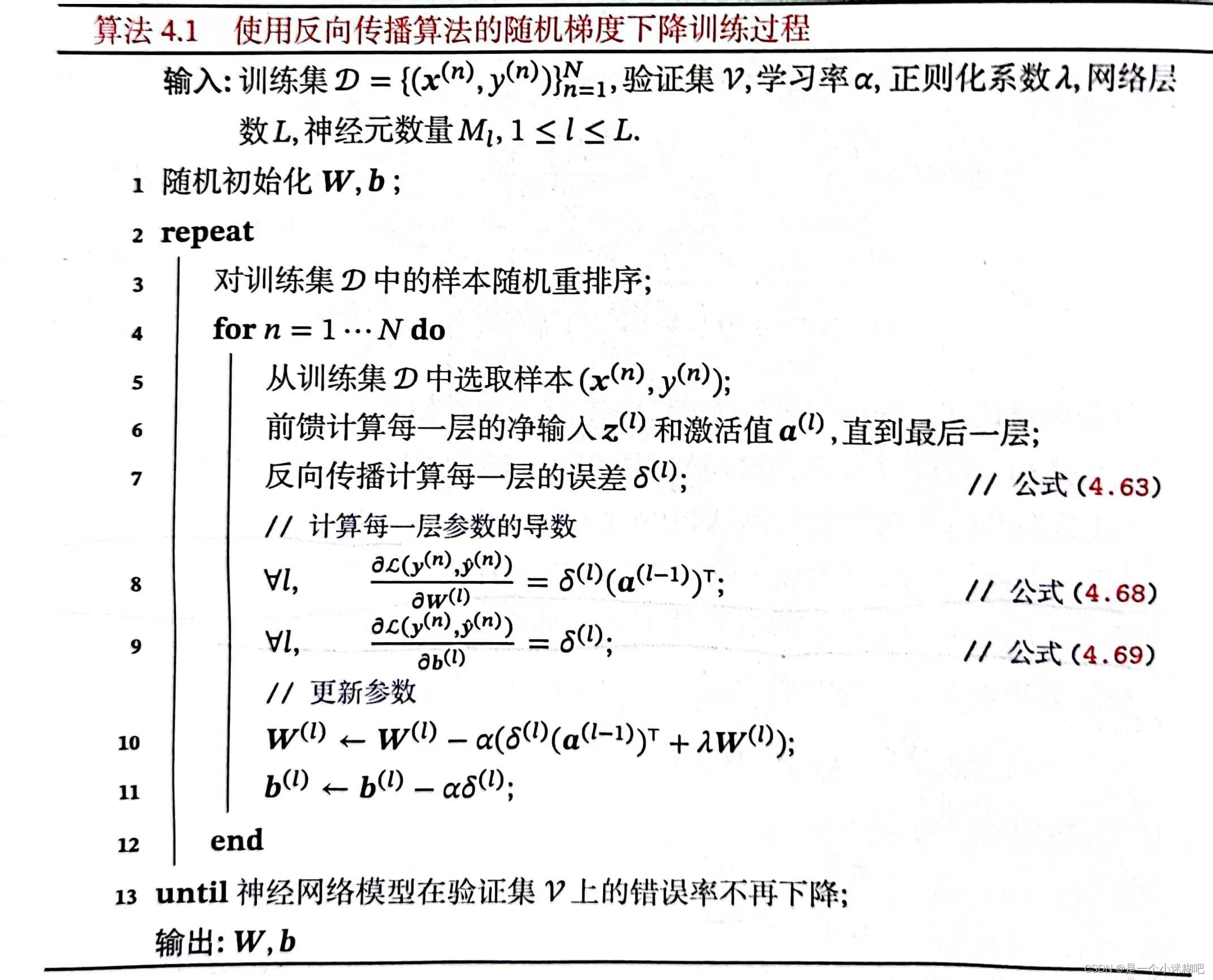

第四章 前反馈神经网络

算法4.1 使用反向传播算法的随机梯度下降训练过程

第七章 网络优化与正则化

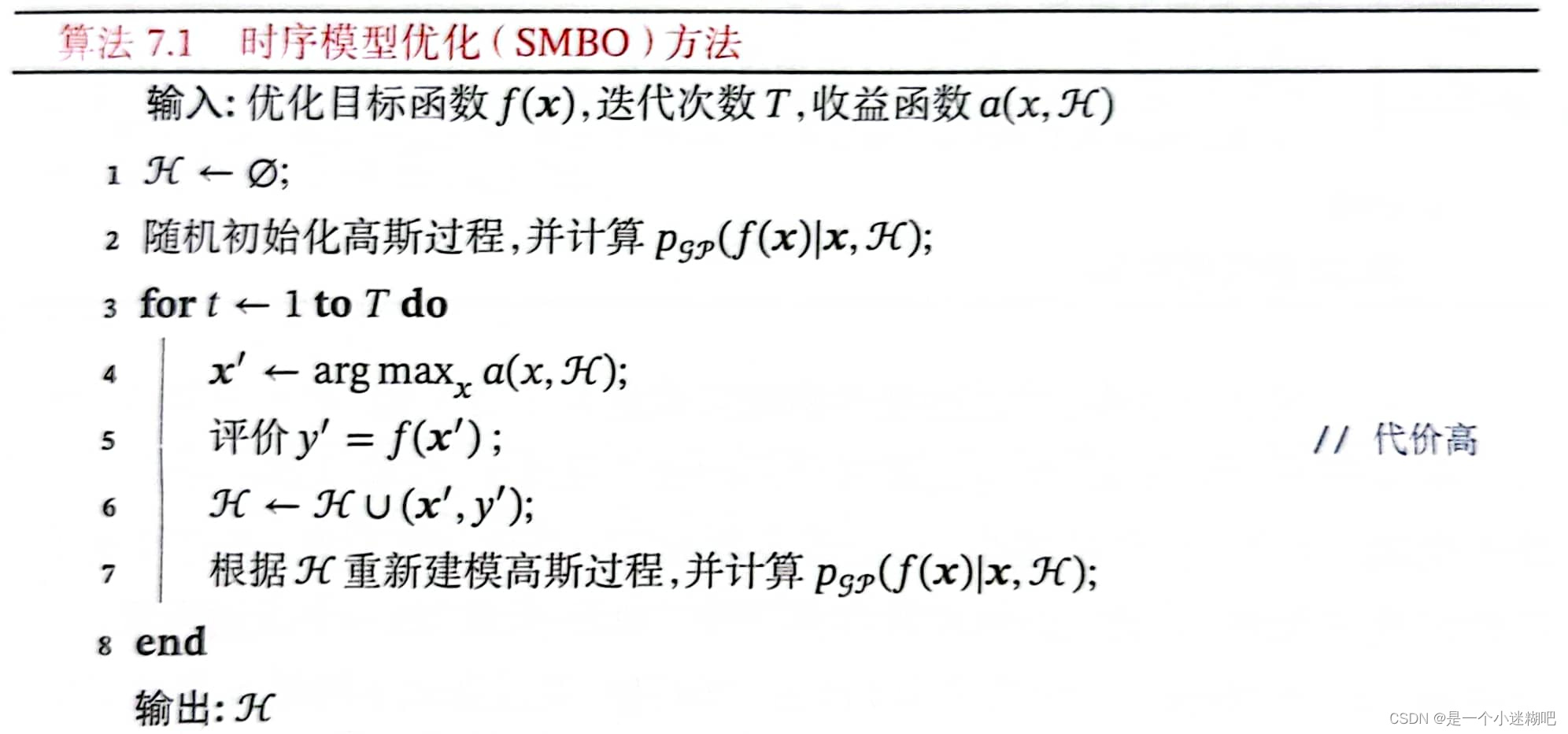

算法7.1 时序模型优化(SMBO)方法

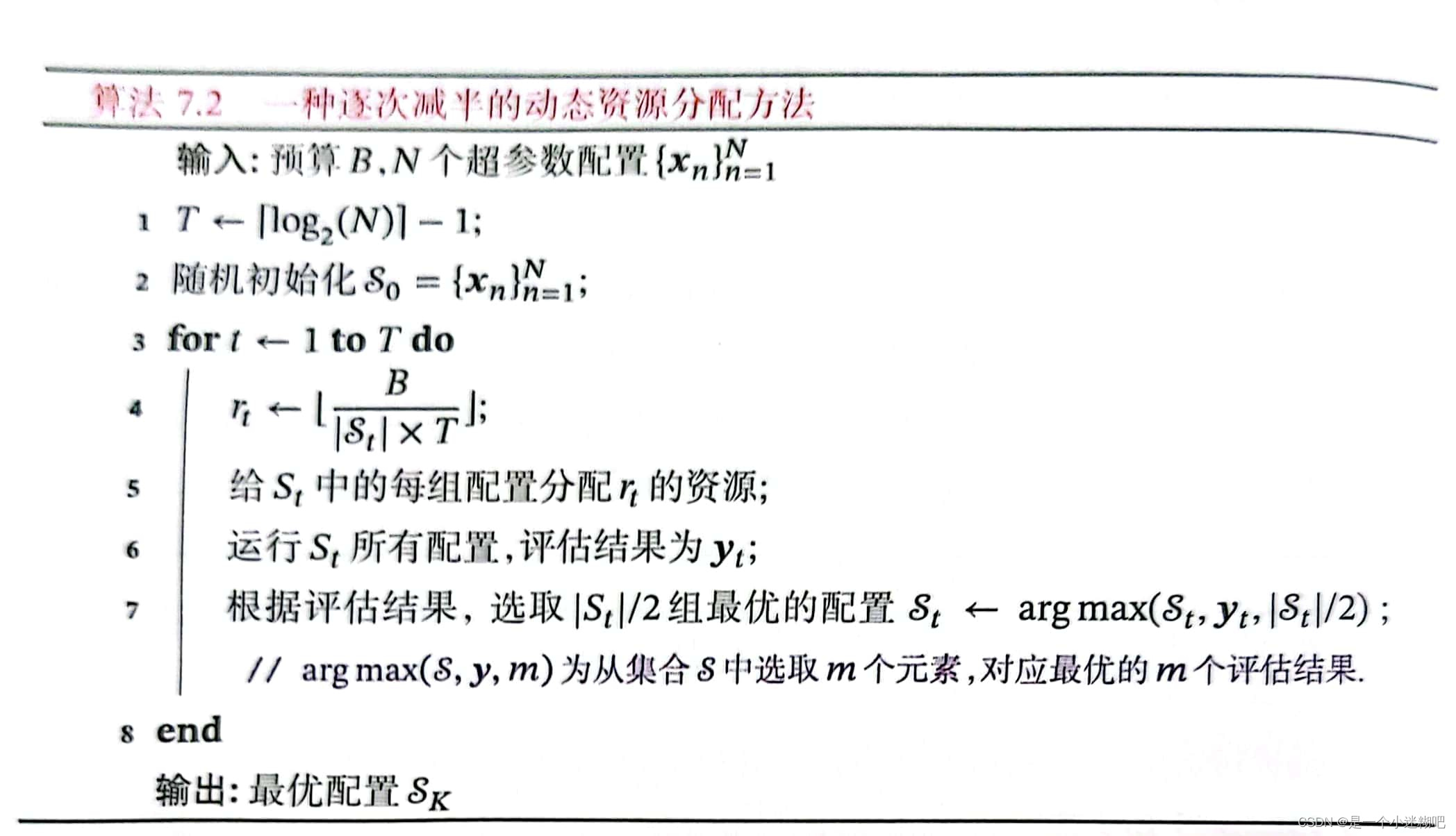

算法7.2 一种逐次减半的动态资源分配方法

第十章 模型独立的学习方式

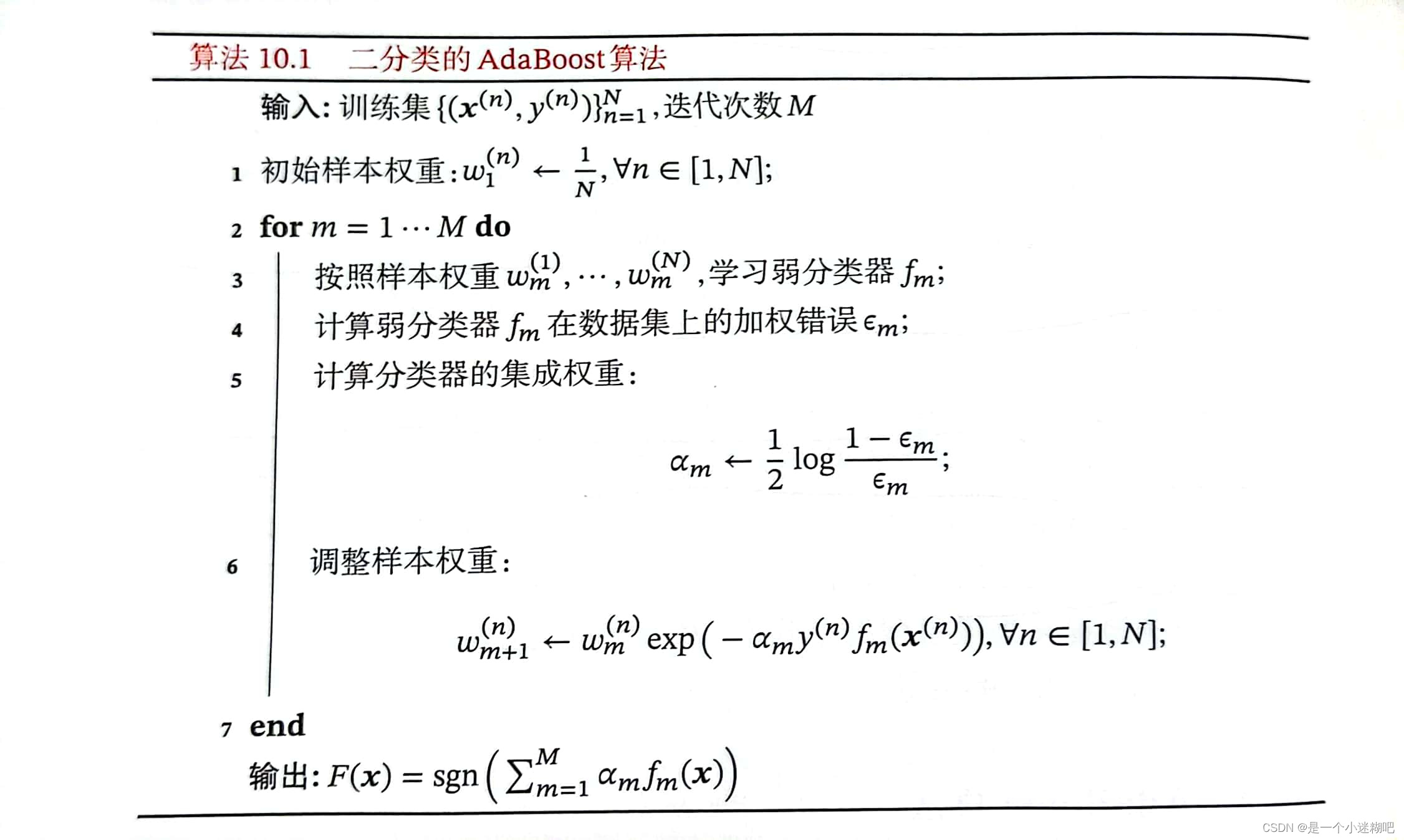

算法10.1 二分类的AdaBoost算法

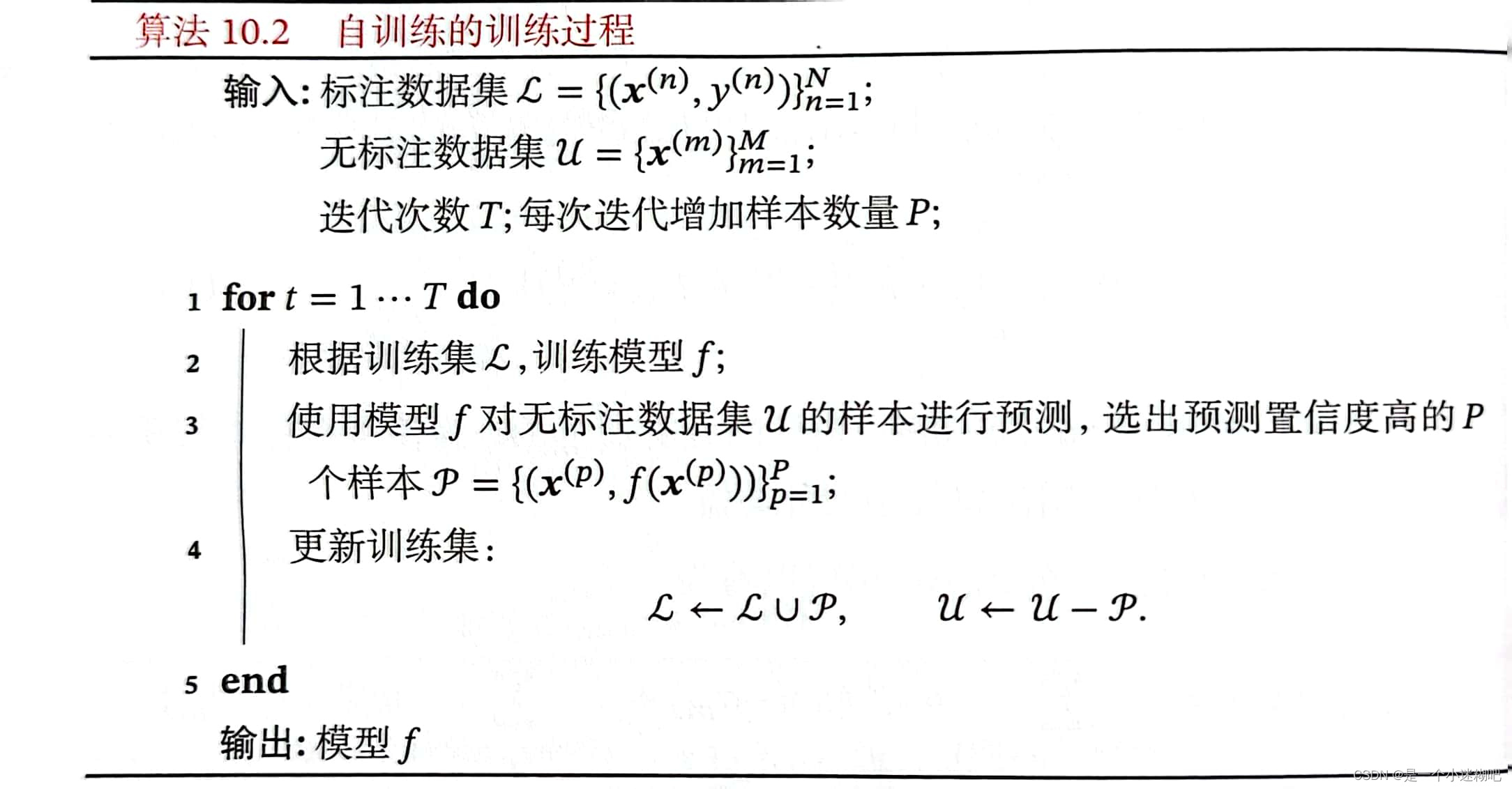

算法10.2 自训练的训练过程

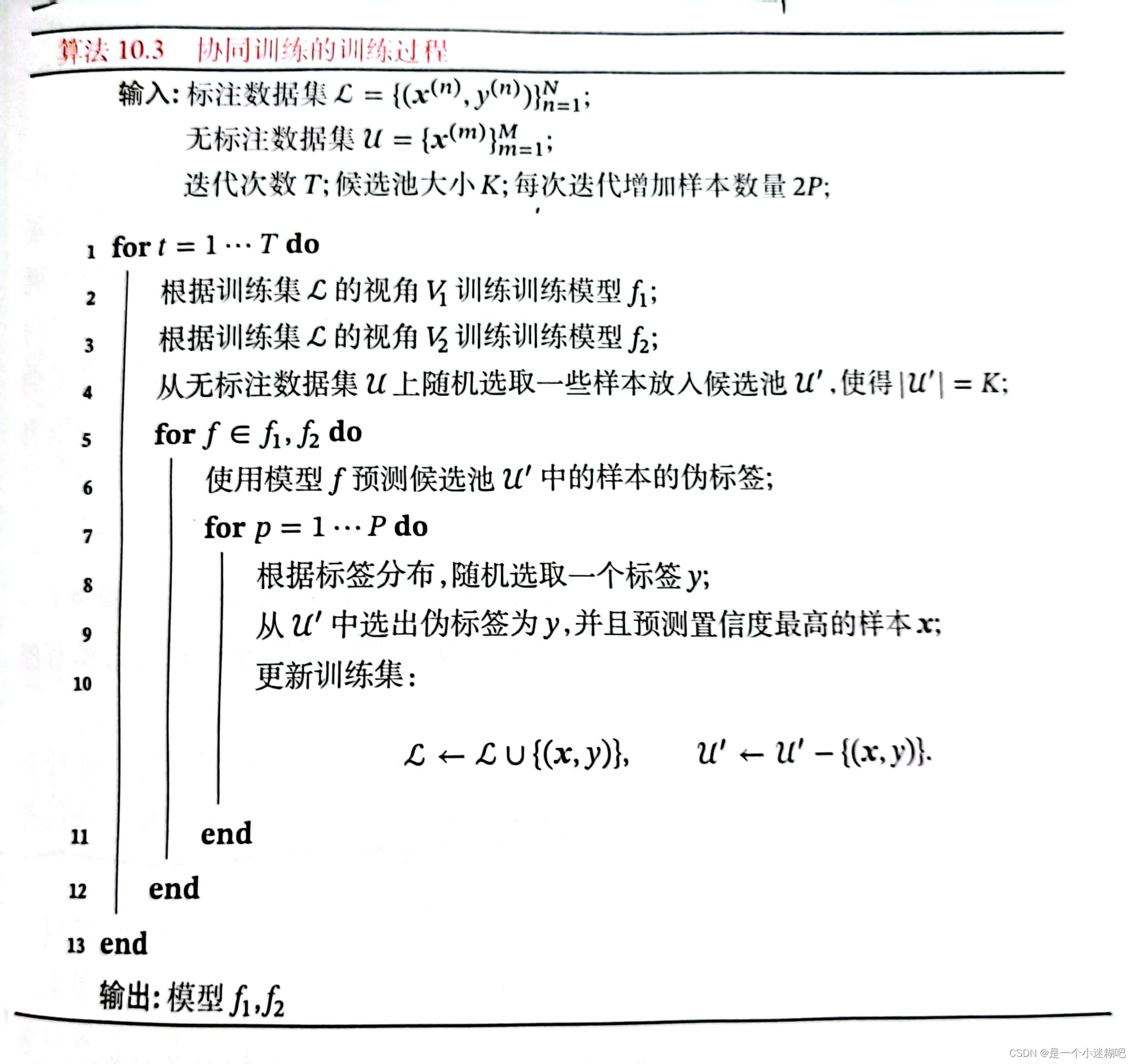

算法10.3 协同训练的训练过程

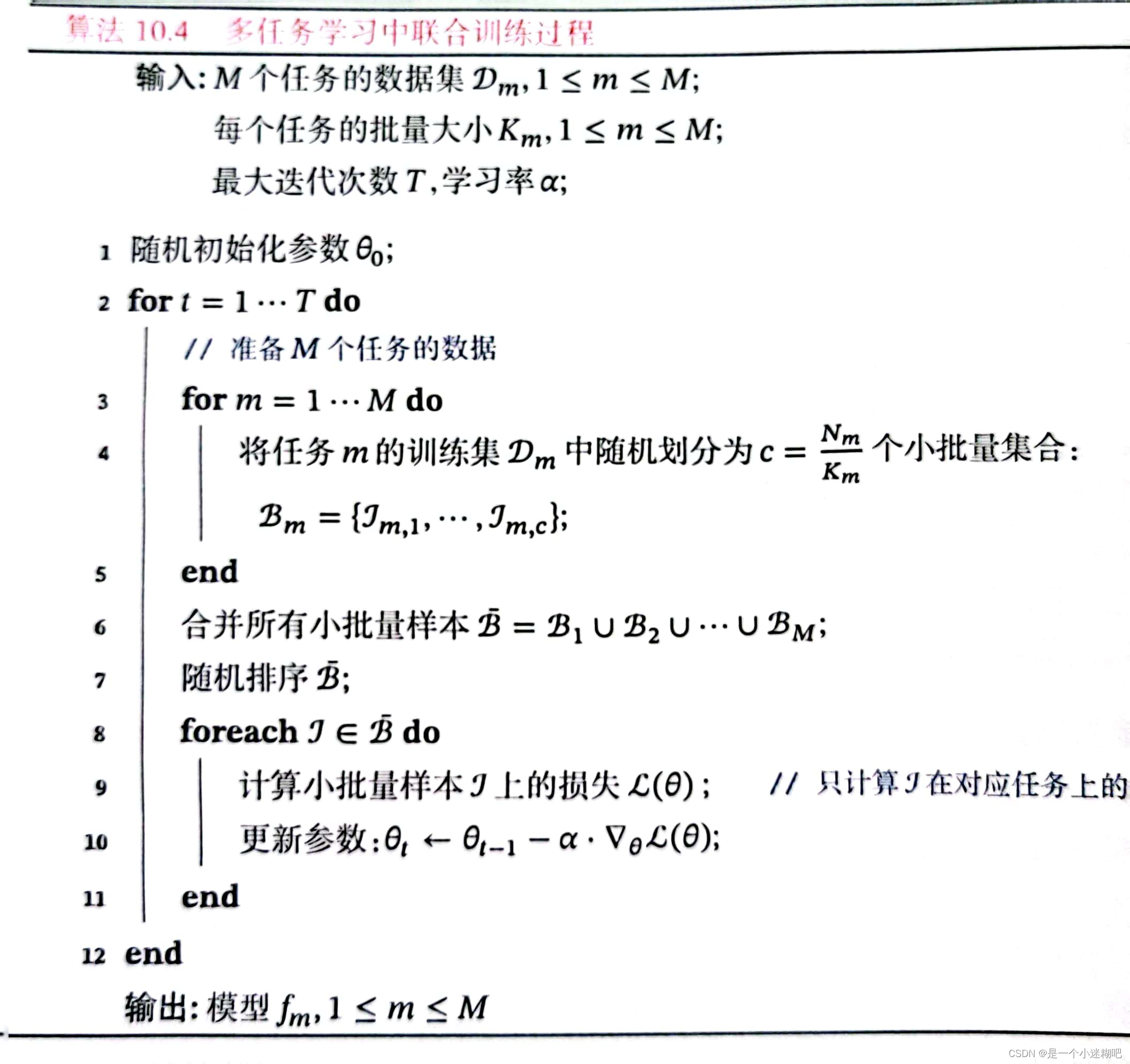

算法10.4 多任务学习中联合训练过程

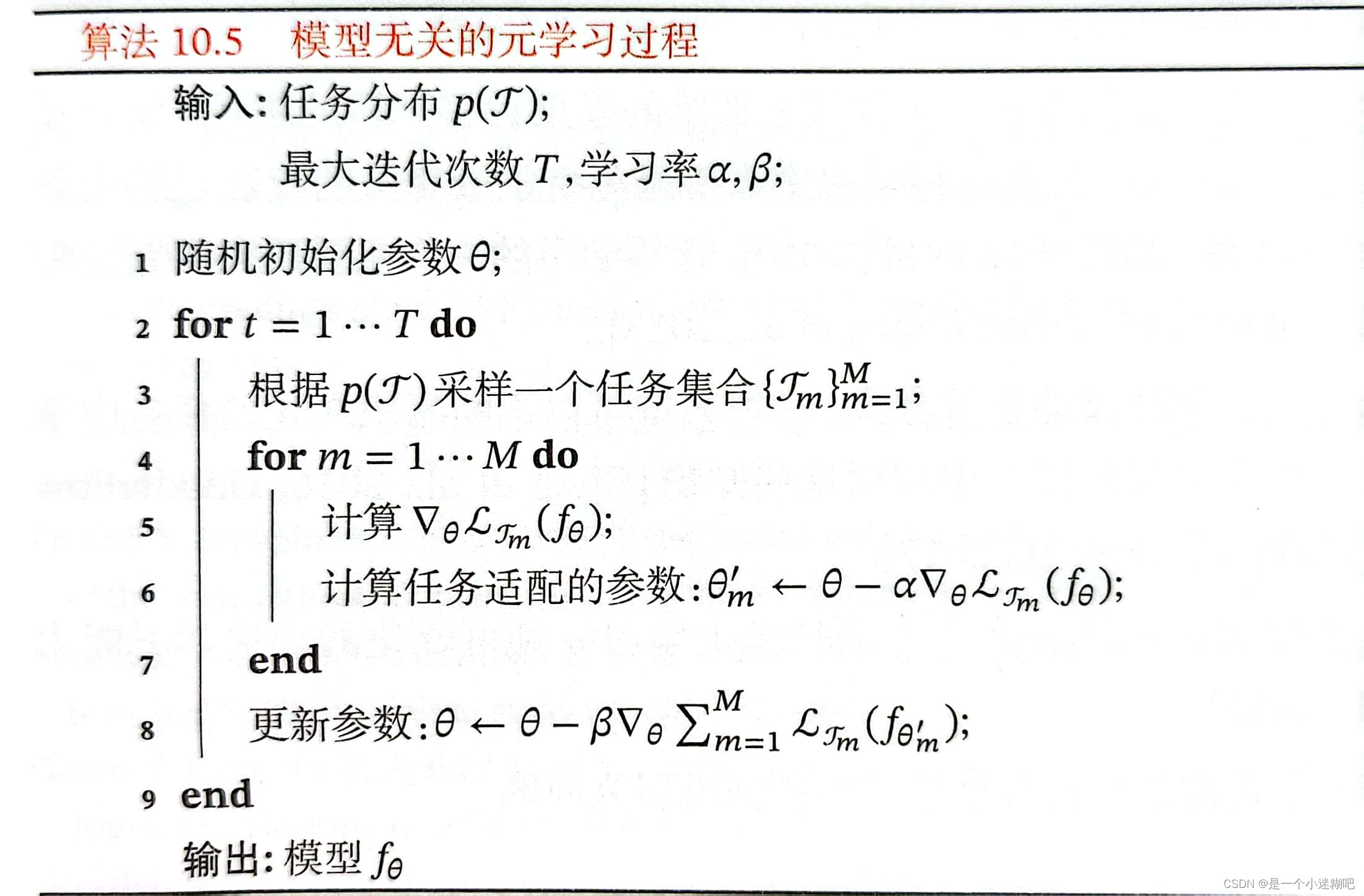

算法10.5 模型无关的元学习过程

第十一章 概率图模型

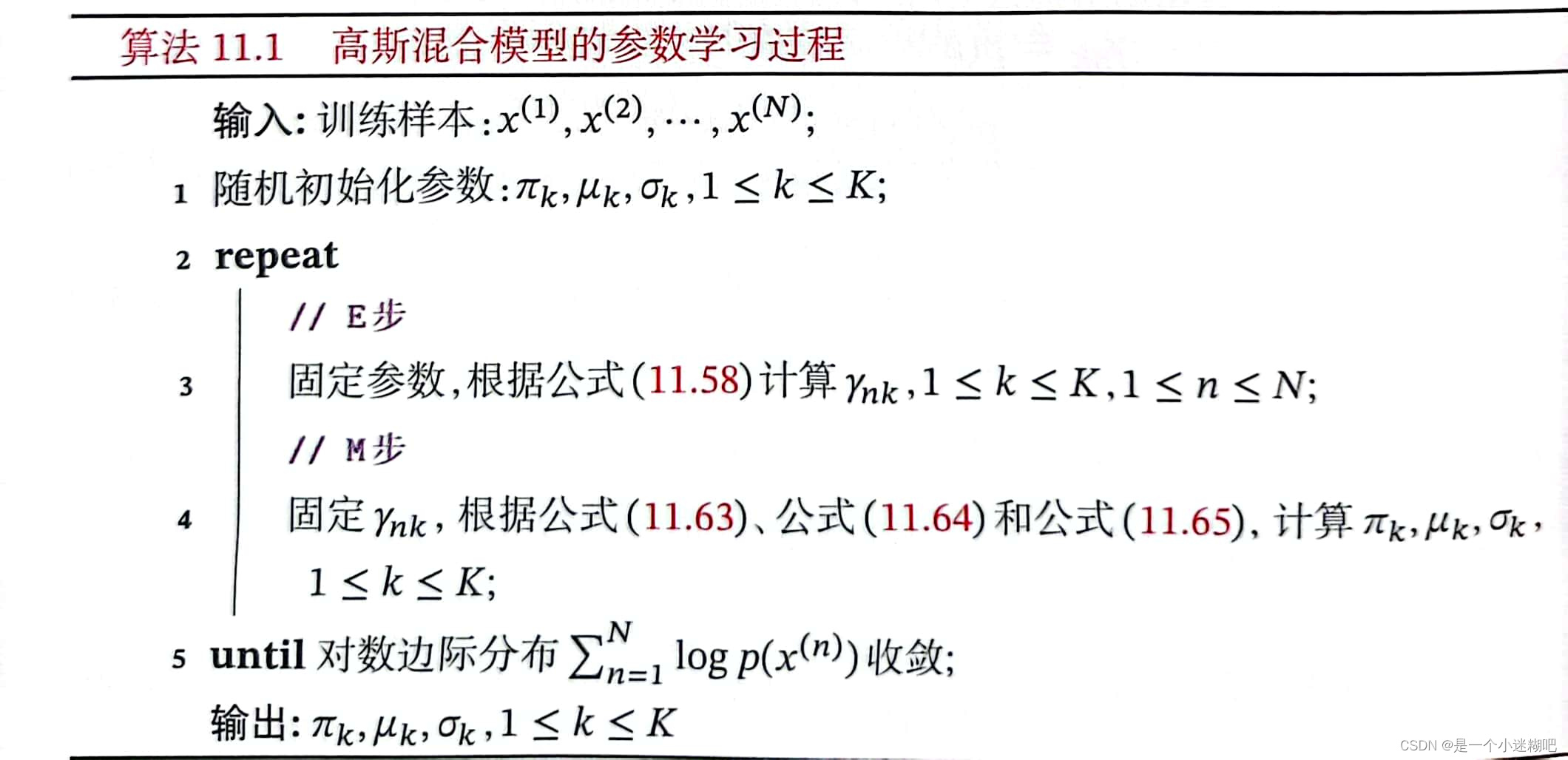

算法 11.1 高斯混合模型的参数学习过程

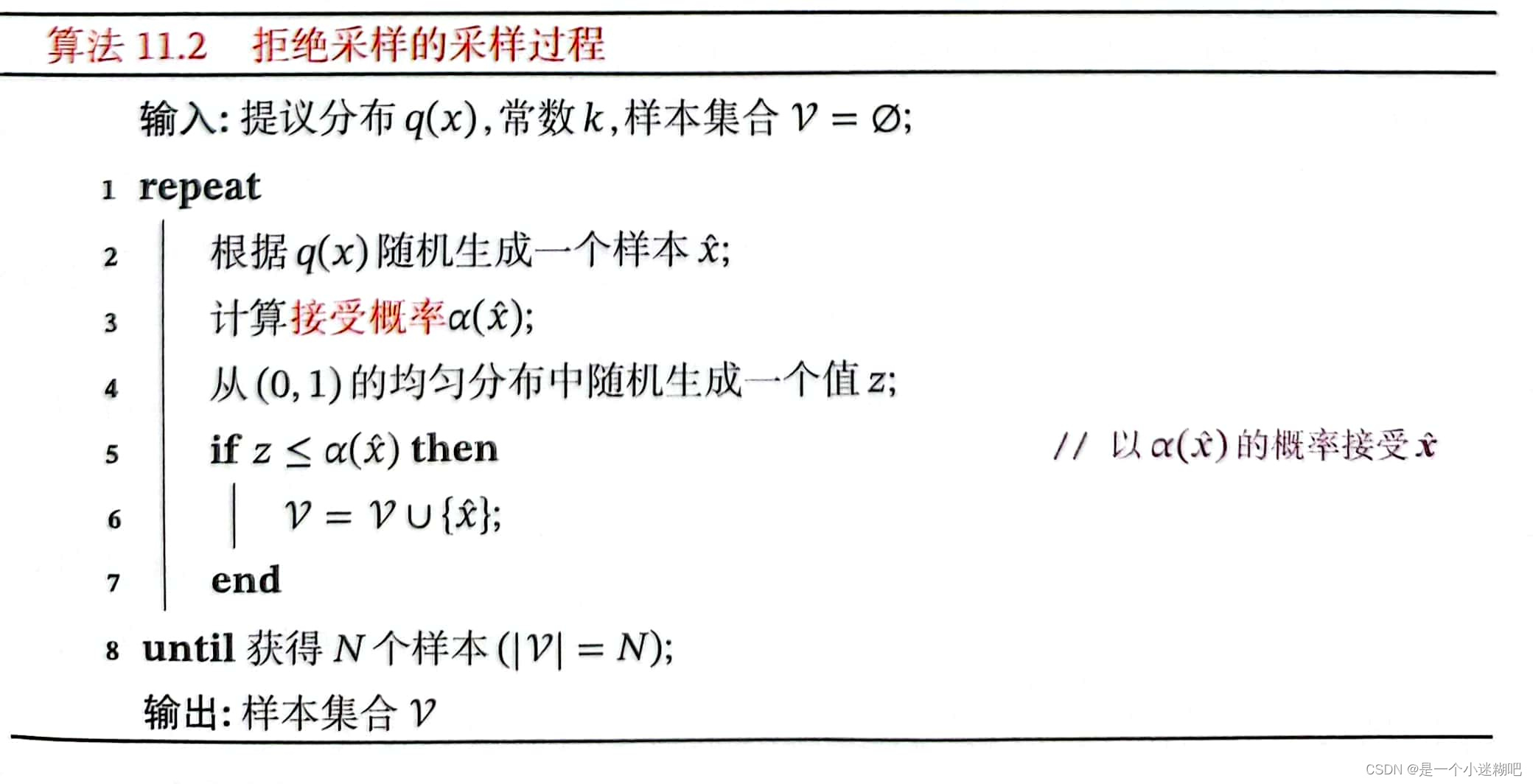

算法 11.2 拒绝采样的采样过程

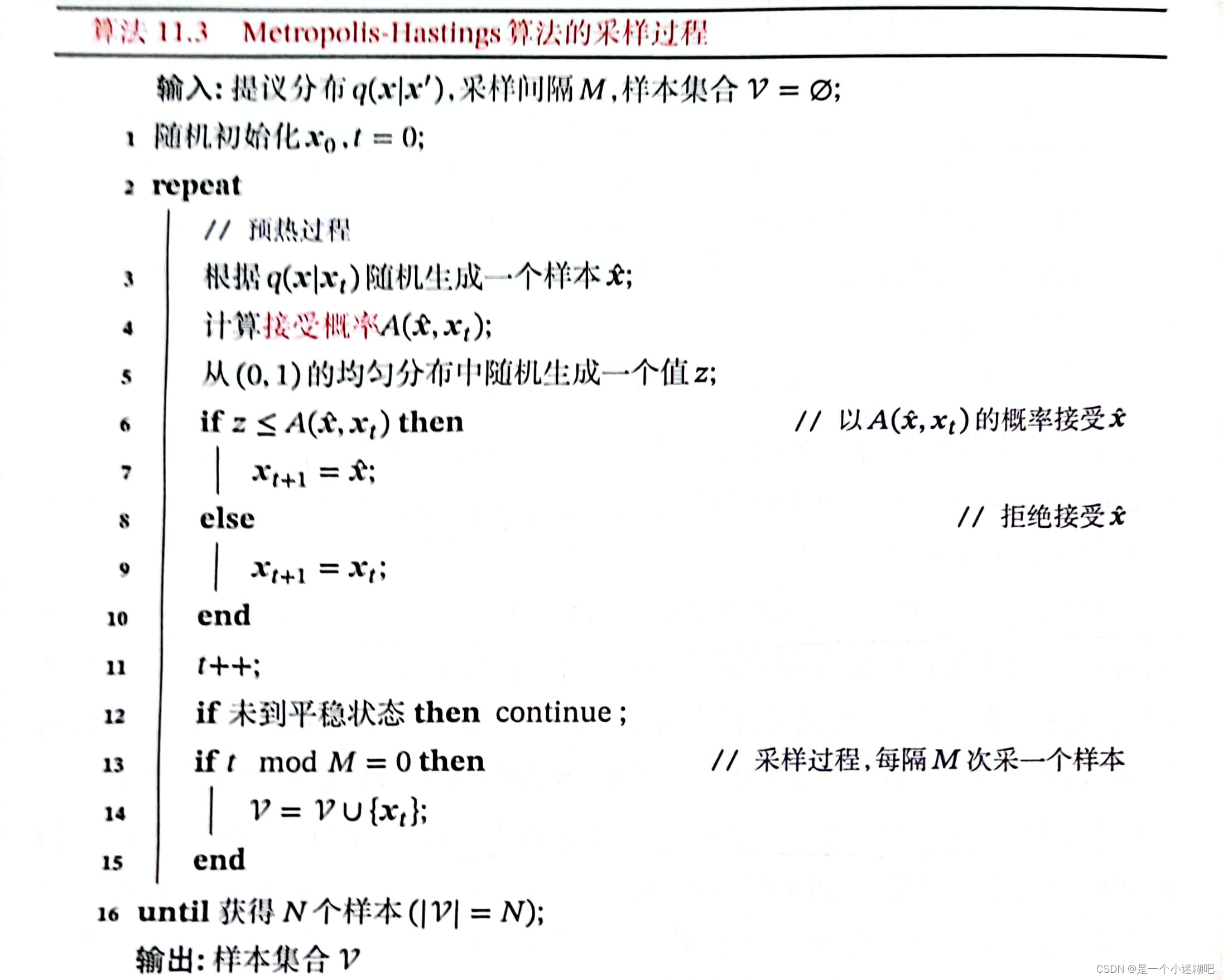

算法11.3 Metropolis-Hastings算法的采样过程

第十二章 深度信念网络

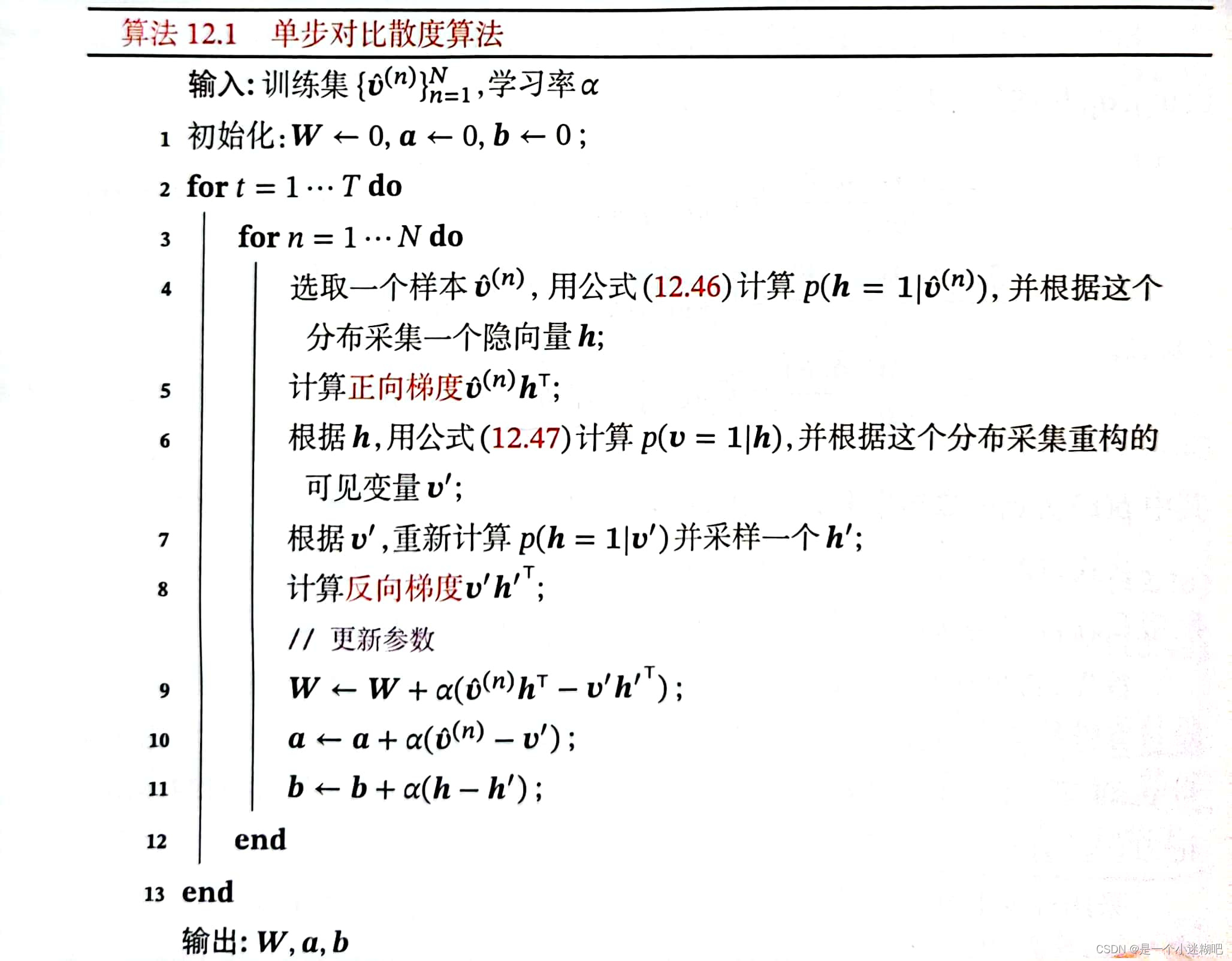

算法12.1 单步对比散度算法

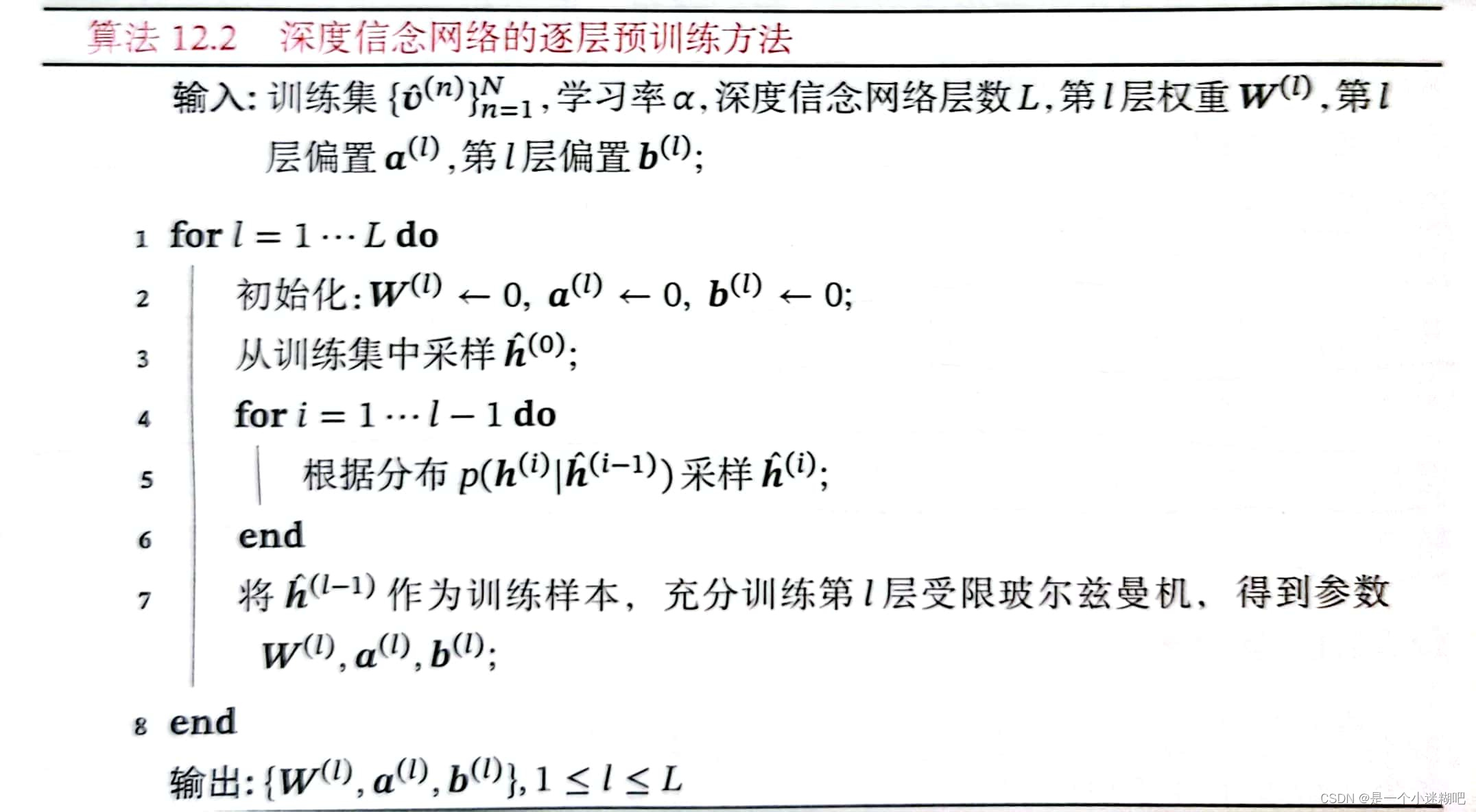

算法12.2 深度信念网络的逐层预训练方法

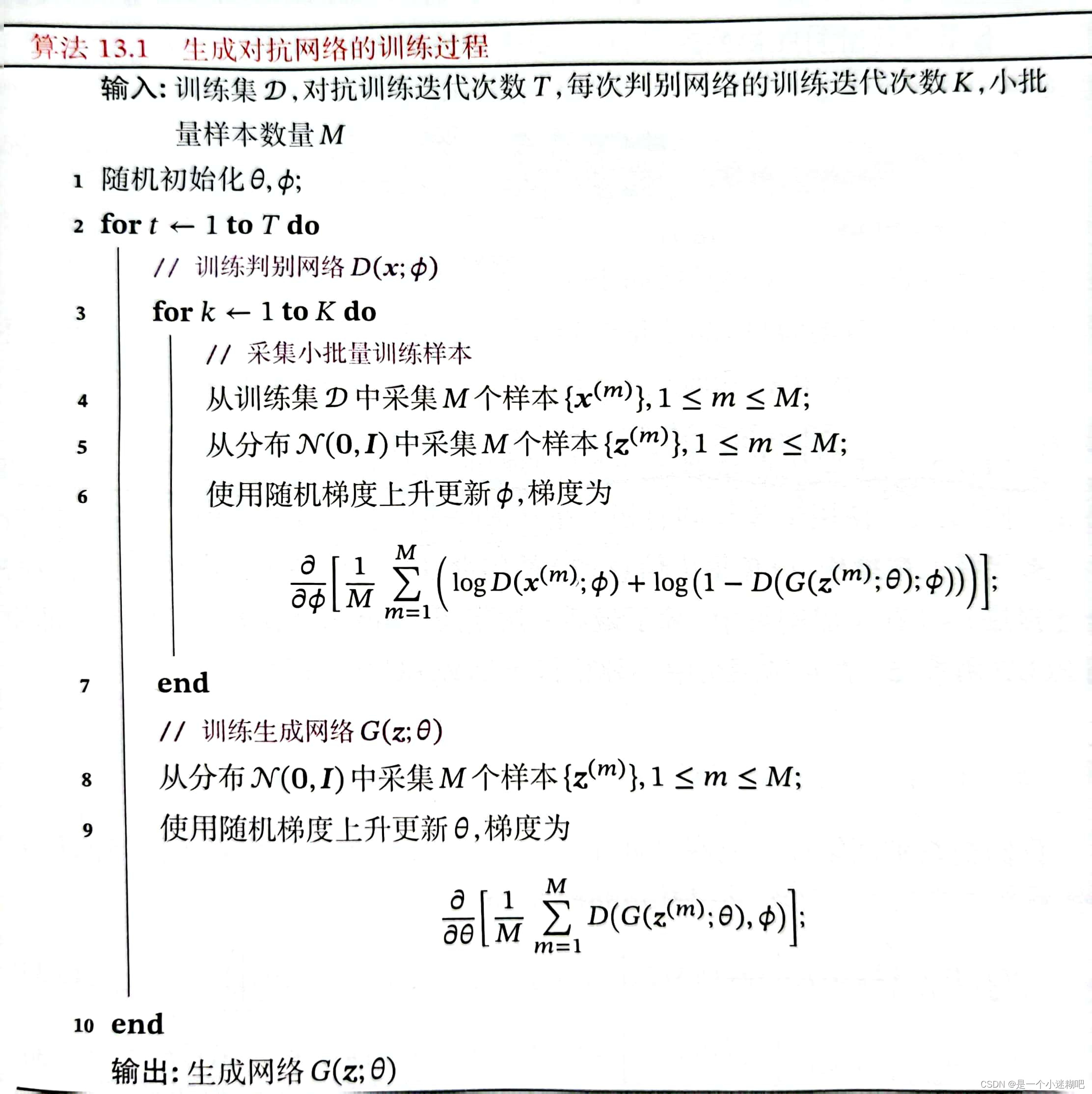

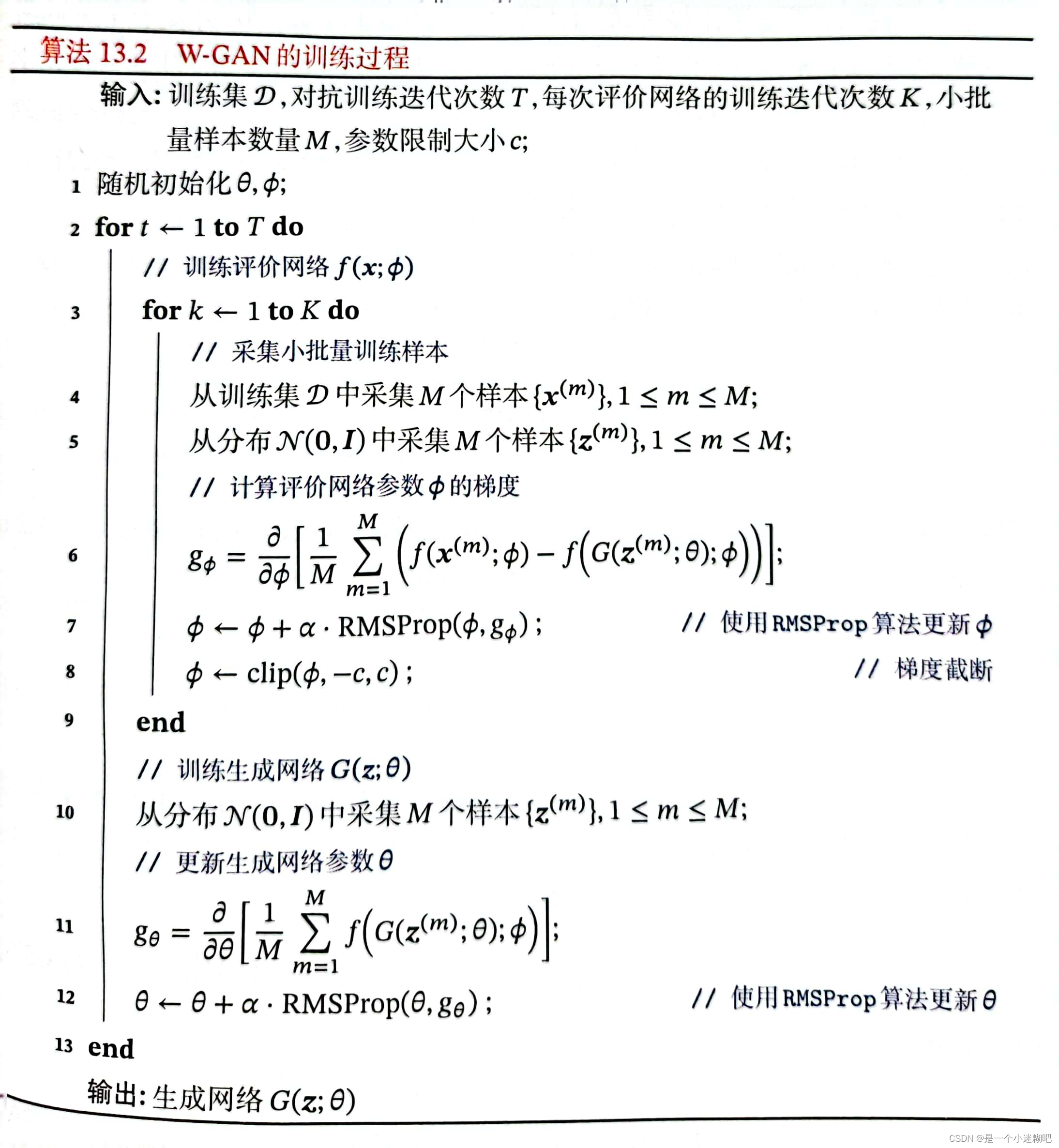

第十三章 深度生成模型

算法13.1 生成对抗网络的训练过程

算法13.2 W-GAN的训练过程

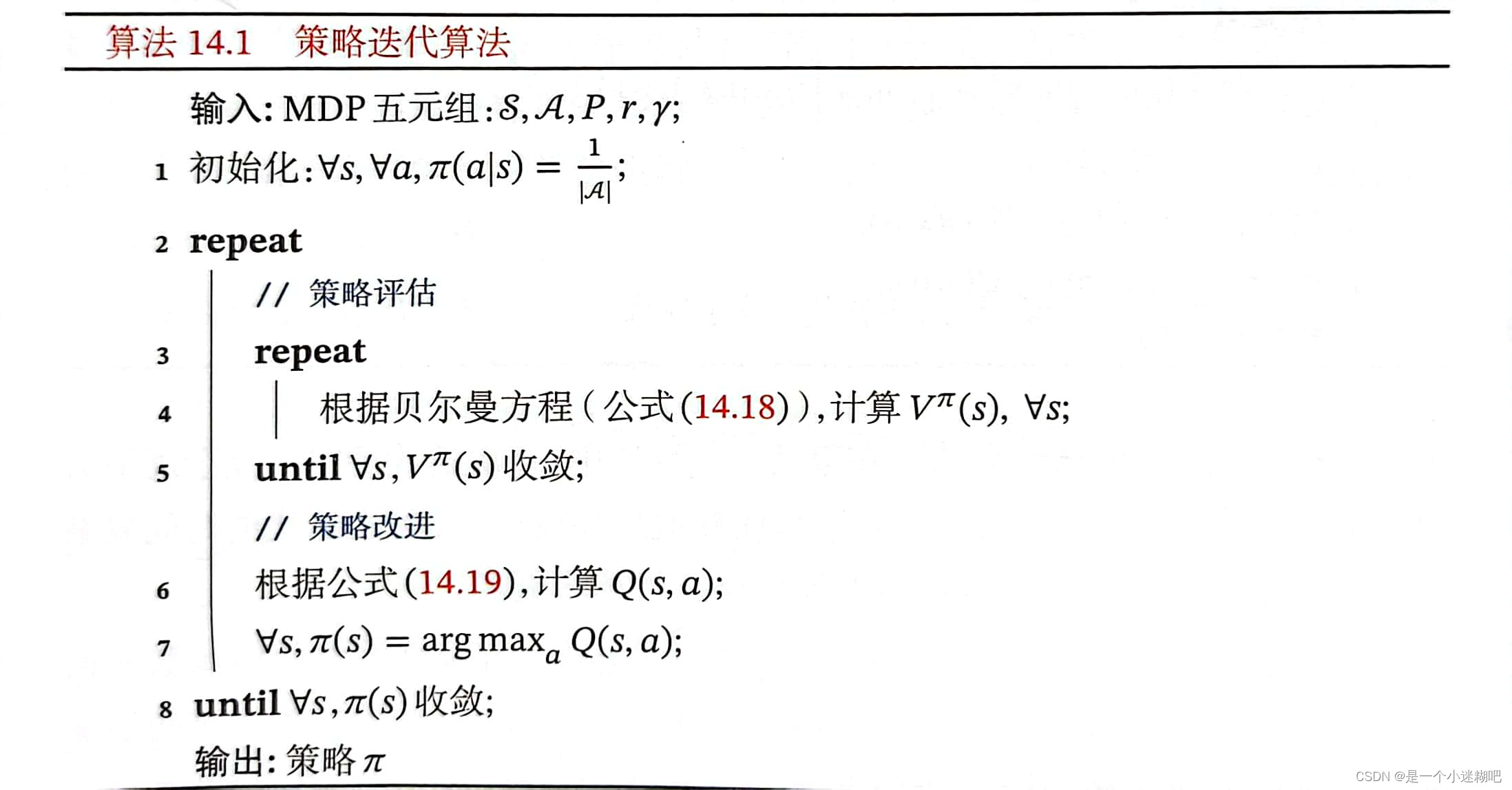

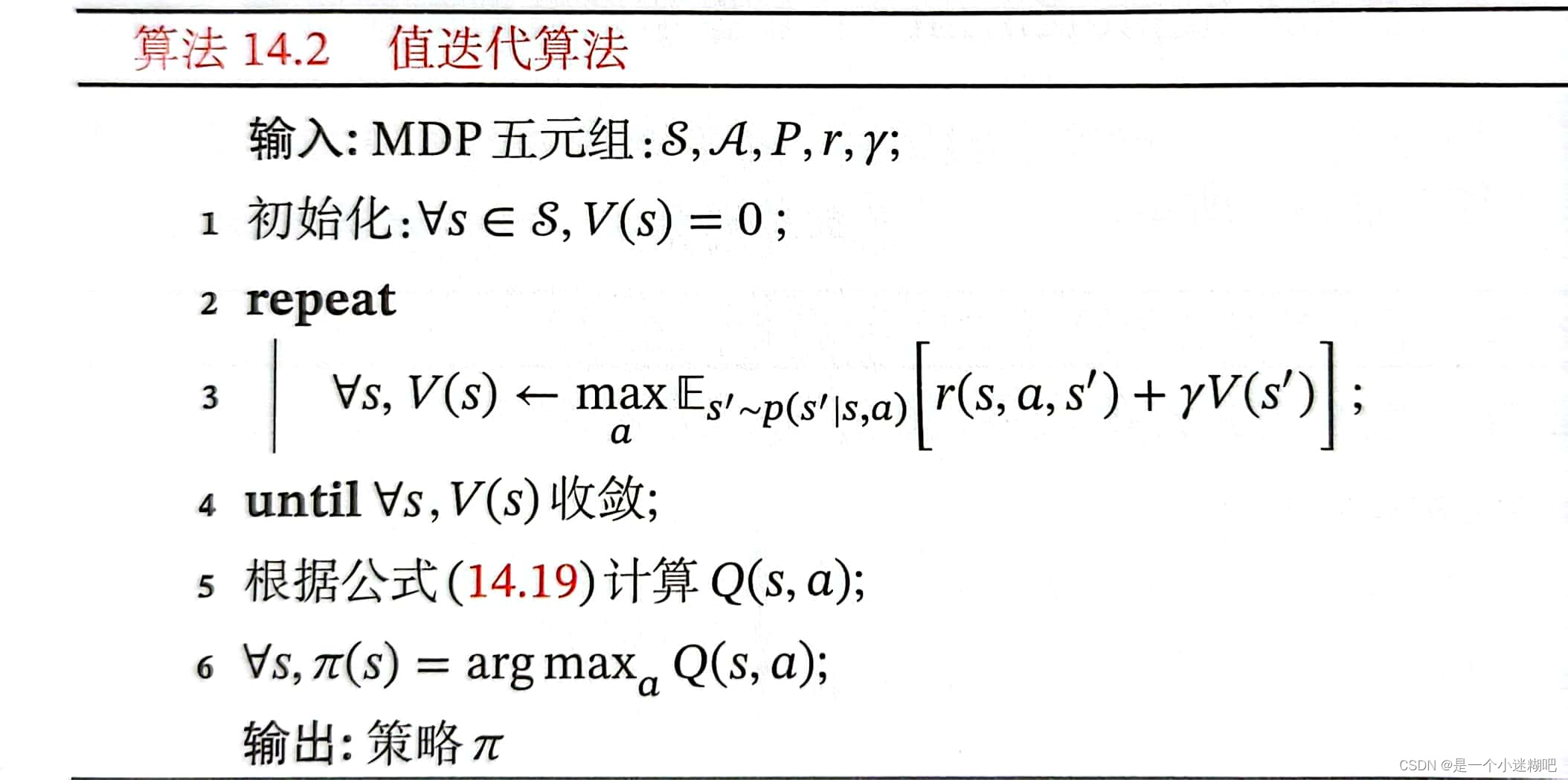

第十四章 深度强化学习

算法14.1 策略迭代算法

算法14.2 值迭代算法

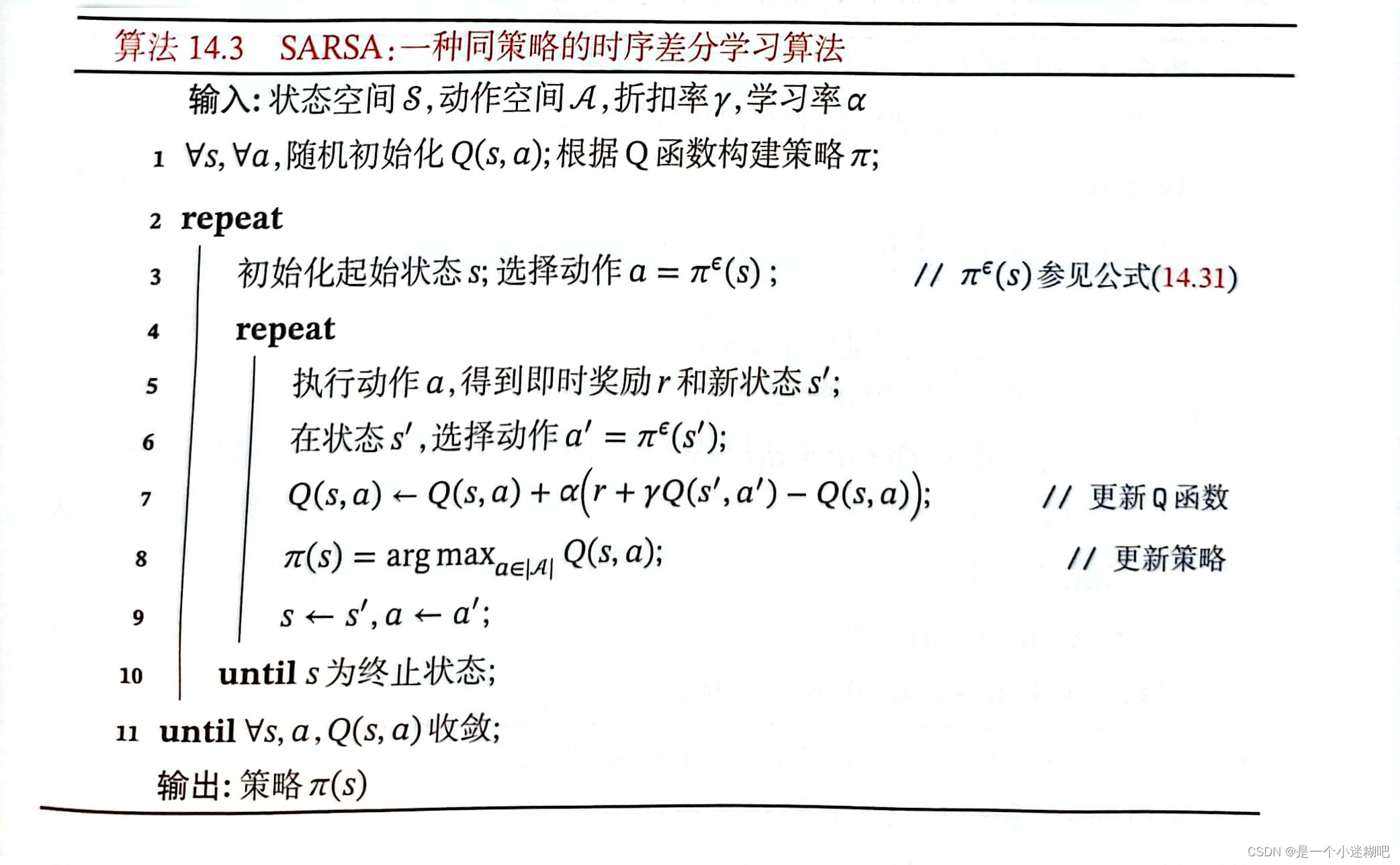

算法 14.3 SARSA :一种同策略的时序差分学习算法

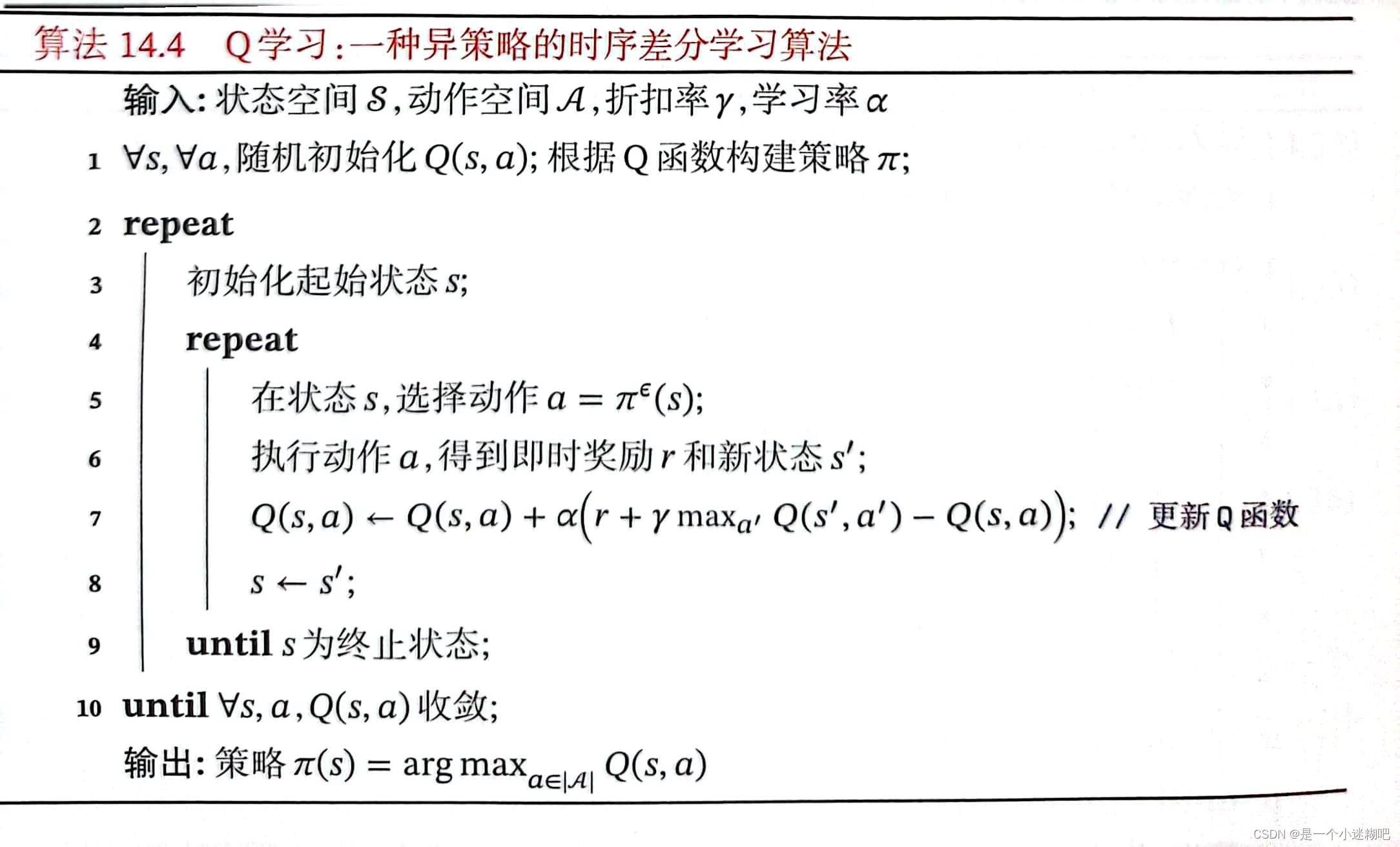

算法14.4 Q学习:一种异策略的时序差分学习算法

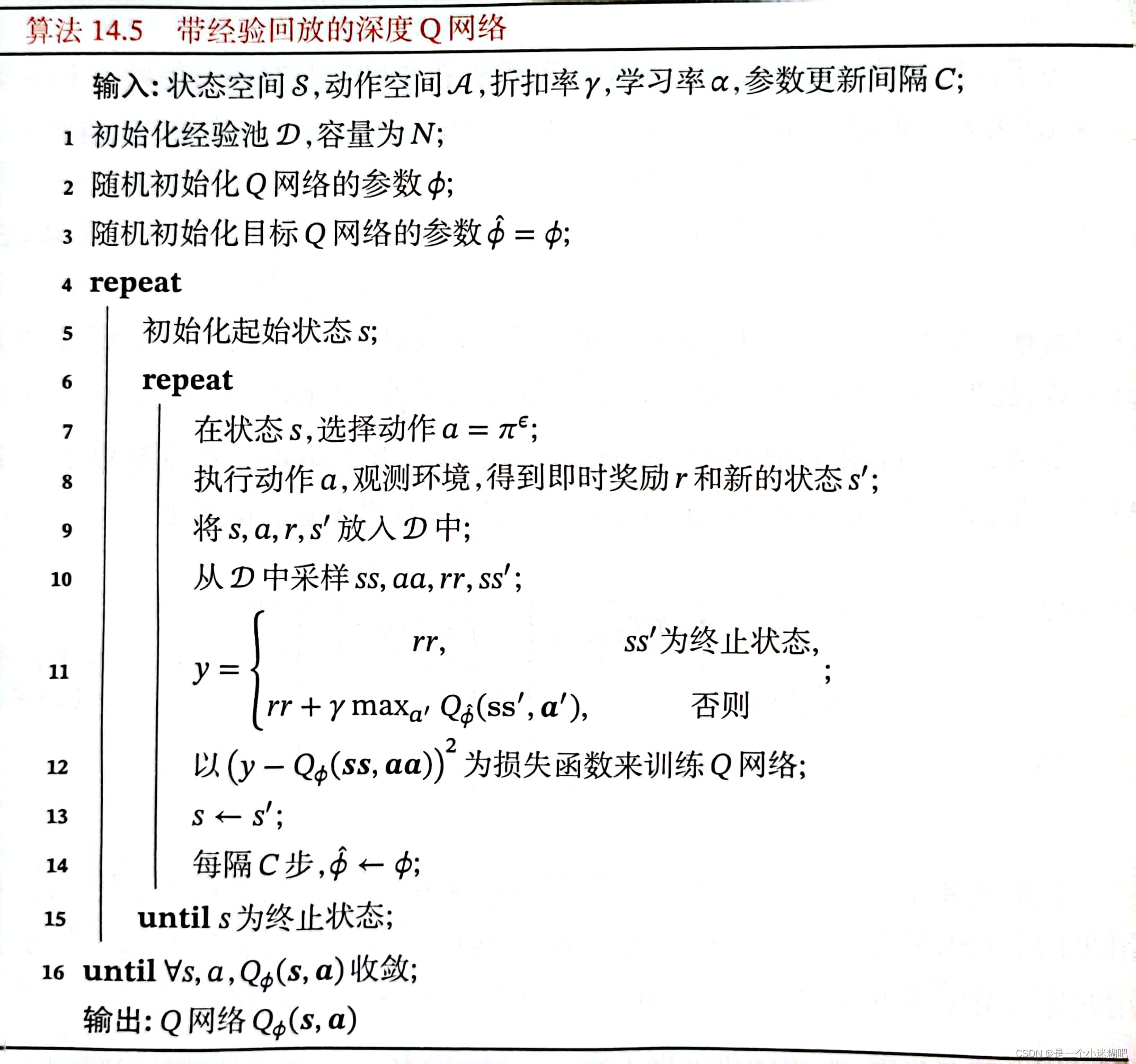

算法 14.5 带经验回放的深度Q网络

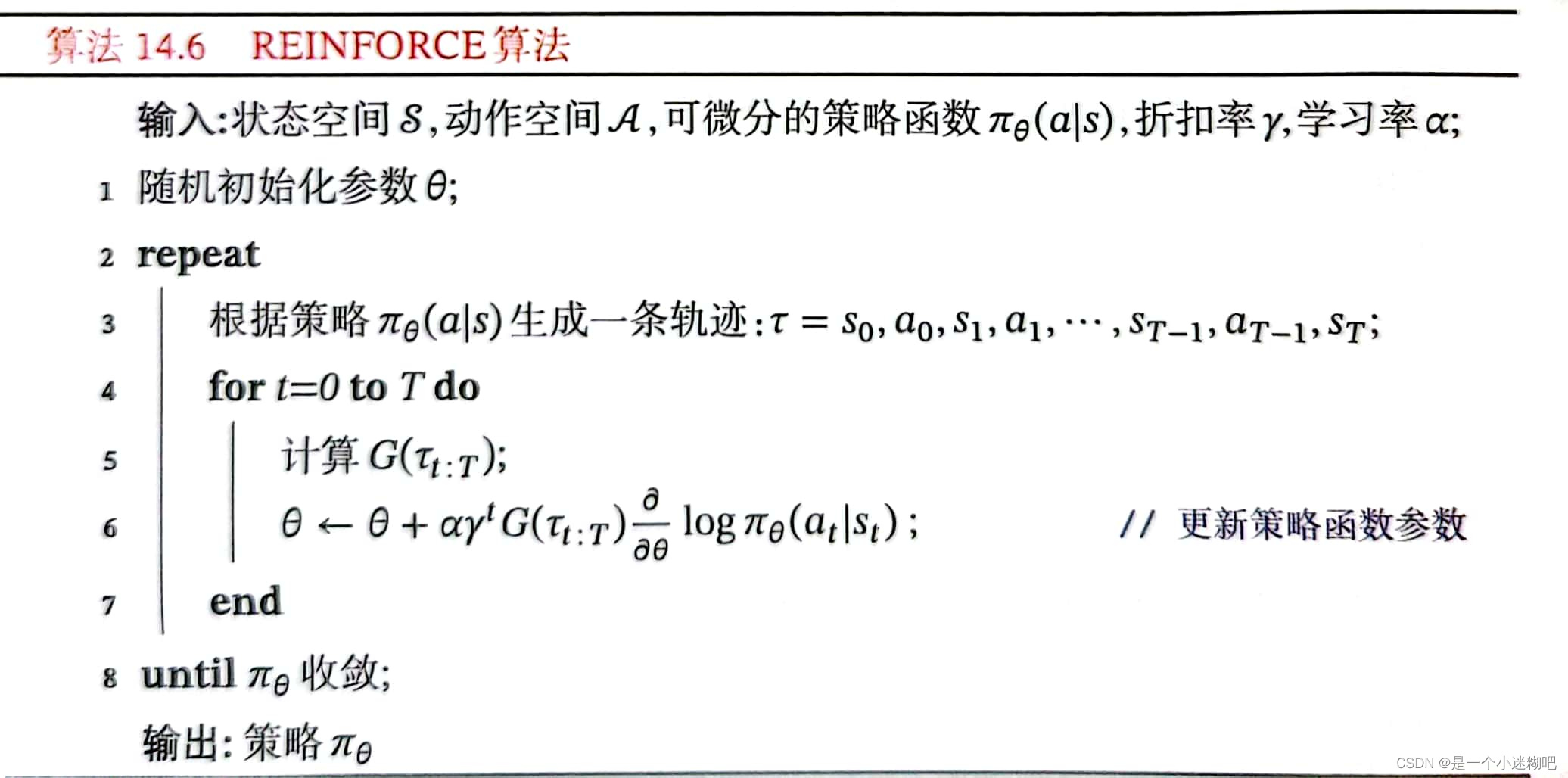

算法14.6 REINFORCE算法

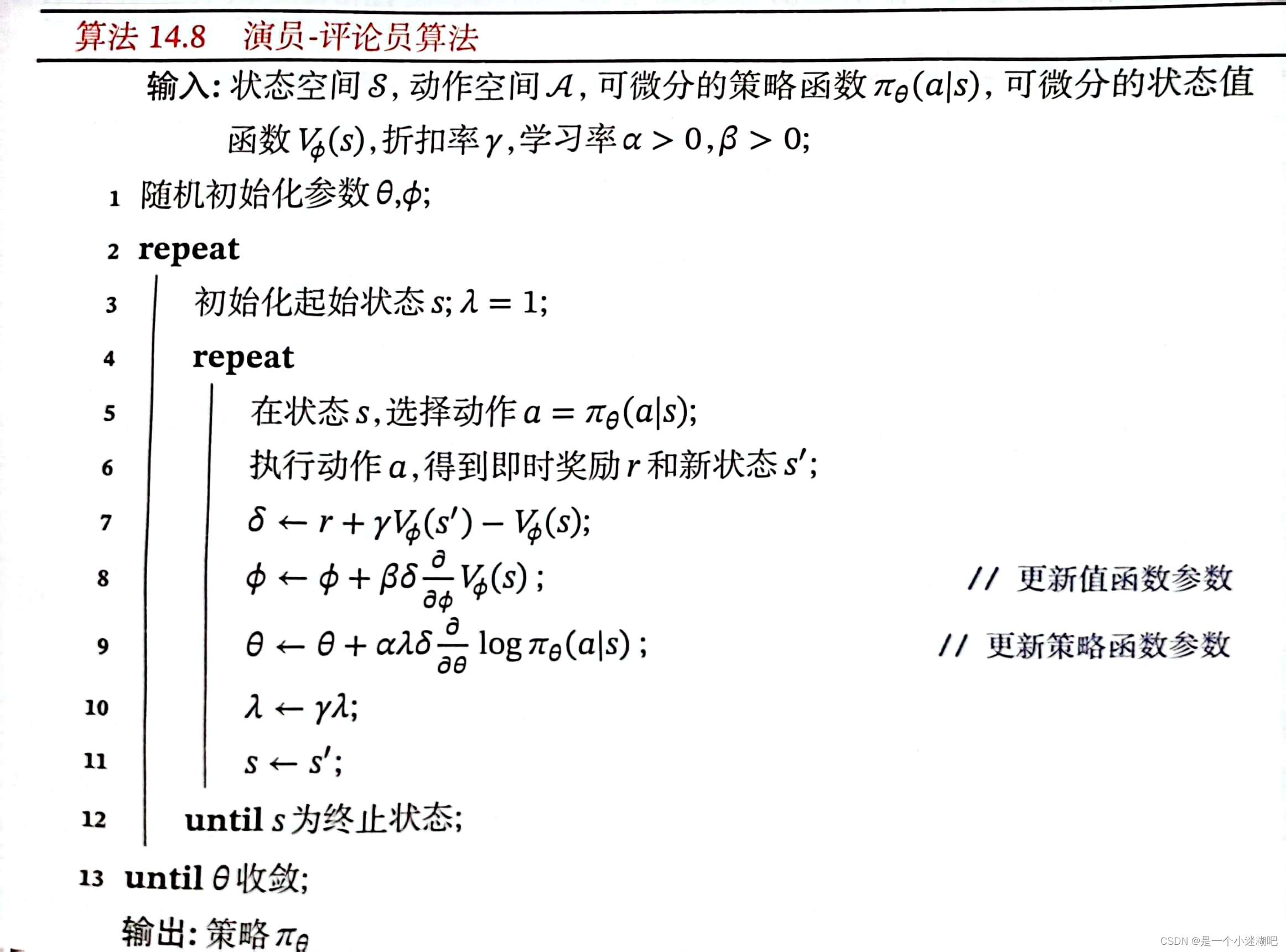

算法14.7 带基准线的REINFORCE算法

算法 14.8 演员-评论员算法

第十五章 序列生成模型

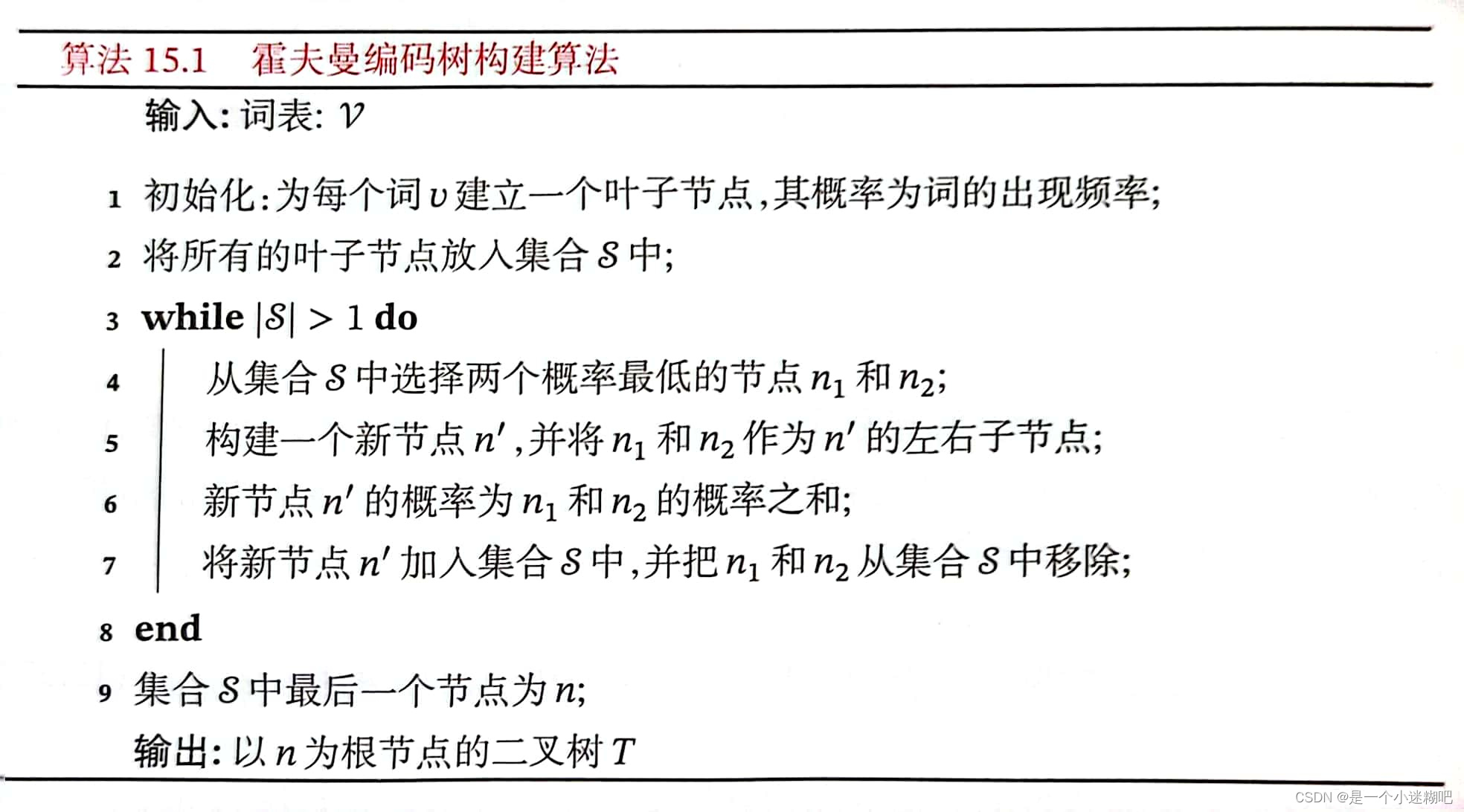

算法15.1 霍夫曼编码树构建算法

本文详细介绍了各种机器学习算法,包括线性模型、前馈神经网络、优化与正则化策略、独立学习方式、概率图模型、深度信念网络、深度生成模型和强化学习。特别地,涵盖了感知器、反向传播、AdaBoost、生成对抗网络和策略迭代等关键算法,为读者提供全面的算法理解与应用指导。

本文详细介绍了各种机器学习算法,包括线性模型、前馈神经网络、优化与正则化策略、独立学习方式、概率图模型、深度信念网络、深度生成模型和强化学习。特别地,涵盖了感知器、反向传播、AdaBoost、生成对抗网络和策略迭代等关键算法,为读者提供全面的算法理解与应用指导。

1459

1459

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?