在本章中,我们将介绍张量网络方法核心概念:定义张量本身及其操作的最常见部分。

我们还将介绍利用张量网络研究多体问题的一些最成功的算法:重新表述平均场方法。

在这个新的形式中介绍矩阵乘积状态(MPS)和在前一章中提出的DMRG的重新表述。

并提出了一些算法来模拟一维多体量子系统的基态性质和含时演化。

回顾了MPS到最直接的层次结构、树张量网络(TTN)及其优化算法的推广。

more to be Reviewed:

Tensor Contraction (0) : Introduction to TN-CSDN博客

Tensor Contraction (1) : Decompositions, Gauge Freedom, Canonical Forms-CSDN博客

一文解释 PyTorch求导相关 (backward, autograd.grad) - 知乎 (zhihu.com)

0. Tensor Introduction:

(1)Tensor Definition:

* WaveFunction & Operator:

=> 指标 :N个协张量指标,M个张量指标。

一个协张量指标 可以 消去一个对应的张量指标

=> //

(数据工程师老是喜欢用后面的简记...)

=> //

(np.einsum会处理好一切的)

=> (总之,记好哪些指标是待求和的, ' 投影 ' 之说法很重要)

(2)Tensor Manipulation:

* Index Fusion and Splitting:

=> 张量形式上是一群数的组织,用于完成各种映射

=> Rank_n张量可以按照给定的(可逆的)规则重新排列在不同秩的张量中

=> Reshape:约化密度矩阵(偏迹), TT-Decompose

* Compression:

=> SVD 截断 奇异值(M * N ~ M * N)// 估上限 sum_m,d^N-1:Ui \epsilon Vi = Const

=> NRG(M^2 * M^2 ~ M * M)

=> MPS ( d^N ~ Nd ) 特有的 平移不变性

* Differentiation of TensorNetwork:

=> 张量网络的形式导数:‘移除被导块后的剩下的部分’

=> Torch - grad: (值得单开专门一讲)

* Gauge & Transforms:

=> 插入 等距矩阵对 UU\ = I 整体张量 T 不变

=> TT-Compose 有 自动符合正交形式的分解,都是 U

=> 加速内积?中心正交形式!(每个都变成SVD - U) ~ 甩出SV 相当于插入了 SV (SV)\ = I

(3)Tensor Decompose:

* TT - Decompose:

=> 简单来说就是 step k:

=> 自发地形成一个中心正交形式...

=> example:

* Tucker - Decompose:

=> 简单来说就是 core-tensor:SVD ~ Tucker2

=> 将 指标 reshape 成 若干维 对应的矩阵 与 中心张量

=> 对每个 index 交替 获得最优化近似解

=> 机器学习|Tucker张量分解 (zhihu.com)

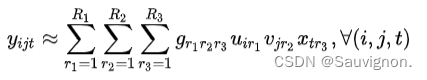

* CP - Decompose:

=> 简单来说就是外积分解

![]()

=> 机器学习 | CP张量分解 - 知乎 (zhihu.com)

(4)Tensor Contracting:(新坑待填)

1. Ground States via Tensor Networks:

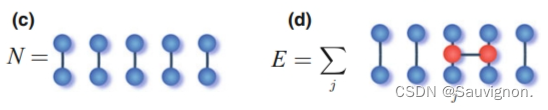

(1)Mean-Field representation:

* N 项 最近邻作用,整理出来的是 N-1 (+1:周期边界) 项 Hamiltonian 的求和

* 全体 H 的 ground state 是各局域 state 的 直积态,每个局域 state 都满足 梯度 = 0

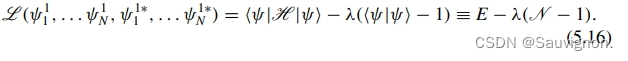

* 每个直积态,最基本的约束 2-范数 归一

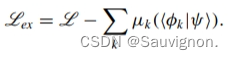

* 综上所述,可列出 Lagrangian:

* 求梯度 = 0,获得有效哈密顿量:

* 必要条件:必须作为当前有效哈密顿量的本征值

* 平均场在 Tensor Network 里几乎干的就是这么些事情:

(1)随机初始化 N 个 Rank-1-Tensor 作为本征矢, 物理指标维数 d

(2)Updating 每轮更新都选取有效哈密顿量的本征值

(3)Sweep the Lattice over and over again... Till the desired precision being reached.

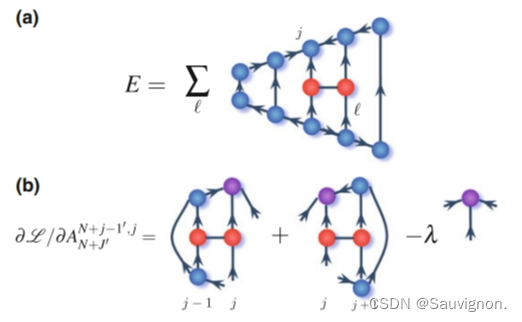

(2)MPS representation:

* reshape 指标簇,执行SVD分解,至每个张量块上 有 一个物理指标 和 两个 辅助指标

* 有:二分分解法,TT - Decompose

* MPS 的更新对象 是 的 Rank-1 Tensors,因此 MPS 也是一种平均场(有精确/非精确之说)

* MPS 在 平均场的框架下 几乎干的就是这件事情:

(1)随机初始化 / 特征初始化 N-sites tensors +(必要时)扩展 tensors 长度

(2)通过(1)形状与 各 近邻 哈密顿量 + 约束 写出 Largerangian,求导得有效Hamiltonian

(3)Updating with 有效Hamiltonian.的 本征向量

* 低激发态:约束就是‘排除法’,目标解是已有eigVect正交的向量

* 平均场与扩展:

(1)问题可以被平均场精确求解 - Auxillary Indexes = 1 ; 不精确 Auxillary Indexes > 1

(2)MPS 可以用于扩展平均场方法(见下文looped与looped-free)

(3)Looped-Free Tensor Networks:

* Indexes - 2:MPO

* Indexes - 3:TTN

* MPO:Variational Ansatz 直接在MPO 的应用很显著

MPO可以将Operators写出紧凑形式

有限温度下有效的多体量子系统,以及一般情况下开放多体量子体系的密度矩阵

* TTN: 任何无圈TensorNetwork 都可以由此表示

1321

1321

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?