前言:

Sam Altman发布OpenAI首个视频生成模型Sora,有着完美的遵循指令的能力,在整个行业引起轰动,其可以很好的理解prompt并实现视频的生成。

Sam Altman发布OpenAI首个视频生成模型Sora,有着完美的遵循指令的能力,在整个行业引起轰动,其可以很好的理解prompt并实现视频的生成。

效果:

开发人员编写的prompt:A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about.

让我们看看生成效果:

建议读者去官网查看生成的视频:

网址:https://openai.com/sora?ref=aihub.cn

画质也是非常好,细节拉满。

该模型对语言有深刻的理解,使其能够准确地解释提示并生成表达生动情感的引人注目的角色。Sora 还可以在单个生成的视频中创建多个镜头,以准确保留角色和视觉风格。

目前的模型有弱点。它可能难以准确模拟复杂场景的物理特性,并且可能无法理解因果关系的具体实例。例如,一个人可能会咬一口饼干,但之后,饼干可能没有咬痕。

该模型还可能混淆提示的空间细节,例如,左右混淆,并且可能难以精确描述随时间推移发生的事件,例如遵循特定的相机轨迹。

Sora 是一种扩散模型,它从看起来像静态噪声的视频开始生成视频,然后通过多个步骤消除噪声来逐渐转换视频。

Sora 能够一次生成整个视频或扩展生成的视频以使其更长。通过让模型一次看到许多帧,我们解决了一个具有挑战性的问题,即确保一个主题即使暂时离开视野也能保持不变。

与 GPT 模型类似,Sora 使用 transformer 架构,释放出卓越的扩展性能。

我们将视频和图像表示为称为补丁的较小数据单元的集合,每个补丁都类似于 GPT 中的一个令牌。通过统一我们表示数据的方式,我们可以在比以前更广泛的视觉数据上训练扩散变压器,跨越不同的持续时间、分辨率和纵横比。

Sora建立在DALL·E 和 GPT 模型。它使用了 DALL·E 3,涉及为视觉训练数据生成高度描述性的标题。因此,该模型能够更忠实地遵循生成视频中用户的文本说明。

除了能够仅根据文本说明生成视频外,该模型还能够获取现有的静止图像并从中生成视频,从而准确无误地对图像内容进行动画处理,并注重小细节。该模型还可以拍摄现有视频并对其进行扩展或填充缺失的帧。

Sora是能够理解和模拟现实世界的模型的基础,我们相信这一能力将是实现AGI的重要里程碑。

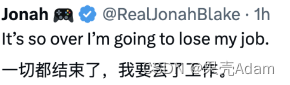

网友直呼,

1367

1367

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?