北京大学 张欣博

原文《Exploiting Rich Syntactic Information for Semantic Parsing with Graph-to-Sequence Model》收录于EMNLP2018

语义解析(Semantic Parsing)将文本转化为逻辑形式或结构化查询(text2logicform),已有很多神经网络方法,学习文本和逻辑形式之间的软对齐进行语义解析,但是大多这类方法通常都是在decoder端的改进,而encoder端常采用简单的序列LSTM进行编码,只考虑词序特征(word-order),忽视了有用的句法信息(syntactic features)。

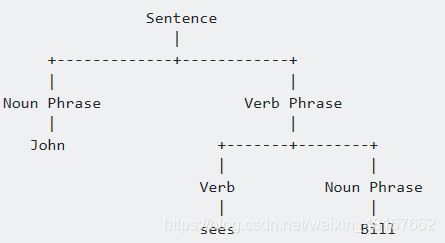

Constituency Parsing成分句法分析

成份句法分析将文本拆分成子短语,可以视为一棵树,非叶子结点是短语的类型,叶子结点是句子中的短语,边上不需额外标签。

Dependency Parsing依存句法分析

依存句法分析将句子解析成语法树,树中的每个节点代表一个单词,子节点是依存于父节点的,边的标签由节点之间的关系定义。

本文引入引入句法图( syntactic graph)的概念,句法图包含了以下三种类型的信息:

• 词序 word order

• 成分句法 constituency feature

• 依存句法 dependency feature

如上给出了句法图的示例。首先将句子里每个单词是一个节点,节点间进行双向互相连接,这样体现了word-order特征。接着根据dependency解析树的结果,将单词之间以有向边连接并指向依赖标签,即加入了dependency特征,代表了单词之间的语法依赖关系。根据constituency解析的结果,把constituent tree中非终止节点以及它们之间的边加入到syntactic graph中,以此体现了句子的constituency特征。

实验在Semantic Parsing的几个Benchmark数据集Jobs640,ATIS和Geo880上进行。使用graph2seq模型(Xu et al. 2018),首先使用graph encoder对syntactic graph进行编码,而后使用RNN+Attention进行解码得到Logical Form。为验证Graph2Seq的有效性,还设计了如下的baseline:用SeqLSTM提取词序信息,用TreeLSTM提取dependency和constituency特征,将这两个模型(词序、语义)的输出都流入到解码器中。

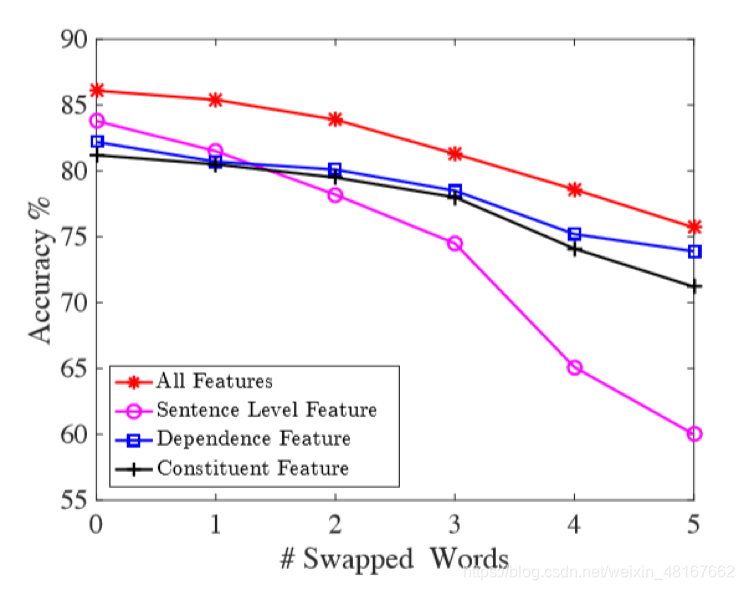

同时对模型进行了鲁棒性的研究,在实验中交换了句子中某些字母,制造“笔误” (swap noise)。

实验结果发现:

1、当这类情况增多时,算法效果降低

2、当这类情况增多时,用三种特征会使算法能力削弱得更慢

3、由于序列特征依赖词序,swap noise对单用这类特征的算法影响最大

3722

3722

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?