数学能力是人类智能的一项基础技能,在自然科学、计算机科学、医学、金融等不同领域都发挥重要作用。因此也是现在评价大模型能力的重要指标。

Benchmark

现在评价大模型数学能力最常用的两个评测数据集分别是MATH和GSM8K

MATH Dataset (2021-03) [1]

MATH数据集是一个由加州大学伯克利分校的研究团队开发的新数据集,专门用于衡量机器学习模型解决数学问题的能力。该数据集包含12,500个来自高中数学竞赛的挑战性问题,每个问题都有一个完整的逐步解决方案,这使得模型可以学习如何生成答案推导和解释。

MATH数据集的问题覆盖了七个主要的数学领域,包括代数、几何、数论等,并且每个问题都标记了难度等级,从1到5,这允许对模型在不同难度和科目上的问题解决能力进行细致的评估。此外,数据集中的问题和解决方案都使用了LATEX和Asymptote语言进行了一致的格式化,使得模型能够处理图形和图表,这是首次在数学问题解决领域中实现。

GSM8K (2021-10, OpenAI) [2]

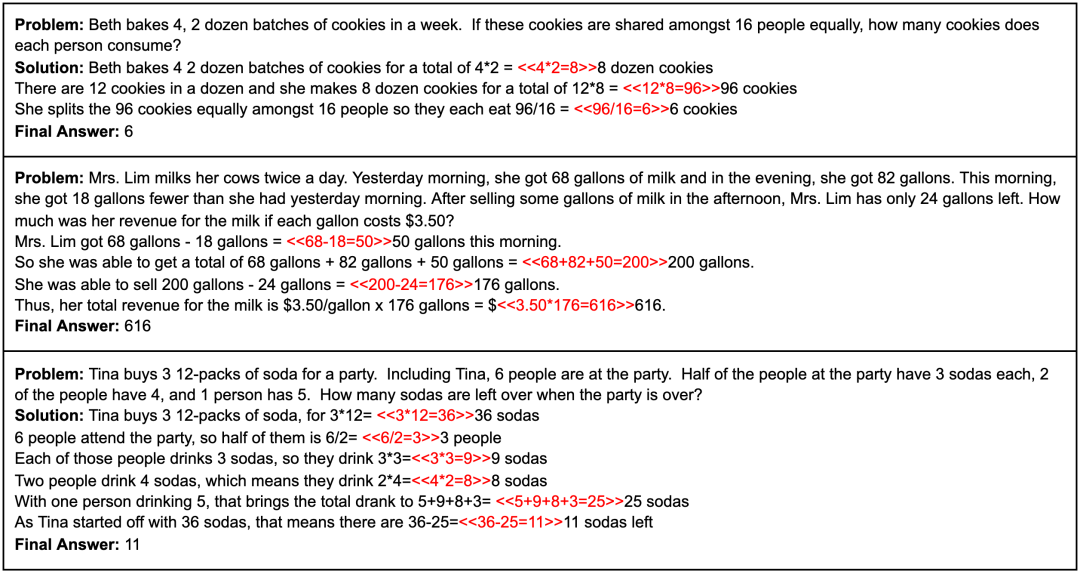

GSM8K数据集是由OpenAI推出的,旨在评估和提升大型语言模型在解决数学文字问题方面的能力。该数据集包含8500个高质量的、语言多样化的小学数学问题,这些问题需要2至8步的计算来解决,主要涉及基本的算术运算。

GSM8K数据集的设计原则包括高质量、高多样性、适中难度和自然语言解决方案。这些问题是由人类问题编写者创建的,并通过广泛的质量控制来确保问题的质量。此外,数据集提供了问题的自然语言解决方案,而不是纯数学表达式,这有助于深入了解大型语言模型的内部推理过程。

WizardMath (2023-08) [3]

文章介绍了一个名为WizardMath的新型大型语言模型,该模型专为提升数学推理能力而设计。WizardMath基于Llama-2模型,通过一种创新的方法——从Evol-Instruct反馈中学习的强化学习(Reinforcement Learning from Evol-Instruct Feedback, RLEIF)进行微调,以增强其在数学问题解决方面的表现。

在方法论上,RLEIF方法包含三个关键步骤

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1752

1752

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?