目录

三、基于中毒的后门攻击(Poisoning-Based Backdoor Attack)

四、基于非中毒行为的后门攻击(Nonpoisoning-Based Backdoor Attacks)

A. Backdoor Attacks and Adversarial Attacks

B. Backdoor Attacks and Data Poisoning

A. Empirical Backdoor Defenses

B. Certifified Backdoor Defenses

B. Semantic and Physical Backdoor Attacks(语义性和物理性的后门攻击):

C. Attacks Toward Other Tasks(对其他任务的攻击):

D. Effective and Effificient Defenses(有效和高效的防御措施):

E. Mechanism Exploration(机制探索):

Abstract

后门攻击:将隐藏的后门嵌入到深度神经网络(DNNs)中,从而使被攻击的模型在良性样本上表现良好,而如果隐藏的后门被攻击者指定的触发器激活,它们的预测将会被恶意地改变。当培训过程没有得到完全控制时,这种威胁就会发生,如对第三方数据集的培训或采用第三方模型,这就构成了一种新的和现实的威胁

文章内容:

1、首次对这一领域进行了全面的调查,根据现有的后门攻击和防御的特点进行了总结和分类

2、为分析基于中毒的后门攻击提供了一个统一的框架

3、分析了后门攻击与相关领域(即对抗性攻击和数据中毒)之间的关系,并总结了被广泛采用的基准数据集

4、在综述的基础上简要概述了未来的研究方向。

在https://github.com/THUYimingLi/backdoor-learning-resources.上也提供了一个与后门相关的资源列表。

一、概述

深度神经网络(DNNs)已成功地应用于许多关键任务中,其安全具有重要意义。一个被充分研究的例子是对抗性的例子[1]-[6],它探索了DNNs在推理阶段的对抗性脆弱性。与推理阶段相比,DNNs的训练包含了更多的步骤,包括数据收集、数据清理与预处理、特征工程、模型选择与构建、训练、模型评估和微调、模型保存和模型部署等。更多的步骤意味着攻击者有更多的机会。同时,众所周知,DNNs的强大的能力明显依赖于大量的训练数据和计算资源。为了降低培训成本,用户可以选择采用第三方数据集,而不是自己收集训练数据,因为有许多公开的数据集;用户也可以基于第三方平台(如云计算平台)训练网络而不是,本地训练;用户甚至可以直接使用第三方骨干或预训练的模型。便利性的成本是在训练阶段失去控制,这可能会进一步扩大培训DNNs的安全风险。对训练阶段的一个典型威胁是后门攻击。

目前,中毒训练样本[7]-[9]是在训练过程中编码后门功能最直接、最广泛采用的方法。例如,如图1所示,一些训练样本通过添加一个攻击者指定的触发器(例如,一个局部补丁)来进行修改。这些带有攻击者指定目标标签的修改样本和剩余的良性训练样本被输入DNNs进行训练。

此外,后门触发器可能是不可见的[10]-[12],中毒样本的源真实标签也可能与目标标签[13]-[15]相一致,从而增加了后门攻击的稳健性。除了直接毒害训练样本外,隐藏的后门还可以通过迁移学习[16]-[18]、直接修改模型参数[19]-[21]、添加额外的恶意模块[22]-[24]来嵌入。换句话说,后门攻击可能发生在培训过程中涉及的所有步骤中。

防御措施可以分为两大类:经验性后门防御、认证性后门防御。

经验后门防御:基于对现有攻击的一些观察或理解提出,在实践中具有良好的性能;然而,有效性没有理论保证,可能会被一些自适应攻击所绕过。

认证后门防御:有效性在理论上得到了保证,而在实践中其性能通常弱于经验防御,因为这些假设通常没有得到满足。

二、准备工作

A、专业术语定义

- 良性模型(Benign model):指在良性环境下训练的模型。

- 受感染模型(Infected model):指具有隐藏后门的模型。

- 中毒样本(Poisoned sample):在基于中毒的后门攻击中用于在训练过程中嵌入后门的改进训练样本。

- 触发器(Trigger):用于生成中毒样本和激活隐藏后门的模式。

- 攻击样本(Attacked sample):用于查询被感染模型的恶意测试样本(带有触发器)。

- 攻击场景(Attack scenario):指可能发生后门攻击的场景。通常发生在用户无法访问或无法控制培训过程时,如使用第三方数据集进行培训、通过第三方平台进行培训、采用第三方模型等。

- 源标签(Source label):表示中毒或受攻击样本的原始标签。

- 目标标签(Target label):攻击者指定的标签。攻击者意图使所有被攻击的样本都被感染模型预测为目标标签。

- 攻击成功率(ASR):表示被感染模型预测为目标标签的被攻击样本的比例。

- 良性样本准确率(BA):表示被感染模型预测的良性测试样本的准确性。

- 攻击者的目标(Attacker’s goal):描述后门攻击者打算做什么。一般情况下,攻击者希望设计一个受感染的模型,在实现高ASR的同时,在良性测试样本上表现良好。

- 能力(Capacity):定义了攻击者/防守者为了达到目标能做什么,不能做什么。

- 攻击/防御方法(Attack/Defense approach):说明了所设计的后门攻击/防御的过程。

B、经典场景和相应的能力

三个经典的现实世界场景,即可能发生的后门威胁,及它们相应的攻击者和防御者的能力,如表一

场景1(采用第三方数据集):在这种场景中,攻击者直接或通过互联网向用户提供有毒的数据集。用户将采用(有毒的)数据集来训练他们的模型,然后进行部署。因此,攻击者只能操作数据集,而不能修改模型、训练计划和推理管道。相比之下,防御者可以在这种情况下操纵一切事情。例如,他们可以清理(有毒的)数据集,以减轻对后门的威胁。

场景2(采用第三方平台):在这个场景中,用户将他们的(良性)数据集、模型结构和培训计划提供给不可信的第三方平台(如谷歌Cloud)来训练他们的模型。虽然提供了良性数据集和训练计划,但攻击者(即恶意平台)可以在实际的训练过程中对其进行修改。但是,攻击者不能改变模型结构,否则用户就会注意到该攻击。相反,防御者不能控制训练集和时间表,而他们可以修改训练后的模型来减轻攻击。例如,他们可以在一个小的本地良性数据集上对其进行微调。

场景3(采用第三方模型):在此场景中,攻击者通过应用程序编程接口(API)或Intert 提供训练有素的受感染DNNs。攻击者可以更改除推理管道之外的一切内容。例如,用户可以在预测前对测试图像引入预处理模块,导致攻击者失控。对于防御者来说,他们可以控制推理管道,也可以在提供其源文件时控制模型;但是,如果他们只能访问模型API,他们就不能修改模型。

三、基于中毒的后门攻击(Poisoning-Based Backdoor Attack)

首先提出一个统一的框架来分析现有的基于中毒的图像分类攻击,基于对攻击属性的理解。然后,根据所提出的框架,对现有的基于中毒的攻击进行了详细的总结和分类。最后还讨论了对其他任务或范式的攻击以及后门攻击的积极应用。由不同类型的后门攻击产生的中毒样本的示例如图4所示。

A、基于中毒攻击的统一框架

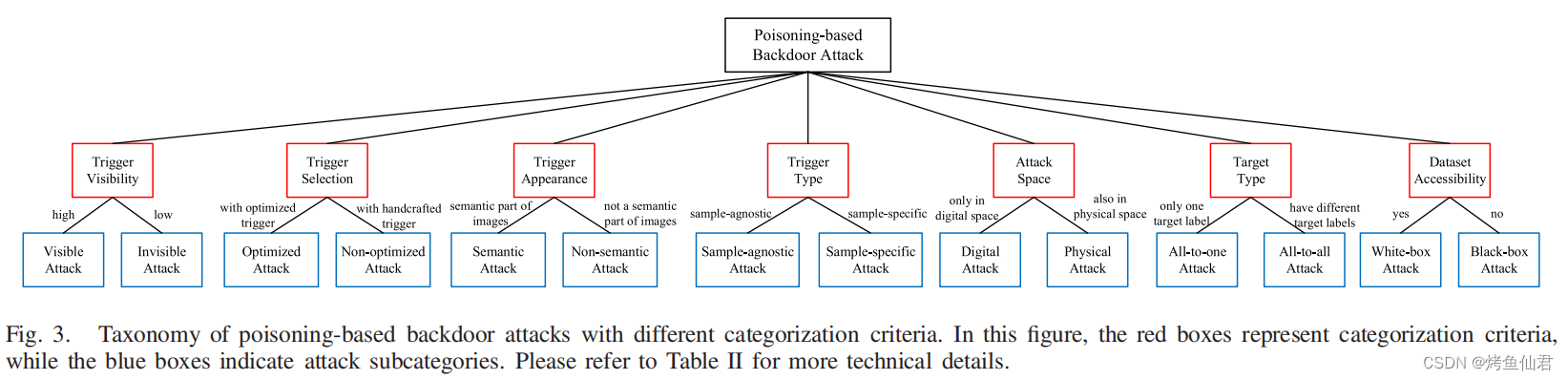

基于中毒的后门攻击可以根据不同的属性相关标准进行分类,如图3所示,总结见表II。更多的细节如下。

分类器:![]() ,其中w为模型参数,

,其中w为模型参数,![]() 为实例空间,

为实例空间,![]() 为标签空间,f (x)表示关于于K类的后验向量,C (x) = arg max fw (x)表示预测的标签。

为标签空间,f (x)表示关于于K类的后验向量,C (x) = arg max fw (x)表示预测的标签。![]() 表示攻击者指定的、触发模式为 t 的中毒图像生成器,

表示攻击者指定的、触发模式为 t 的中毒图像生成器,![]() 是攻击者指定的标签转移函数。

是攻击者指定的标签转移函数。![]() 表示良性数据集,现有后门攻击中涉及的三个经典风险(关于D)可以定义如下。

表示良性数据集,现有后门攻击中涉及的三个经典风险(关于D)可以定义如下。

定义1(标准、后门和可感知风险):

1)标准风险Rs:衡量受感染模型C是否能正确预测良性样本,即度量x的预测(即C(x))是否与它的groud-truth label y相同。它的定义与有标记的数据集DL的关系式为:

![]()

![]() 表示D后面的分布,

表示D后面的分布,![]() 当且仅当事件A发生。

当且仅当事件A发生。

2)后门风险Rb:表示后门触发器是否能成功激活分类器中隐藏的后门。它的定义如下:

![]()

![]() 是被攻击的图像,即有毒样本。

是被攻击的图像,即有毒样本。

3)可感知风险Rp:指有毒样本(即x')是否可以被(人或机器)检测为恶意样本。它的定义如下:

![]()

![]() 当且仅当x‘ 可以被检测为恶意样本。

当且仅当x‘ 可以被检测为恶意样本。

给定一个良性训练集Dt,基于上述定义,可以将现有的基于中毒的后门攻击归纳为一个统一的框架,如下:

![]()

其中![]() ,λ1和λ2是两个非负权衡超参数,而Ds是Dt的一个子集。(|Ds|/|Dt|)为中毒率。

,λ1和λ2是两个非负权衡超参数,而Ds是Dt的一个子集。(|Ds|/|Dt|)为中毒率。

评价:由于在Rs和Rb中使用的指标函数ΙΙ(·)是不可微的,所有在实践中通常使用它的替代损失(如交叉熵函数、KL散度)来替代。优化(4)可以通过不同的规范来表示现有的攻击。

当![]() t未优化(即|Γ|=1)时,则退化为BadNets和Blended Attack。

t未优化(即|Γ|=1)时,则退化为BadNets和Blended Attack。

当![]()

![]() ,则变为

,则变为![]()

此外,参数t和w可以通过多阶段方法同时或单独优化。

注意:这个框架可以很容易地推广到其他任务,比如语音识别。

B、评价指标

为了评估后门攻击在图像分类中的性能,通常采用两个经典的指标,①良性准确率 (BA)和②attack成功率(ASR)。ASR越高,被感染模型与正常模型之间的BA越接近,攻击效果越好。此外,中毒率和良性图像与中毒图像之间的扰动越小,攻击就越隐蔽。

C、对图像和视频分类的攻击

1) BadNets:

如图1所示,其训练过程主要由两个主要部分组成:

①在良性样本集中选取一小部分加入后门触发器,也就是说,将后门触发器印到良性图片x上来获得攻击者指定的标签y相关的投毒样本(x',yt)来生成后门图片x'

②使用有毒样本和良性样本对模型进行训练

训练后的DNN会被感染,在良性测试样本上表现良好,类似于仅使用良性样本训练的模型;但是,如果在一个被攻击的图像中包含相同的触发器,则其预测将被更改为目标标签。这种攻击可能发生在第二节-B中描述的所有场景中,因此,是一种严重的安全威胁。BadNets是可见攻击的代表,几乎所有的后续中毒攻击都是基于该方法进行的。

2)Invisible Backdoor Attacks(隐形后门攻击):

论文:Targeted Backdoor Attacks on Deep Learning Systems Using Data Poisoning

第一次提出了后门的隐蔽性(不可见性),提出怎样去降低后门的可见度(小比例、混合策略、精心设计的模式,第一次讨论了现实中的攻击行为),证明trigger 可以通过不同的形式(甚至高斯噪声)来构成,而不是单一的像素块。

在那之后,有一系列致力于研究隐形后门攻击的作品。Turner等人[13]提出通过后门触发振幅来扰动良性图像的像素值,而不是用所选择的模式替换相应的像素。Zhong等人[37]采用通用对抗性攻击[38]生成后门触发器,使扰动的2范数最小化,以确保不可见性。之后,[11]、[39]和[40]提出了在优化后门触发器时,正则化扰动的p范数。Liu等人[8]提出采用一种共同的现象(即反射)作为稳定的触发器。Nguyen和Tran [41]采用了基于扭曲的触发器,这对人类的检查更看不见。最近,[42]将后门攻击视为一种特殊的多任务学习,它们通过毒害损失计算来实现不可见性。Cheng等[43]提出通过风格转移在特征空间中进行无形攻击。与之前在像素域生成中毒样本的工作不同,[44]和[45]在freq中生成了不可见的触发模式。

在那之后,有一系列致力于研究隐形后门攻击的作品。Turner等人[13]提出通过后门触发振幅来扰动良性图像的像素值,而不是用所选择的模式替换相应的像素。Zhong等人[37]采用通用对抗性攻击[38]生成后门触发器,使扰动的2范数最小化,以确保不可见性。之后,[11]、[39]和[40]提出了在优化后门触发器时,正则化扰动的p范数。Liu等人[8]提出采用一种共同的现象(即反射)作为稳定的触发器。Nguyen和Tran [41]采用了基于扭曲的触发器,这对人类的检查更看不见。最近,[42]将后门攻击视为一种特殊的多任务学习,它们通过毒害损失计算来实现不可见性。Cheng等[43]提出通过风格转移在特征空间中进行无形攻击。与之前在像素域生成中毒样本的工作不同,[44]和[45]在freq中生成了不可见的触发模式。

论文:Label-consistent backdoor attacks

中毒样本的源标签通常与目标标签不同,通过检查训练样本的图像-标签关系,仍然可以检测到一个不可见的攻击。

提出了一种特殊的基于隐形中毒的攻击子类,称为干净标签不可见攻击,增加触发器的隐蔽性,讨论如何减轻数据扩充的反作用。

利用敌对性扰动或生成模型,首先从目标类中修改一些良性图像,然后进行标准的不可见攻击。修改过程是为了减轻中毒样本中包含的“健壮特征”的影响,以确保DNN能够成功地学习到触发器。

具体方法:挑选p%的带有标签的干净样本;使用基于AT的模型对所有选定图像进行非目标对抗性攻击,以减轻“鲁棒特征”的影响。对攻击样本添加触发器;训练。

论文:Hidden trigger backdoor attack

一种新颖的干净标签后门攻击方法,该方法在特征空间中优化与目标图像接近的有毒图像,以增加不可见性;讨论了动态后门攻击。以良性样本训练;产生干净标签的投毒样本;使用生成的中毒样本和良性样本微调模型。

Zhao等人[15]在攻击视频分类时扩展了这一想法,他们采用了通用扰动,而不是一个给定的扰动作为触发模式。查询和Rieck [46]提出通过图像缩放攻击[47]来隐藏触发器。另一种有趣的干净标签攻击方法是通过最小化图像在特征空间中的距离,将前一次可见攻击产生的有毒样本的信息注入到目标类的纹理中,如[14]所示。根据[14]中的设置,Souri等人[48]将后门攻击定义为二层优化[49],并在此基础上提出了一种新的干净标签的后门攻击。最近,舒梅洛夫等人[50]提出,在不改变样本的情况下,通过操纵训练样本的顺序来注入隐藏的后门。

注意:与中毒标签后门攻击相比,干净标签后门攻击的攻击效果通常较低,尽管它们更隐秘。如何平衡攻击的稳定性和有效性仍然是一个有待解决的问题,值得进一步探索。

3)Optimized Backdoor Attacks(优化后门攻击):

触发器是基于中毒攻击的核心。因此,分析如何设计一个更好的触发器,而不是简单地使用一个给定的非优化的触发器具有重要的意义。优化后的攻击通过优化后的触发器生成中毒样本,以获得更好的性能。Liu等人[51]提出了优化触发器,使重要的神经元能够达到最大值。然后,假设如果一个扰动可以诱使大多数样本朝向目标类的决策边界,它将作为一个有效的触发器,[15]、[37]和[52]提出通过通用对抗性扰动产生触发器。这些方法可以看作是上述二层优化的启发式解。最近,[11]、[39]、[40]和[48]直接解决了双层优化问题。例如,[11]、[39]和[40]交替优化上层和底层子问题,而[48]采用梯度匹配[53]。然而,优化后的后门攻击通常泛化性不佳,即过度适合于特定的模型结构或模型状态。虽然现有的工作引入了模型集成或精心设计的交替优化过程来缓解过拟合,但如何更好地平衡优化触发器的有效性和泛化仍然是一个重要的开放问题。

4) Semantic Backdoor Attacks(语义后门攻击):

大多数的后门攻击,即非语义攻击,假设后门触发器独立于良性图像。因此,攻击者需要修改数字空间中的图像,以在推理过程中激活隐藏的后门。这就提出了这样一个问题,即样本的语义部分是否也可以作为触发模式,这样攻击者就不需要在推理时修改输入来欺骗被感染的模型。巴格达沙里扬等人首先探讨了这一问题,并提出了一种新型的后门攻击类型,即[42],[54],即语义后门攻击。具体来说,他们证明了为所有具有特定特征的图像分配一个攻击者选择的标签,例如,绿色汽车或带有赛车条纹的汽车,用于训练,可以在受感染的DNN中创建语义后门。因此,受感染的模型会自动对包含预定义语义信息的测试图像进行错误分类,而不需要对图像进行任何修改。在[55]中也探索了类似的想法,隐藏的后门可以通过图像中某些对象的组合来激活。由于这些攻击不需要修改数字空间中的图像,因此它们更加恶意,值得进一步探索。

5) Sample-Specifific Backdoor Attacks(特定的后门攻击示例):

目前,几乎所有的后门攻击都是样本不可知论的,即所有中毒的样本都包含相同的触发模式。该特性被广泛应用于后门防御的设计,如基于触发合成的防御[25],[56]-[59]和基于显著性的防御[60],[61]。Nguyen和Tran [62]提出了第一个针对特定样本的后门攻击,其中不同的中毒样本包含不同的触发模式。这次攻击绕过了许多现有的后门防御,因为它打破了他们的基本假设。但是,它需要控制训练损失,除了只修改训练样本外,它们的触发器仍然可见,这大大降低了其在现实世界应用中的威胁。在那之后,Li等人[12]受基于DNN的先进图像隐写术的启发,提出了第一个具有不可见触发模式的只有毒药的特定样本的后门攻击。在[63]中也探索了类似的想法,他们在有毒图像的边缘结构中嵌入了触发模式。由于这些攻击可以绕过大多数现有的后门防御,它们构成了严重的安全威胁,因此值得进一步探索。

6)Physical Backdoor Attacks (物理后门攻击):

与之前的数字攻击是完全在数字空间中进行的攻击不同,在物理攻击中生成有毒样本时也涉及到物理空间。Chen等人[10]首先探索了这种攻击,他们采用一副眼镜作为物理触发器,以误导在相机中开发的受感染的面部识别系统。Wenger等人还对物理世界中攻击人脸识别的进一步探索进行了讨论。在[7]中也讨论了类似的想法,在攻击部署在摄像头中的交通标志识别时,使用了便利贴作为触发。最近,Li等人证明了现有的数字攻击在物理世界中失败,因为与用于训练的样本相比,所涉及的转换(例如旋转和收缩)改变了被攻击样本中触发的位置和外观。这种不一致性将大大降低攻击的性能。基于这种理解,他们提出了一种基于转换的攻击增强,以便增强的攻击在物理世界中仍然有效。这种尝试是在真实应用程序中成功进行后门攻击的重要一步。

7) All-to-All Backdoor Attacks(全后门攻击):

根据目标标签的类型,现有的后门攻击可以分为两大类,包括一对一攻击和全能攻击。具体来说,一对一攻击假设所有中毒的样本都有相同的目标标签,无论它们的地面真实标签是什么,即,S (y) = yt,∀y∈{1,...,K}。相比之下,不同的中毒样本在所有攻击中可能有不同的标签。例如,在[7]、[39]和[62]中,标签移动函数被分配为S (y) =(y +1)mod K。全能攻击可以绕过许多面向目标的防御(如[25]、[59]、[61]),以实现复杂的目标转移,因此比一对一攻击更严重。然而,对全能攻击的研究很少。如何更好地设计全能攻击和对其性质的分析仍是空白的。

8) Black-Box Backdoor Attacks(黑盒后门攻击):

与之前需要访问训练样本的白盒攻击不同,黑盒攻击采用了训练集不可访问的设置。在实践中,由于隐私或版权方面的考虑,训练数据集通常不被共享;因此,黑盒攻击比白盒攻击更现实。一般来说,黑盒后门攻击者首先会生成一些替代训练样本。例如,在[51]中,攻击者通过优化从另一个数据集初始化的图像,生成每个类的预测置信度,从而达到最大。利用替代训练样本,可以采用白盒攻击进行后门注入。黑盒后门攻击比白盒后门攻击困难得多,而且在这一领域的工作很少。

D、对其他领域或范式的攻击

目前,大多数针对其他任务或范式的后门攻击仍然是基于毒害的。因此,除了特定任务的要求外,大多数方法都集中在(1)如何设计触发器,(2)如何定义攻击隐身性,(3)如何绕过潜在的防御。不同的任务和模式之间的巨大差异使得上述问题的答案完全不同。例如,在与图像相关的任务中,隐形性可以定义为有毒样本与其良性样本之间的像素距离(如lp范数);然而,在自然语言处理(NLP)中,即使改变一个单词或字符也可能使修改对人类可见,因为它可能导致语法或拼写错误。因此,在与NLP相关的任务中,仅仅是有毒样本和良性样本之间的差异可能并不能作为一个良好的隐身指标。

除图像或视频分类外,自然语言处理是后门攻击中最广泛的研究领域。Dai等人讨论了如何攻击基于LSTM的情感分析。具体来说,他们提出了一种类似BadNets的方法,其中一个情感中立的句子被用作触发器,并被随机插入到一些良性训练样本中。Chen等人进一步研究了这个问题,提出了三种不同类型的触发器(charlevel、word level和sentence level触发器),并取得了不错的性能。此外,Kurita等人证明,即使经过微调,情感分类、毒性检测和垃圾邮件检测也可以被攻击。最近,Chan等人提出了基于条件对敌正则化自编码的潜在空间攻击NLP模型。除了与NLP相关的任务外,一些研究也揭示了对图神经网络(GNN)的后门威胁。通常,攻击者指定的子图被定义为触发器,一旦被攻击样本中包含触发器,受感染的GNN就会预测被攻击图的目标标签。此外,还研究了对其他任务的后门威胁,如强化学习、说话人验证和无线信号分类。

除了经典的训练范式外,如何通过后门进行协作学习,尤其是联邦学习,一直是人们关注的焦点。Bagdasaryan等人通过放大节点服务器的有毒梯度首次引入了针对联邦学习的后门攻击。之后,Bhagoji等人讨论了隐身模型中毒后门攻击,Xie等人提出了一种针对联邦学习的分布式后门攻击。最近,[49]在理论上证实,如果一个模型在温和的联合学习条件下容易受到对抗例子的攻击,后门攻击是不可避免的。此外,还讨论了针对元联合学习[50]和特征分割协作学习[51]的后门攻击。相比之下,[52]、[53]、[54]、[55]、[56]、[57]等著作也质疑联邦学习是否真的容易受到攻击。除了合作学习外,在[7],[58],[16],[17],[59]中也讨论了迁移学习这一重要学习范式的后门威胁。

E、后门攻击好的用途

除了恶意目的外,如何正确地利用后门攻击也得到了一些初步的探索。Adi等人利用后门攻击来验证模型所有权。他们提出通过后门嵌入对DNN进行水印。因此,模型中隐藏的后门可以用来检查所有权,而水印过程仍然保持原有的模型功能。此外,Sommer等揭示了当用户通过基于毒的后门攻击要求删除数据时,如何验证服务器是否真的删除了自己的数据。具体来说,在他们的验证框架中,每个用户使用特定于用户的触发器和目标标签毒害其数据的一部分。因此,在服务器接受用户数据培训后,每个用户都可以在服务器中留下唯一的跟踪,用于删除验证,而对良性模型功能的影响可以忽略不计。Shan等人引入了trapdoor-enabled对抗性防御,防御者通过注入隐藏的后门来防止攻击者发现模型中的自然弱点。这样做的动机是,基于梯度下降的攻击所产生的对抗扰动将会收敛到活板门模式附近,这很容易被防御者发现。Li等讨论了如何保护基于后门攻击的开源数据集。具体来说,他们将这个问题表述为确定数据集是否被用于训练第三方模型。具体来说,他们提出了一种基于假设检验的验证方法,基于良性样本及其相应攻击样本的可疑第三方模型产生的后验概率进行验证。最近,DNN可解释性和可解释AI方法评估也采用了后门攻击。

四、基于非中毒行为的后门攻击(Nonpoisoning-Based Backdoor Attacks)

攻后门攻击也可能发生在其他阶段(例如,部署阶段),而不是简单的数据收集或训练阶段,击者可以直接改变模型的权重,甚至可以改变模型的结构,而无需进行训练过程。这进一步揭示了后门威胁的严重性。

A、面向权重的后门攻击

在面向权值的后门攻击中,攻击者直接修改模型参数,而不是通过对中毒样本进行训练。据我们所知,Dumford和Scheirer [19]提出了第一个面向权值的攻击,他们对预先训练过的模型的权重进行了贪婪搜索。这也是第一次基于非中毒行为的后门攻击。之后,Rakin等人[20]引入了一种面向位级权值的后门攻击,即目标位木马(TBT),它翻转存储在内存中的权值的临界位。该方法取得了显著的性能,攻击者能够通过8800万权重位中的84位翻转,在CIFAR-10数据集[114]上误导ResNet-18 [113]。在[21]中也引入了类似的想法,攻击者可以显著减少嵌入隐藏的后门所需的翻转位。此外,Garg等人[52]提出在良性模型的模型参数上添加对抗性扰动,以注入后门,显示了使用公开使用的训练模型的一种新的安全威胁。最近,Zhang等人[115]将保持良性样本的准确性的行为表述为受感染模型的一致性,并为后门攻击中的对抗性权重扰动(AWP)提供了理论解释。在此基础上,他们还引入了一种新的基于AWP的后门攻击,具有更好的全局和实例一致性。

与以往将后门直接嵌入参数的方法不同,Guo等人[116]提出TrojanNet对通过秘密权重排列激活的受感染dnn中的后门进行编码。具体来说,训练TrojanNet与多任务学习相似,尽管良性任务和恶意任务没有共同的特征。此外,作者还证明了确定模型是否包含触发隐藏后门的排列的决策问题是np完备的,因此,后门检测几乎是不可能的。

B、结构修改的后门攻击

经过结构修改的后门攻击,通过改变良性模型的模型结构,将隐藏的后门注入到良性模型中。这些攻击可能发生在使用第三方模型或在部署阶段时。据我们所知,Tang等人[22]提出了第一个结构修改攻击,他们在训练好的一个恶意后门模块(即一个子后门)插入到目标模型中,用于嵌入隐藏的后门。这种攻击简单而有效,恶意模块可以与所有DNNs相结合。在[23]中也探索了类似的想法,攻击者通过添加包含条件模块和触发检测器的恶意有效负载,将恶意条件逻辑嵌入到目标DNNs中。最近,Qi等人的[24]提出了直接替代,而不是添加一个良性模型的窄子网来进行后门攻击。这种方法在数字场景和物理场景中都是有效的。

五、与相关领域的联系

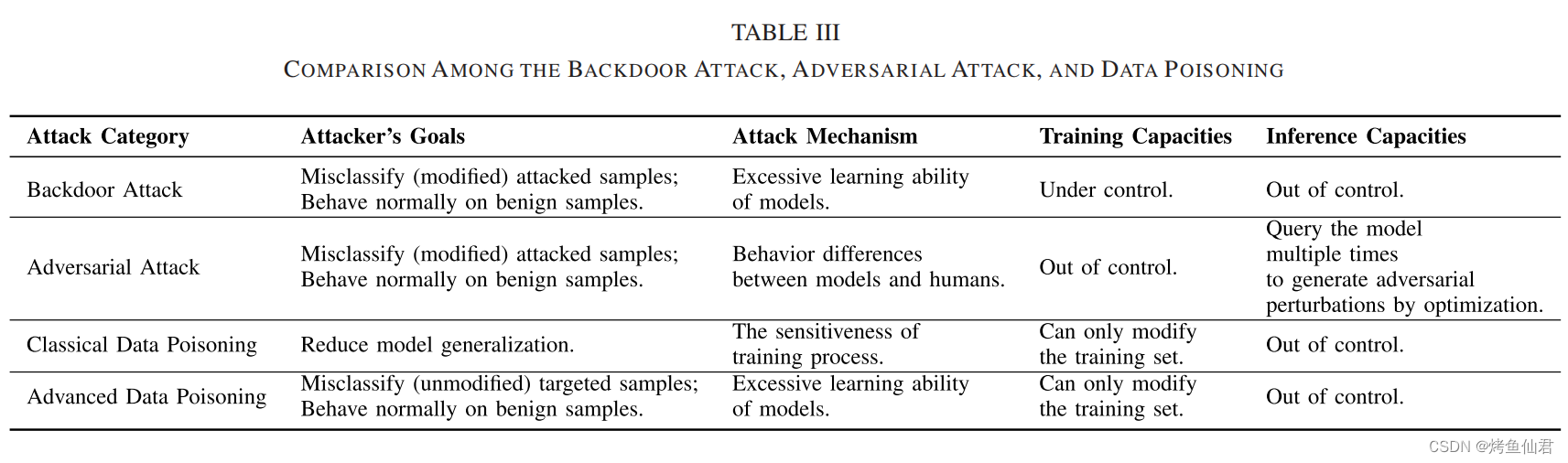

后门攻击和相关领域之间的异同。这些联系总结见表三。

A. Backdoor Attacks and Adversarial Attacks

对抗性攻击和后门攻击都会修改良性测试样本,使模型在推理过程中行为不正常。

当在普遍对抗攻击[38]、[117]、[118]中,对抗扰动是样本不可知的时,这两种攻击似乎相同。

本质区别:

1)攻击者:对抗性攻击者要控制推理过程(需要多次查询模型结果,甚至是梯度,通过给定固定目标模型的优化来产生对抗性扰动),后门攻击者要修改一些训练阶段(例如,数据收集和模型训练)。

2)被攻击样本:后门攻击者已知了扰动(即未优化),而对抗性攻击者则需要通过基于模型输出的优化过程来获得扰动。对抗性攻击中的这种优化需要多个查询。因此,对抗性攻击在许多情况下无法实时进行,因为优化过程需要时间。

3)对抗脆弱性是利用模型和人类行为的差异。后门攻击者利用DNN的过度学习能力,在触发模式和目标标签之间建立了一个潜在的联系。

注意:通过对抗性训练来防御对抗性攻击可能会增加后门攻击的风险。

B. Backdoor Attacks and Data Poisoning

数据投毒:

1)经典投毒:减少模型泛化,即让受感染的模型在训练样本上表现良好,在测试样本上表现较差

2)高级投毒:使受感染的模型在测试样本上表现良好,而在一些不包含在训练集中的攻击者指定的目标样本上表现较差

相似之处:通过在训练过程中引入有毒样本,在推理过程中误导模型。

不同之处:

1)与经典的数据中毒相比,后门攻击保持了预测良性样本的性能(具有不同的攻击者目标)

2)经典数据中毒的有效性主要是由于训练过程的敏感性,因此即使训练样本的一个小的域移也可能导致感染模型的决策面显著不同

3)后门攻击也比经典的数据中毒更隐秘

4)在高级数据中毒中没有触发器,不需要在推理过程中修改目标样本。相应地,高级数据中毒只能对(少数)特定的样本进行错误分类,这限制了它在许多场景下的威胁

注意:对数据中毒的防御可能在防御后门攻击方面也有好处

六、后门防御

后门防御:经验性后门防御、认证性后门防御

A. Empirical Backdoor Defenses

确保后门攻击成功有三个不可缺少的要求,包括:

1)在(被感染的)模型中存在隐藏的后门;

2)在(被攻击的)样本中包含触发器;

3)触发器与后门匹配,如图5所示。

因此,可采用三种主要的防御模式,包括:

1)触发-后门错配;

2)后门消除;

3)触发消除,以抵御现有的攻击。

针对上述范式提出了不同类型的防御,总结见表

1)Preprocessing-Based Defenses(基于预处理的防御):

将样本输入DNN之前引入了一个预处理模块,以改变被攻击样本中包含的触发模式。因此,修改后的触发器不再匹配隐藏的后门,阻止其激活。

Liu等人[119]提出了第一个基于预处理的后门防御,他们采用了一个预训练的自动编码器作为预处理器。受触发区域对预测贡献最大的想法的启发,Doan等人[120]引入了一种两阶段的图像预处理方法(即发热)。在第一阶段,Februus使用GradCAM [165]来识别有影响的区域,然后将其移除,并被一个中和色盒取代。之后,Februus采用基于gan的绘制方法重建掩蔽区域,以减轻其不良影响(如BA下降)。之后,Udeshi等[121]利用图像中的主色在预处理阶段制作一个方形触发器拦截器,定位并去除后门触发器。这种方法的动机是理解,在攻击图像中触发模式的位置放置触发阻断器将显著改变模型预测。比利拉雷亚-瓦斯奎兹和巴尔加瓦·[122]提出通过风格转移对图像进行预处理。最近,Li等人[9]讨论了现有的基于静态触发模式的基于中毒的攻击的特性。他们证明,如果触发器的外观或位置略有改变,攻击性能可能会急剧下降。基于这一观察结果,他们建议采用空间转换(例如,收缩,翻转)来进行防御。与以往的方法相比,该方法的效率更高,因为它几乎不需要额外的计算成本。在[123]中也探索了类似的想法,他们在微调和推理过程中引入并评估了更多的转换。

2) Model Reconstruction-Based Defenses(基于模型重建的防御):

通过直接修改可疑模型来消除受感染模型中隐藏的后门。因此,即使触发器包含在被攻击的样本中,重建的模型仍然会正确地预测它们,因为隐藏的后门已经被移除。

Liu等[119]提出用一些局部良性样本对训练过的可疑模型进行再训练,以减少后门威胁。其有效性主要是由于DNNs [166]的灾难性遗忘,即由于再训练集不包含有毒样本,隐藏的后门逐渐被移除。Zeng等人[129]进一步探索了这一想法,他们将再训练定义为一个迷你最大问题,并采用隐式超梯度来解释内部和外部优化之间的相互依赖关系。由于观察到在预测良性样本时,与后门相关的神经元通常处于休眠状态,Liu等人[124]提出对这些神经元进行修剪,以去除隐藏的后门。具体来说,他们提出了一种精细剪枝方法,首先对DNNs进行修剪,然后对修剪后的网络进行微调,以结合剪枝和微调防御的好处。在[128]中也进一步探索了类似的想法,他们使用对抗性权值扰动(AWP)来放大良性和恶意神经元之间的差异。Zhao等[125]研究表明,基于模式连接技术[167],通过一定数量的良性样本,可以修复受感染DNNs的隐藏后门。最近,Yoshida和Fujino [126]和Li等[127]采用知识蒸馏技术[168]重构(受感染的)DNNs,基于蒸馏过程干扰与后门相关的神经元,从而去除隐藏的后门。

3) Trigger Synthesis-Based Defenses(基于触发器合成的防御):

基于触发器合成的防御除了直接消除隐藏后门外,还提出先合成后门触发器,然后通过抑制合成触发器的影响来消除隐藏后门。这种防御与第二阶段基于模型重构的防御有一定的相似之处。

据我们所知,Wang等人[25]提出了第一个基于触发合成的防御(即神经清理),即防御者首先获得针对每个类的潜在触发模式,然后根据异常检测确定最终的合成触发器及其目标标签。Qiao等人[130]注意到,神经净化合成的反向触发通常与训练过程中使用的反向触发显著不同,他们首先讨论了后门触发的泛化。他们证明了受感染的模型将在训练过程中推广它们的原始触发器。因此,他们提出恢复触发器分布,而不是基于最大熵阶梯近似器的防御的特定触发器。在[131]中也讨论了类似的想法,他们提出了一种基于GAN的合成触发分布。在[57]中,他们展示了用于确定[25]中合成触发器的检测过程存在几种失效模式,在此基础上,他们提出了一种新的防御方法。此外,Cheng等人[132]发现,激活值的![]() 范数可以基于合成触发器来区分与后门相关的神经元。因此,他们提出进行基于

范数可以基于合成触发器来区分与后门相关的神经元。因此,他们提出进行基于![]() -的神经元剪枝,以去除具有高激活值的神经元,以响应触发器。同样,Aiken等人[133]也提出从另一个角度,根据合成触发器,通过修剪DNN来去除隐藏的后门。此外,Shen等[58]提出了一种有效的基于触发合成的防御。与之前的防御需要为每个类生成所有潜在的触发器不同,这种防御在每一轮中只选择一个类进行触发优化,受到K-Arm强盗[169]的启发。最近,Hu等人[137]设计了一个拓扑结构来改进触发器合成。请注意,以前的防御都是白框,要求防御者能够访问模型源文件。最近,一些基于黑盒合成的黑盒防御[59],[136]也被提出,其中防御者可以逆转触发模式,即使他们只能获得模型预测(例如,概率向量或预测标签)。

-的神经元剪枝,以去除具有高激活值的神经元,以响应触发器。同样,Aiken等人[133]也提出从另一个角度,根据合成触发器,通过修剪DNN来去除隐藏的后门。此外,Shen等[58]提出了一种有效的基于触发合成的防御。与之前的防御需要为每个类生成所有潜在的触发器不同,这种防御在每一轮中只选择一个类进行触发优化,受到K-Arm强盗[169]的启发。最近,Hu等人[137]设计了一个拓扑结构来改进触发器合成。请注意,以前的防御都是白框,要求防御者能够访问模型源文件。最近,一些基于黑盒合成的黑盒防御[59],[136]也被提出,其中防御者可以逆转触发模式,即使他们只能获得模型预测(例如,概率向量或预测标签)。

4) Model-Diagnosis-Based Defenses(基于模型诊断的防御):

基于模型诊断的防御通过训练后的元分类器判断所提供的模型是否被感染,并拒绝部署被感染的模型。由于只使用良性模型进行部署,因此自然消除了隐藏的后门。

据我们所知,Kolouri等人[26]首先讨论了如何诊断一个给定的模型。具体来说,他们联合优化了一些通用石蕊模式(ULPs)和一个元分类器,该分类器基于获得的ULPs预测进一步用于诊断可疑模型。与之前的防御模型和良性模型都需要感染模型来训练元分类器不同,有效的元分类器只能在基于[138]提出的策略的良性模型上训练。此外,由于观察到良性模型和受感染模型的热图具有不同的特征,Huang等人[60]基于生成的显著性图的三个提取特征,采用了离群值检测器作为元分类器。在[139]中,他们设计了一个单像素的签名表示,并以此来区分良性和受感染的模型。此外,Wang等人[140]还讨论了如何在数据有限和无数据的病例中检测一个给定的模式是良性的还是感染的。最近,[141]发现良性模型和受感染的dnn具有显著的拓扑结构差异,可用于诊断可疑模型。

5) Poison Suppression-Based Defenses(基于毒抑制的防御):

基于毒素抑制的防御在训练过程中降低了中毒样本的有效性,以防止隐藏后门的产生。

Du等人[143]首先探索了基于毒药抑制的防御,他们采用噪声SGD来学习不同的私有dnn来进行防御。由于训练过程的随机性,随机噪声降低了中毒样本的恶意影响,防止了后门的产生。

6) Training Sample Filtering-Based Defenses(基于训练样本过滤的防御):

这些防御旨在从训练数据集中过滤有毒的样本。过滤过程结束后,在训练过程中只使用良性样本或纯化的有毒样本,从而消除了来自源的后门创建。

7) Testing Sample Filtering-Based Defenses(基于测试样本过滤的攻击):

这些防御也会过滤恶意样本,而过滤则发生在推理过程中,而不是发生在训练过程中。只有良性测试或纯化的攻击样本将被部署的模型预测。这些防御可以防止后门激活,因为它们可以删除触发模式。

B. Certifified Backdoor Defenses

尽管已经提出了多种经验后门防御方法,并且对以前的攻击取得了不错的性能,但几乎所有这些方法都被更强的自适应攻击所绕过。为了终止这种猫鼠游戏,Wang等人在基于随机平滑技术的认证后门攻击防御方面迈出了第一步。随机平滑最初是为了证明针对对抗性例子的鲁棒性,其中平滑函数是通过在数据向量中添加随机噪声来从基函数构建,以证明分类器在一定条件下的鲁棒性。Wang等人将分类器的整个训练过程作为基函数,推广经典随机平滑,防范后门攻击。Weber等人证明了直接应用随机平滑,不会提供高认证的鲁棒边界。相反,他们提出了一个统一的框架,检验了不同的平滑噪声分布,并提供了鲁棒性界限的紧密性分析。

C. Evaluation Metrics(评价指标)

1)类似于检测的经验防御的评估度量:基于模型诊断的防御和基于测试样本过滤的防御都是类似检测的方法,其主要目标是识别(不可信的)对象(如经过训练的DNN或测试图像)是否具有恶意。这本质上是一个二元分类问题。通常采用(1)准确率、(2)召回率和(3)F1score三个指标来评价他们的表现。准确率、召回率和f1得分越高,攻击表现越好。

2)非检测类经验防御的评估度量:除了类检测的经验防御外,其他类型的经验防御,包括基于预处理的防御、基于模型重构的防御、基于触发合成的防御、基于毒素抑制的防御、基于训练样本过滤的防御,都是非类检测的防御。他们的主要目标是对良性样本和受攻击样本进行正确的预测。因此,也采用良性准确率和攻击成功率(定义见第II-A节)进行评价。特别是,虽然检测过程也涉及到基于训练样本过滤的防御,但上述三个指标(即准确率、召回率和F1score)不适合进行评估。这些防御可能会尝试丢弃尽可能多的有毒样本,以减少在过滤后的数据集上创建隐藏后门的可能性,甚至牺牲某些良性样本。

3)认证后门防御的评估指标:如第VI-B节所述,现有认证后门防御均采用随机平滑技术。这些方法可以提供一个认证半径,在这个认证半径下,球内的所有扰动都不会改变模型在某些假设下的预测。人们通常使用(1)良性准确率、(2)认证率和(3)认证准确率作为评价指标[24]、[25]。具体来说,良性准确率表明(平滑的)分类器在分类良性样本时的表现如何;认证率是指在半径大于认证半径的情况下,能够认证的样品的比例;认证准确率是指在半径大于认证半径的情况下,测试集被正确分类并被认证为鲁棒性的部分。良性准确率、认证率和认证准确率越高,攻击性能越好。

七、基准数据集

与对抗性学习相似,现有的相关文献大多集中在图像识别任务上。在本节中,我们总结了所有在表五的相关文献中至少使用过两次的基准数据集。这些基准数据集可以分为三大类,分别是自然图像识别、交通标志识别和人脸识别。第一种类型的数据集是图像分类领域的经典数据集,而第二种和第三种数据集是需要严格安全保证的任务。我们建议未来的工作应该评估这些数据集,以促进比较和确保公平。

八、未来方向展望

A. Trigger Design(触发器设计)

基于中毒的后门攻击的有效性和效率与其触发模式密切相关。然而,大多数现有攻击的触发器都是以启发式设计的(例如,使用通用扰动设计),甚至是一种非优化的方式设计的。如何更好地优化触发模式(例如,基于双层优化)仍然是一个重要的开放问题。此外,在触发器设计中只考虑了有效性和触发器的不可见性。其他标准,如最低中毒率和触发泛化,也值得进一步探索。

B. Semantic and Physical Backdoor Attacks(语义性和物理性的后门攻击)

在实际场景中,语义攻击和物理攻击对人工智能系统的威胁更为严重,而与其他类型的后门攻击相比,他们的研究却远远落后于后者。更深入的研究以更好地了解这些攻击,将是在实践中减轻后门威胁的重要步骤。例如,人们可以探索其他的物理现象(例如,特定的照明),是否也可以作为有效的物理触发模式,以及为什么语义触发也有效。

C. Attacks Toward Other Tasks(对其他任务的攻击)

后门攻击的成功很大程度上依赖于根据目标任务特征的触发设计。例如,触发器的视觉不可见性是视觉任务中的关键标准之一,它确保了稳定性。然而,在不同的任务中,后门触发器的设计可能是完全不同的(例如,当攻击与nlp相关的任务时,将触发器隐藏在句子中的触发器与在图像中隐藏触发器是完全不同的)。因此,有必要研究任务指定的后门攻击。目前,现有的后门攻击主要集中在计算机视觉任务上,特别是图像分类任务。对其他任务(如推荐系统、语音识别和NLP)的研究尚未得到很好的研究。此外,回归作为另一个重要的范式值得更多的关注和幕后探索。

D. Effective and Effificient Defenses(有效和高效的防御措施)

尽管已经提出了许多类型的经验性后门防御(如第六节所示),但几乎所有的后门防御都可以被随后的自适应攻击所绕过。此外,除了基于预处理的防御外,现有的防御通常需要承受较高的计算成本。应进一步努力设计有效和有效的防御(如分析现有攻击的弱点以及如何减少防御的计算成本),以跟上后门攻击的快节奏。例如,它可以基于可解释的AI(XAI)方法来定位触发模式或恶意隐藏特征。此外,如何设计黑箱防御也值得进一步关注,因为这些方法在现实中更加实用。此外,认证的后门防御很重要,但目前很少研究,值得更多的探索。

E. Mechanism Exploration(机制探索)

后门产生的原理和后门触发器的激活机制是后门学习中的圣杯问题。例如,为什么可以创建隐藏的后门,以及当触发器出现时,在受感染的模型内部发生了什么,这在现有的工作中还没有被仔细研究过。深入了解它们的内在机制可以指导更有效的攻击和防御的设计,以及对DNN的理解。

八、结论

对现有的后门攻击进行了总结和分类,并提出了一个分析基于中毒的后门攻击的统一框架。提出了7个不同的标准来分类现有的攻击。在所有这些攻击中,我们认为语义的、样本特定的和基于黑盒中毒的后门攻击更值得关注,因为它们在实践中更具威胁性。讨论了后门攻击与相关研究领域(即数据中毒和对抗性攻击)之间的关系,并分析了现有的防御措施。具体来说,确定了三种基本的防御模式,并将现有的防御分为八个主要类别。最后说明了经典的基准数据集和潜在的研究方向。

论文学习反思与总结:

回答以下几个问题:

1、什么是后门攻击?

2、后门攻击的三个场景?

3、基于中毒的后门攻击有哪些?

4、基于非中毒行为的后门攻击有哪些?

5、后门攻击和对抗样本攻击以及数据投毒攻击的区别?

6、后面防御的三种模式?

7、经验性后门防御的方法?

8、认证性后门防御的方法?

685

685

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?