目录

支持向量机

1、支持向量机介绍

在机器学习中,支持向量机(SVM,还支持矢量网络)是与相关的学习算法有关的监督学习模型,可以分析数据,识别模式,用于分类和回归分析。

支持向量机方法是建立在统计学习理论的VC维理论和结构风险最小原理基础上的,根据有限的样本信息在模型的复杂性(即对特定训练样本的学习精度)和学习能力(即无错误地识别任意样本的能力)之间寻求最佳折中,以期获得最好的推广能力。

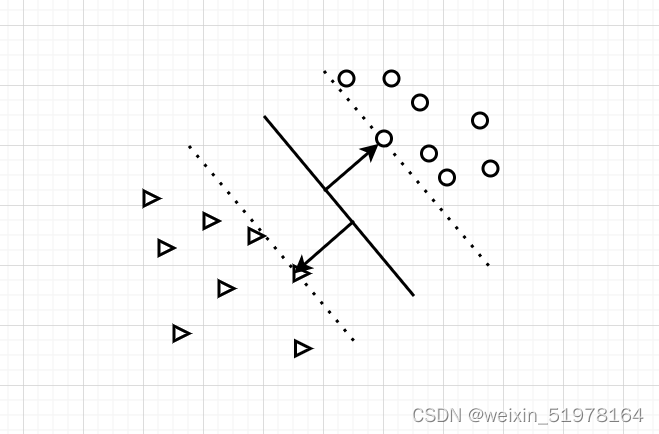

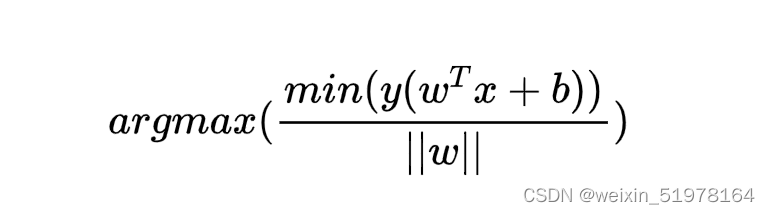

支持向量机将向量映射到一个更高维的空间里,在这个空间里建立有一个最大间隔超平面。在分开数据的超平面的两边建有两个互相平行的超平面。建立方向合适的分隔超平面使两个与之平行的超平面间的距离最大化。

就是选择离中间那条线离上下两种类型的点的最近点的距离之和要最大。

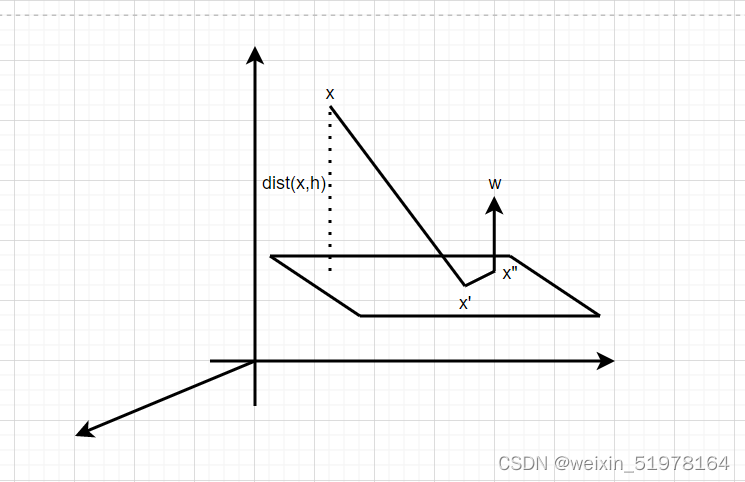

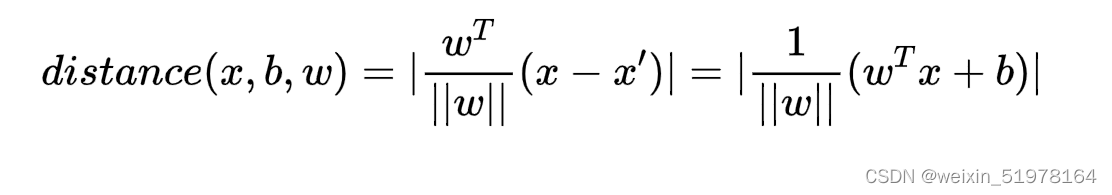

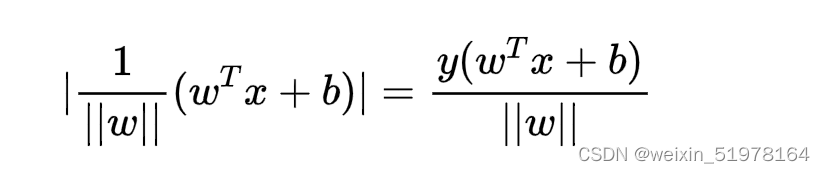

**然后可以拿出点到面的距离来分析公式,作平行线和xx’的投影平行,同时垂直于x’x",首先

之后直线的距离就是x-x’投影到这个面上的直线距离,所以公式如下;

**

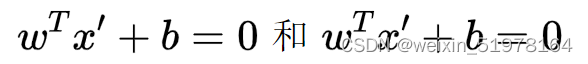

同时我们令Y为样本类别,当X为正例时 Y = 1,X为负例时Y= -1,那么对于决策方程来说y = wx +b,y(x)>0,y = 1 ; y(x)<0,y = -1,所以y(x)y>0,这样就是正数了

将绝对值去掉如上图;所以通过放缩在使得y(w^T+b)>1,优化目标函数

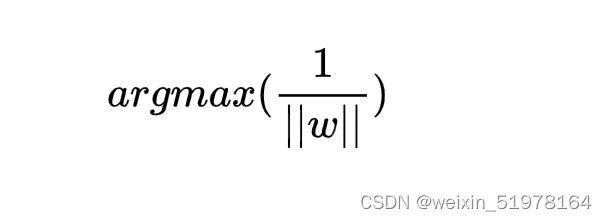

在这个条件下就只用考虑

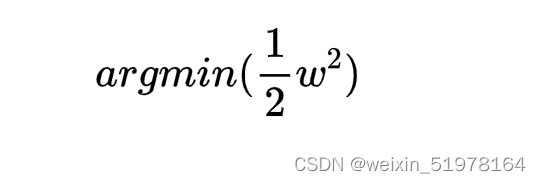

一般都是将极大值改为极小值算,所以上面求w最小值,也就是求如下公式的最小值。

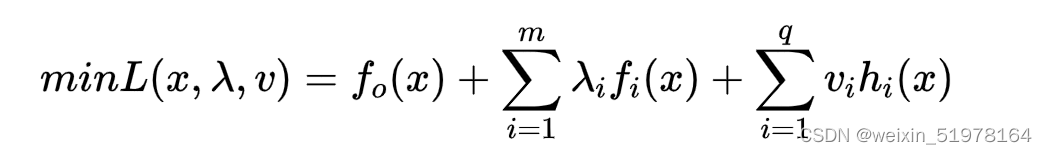

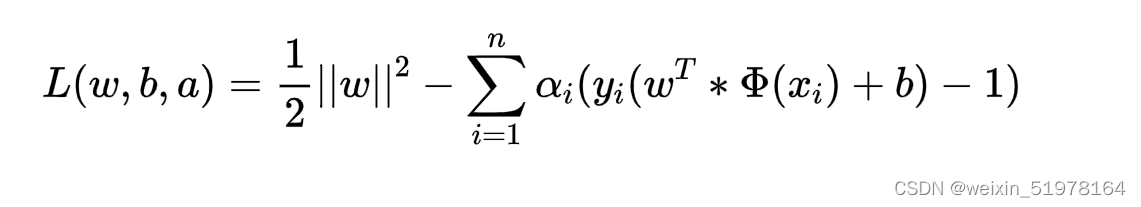

之后就可以用拉格朗日乘子法计算

然后可以求出用w表示a,用b表示a,之后再把w,b用a来代替,最后就可以求出a,之后在把a代入w,b,这不就可以算出w了。

2、支持向量机简单实现

这个是SVM简单实现

# -*- coding: utf-8 -*-

__author__ = 'Wsine'

from numpy import *

import matplotlib.pyplot as plt

import operator

import time

def loadDataSet(fileName):

dataMat = []

labelMat = []

with open(fileName) as fr:

for line in fr.readlines():

lineArr = line.strip().split('\t')

dataMat.append([float(lineArr[0]), float(lineArr[1])])

labelMat.append(float(lineArr[2]))

return dataMat, labelMat

def selectJrand(i, m):

j = i

while (j == i):

j = int(random.uniform(0, m))

return j

def clipAlpha(aj, H, L):

if aj > H:

aj = H

if L > aj:

aj = L

return aj

class optStruct:

def __init__(self, dataMatIn, classLabels, C, toler):

self.X = dataMatIn

self.labelMat = classLabels

self.C = C

self.tol = toler

self.m = shape(dataMatIn)[0]

self.alphas = mat(zeros((self.m, 1)))

self.b = 0

self.eCache = mat(zeros((self.m, 2)))

def calcEk(oS, k):

fXk = float(multiply(oS.alphas, oS.labelMat).T * (oS.X * oS.X[k, :].T)) + oS.b

Ek = fXk - float(oS.labelMat[k])

return Ek

def selectJ(i, oS, Ei):

maxK = -1

maxDeltaE = 0

Ej = 0

oS.eCache[i] = [1, Ei]

validEcacheList = nonzero(oS.eCache[:, 0].A)[0]

if (len(validEcacheList)) > 1:

for k in validEcacheList:

if k == i:

continue

Ek = calcEk(oS, k)

deltaE = abs(Ei - Ek)

if (deltaE > maxDeltaE):

maxK = k

maxDeltaE = deltaE

Ej = Ek

return maxK, Ej

else:

j = selectJrand(i, oS.m)

Ej = calcEk(oS, j)

return j, Ej

def updateEk(oS, k):

Ek = calcEk(oS, k)

oS.eCache[k] = [1, Ek]

def innerL(i, oS):

Ei = calcEk(oS, i)

if ((oS.labelMat[i] * Ei < -oS.tol) and (oS.alphas[i] < oS.C)) or ((oS.labelMat[i] * Ei > oS.tol) and (oS.alphas[i] > 0)):

j, Ej = selectJ(i, oS, Ei)

alphaIold = oS.alphas[i].copy()

alphaJold = oS.alphas[j].copy()

if (oS.labelMat[i] != oS.labelMat[j]):

L = max(0, oS.alphas[j] - oS.alphas[i])

H = min(oS.C, oS.C + oS.alphas[j] - oS.alphas[i])

else:

L = max(0, oS.alphas[j] + oS.alphas[i] - oS.C)

H = min(oS.C, oS.alphas[j] + oS.alphas[i])

if (L == H):

# print("L == H")

return 0

eta = 2.0 * oS.X[i, :] * oS.X[j, :].T - oS.X[i, :] * oS.X[i, :].T - oS.X[j, :] * oS.X[j, :].T

if eta >= 0:

# print("eta >= 0")

return 0

oS.alphas[j] -= oS.labelMat[j] * (Ei - Ej) / eta

oS.alphas[j] = clipAlpha(oS.alphas[j], H, L)

updateEk(oS, j)

if (abs(oS.alphas[j] - alphaJold) < 0.00001):

# print("j not moving enough")

return 0

oS.alphas[i] += oS.labelMat[j] * oS.labelMat[i] * (alphaJold - oS.alphas[j

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1901

1901

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?