神经网络是由具有适应性的简单单元组成的广泛并行互联的网络,它的组织能够模拟生物神经系统对真实世界物体所做出的交互反应。

前世之源

符号主义范式–推理技术

基本目标:模拟智能的功能,将智能功能公理化

人工智能中的符号主义是一种方法论,它将智能视为符号处理的过程,强调符号之间的语义关系和逻辑推理,将智能形式化为严格的数理逻辑体系,基于基本的数学规则,利用计算机强大的搜索功能,严格推导出各项基本结论,智慧的公理化体系,暴力搜索+剪枝,在封闭条件下找到最优解,拼命地加规则;特点与限制。

连接主义范式

连接主义模型的核心概念是受到人类大脑神经元网络的启发,它试图通过模拟神经元之间的连接和信息传递来实现智能

目标:模拟大脑结构

赫布法则:两个神经元总是同时被激活,则期间连接权重增加,如果只有某个神经元单独响应,则其与其它神经元连接权重相应减少

神经网络结构: 连接主义模型通常由多层神经网络组成,每一层由多个神经元节点连接而成,这些连接形成了一个复杂的网络结构。 特点与不足。

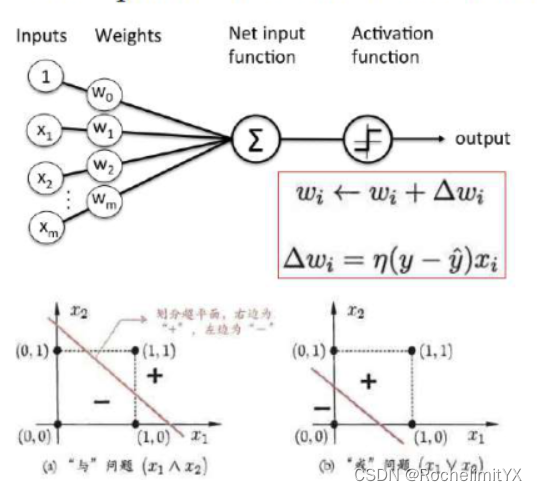

巅峰成果:perceptron=mcculloch-pittsmodel+Learing rule

感知机模型是基于McCulloch-Pitts模型和学习规则的组合构建而成的:

McCulloch-Pitts模型: McCulloch-Pitts模型是神经网络领域的一个早期模型,由Warren McCulloch和Walter Pitts于1943年提出。它描述了一个简单的神经元模型,该模型接收多个输入,并通过加权和激活函数将这些输入组合成一个输出。McCulloch-Pitts模型的输出通常是二进制的(激活或非激活),并且它在某种程度上启发了后来的神经网络模型的发展。

学习规则: 感知机的学习规则是指如何根据输入和期望输出来更新模型的权重。最著名的感知机学习规则是Rosenblatt的感知机学习规则,也被称为感知机算法。该算法通过比较感知机的预测输出和实际输出之间的差异,然后根据差异来更新权重。具体来说,如果感知机的预测错误,它会增加与错误分类的输入相关联的权重,以便下次更好地分类。

因此,感知机模型可以看作是McCulloch-Pitts模型的一种变体,结合了学习规则,使其能够根据训练数据自动调整权重,以便进行二分类任务。感知机模型是神经网络的早期形式,虽然它具有一定的局限性(只适用于线性可分问题),但它为后来更复杂的神经网络模型的发展铺平了道路。

行为主义范式

其灵感来源于心理学中的行为主义学派,行为主义的核心观点是,人的行为可以通过观察和测量外部行为来理解和预测,而不必深入研究内部思维和感觉过程。在人工智能领域,行为主义方法强调构建可以根据输入数据和环境条件做出适当响应的智能系统,而无需模拟或模拟人类的思维过程,和人的行为很像的智能体,所有的东西都是规定好的模式

目标:给思考对象以某种刺激,观察它的反馈,通过研究反馈与刺激的关系来了解对象的特性,而不去纠结对象内部的组织结构

即输入-输出的方法,常常被称为感知-动作的算法;特点与观点。

综述

符号主义:前提为智能全知

连接主义:前提为模仿大脑结构即智能

行为主义:前提为行为模式即智能

感知机及其推导

训练数据集:

{

x

i

,

y

i

}

i=1...n

x

i

∈

(

x

i

1

,

x

i

2

,

.

.

.

,

x

i

d

)

=

R

d

,

y

i

∈

{

1

,

−

1

}

\overset{\text{}}{% \left\{x^i,y^i \right\}% }% \underset{\text{i=1...n}}{}x^i \in(x^{i1},x^{i2},...,x^{id})=R^d,y^i\in \{1,-1\}%

{xi,yi}i=1...nxi∈(xi1,xi2,...,xid)=Rd,yi∈{1,−1}

f

(

∑

i

=

1

n

w

i

x

i

+

b

)

=

f

(

w

T

x

)

f(\sum_{i=1}^{n}w_ix_i+b)=f(\textbf{w}^T\textbf{x})

f(i=1∑nwixi+b)=f(wTx)

其中

w

=

[

w

1

,

w

2

,

w

3

.

.

.

w

n

,

b

]

T

,

x

=

[

x

1

,

x

2

,

.

.

.

x

n

,

1

]

T

\textbf{w}=[w_1,w_2, w_3...w_n,b]^T,\textbf{x}=[x_1,x_2,...x_n,1]^T

w=[w1,w2,w3...wn,b]T,x=[x1,x2,...xn,1]T

f

(

x

)

=

{

+

1

,

if

x

≥

0

−

1

,

if

o

t

h

e

r

w

i

s

e

f(x)=\begin{cases} +1, & \text{if } x \geq0 \\ -1, & \text{if } otherwise \end{cases}

f(x)={+1,−1,if x≥0if otherwise

(即激活函数是硬激活)

感知机模型要发挥作用需要建立在一下两个假设之下:

线性可分假设:

T

h

e

r

e

e

x

i

s

t

s

s

o

m

e

w

∗

∈

R

d

s

u

c

h

t

h

a

t

∣

∣

w

∗

∣

∣

=

1

a

n

d

f

o

r

s

o

m

e

γ

>

0

,

There \, exists\, some \,\textbf{w}^* \in R^d\,such\,that\,||\textbf{w}^*||=1\,and\,for\,some\,\gamma>0,

Thereexistssomew∗∈Rdsuchthat∣∣w∗∣∣=1andforsomeγ>0,

f

o

r

a

l

l

i

∈

{

1

,

2

,

3..

n

}

,

for\,all\,i\in \{1,2,3..n\},

foralli∈{1,2,3..n},

y

i

(

w

∗

.

x

i

)

>

γ

.

y_i(\textbf{w}^*.\textbf{x}^i)>\gamma.

yi(w∗.xi)>γ.

等价来说,也就是:

{

w

T

x

+

b

>

0

,

将他分到正类

y

i

=

1

w

T

x

+

b

<

0

,

将他分到负类

y

i

=

−

1

\begin{cases} w^Tx+b>0, & \text{将他分到正类} y_i=1\\ w^Tx+b<0, & \text{将他分到负类} y_i=-1 \end{cases}

{wTx+b>0,wTx+b<0,将他分到正类yi=1将他分到负类yi=−1

注意将w的范数限制=1是预先定义的,为了保证只有一个解

有界性假设

T

h

e

r

e

e

x

i

s

t

s

R

∈

R

s

u

c

h

t

h

a

t

f

o

r

i

∈

{

1

,

2

,

3...

n

}

There \, exists\,\textbf{R}\in R\,such\,that\,for\,i\in \{1,2,3...n\}

ThereexistsR∈Rsuchthatfori∈{1,2,3...n}

∣

∣

x

∣

∣

i

≤

R

.

||\textbf{x}||^i \leq \textbf{R}.

∣∣x∣∣i≤R.

算法步骤

k

←

1

;

w

k

←

0.

k\leftarrow1;\textbf{w}_k\leftarrow0.

k←1;wk←0.

while:当仍然存在

i

∈

{

1

,

2

,

.

.

n

}

i\in \{1,2,..n\}

i∈{1,2,..n}使得

y

i

(

w

k

T

.

x

i

)

≤

0.

y_i(\textbf{w}_k^T.\textbf{x}^i)\leq0.

yi(wkT.xi)≤0.

随便挑选一个分错的样本

j

∈

{

1

,

2

,

.

.

.

n

}

满足

y

i

(

w

k

T

.

x

j

)

≤

0.

随便挑选一个分错的样本j\in \{1,2,...n\}满足y_i(\textbf{w}_k^T.\textbf{x}^j)\leq0.

随便挑选一个分错的样本j∈{1,2,...n}满足yi(wkT.xj)≤0.

w

k

+

1

←

w

k

+

y

j

x

j

\textbf{w}_{k+1}\leftarrow\textbf{w}_k+y^jx^j

wk+1←wk+yjxj

k

←

k

+

1

k \leftarrow k+1

k←k+1

返回

w

k

返回\textbf{w}_k

返回wk.

注意线性可分是这样定义的:

y

i

(

w

∗

.

x

i

)

>

γ

.

且

γ

>

0

y_i(\textbf{w}^*.\textbf{x}^i)>\gamma.且\gamma>0

yi(w∗.xi)>γ.且γ>0是一定存在某个w*使得所有的样本满足上述不等式的,故而

y

i

(

w

k

T

.

x

j

)

≤

0

y_i(\textbf{w}_k^T.\textbf{x}^j)\leq0

yi(wkT.xj)≤0意味着该样本在该w下是被分错了的,然后就只选择其中之一进行上述调整,分错了就进行调整,最终由捷布将找到全局极优解

收敛性定理证明

定理:学习算法至多经过 R 2 γ 2 \frac{R^2}{\gamma^2} γ2R2步更新,就可返回一个分类面

证明如下:

∣

∣

w

k

+

1

∣

∣

2

2

=

(

w

k

+

y

j

x

j

)

T

(

w

k

+

y

j

x

j

)

=

(

w

k

T

+

(

y

j

)

T

(

x

j

)

T

)

(

w

k

+

y

j

x

j

)

;

y

j

是一个数,

(

y

j

)

T

=

y

j

||w_{k+1}||_{2}^{2}=(w_k+y^jx^j)^T(w_k+y^jx^j)=(w_k^T+(y^j)^T(x^j)^T)(w_k+y^jx^j);y^j是一个数,(y^j)^T=y^j

∣∣wk+1∣∣22=(wk+yjxj)T(wk+yjxj)=(wkT+(yj)T(xj)T)(wk+yjxj);yj是一个数,(yj)T=yj

=

w

k

T

w

K

+

x

j

T

x

j

+

2

y

j

w

k

T

x

j

,

显然根据线性可分假设,在分类过程中

,

=w_k^Tw^K+x_j^Tx_j+2y_jw_k^Tx_j,显然根据线性可分假设,在分类过程中,

=wkTwK+xjTxj+2yjwkTxj,显然根据线性可分假设,在分类过程中,

(

x

j

,

y

j

)

是误分点

,

故而

y

j

w

k

T

x

j

≤

0

(x^j,y^j)是误分点,故而y_jw_k^Tx_j\leq0

(xj,yj)是误分点,故而yjwkTxj≤0

≤

∣

∣

w

k

∣

∣

2

2

+

∣

∣

x

j

∣

∣

2

2

,

又根据有界性假设

∣

∣

x

∣

∣

≤

R

\leq ||w_k||_2^2+||x^j||_2^2,又根据有界性假设||x||\leq \textbf{R}

≤∣∣wk∣∣22+∣∣xj∣∣22,又根据有界性假设∣∣x∣∣≤R

≤

.

.

.

.

≤

∣

∣

w

1

∣

∣

2

2

+

k

R

2

,

(

w

1

=

0

)

=

k

R

2

\leq ....\leq ||w_1||_2^2+k\textbf{R}^2,(w_1=0)=k\textbf{R}^2

≤....≤∣∣w1∣∣22+kR2,(w1=0)=kR2

又有【

w

∗

w^*

w∗为内在存在可分的那个分类面,所以根据线性可分假设

∣

∣

w

∗

∣

∣

||w^*||

∣∣w∗∣∣=1】

∣

∣

w

k

+

1

∣

∣

=

∣

∣

w

k

+

1

∣

∣

.

∣

∣

w

∗

∣

∣

≥

∣

∣

w

k

+

1

.

w

∗

∣

∣

=

w

k

+

1

T

.

w

∗

=

(

w

k

+

y

j

x

j

)

.

w

∗

||w_{k+1}||=||w_{k+1}||.||w^*||\geq ||w_{k+1}.w^*||=w_{k+1}^T.w^*=(w_k+y^jx^j).w^*

∣∣wk+1∣∣=∣∣wk+1∣∣.∣∣w∗∣∣≥∣∣wk+1.w∗∣∣=wk+1T.w∗=(wk+yjxj).w∗

=

w

k

.

w

∗

+

y

j

x

j

.

w

∗

,

w

∗

为内在存在可分的那个分类面

,

可以把所有点都正确分开

=w_k.w^*+y^jx^j.w^*,w^*为内在存在可分的那个分类面,可以把所有点都正确分开

=wk.w∗+yjxj.w∗,w∗为内在存在可分的那个分类面,可以把所有点都正确分开

显然根据线性可分假设

y

j

w

k

T

x

j

>

γ

显然根据线性可分假设y_jw_k^Tx_j>\gamma

显然根据线性可分假设yjwkTxj>γ

=

w

k

.

w

∗

+

γ

>

w

1

T

w

∗

+

k

γ

=

k

γ

=w_k.w^*+\gamma>w_1^Tw^*+k\gamma=k\gamma

=wk.w∗+γ>w1Tw∗+kγ=kγ

综上有,

k

R

2

>

(

k

γ

)

2

↔

k

<

(

R

2

γ

2

)

综上有,k\textbf{R}^2>(k\gamma)^2 \leftrightarrow k<(\frac{\textbf{R}^2}{\gamma^2})

综上有,kR2>(kγ)2↔k<(γ2R2)

k

k

k为迭代步数

R

\textbf{R}

R,

γ

\gamma

γ为预先确定好的有限值,综上所述,得证。

感知机模型揭示了一个深刻的思想,知识来源于朴素的数据,来源于底层的,无限的,自底而上的数据

神经网络

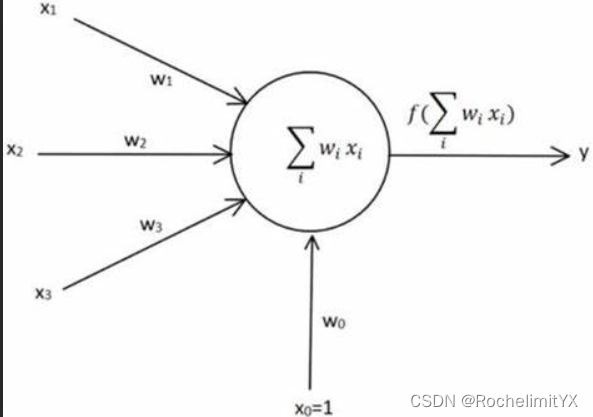

描述一个神经元:

输入为

X

i

X_i

Xi其输出为:

σ

(

w

0

+

∑

i

w

i

X

i

)

=

1

1

+

e

x

p

(

−

(

w

0

+

∑

i

w

i

X

i

)

)

\sigma (w_0+\sum_{i}w_iX_i)=\frac{1}{1+exp(-(w_0+\sum_{i}w_iX_i))}

σ(w0+∑iwiXi)=1+exp(−(w0+∑iwiXi))1

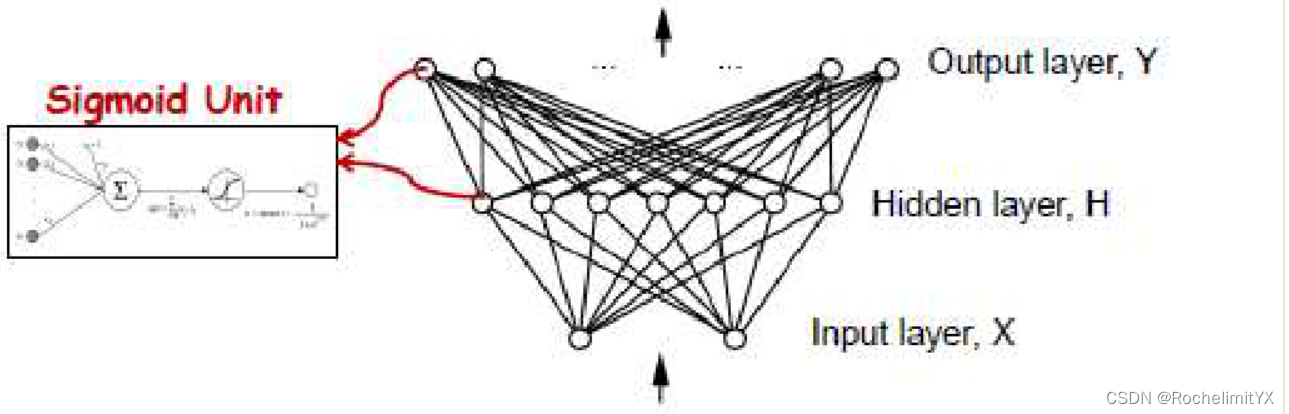

在线性函数无法描述函数结构的情况下,选择神经网络

每一个节点都是一个分类器

每一个节点都是一个分类器

神经网络等于多层分类器的集成

σ ( z ) = 1 1 + e x p ( − z ) \sigma (z)=\frac{1}{1+exp(-z)} σ(z)=1+exp(−z)1函数的求导

σ ′ ( z ) = e x p ( − z ) ( 1 + e x p ( − z ) ) 2 = 1 1 + e x p ( − z ) . e x p ( − z ) 1 + e x p ( − z ) = σ ( z ) . ( 1 − σ ( z ) ) \sigma '(z)=\frac{exp(-z)}{(1+exp(-z))^2}=\frac{1}{1+exp(-z)}.\frac{exp(-z)}{1+exp(-z)}=\sigma (z).(1-\sigma (z)) σ′(z)=(1+exp(−z))2exp(−z)=1+exp(−z)1.1+exp(−z)exp(−z)=σ(z).(1−σ(z))

神经网络的机器学习范式

训练数据集:

D

=

{

x

i

,

y

i

}

i=1...n

;

y

i

∈

{

−

1

,

1

}

(

{

0

,

1

}

)

D=\overset{\text{}}{% \left\{x_i,y_i \right\}% }% \underset{\text{i=1...n}}{};y_i\in \{-1,1\}(\{0,1\})%

D={xi,yi}i=1...n;yi∈{−1,1}({0,1})

学习机(决策函数集):神经网络

策略(找寻损失函数):

min

w

L

(

D

;

w

)

\min\limits_{w}L(D;w)

wminL(D;w),引导更新参数

优化算法:梯度下降

输出函数的基本形式:

y

k

(

x

,

w

)

=

σ

(

∑

j

=

1

M

w

k

j

(

2

)

h

(

∑

j

=

1

D

w

j

i

(

1

)

x

i

+

w

j

0

(

1

)

)

+

w

k

0

(

2

)

)

y_k(\textbf{x},\textbf{w})=\sigma(\sum_{j=1}^Mw_{kj}^{(2)}h(\sum_{j=1}^Dw_{ji}^{(1)}x_i+w_{j0}^{(1)})+w_{k0}^{(2)})

yk(x,w)=σ(j=1∑Mwkj(2)h(j=1∑Dwji(1)xi+wj0(1))+wk0(2))

Forward Propagation

已知样本点,按照给定的参数w,既定的函数形式,计算函数值,前馈

Backpropagation

学习目标:f:X–>Y

回归目标函数:

E

(

w

)

=

1

2

∑

i

=

1

N

∣

∣

y

(

x

n

,

w

)

−

t

n

∣

∣

2

2

E(w)=\frac{1}{2}\sum_{i=1}^N||y(\textbf{x}_n,\textbf{w})-\textbf{t}_n||_2^2

E(w)=21∑i=1N∣∣y(xn,w)−tn∣∣22

分类目标函数:

C

r

o

s

s

E

n

t

r

o

p

y

L

o

s

s

=

−

∑

i

=

1

C

y

i

l

o

g

y

^

i

CrossEntropy Loss=−\sum_{i=1}^{C}y_ilog\hat{y}_i

CrossEntropyLoss=−∑i=1Cyilogy^i

其中

C

C

C 是类别数量,

y

i

y_i

yi 是实际类别分布的概率,

y

^

i

\hat{y}_i

y^i 是模型的预测概率。

目标函数制定原则:光滑,易算

基本思想方法–Gradient Desicent+Error Progpagation

w t + 1 = w t − η ∇ E ( w t ) w^{t+1}=w^t-\eta \nabla E(w^t) wt+1=wt−η∇E(wt)

两种主要的学习模式:批量梯度下降(Batch Gradient Descent)和随机梯度下降(Stochastic Gradient Descent):

批量梯度下降(Batch Gradient Descent):

在批量梯度下降中,每次更新模型参数时,都使用整个训练数据集的数据进行计算梯度和参数更新。

这意味着它对整个数据集的信息进行了全局考虑,因此通常能够更稳定地收敛到局部最小值或全局最小值。

但对于大型数据集而言,计算整个数据集的梯度可能会很慢,因此批量梯度下降的收敛速度较慢。

随机梯度下降(Stochastic Gradient Descent):

在随机梯度下降中,每次更新模型参数时,只使用一个训练样本的数据进行计算梯度和参数更新。

这意味着它对每个样本都进行了单独的参数更新,因此收敛的路径可能会更嘈杂和不稳定。

但由于每次只计算一个样本的梯度,因此随机梯度下降通常比批量梯度下降更快,尤其在大型数据集上。

此外,还有一种折中的方法,称为小批量梯度下降(Mini-Batch Gradient Descent),它在每次更新时使用一小部分(批量)训练样本的数据进行计算梯度和参数更新。这种方法在实际应用中非常常见,因为它综合了批量梯度下降和随机梯度下降的优点,既具有相对稳定的收敛性,又具有较快的更新速度。

选择梯度下降的学习模式通常取决于问题的性质和数据集的大小。通常来说,批量梯度下降在小型数据集上效果较好,而随机梯度下降在大型数据集上更快。小批量梯度下降则是一个常用的通用选择,可以在中等大小的数据集上取得良好的效果。

BP推导:以连续回归问题为例

学习目标函数:

E

(

w

)

=

1

2

∑

i

=

1

N

∣

∣

y

(

x

n

,

w

)

−

t

n

∣

∣

2

2

E(w)=\frac{1}{2}\sum_{i=1}^N||y(\textbf{x}_n,\textbf{w})-\textbf{t}_n||_2^2

E(w)=21∑i=1N∣∣y(xn,w)−tn∣∣22

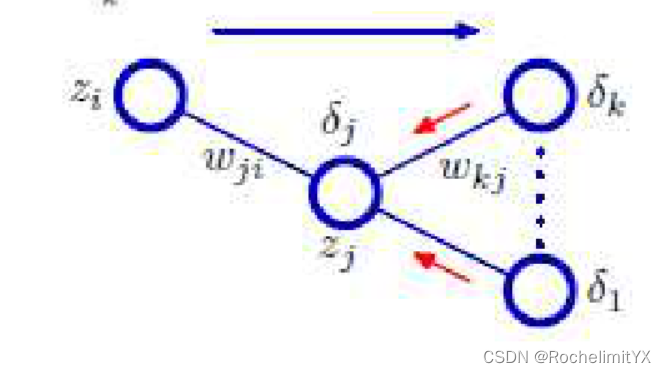

下面以三层神经网络为例,i,j,k三层

L

(

D

;

w

)

=

∑

i

=

1

n

L

w

(

x

i

,

y

i

)

=

∑

i

=

1

n

L

(

f

w

(

x

i

)

,

y

i

)

L(D;w)=\sum_{i=1}^nL_w(x_i,y_i)=\sum_{i=1}^nL(f_w(x_i),y_i)

L(D;w)=∑i=1nLw(xi,yi)=∑i=1nL(fw(xi),yi)

Z

j

=

σ

(

a

j

)

Z_j=\sigma(a_j)

Zj=σ(aj)

a

j

=

∑

i

w

j

i

Z

i

,

w

j

i

只在

a

j

或者

Z

j

里,在其它的神经元中没有

w

j

i

a_j=\sum_iw_{ji}Z_i,w_{ji}只在a_j 或者Z_j里,在其它的神经元中没有w_{ji}

aj=∑iwjiZi,wji只在aj或者Zj里,在其它的神经元中没有wji

∂

L

∂

w

j

i

=

∂

L

∂

Z

j

.

∂

Z

j

∂

a

j

.

∂

a

j

∂

w

j

i

\frac{\partial {L}}{\partial {w_{ji}}}=\frac{\partial {L}}{\partial {Z_j}}.\frac{\partial {Z_j}}{\partial {a_j}}.\frac{\partial {a_j}}{\partial {w_{ji}}}

∂wji∂L=∂Zj∂L.∂aj∂Zj.∂wji∂aj

其中

w

j

i

只存在

a

j

中,

a

j

=

w

j

1

Z

1

+

w

j

2

Z

2

+

.

.

.

w

j

i

Z

i

+

.

.

.

=

∑

i

w

j

i

Z

i

w_{ji}只存在a_j中,a_j=w_{j1}Z_1+w_{j2}Z_2+...w_{ji}Z_i+...=\sum_iw_{ji}Z_i

wji只存在aj中,aj=wj1Z1+wj2Z2+...wjiZi+...=∑iwjiZi

在当前参数下,前向一遍都算出来的

=

∂

L

∂

Z

j

.

σ

(

a

j

)

(

1

−

σ

(

a

j

)

)

.

Z

i

,

又记

∂

L

∂

Z

j

=

δ

j

=\frac{\partial {L}}{\partial {Z_j}}.\sigma(a_j)(1-\sigma(a_j)).Z_i,又记\frac{\partial {L}}{\partial {Z_j}}=\delta_j

=∂Zj∂L.σ(aj)(1−σ(aj)).Zi,又记∂Zj∂L=δj

=

(

∑

k

∂

L

∂

Z

k

∂

Z

k

∂

Z

j

)

.

σ

(

a

j

)

(

1

−

σ

(

a

j

)

)

.

Z

i

每一个

k

都和

Z

j

有关

=(\sum_{k}\frac{\partial {L}}{\partial {Z_k}}\frac{\partial {Z_k}}{\partial {Z_j}}).\sigma(a_j)(1-\sigma(a_j)).Z_i每一个k都和Z_j有关

=(k∑∂Zk∂L∂Zj∂Zk).σ(aj)(1−σ(aj)).Zi每一个k都和Zj有关

=

(

∑

k

∂

L

∂

Z

k

∂

Z

k

∂

a

k

∂

a

k

∂

Z

j

)

.

σ

(

a

j

)

(

1

−

σ

(

a

j

)

)

.

Z

i

=(\sum_{k}\frac{\partial {L}}{\partial {Z_k}}\frac{\partial {Z_k}}{\partial {a_k}}\frac{\partial {a_k}}{\partial {Z_j}}).\sigma(a_j)(1-\sigma(a_j)).Z_i

=(k∑∂Zk∂L∂ak∂Zk∂Zj∂ak).σ(aj)(1−σ(aj)).Zi

=

∑

k

δ

k

σ

(

a

k

)

(

1

−

σ

(

a

k

)

)

w

k

j

∗

.

.

.

.

.

.

=\sum_{k} \delta_k\sigma(a_k)(1-\sigma(a_k))w_{kj}*......

=k∑δkσ(ak)(1−σ(ak))wkj∗......

下一层的导数,可以推出上一层的导数

最后一层时

Z

k

=

∣

∣

f

w

(

x

i

)

−

y

i

∣

∣

2

Z_k=||f_w(x_i)-y_i||^2

Zk=∣∣fw(xi)−yi∣∣2

流程:

forward:前向按照已经给定的

w

j

i

w_{ji}

wji和相应的样本,计算出a和Z;

backward:最后一层梯度前传;计算权重梯度,转到计算节点/每个样本的梯度;此时a,w,Z均为已知

更新权重,再向前传播

反向传播算法流程

*对于网络的一个输入向量

x

n

\textbf{x}_n

xn,使用

a

j

=

w

j

1

Z

1

+

w

j

2

Z

2

+

.

.

.

w

j

i

Z

i

+

.

.

.

=

∑

i

w

j

i

Z

i

a_j=w_{j1}Z_1+w_{j2}Z_2+...w_{ji}Z_i+...=\sum_iw_{ji}Z_i

aj=wj1Z1+wj2Z2+...wjiZi+...=∑iwjiZi 和

Z

j

=

σ

(

a

j

)

Z_j=\sigma(a_j)

Zj=σ(aj)进行正向传播,找到所有隐藏单元

Z

j

Z_j

Zj和输入单元的(激活=

a

j

a_j

aj)[输入单元的激活=

a

j

a_j

aj;输出单元的(激活=

a

k

a_k

ak)

*使用

δ

k

=

y

k

−

t

k

\delta_k=y_k-t_k

δk=yk−tk计算所有输出单元的

δ

k

\delta_k

δk

*使用公式

δ

j

=

σ

′

(

a

j

)

∑

k

w

k

j

δ

k

\delta_j=\sigma'(a_j)\sum_kw_{kj}\delta_k

δj=σ′(aj)∑kwkjδk反向传播

δ

\delta

δ,获得网络中所有隐含单元的

δ

j

\delta_j

δj

*使用公式

∂

E

n

∂

w

j

i

=

δ

j

Z

j

\frac{\partial{E_n}}{\partial{w_{ji}}}=\delta_jZ_j

∂wji∂En=δjZj计算导数

上面的推导中,我们隐式地假设了网络中的每个隐含单元或输入单元都有相同的激活函数sigmod函数。

BP算法的性质

1.BP算法找到的解是?

BP算法寻找的解是一个局部最小值。神经网络通常有多个局部最小值,而不一定能够找到全局最小值。因此,BP算法的结果受到初始参数值的影响,深度网络,局部极优都很难达到

讨论:

E

(

w

)

=

1

2

∑

i

=

1

N

∣

∣

y

(

x

n

,

w

)

−

t

n

∣

∣

2

2

E(w)=\frac{1}{2}\sum_{i=1}^N||y(\textbf{x}_n,\textbf{w})-\textbf{t}_n||_2^2

E(w)=21∑i=1N∣∣y(xn,w)−tn∣∣22损失函数是个二次函数,是凸函数,为啥只能找到局部极小呢?

可行域不是凸的

2.推广能力如何?

感知机,非常容易过拟合;BP算法在训练数据上表现良好的神经网络通常具有较强的泛化能力,能够对未见过的数据做出合理的预测。然而,如果模型过度拟合(过于复杂)训练数据,泛化能力可能会下降。

3.训练速度如何?

训练速度取决于多个因素,包括网络的大小、数据集的大小、计算资源等。通常情况下,BP算法的训练速度相对较慢,尤其是在深度神经网络中,需要大量的计算和迭代,及其消耗资源,背后要付出极大的训练代价。

4.预测速度如何?

一旦神经网络训练完成,其预测速度通常很快。前向传播(Forward Propagation)过程只涉及到一次输入数据的计算,不需要反复迭代。

5.如何加强其推广能力?

为了提高神经网络的泛化能力,可以考虑各种技巧:

收集更多的训练数据,尤其是在数据量有限的情况下;

使用正则化技巧,如L1正则化、L2正则化,以限制模型的复杂度;

采用早停(Early Stopping)策略,及时停止训练以避免过度拟合;

使用更复杂的网络结构,如卷积神经网络(CNN)和循环神经网络(RNN)等,以提高表示能力;

使用数据增强技术,通过扩展训练数据集来增强泛化能力;

选择合适的激活函数和优化器,它们可以对网络的性能产生重要影响。

小结

神经网络的输入和输出可以是空间不同的,输入和输出相关,有因果性,其解释性被忽略了,我们需要再机器学习的本质和内涵上思考它,否则等着被收割

1247

1247

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?