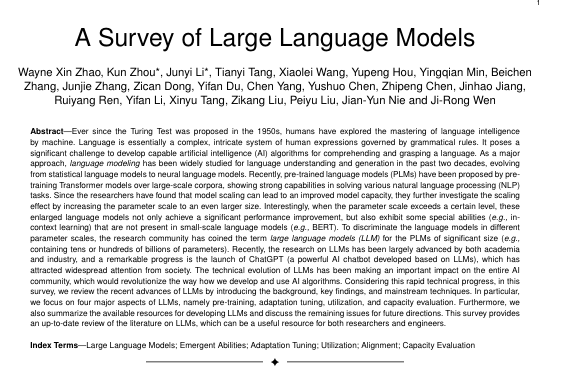

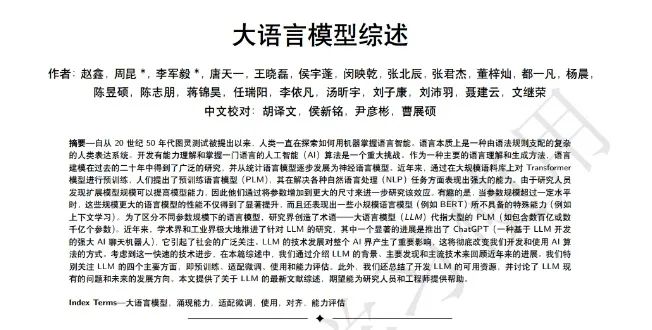

这是人大的一篇大语言模型发展综述,特别好的一篇文章,读后受益良多。这篇文章讨论了机器语言智能的发展,特别是大规模预训练语言模型。详细介绍了从语言模型到统计语言模型,神经语言模型到预训练语言模型的演变。并且不止有一篇工作提出,大规模LLM超出某一参数大小的模型扩展导致了新的能力的涌现,这种现象导致了强大的人工智能聊天机器人的诞生。该综述还强调了评估和了解LLMs的必要性,包括它们的预训练、适应性调整、利用和容量评估。

论文有中英文版本,在下方加小助手获取

目录

-

引入

-

一、摘要 & 介绍

-

二、回顾

-

2.1、背景

-

2.2、LLM 涌现出的能力

-

2.3、LLM 的关键技术

-

2.4、LLM 发展脉络

-

2.5、LLM 模型汇总

-

三、LLMs 资源

-

四、预训练

-

4.1、数据收集

-

4.1.1、数据源

-

4.1.2、数据预处理

-

4.1.3、预训练数据对 LLMs 的影响

-

4.2、网络结构

-

4.2.1、主流架构

-

4.2.2、详细配置

-

4.2.3、预训练任务

-

4.2.4、总结讨论

-

4.3、模型训练

-

4.3.1、优化设置(Optimization Setting)

-

4.3.2、缩放训练技巧(Scalable Training Techniques)

-

五、LLMs 的适配调优

-

5.1、指令微调(Instruction Tuning)

-

5.2、对齐微调(Alignment Tuning)

-

六、利用

-

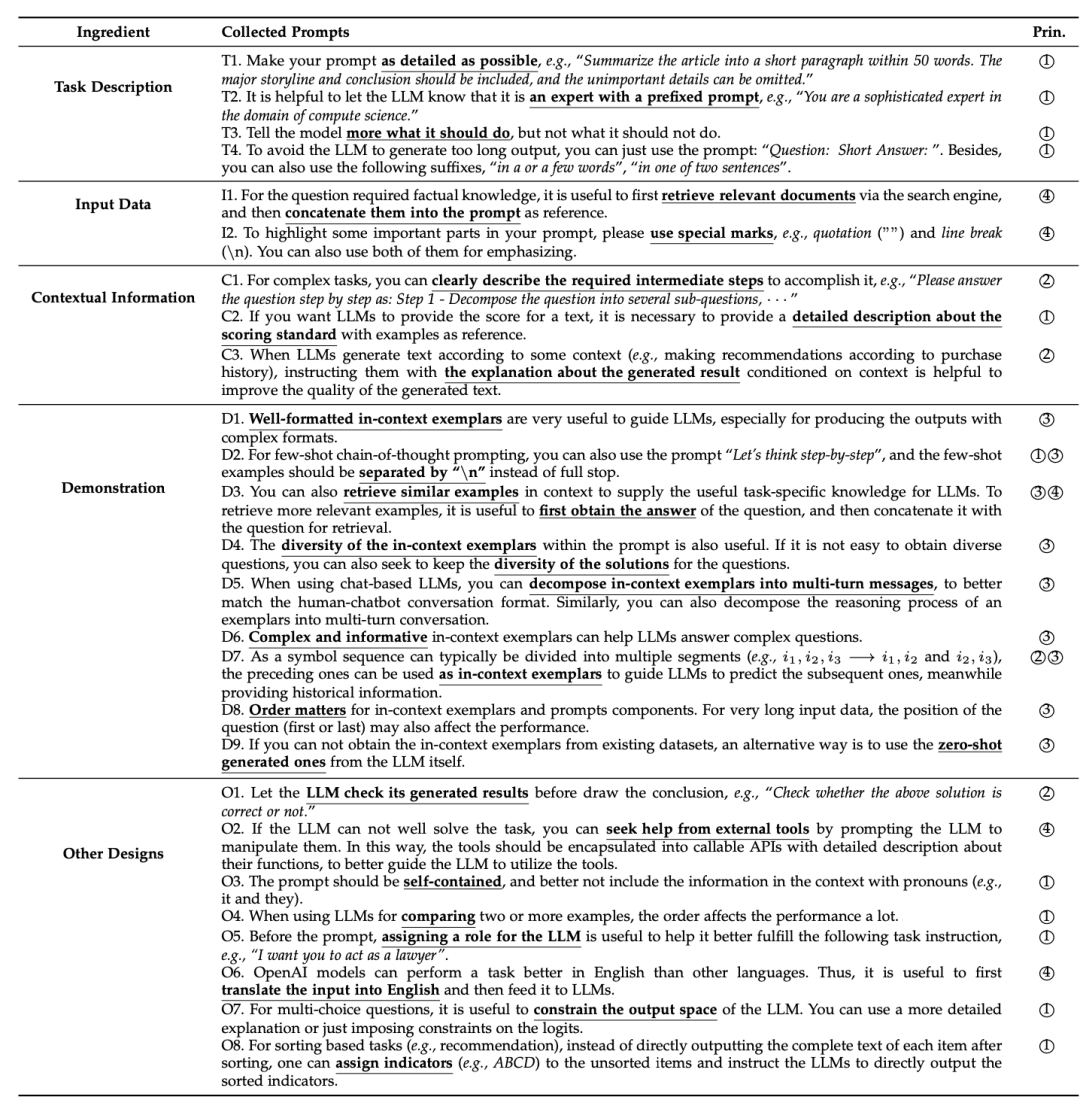

6.1、语境学习(In-Context Learning)

-

6.2、思维链提示(Chain-of-Thought Prompting)

-

七、能力评估

-

7.1、基础任务

-

7.1.1、语言生成

-

7.1.2、知识利用率

-

7.1.3、复杂推理

-

7.2、高级能力评估

-

7.2.1、人类对戏

-

7.2.2、与外部环境的交互作用

-

7.2.3、扩展能力范围

-

7.3、公共基准测试和经验分析

-

7.3.1、评价基准

-

7.3.2、对LLM的能力进行全面分析

-

八、结论和未来方向

-

References

结合文档内容,我再多说几句。

语言模型

大模型的本质是构建一个语言模型来对自然语言建模。

最常见的NLP任务是生成文本,例如,已知几个词,通过语言模型去预测下一个词,GPT系列就是通过自回归方式生成下一个词;或者给出前后几个词,预测中间的词,Bert就是这种类似完形填空的模型。无论是自回归还是完形填空,都被称为基于上下文的文本生成。

语言模型通过预测词典中每个词出现在这个位置的概率来生成文本。

构建语言建模经历了从统计语言模型到现在的神经网络模型。

统计语言模型:马尔科夫链

神经网络模型:RNN,LSTM(ELMO),Transformer(GPT,Bert,T5,LLAMA)。

大语言模型的涌现能力

在计算机视觉领域,通过增加卷积层个数能增加模型提取特征的能力,但随着层数的增加,模型性能增加会逐渐放缓。

但在NLP中,Tranformer打破了CV中的Scale定律,通过扩展模型的大小或者数据量,模型的性能会一直增加下去。且模型超过某个体量后就会出现涌现现象。

涌现现象通常表现在上下文理解能力,指令遵循,逐步推理。

大模型关键技术

预训练:并行训练,分布式训练。

能力引导:使用有监督数据对预训练模型进行微调,使其适应下游任务。

对齐微调:通过强化学习,使其向人类对齐。

扩展:但随着模型的扩展,计算资源消耗也会急剧增长。

论文有中英文版本,在下方加小助手获取:

6万+

6万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?