5.用pytorch实现线性传播

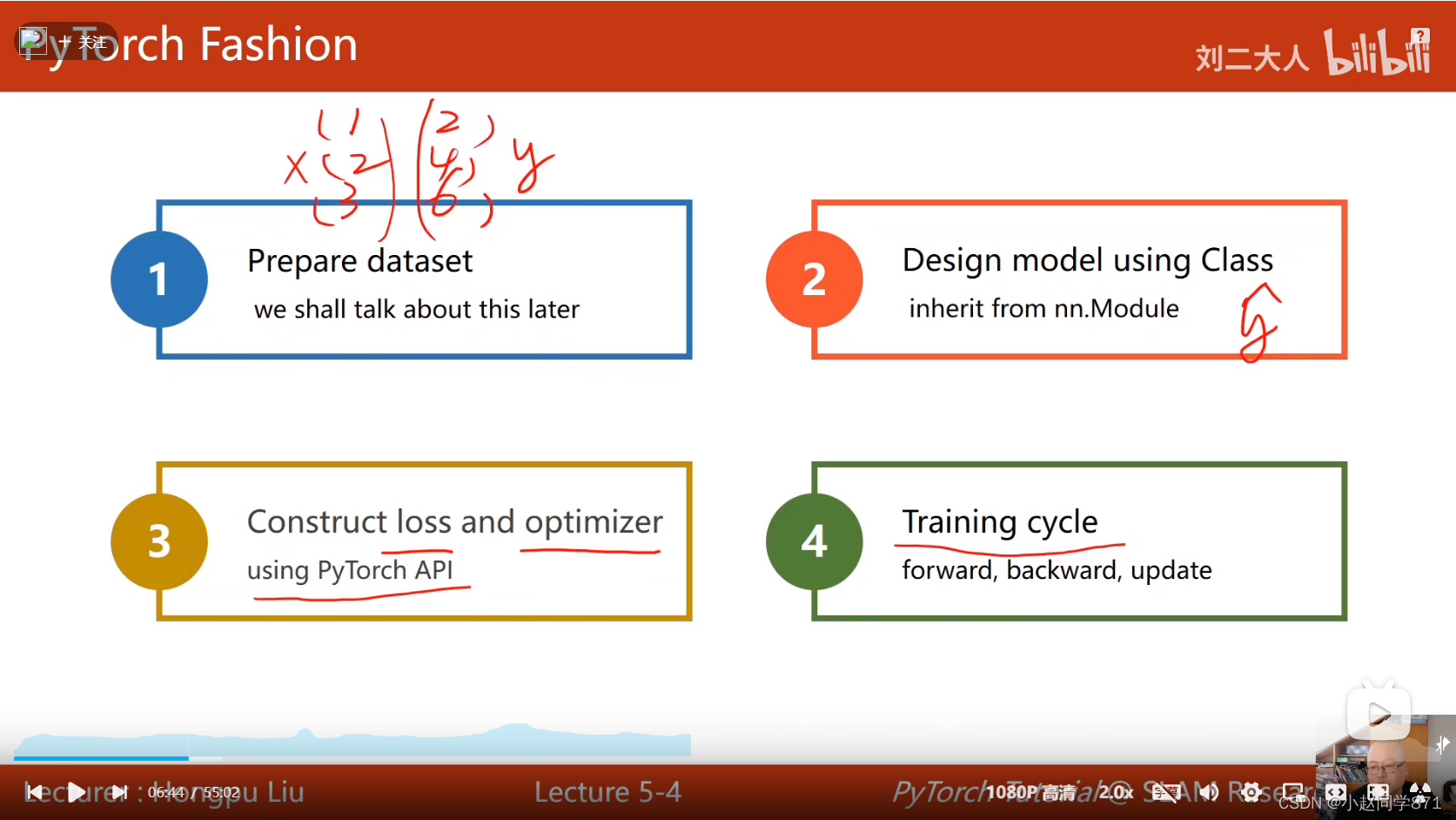

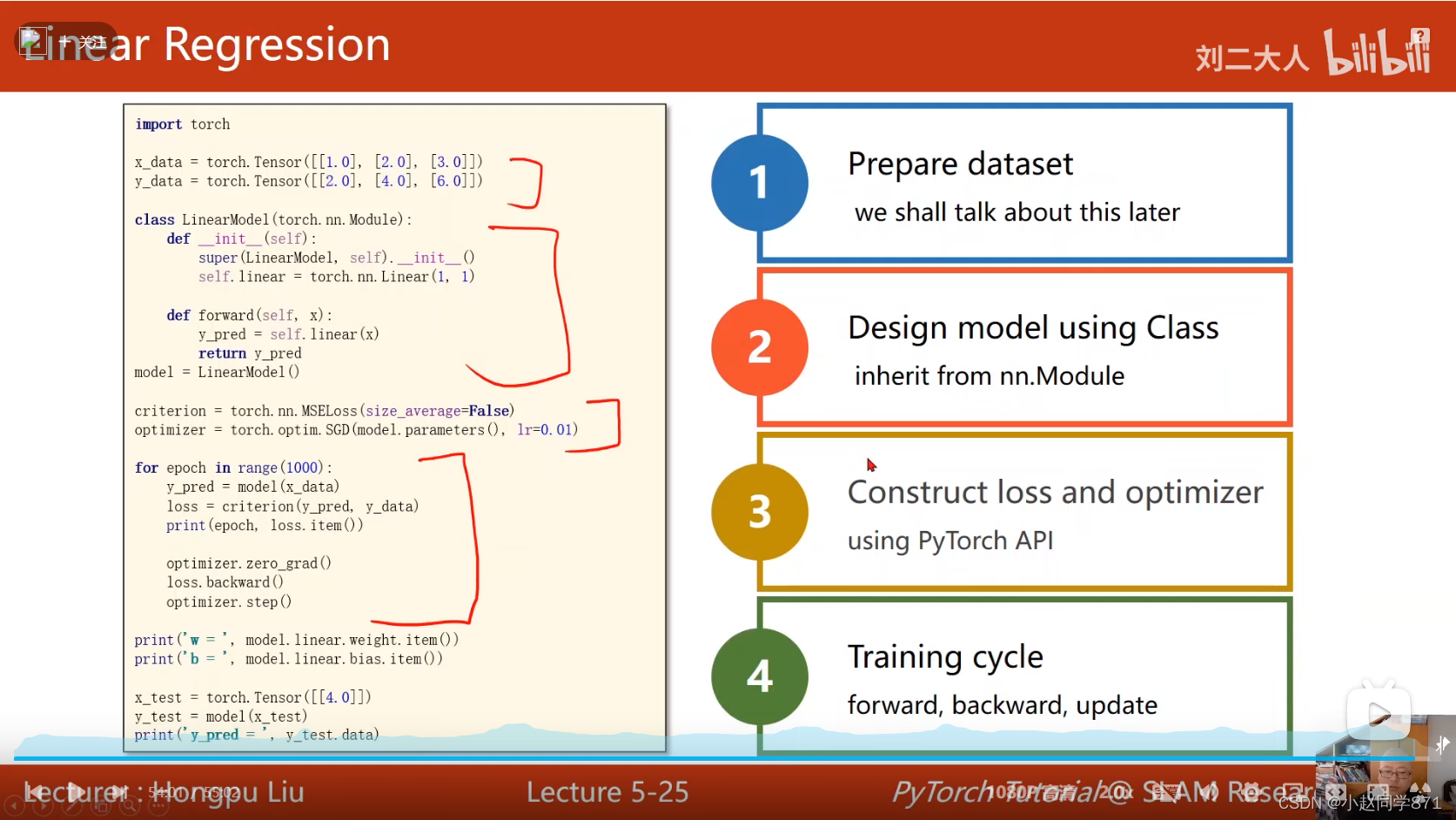

用pytorch构建深度学习模型训练数据的一般流程如下:

- 准备数据集

- 设计模型Class,一般都是继承nn.Module类里,目的为了算出预测值

- 构建损失和优化器

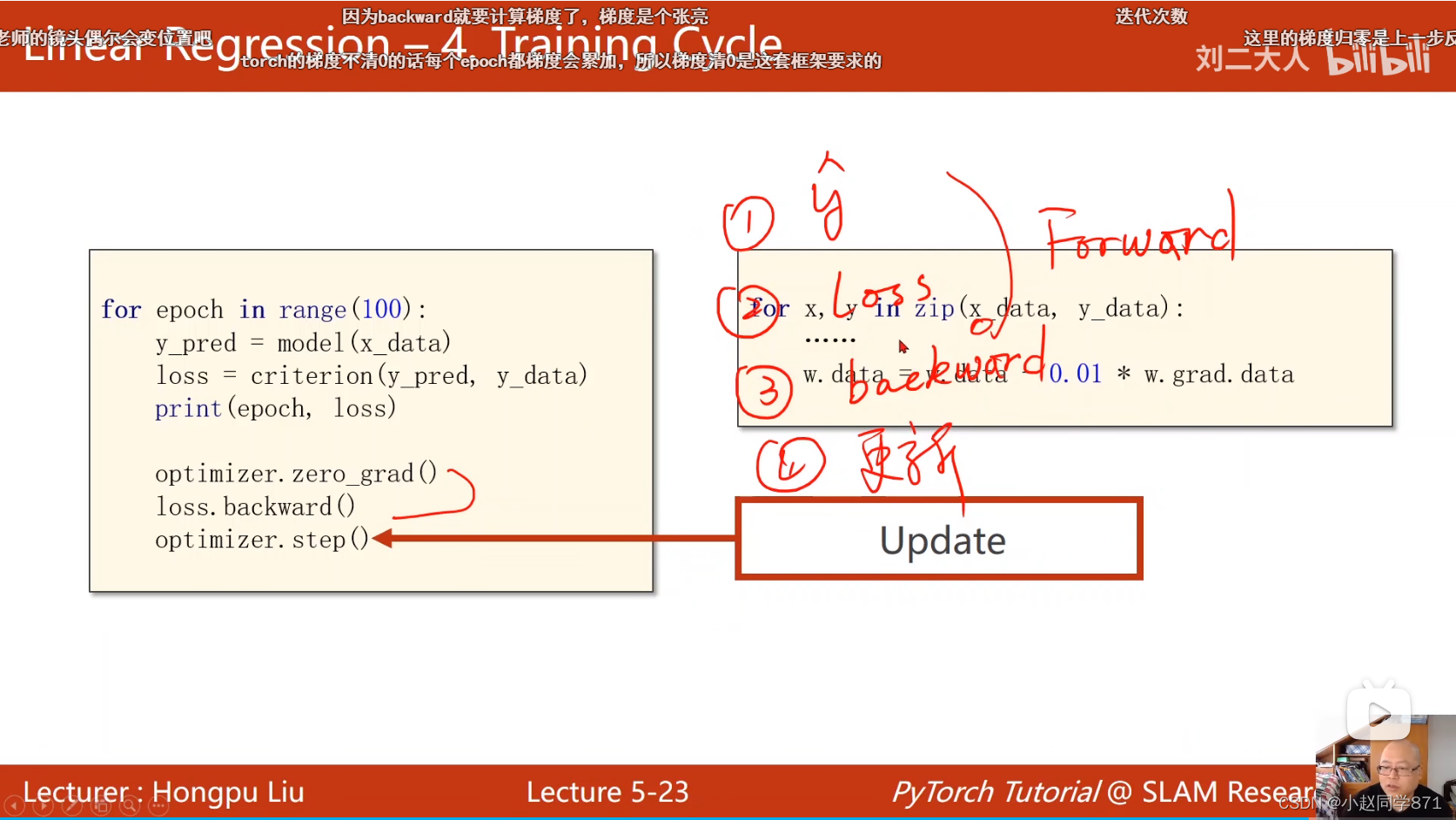

- 开始训练,前向传播,反向传播,更新

准备数据

这里需要注意的是准备数据这块,数据是张量形式,而且数据维度要正确,体现在数据的行为样本数,列为特征数目

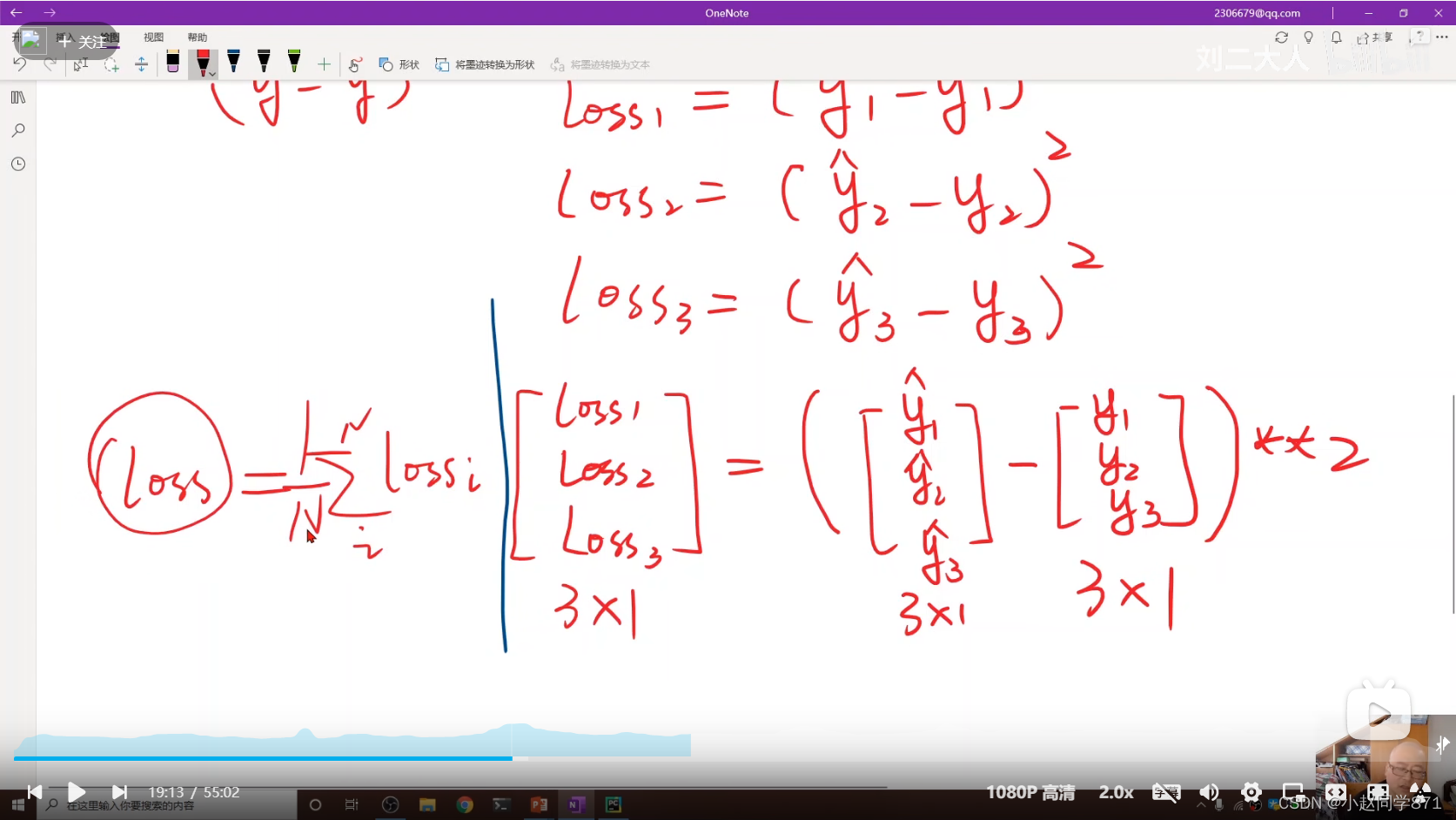

由于这里的损失是批量计算的,所以这里计算出的是损失的向量,可以通过计算平均值来得到损失值

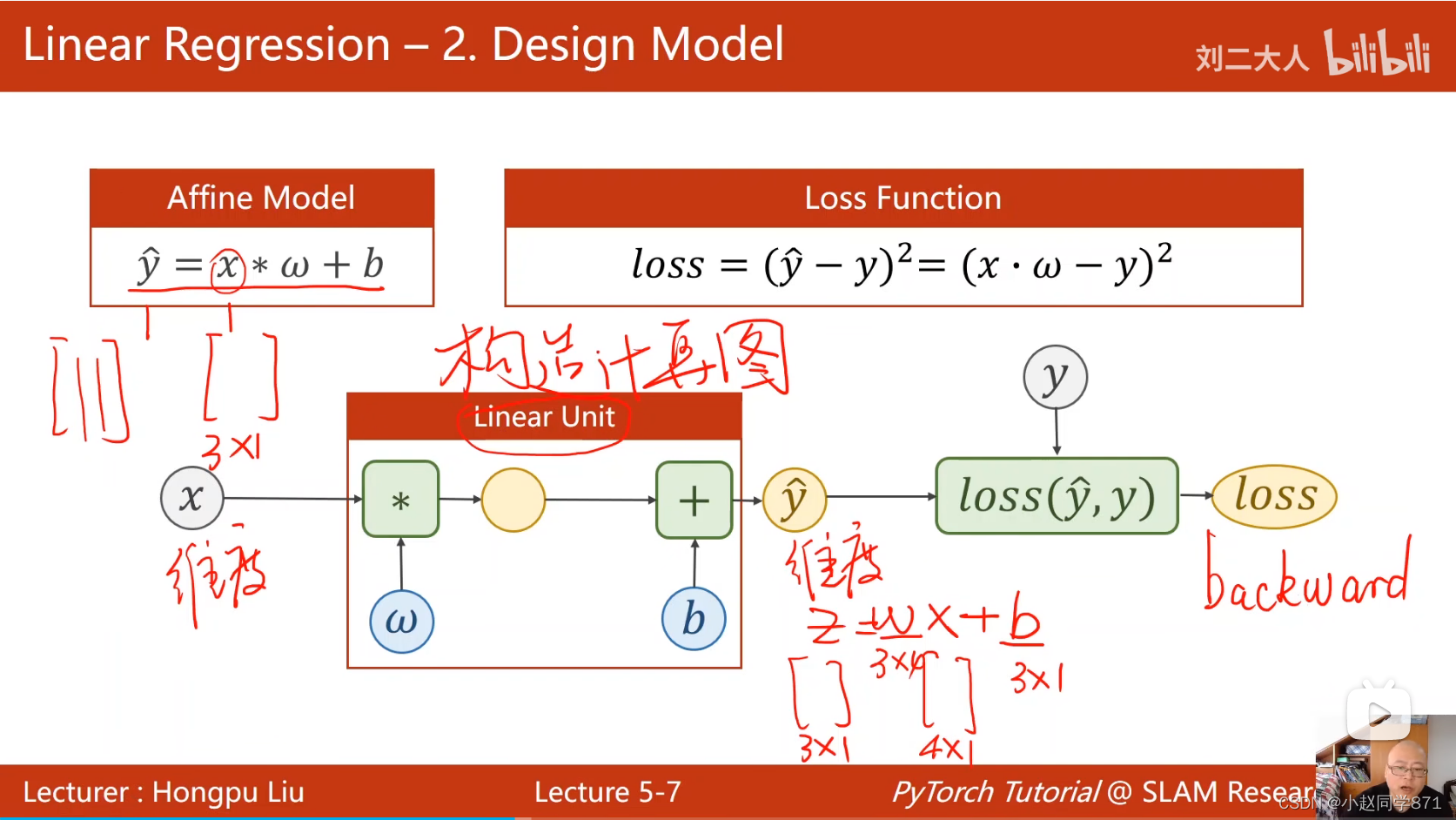

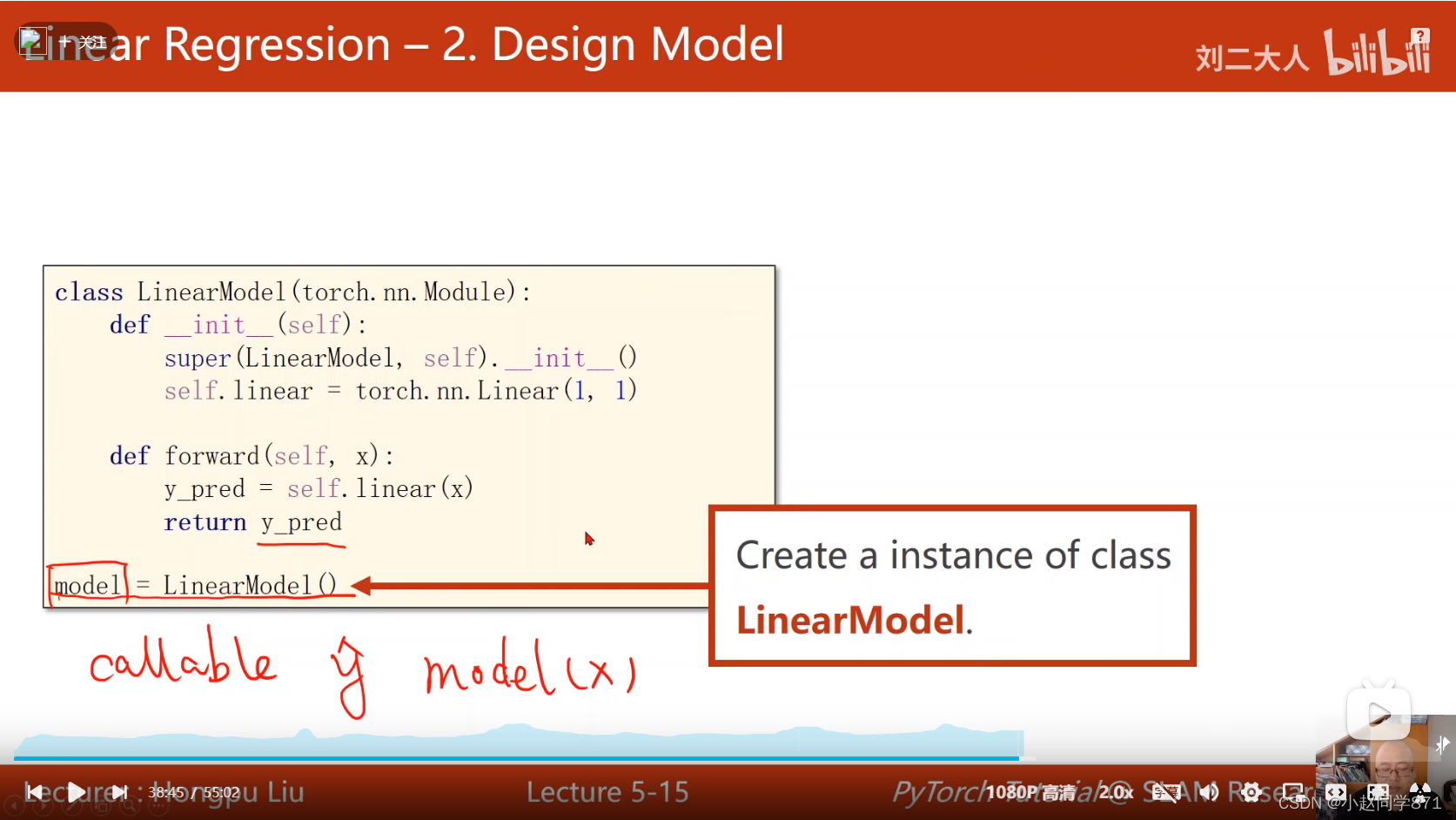

构造模型

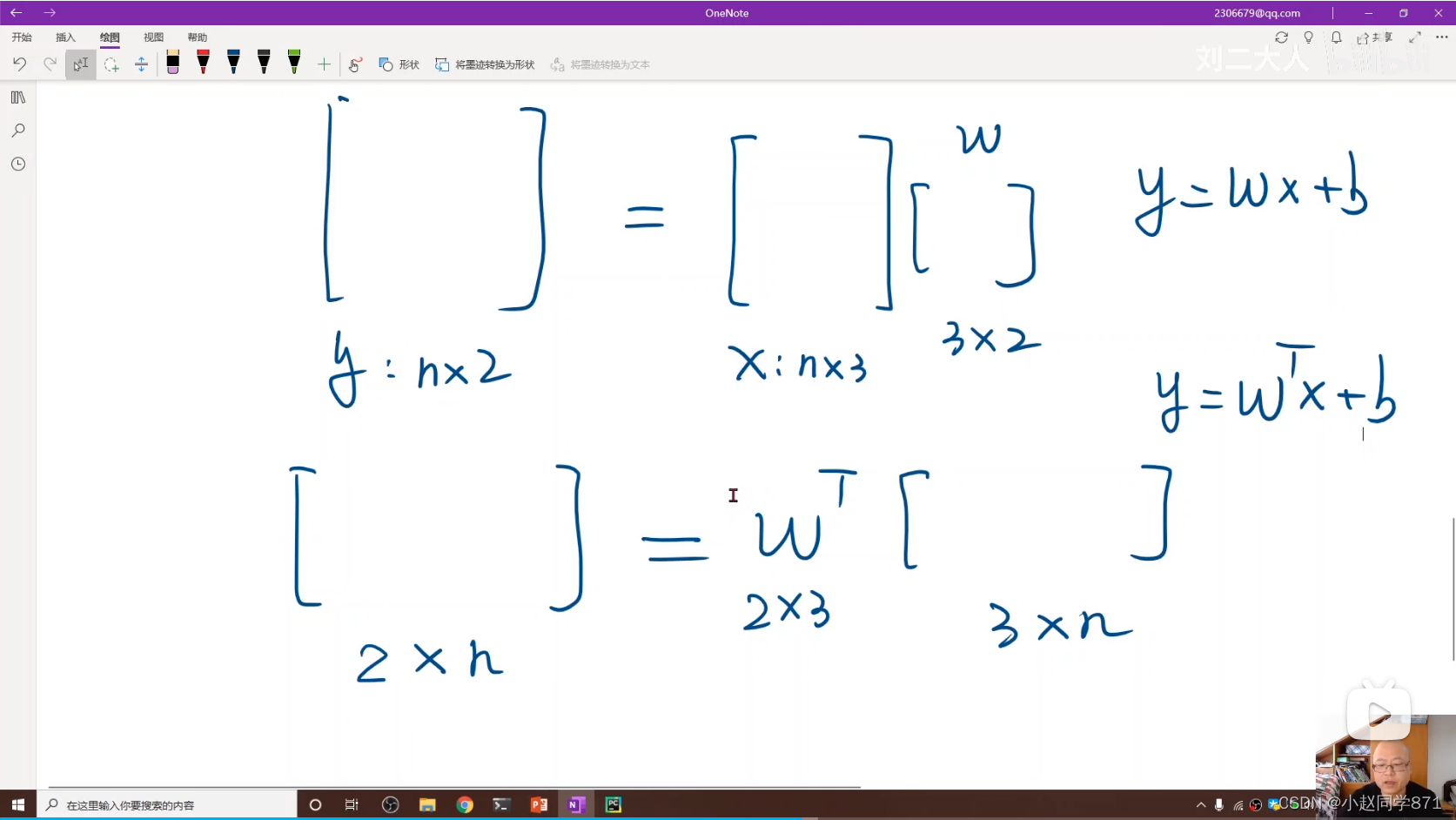

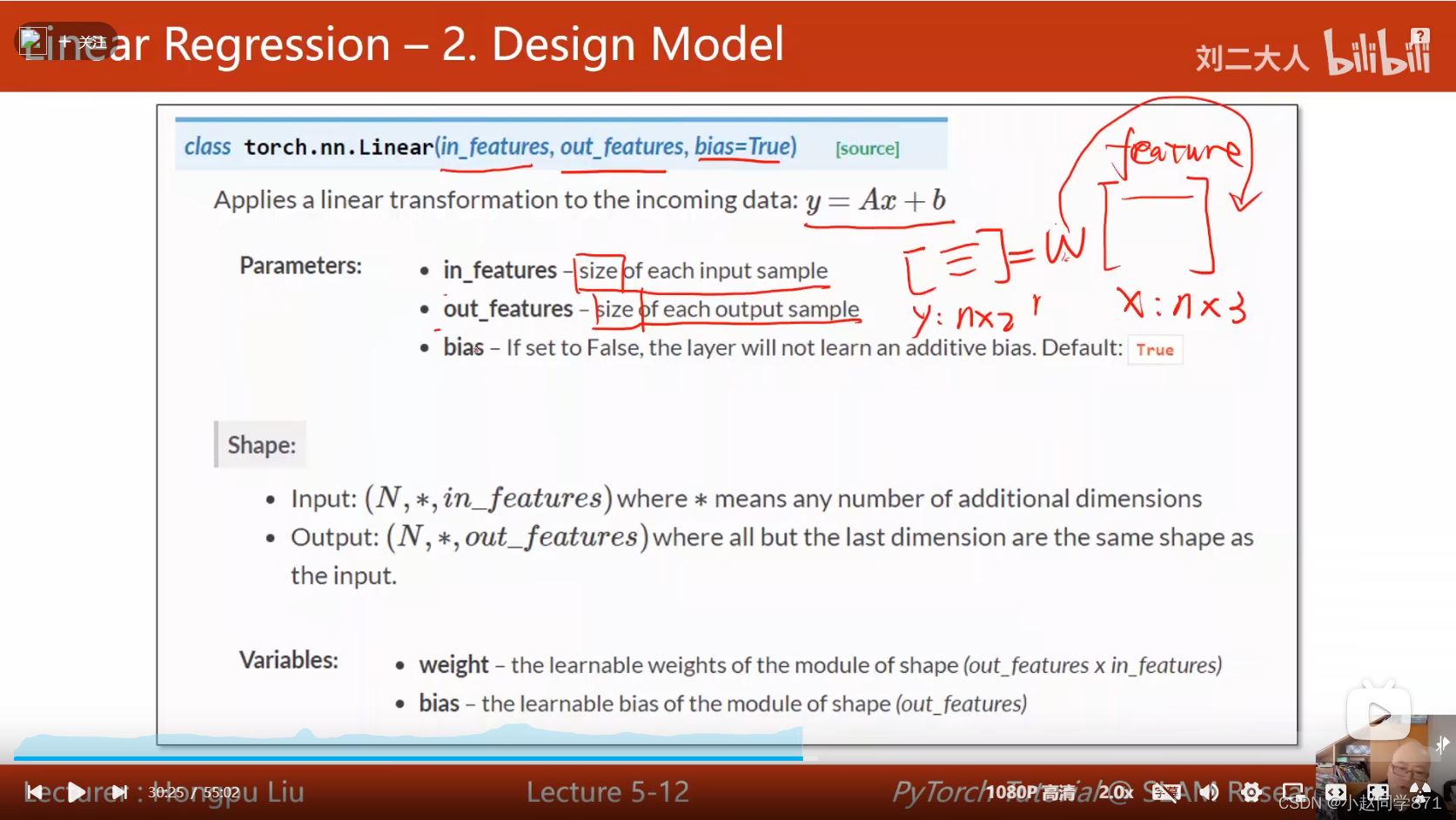

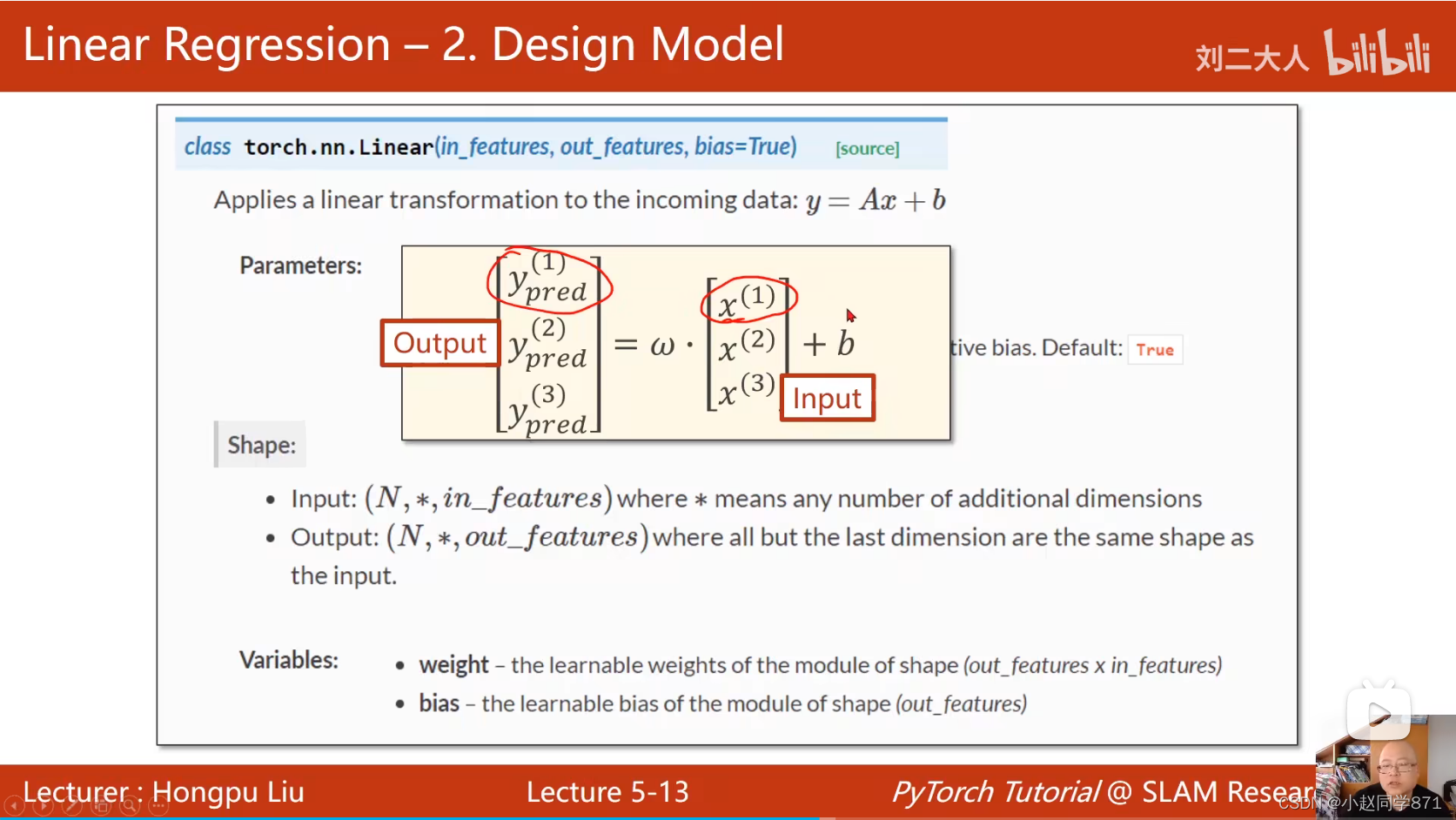

这里pytorch里自带的Linear层利用的是讲W进行转置去求y值如下图,我们只要输入输入和输出的特征维度即可

设计模型:

torch.nn.Linear()是一个类,三个参数,第一个为输入的样本特征,输出的样本特征,同时还有个偏置项,看是否加入偏置

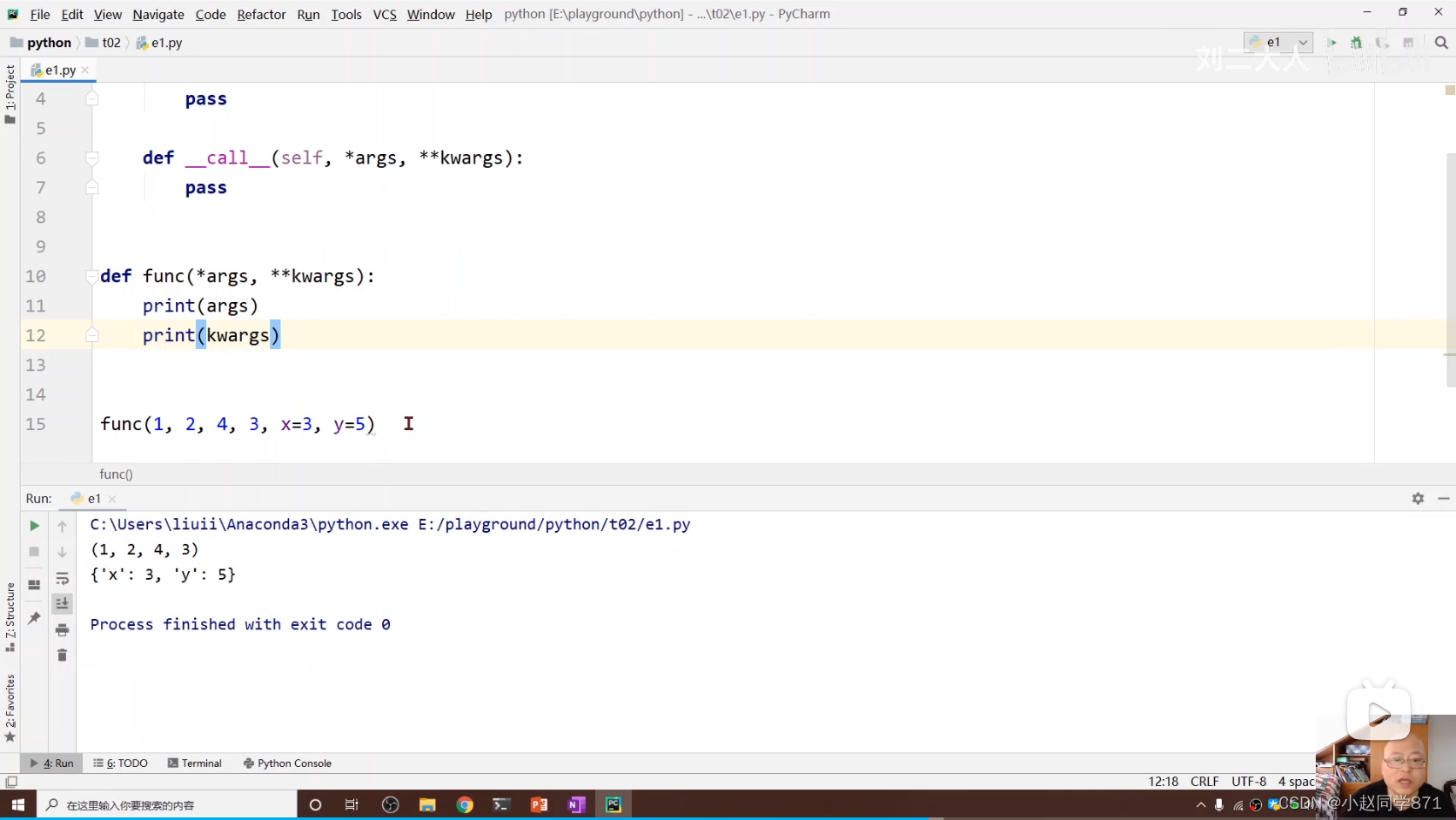

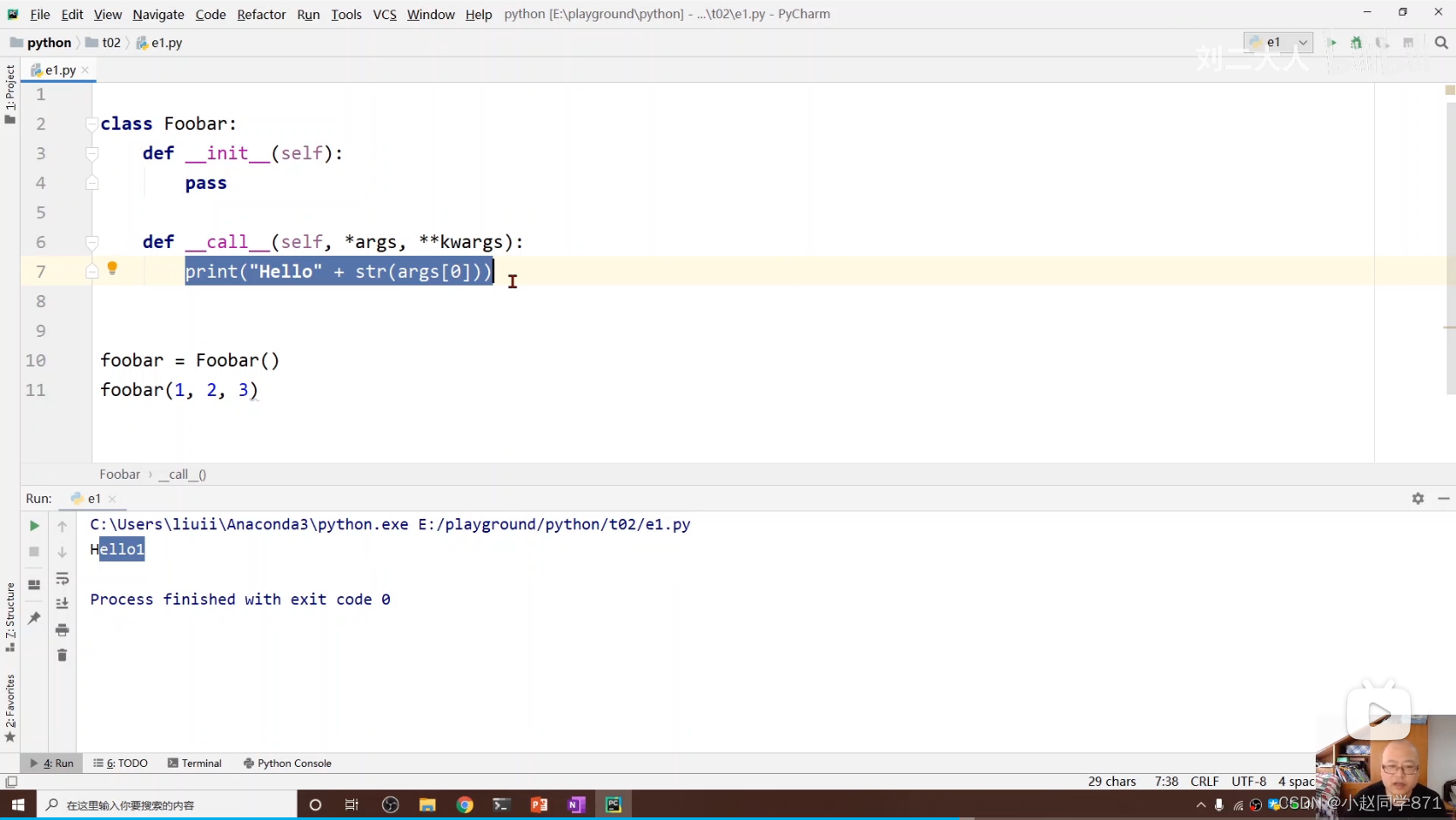

这里简单记录下两个pytorch里的小知识点,其中参数*args代表把前面n个参数变成n元组,**kwargsd会把参数变成一个词典

定义模型类,先初始化函数导入需要的线性模型,然后调用预测y值

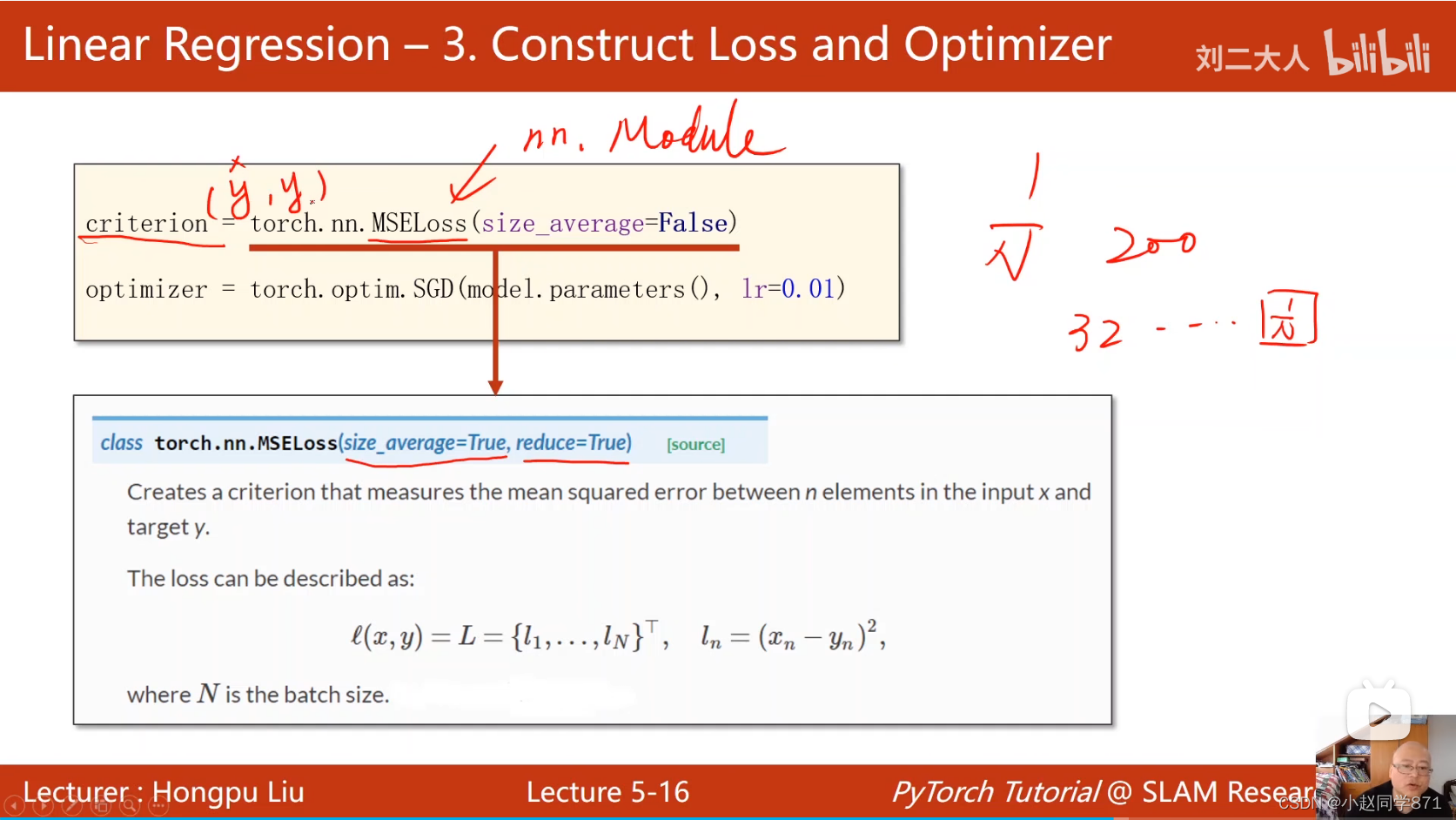

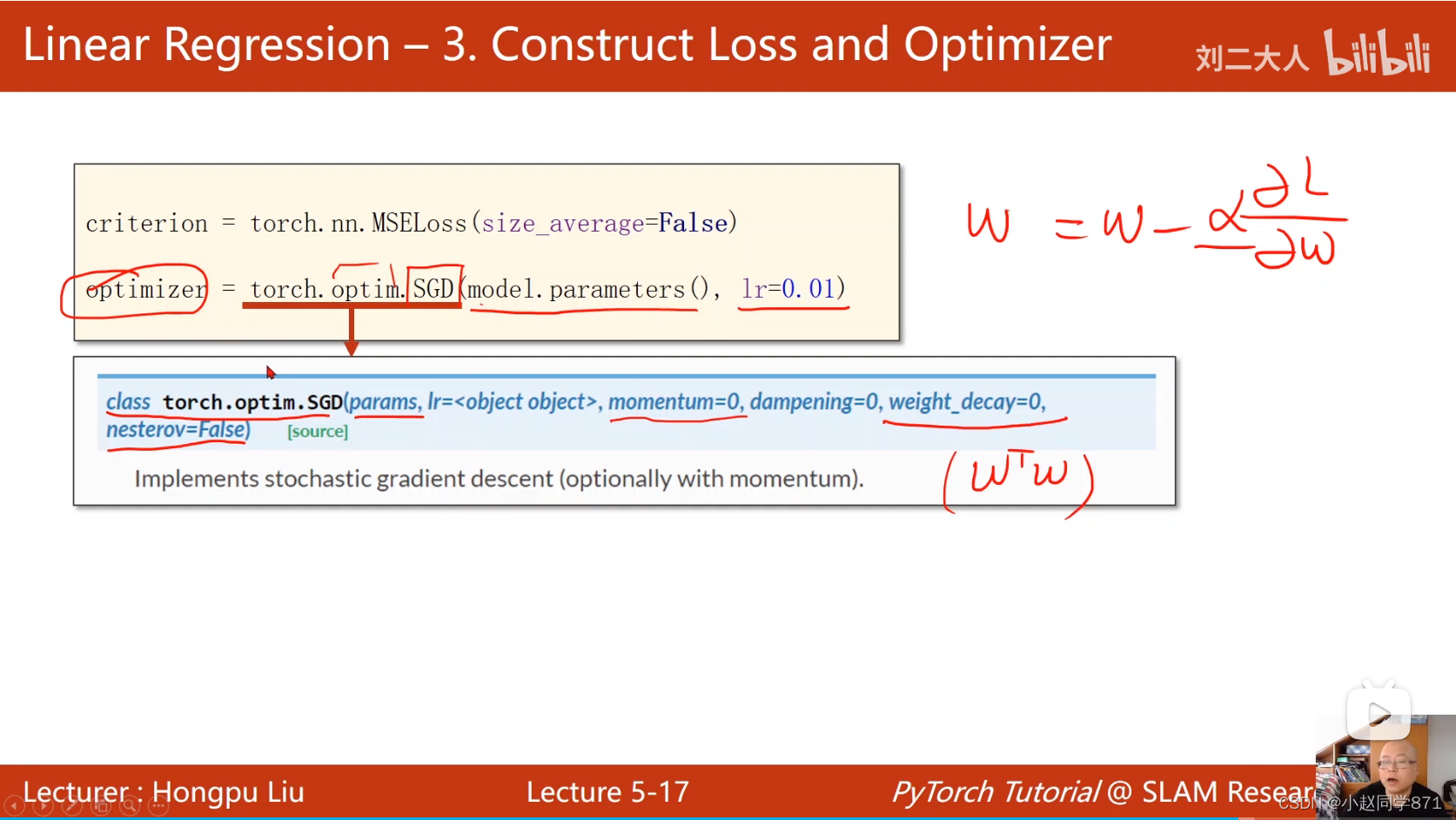

定义损失函数和优化器

记住梯度清零然后反向传播,然后梯度更新

拿个值来预测一下

整体的流程

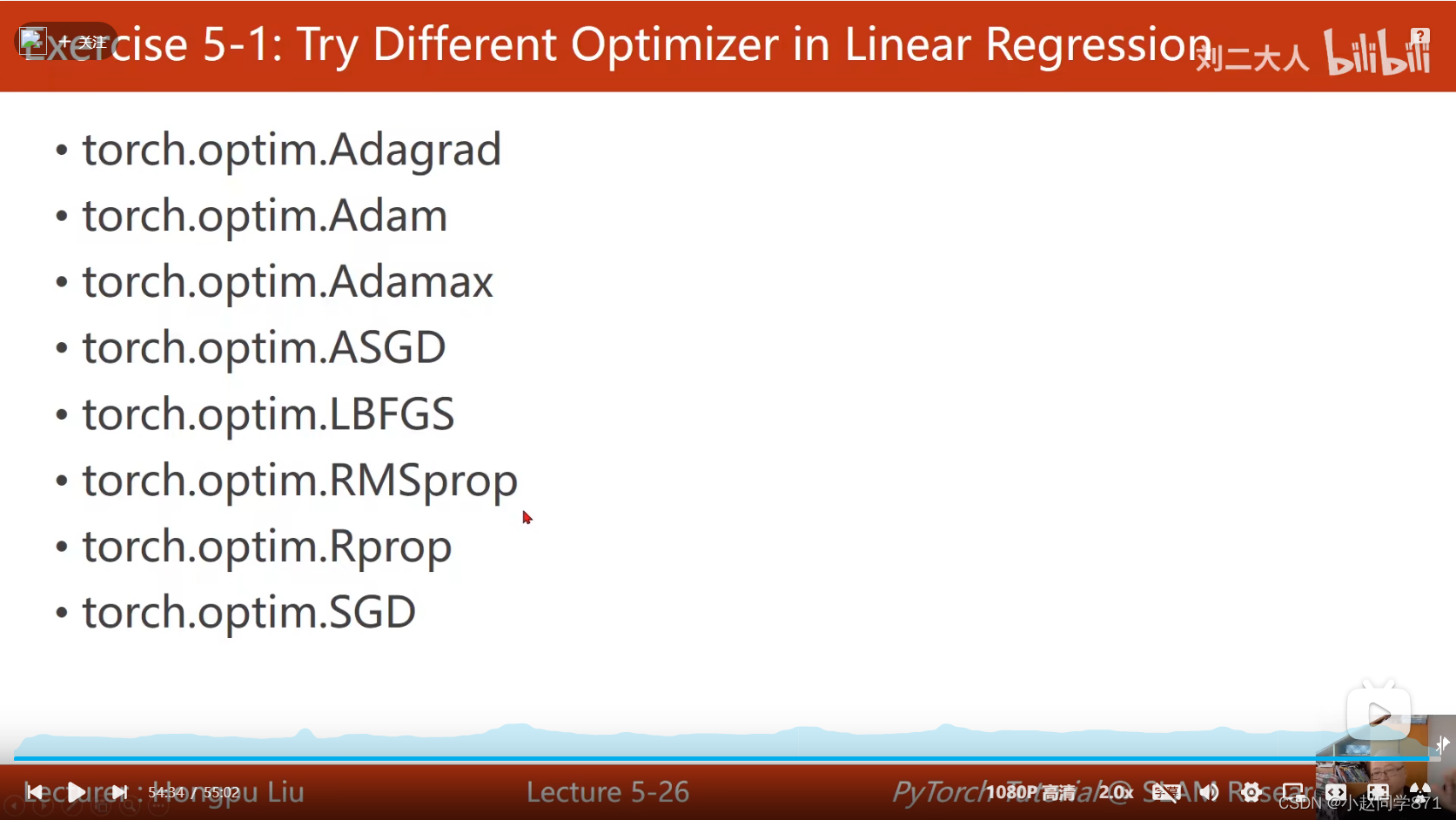

常见的优化器

全部代码:

import torch

# prepare dataset

# x,y是矩阵,3行1列 也就是说总共有3个数据,每个数据只有1个特征

x_data = torch.tensor([[1.0], [2.0], [3.0]])

y_data = torch.tensor([[2.0], [4.0], [6.0]])

#design model using class

"""

our model class should be inherit from nn.Module, which is base class for all neural network modules.

member methods __init__() and forward() have to be implemented

class nn.linear contain two member Tensors: weight and bias

class nn.Linear has implemented the magic method __call__(),which enable the instance of the class can

be called just like a function.Normally the forward() will be called

"""

class LinearModel(torch.nn.Module):

def __init__(self):

super(LinearModel, self).__init__()

# (1,1)是指输入x和输出y的特征维度,这里数据集中的x和y的特征都是1维的

# 该线性层需要学习的参数是w和b 获取w/b的方式分别是~linear.weight/linear.bias

self.linear = torch.nn.Linear(1, 1)

def forward(self, x):

y_pred = self.linear(x)

return y_pred

model = LinearModel()

# construct loss and optimizer

# criterion = torch.nn.MSELoss(size_average = False)

criterion = torch.nn.MSELoss(reduction = 'sum')

optimizer = torch.optim.SGD(model.parameters(), lr = 0.01) # model.parameters()自动完成参数的初始化操作,这个地方我可能理解错了

# training cycle forward, backward, update

for epoch in range(100):

y_pred = model(x_data) # forward:predict

loss = criterion(y_pred, y_data) # forward: loss

print(epoch, loss.item())

optimizer.zero_grad() # the grad computer by .backward() will be accumulated. so before backward, remember set the grad to zero

loss.backward() # backward: autograd,自动计算梯度

optimizer.step() # update 参数,即更新w和b的值

print('w = ', model.linear.weight.item())

print('b = ', model.linear.bias.item())

x_test = torch.tensor([[4.0]])

y_test = model(x_test)

print('y_pred = ', y_test.data)

作业代码:只用了其中一个优化器Adam

import torch

#加载数据

x_data = torch.tensor([[1.0],[2.0],[3.0]]) #构建为3x1的张量数据

y_data = torch.tensor([[2.0],[4.0],[6.0]])

#定义模型model类

class Model(torch.nn.Module):

def __init__(self):

super(Model,self).__init__() #继承父类

self.linear = torch.nn.Linear(1,1) #定义线性对象实例化

def forward(self,x):

y_pred = self.linear(x)

return y_pred

#定义损失函数

model = Model() #实例化

criterion = torch.nn.MSELoss() #定义损失函数,求平均加了size_average=False后收敛速度更快

optimizer = torch.optim.Adam(model.parameters(),lr=0.01) #定义优化器,参数传入为model需要更新的参数

loss_list = []

#前向传播,迭代循环

for epoch in range(100):

y_pred = model(x_data) #预测y

loss = criterion(y_pred,y_data) #计算损失值

loss_list.append(loss)

print(epoch,loss.item())

optimizer.zero_grad() #梯度都变为0

loss.backward() #loss损失反向传播

optimizer.step() #通过优化器更新参数

print('w=',model.linear.weight.item())

print('b=',model.linear.bias.item())

x_test = torch.tensor([[4.0]])

y_pred = model(x_test)

print(y_pred.data)

import matplotlib.pyplot as plt

import numpy as np

epoch_list = list(np.arange(0,100,1))

plt.plot(epoch_list,loss_list)

plt.xlabel('epoch')

plt.ylabel('loss')

plt.title('Adam')

plt.show()

1302

1302

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?