目录

当汽车诞生时,无需与之赛跑,而应该考个驾照。

一、DeepSeek是什么

Deep Seek 是一家专注通用人工智能(AGI)的中国科技公司,主攻大模型研发与应用。这家公司2023年由梁文峰创立,总部在浙江杭州。

其开发的AI模型DeepSeek,仅用557万美元的训练成本,就实现了与OpenAI价值数十亿美元的顶级模型相匹敌的性能。R1对标o1,V3对标4o。

目前,Deep Seek公司已经推出了两款很强大的模型:DeepSeek-V3和DeepSeek-R1。

AI+国产+免费+开源+强大

二、Deepseek可以做什么

直接面向用户或者支持开发者,提供智能对话、文本生成、语义理解、计算推理、代码生成补全等应用场景, 支持联网搜索与深度思考模式,同时支持文件上传,能够扫描读取各类文件及图片中的文字内容。

三、DeepSeek的几种使用方式

总的来说有在线使用、本地部署、云端部署这几种方式,各有优势,方法如下。

1. DeepSeek官网

深度思考(R1)和联网搜索的区别

信息时效

开启联网搜索可回答动态更新的内容,引用社交媒体热议、近期事件进展但响应时间可能稍长。

关闭联网搜索可实现快速响应,适合常识性或历史性问题,但无法提供2024年7月后的新信息。

推理深度

开启深度思考可将复杂问题分步拆解,提供多视角对比,但生成时间延长,适用于需要深度分析的场景。

关闭深度思考可快速输出简明结论,但可能遗漏潜在假设或未明示的逻辑链条。

| 功能 | 信息时效 | 推理深度 | 回答复杂度 | 适用场景 |

| 仅开启深度思考(R1) | 受限于预训练数据 | 多角度假设推演、因果链分析 | 结构化分层论证(如SWOT/5W1H) | 学术研究、战略分析、复杂决策支持 |

| 仅开启联网搜索 | 实时获取全网最新消息 | 基础逻辑+实时数据验证 | 事实增强型回答 | 新闻追踪、市场动态、突发事件解析 |

| 关闭两个功能 | 依赖预训练数据 | 基础逻辑推理 | 简单直接、单层结论 | 简单事实查询、常识问题解答 |

| 开启两个功能 | 实时数据+历史知识库融合 | 动态数据驱动深度推理 | 多模态综合、分析报告 | 行业趋势预测、竞争情报分析、政策影响评估 |

2. 硅基流动

用户注册

可以填写我的邀请码:cwfkfzr8,填了之后咱两都能获得14块钱的免费配额

R1和V3的区别

R1:深度推理,相当于上面DeepSeek网页版开启了深度搜索(R1)功能

V3:快速问答,相当于上面DeepSeek网页版关闭了联网搜索和深度思考功能

3. 秘塔搜索

联网搜索关不掉,无法多轮对话

4. ollama本地部署deepseek

ollama简介

ollama是一个开源框架,允许我们在本地轻松运行、部署和交互 LLMs。

本地部署的优缺

优点:保护隐私与数据安全;可定制化微调;离线运行,适用于无网络环境。

缺点:一般而言,pc本地部署的小规模deepseek统称为deepseek_r1残血版,和官网或app线上提供的617b满血版而言,在推理能力方面还是相差甚远。

部署deepseek

下载ollama

点击github链接,根据自己的操作系统选择对应的安装文件

点击.exe文件

点击install

修改安装位置

Ollama默认下载在C盘C:\Users\%username%\AppData\Local\Programs\Ollama路径下,可以将该文件夹移动至指定位置,然后添加环境变量

测试安装是否成功

下载deepseek-r1

llm默认安装在C盘,我们可以修改llm的安装位置到其他盘,新建系统变量中的用户变量,变量名为OLLAMA_MODELS,值为模型存放的路径

打开官网,点击models

选择deepseek-r1

国产大语言模型deepseek_r1荣登榜首!

按需求选择模型规模,我这里安装7b,指模型的参数数量为 70 亿(7 billion)

命令行运行指令

ollama run deepseek-r1:7b下载完成后如下图所示

下载python3.11

官网下载python3.11

链接:https://www.python.org/ftp/python/3.11.9/python-3.11.9-amd64.exe

选择Customize installation,勾选Add python 3.11 to Path选项,建议把安装路径改为其他盘

测试python

1. 按下win+r打开运行框,输入cmd,回车

2. 在命令提示符中输入python,查看是否安装成功

输入exit()退出python

pip换源

pip config set global.index-url https://mirrors.aliyun.com/pypi/simple

安装open-webui

OpenWebUI 是一个开源的、用户友好的专为大型语言模型(LLMs)设计的 web 界面,它支持各种 LLM 运行器,如 Ollama 和 OpenAI 兼容的 API,并内置了 RAG 推理引擎,使其成为强大的 AI 部署解决方案。

pip install open-webui

等待安装完成~

等待过程结束后,输入:

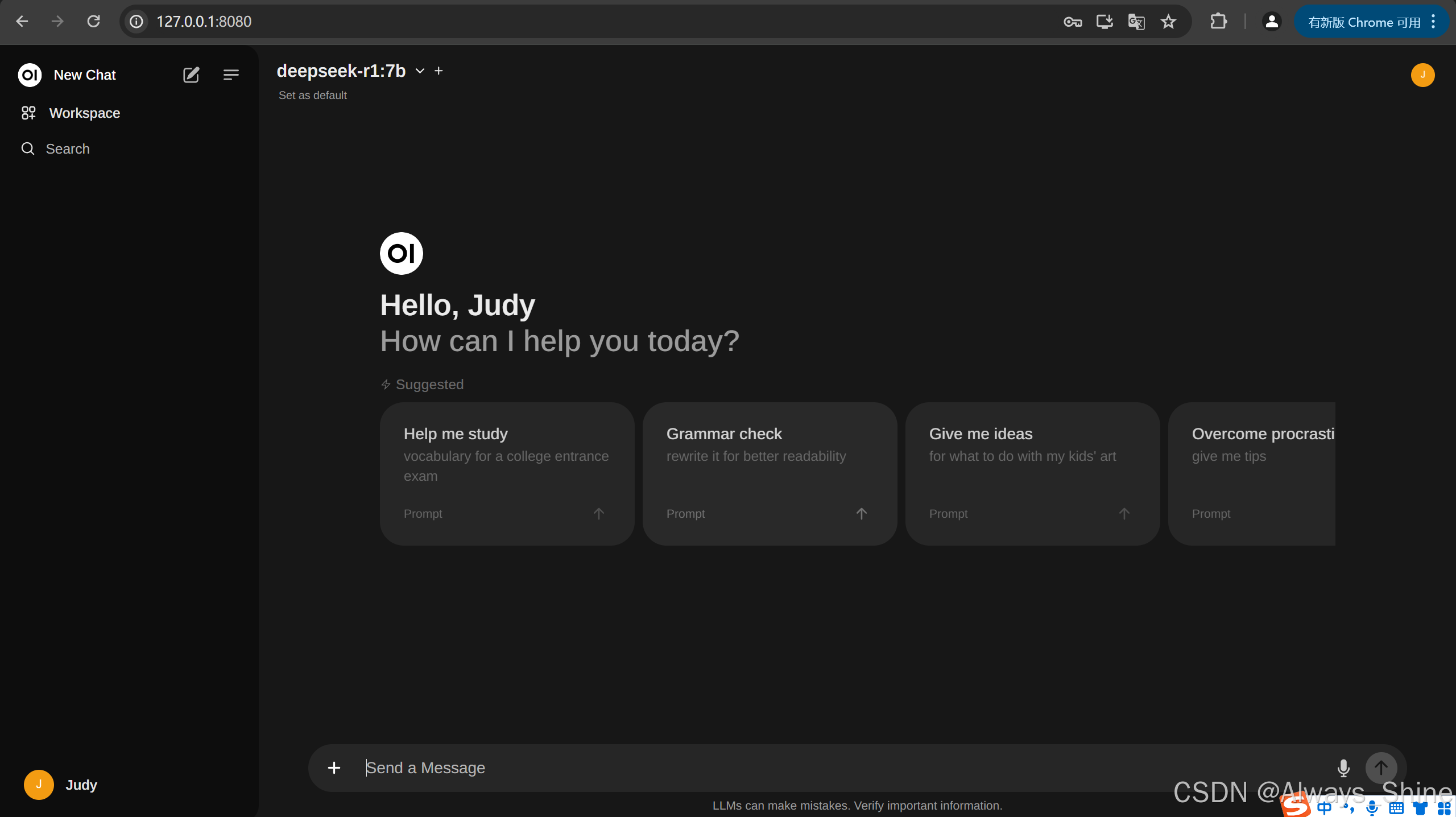

open-webui serve安装成功后,如下图所示

确保ollama服务是打开的,输入http://localhost:11434/

访问链接:http://localhost:8080

先注册登录下

此时open-webui就连接好了ollama,选择deepseek-r1:7b

问个问题吧

5. 阿里云部署deepseek

登录阿里云PAI控制台,进入Model Gallery

选择DeepSeek-R1的蒸馏版本DeepSeek-R1-Distill-Qwen-7B,单击右上角部署,此处我选择标准部署。

DeepSeek-R1-Distill-Qwen-7B 是一个通过知识蒸馏技术从小型化模型中提取推理能力的高性能语言模型。它是基于 DeepSeek-R1 的推理能力,通过蒸馏技术将推理模式迁移到较小的 Qwen 模型上,从而在保持高效性能的同时降低了计算成本。

DeepSeek-R1-Distill-Qwen-7B 模型支持多种部署方式:标准部署、vLLM 加速部署和 BladeLLM加速部署。标准部署用户可以在服务详情页面通过“查看 Web 应用”按钮来在网页端直接和模型进行推理交互。

在PAI-Model Gallery > 任务管理 > 部署任务中单击已部署的服务名称,在服务详情页面右上角单击查看WEB应用,即可通过ChatLLM WebUI进行实时交互。

要求写一个登录注册的前端页面,来看看效果吧

四、DeepSeek的几个使用技巧

1. 是否需要联网

DeepSeek的预训练数据,更新至2024年7月。2024年7月之后的内容需要打开联网搜索(近日,硅谷对DeepSeek-R1的评价)。

2. 不同模型的提示词设计

对于像R1这种推理模型,我们不再需要过于复杂的结构化提示词,只需要做到准确表达需求就完全够用了。

常见的提示词模版:

你是谁+你的目标

你是谁+背景信息+你的目标

我要xx,用途是xx,效果是xx,避免xx问题...

其核心都是准确表达好自己的需求

对于通用模型和指令模型,学习提示词技巧还是很有必要的。

推理模型和指令模型:

OpenAI的GPT-4o、DeepSeek V3、豆包等都属于指令模型(instruct model),专门设计用于遵循指令生成内容或执行任务的。

DeepSeek R1属于推理模型(reasoning model),专注于逻辑推理、问题解决的模型,能够自主处理需要多步骤分析、因果推断或复杂决策的任务。

实际上,OpenAI的o1也是推理模型,但是需要付费使用,而DeepSeek R1现在完全免费!

3. 指定写作风格

比如让R1用李白的风格写一首诗,按脱口秀演员风格创作脱口秀脚本等。

4. 提供充分的任务背景信息

错误示范:分析2024年巴黎奥运会中国代表团的金牌分布

优化方案:上传《2024巴黎奥运会中国夺金项目统计表》,基于我提供的奥运会数据,请分析2024年巴黎奥运会中国代表团不同运动项目的金牌贡献率。

5. 主动标注自己的知识状态

比如我是某一个领域的小白,我是一个小学生等。请你给我讲讲...

6. 灵活使用通用模型、指令模型、推理模型

根据不同的任务需求,灵活选择不同类型的模型。

通用模型就像一本百科全书,上知天文下知地理。

指令模型就像一个“听话的助手”,按照你的要求完成任务。

推理模型就像一个“数学天才”,擅长处理逻辑推理问题。

559

559

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?