什么是迁移学习?

我们总是被告知“熟能生巧”,我们被要求在不同领域练习大量问题,为期末考试做好准备。我们解决的问题越多,我们就越能更好地利用这些知识以解决新问题。如果有一种方法可以应用相同的技术来解决分类、回归或聚类问题呢?

迁移学习是一种技术,通过它我们可以使用在 ImageNet 等标准数据集上训练的模型权重来提高给定任务的效率。

为什么要使用迁移学习?

在我们进一步了解迁移学习的工作原理之前,让我们先看看进行迁移学习后我们获得的好处。迁移学习的学习过程为:

快速 - 普通的卷积神经网络需要几天甚至几周的时间来训练,但你可以通过迁移学习来缩短这个过程。

准确 - 通常,迁移学习模型的性能比自定义模型好 20%。

需要较少的训练数据 - 在大型数据集上进行训练,该模型已经可以检测特定特征,并且需要较少的训练数据来进一步改进模型。

图像数据的迁移学习

为了在这里演示迁移学习,我选择了一个简单的二元分类器数据集,可以在这里找到:

https://www.kaggle.com/shaunthesheep/microsoft-catsvsdogs-dataset/code

该数据由猫和狗组成,即猫的 2.5k 图像和狗的 2.5k 图像。

VGG 架构

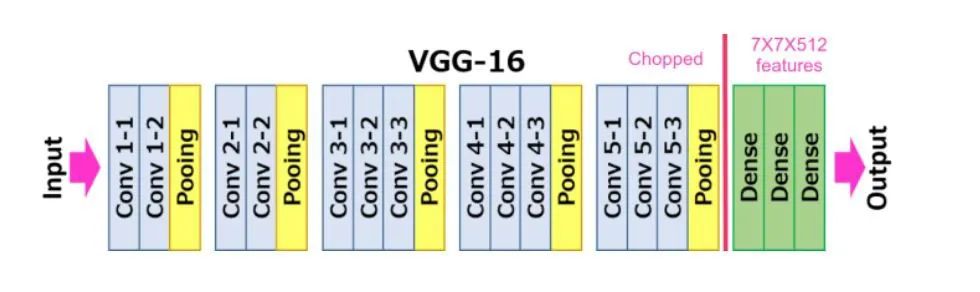

VGG 有两种模型,VGG-16 和 VGG-19。在这篇博客中,我们将使用 VGG-16 对我们的数据集进行分类。VGG-16主要有三部分:卷积层、池化层和全连接层。

卷积层:在这一层中,过滤器用于从图像中提取特征。最重要的参数是内核的大小和步幅。

池化层:它的功能是减小空间大小以减少网络中的参数和计算量。

全连接层:这些完全连接到前面的层,就像一个简单的神经网络。

给定的图显示了模型的架构:

要执行迁移学习,请使用 PyTorch 导入预训练模型,根据你的要求移除最后一个全连接层或在最后添加一个额外的全连接层(因为该模型提供 1000 个输出,我们可以对其进行自定义以提供所需的数量输出)并运行模型。

预处理

在训练前预处理图像

本文介绍了如何在PyTorch中使用VGG16进行迁移学习,通过预训练模型加快训练速度,提高模型准确性。内容包括迁移学习的优势,图像数据的迁移学习,VGG16模型的架构,数据预处理,以及模型的训练过程。通过调整模型的最后一层以适应二元分类任务,并使用GPU加速训练,最终完成模型的训练。

本文介绍了如何在PyTorch中使用VGG16进行迁移学习,通过预训练模型加快训练速度,提高模型准确性。内容包括迁移学习的优势,图像数据的迁移学习,VGG16模型的架构,数据预处理,以及模型的训练过程。通过调整模型的最后一层以适应二元分类任务,并使用GPU加速训练,最终完成模型的训练。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5621

5621

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?