前言

DeepSeek 作为国产开源大模型,近期因在线服务压力过大,本地部署需求激增。你是不是也遇到过网络繁忙请稍后再试的情况,但是进行本地部署就不会出现这个情况,同时还可以避免信息泄露。接下来将手把手教你如何进行deep seek本地部署

一、下载软件

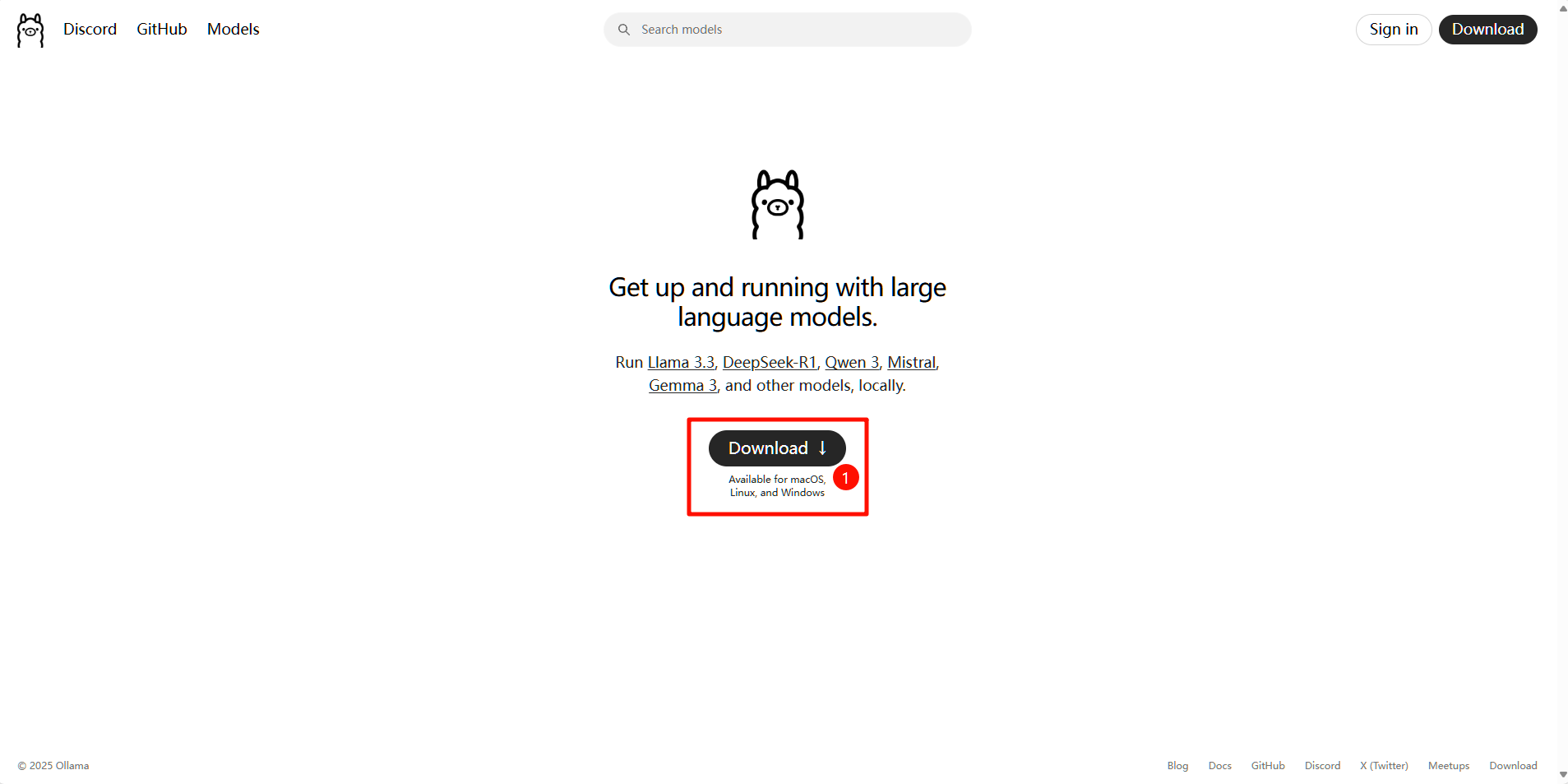

打开官网https://ollama.com/ 进行下载ollama软件

选择你的操作系统进行下载,此处默认使用Windows进行下载

下载完成后默认下一步默认安装即可,这边已经安装过就不演示了

安装完成后会在你的系统托盘里找到,它没有主界面,出现这个图标即可

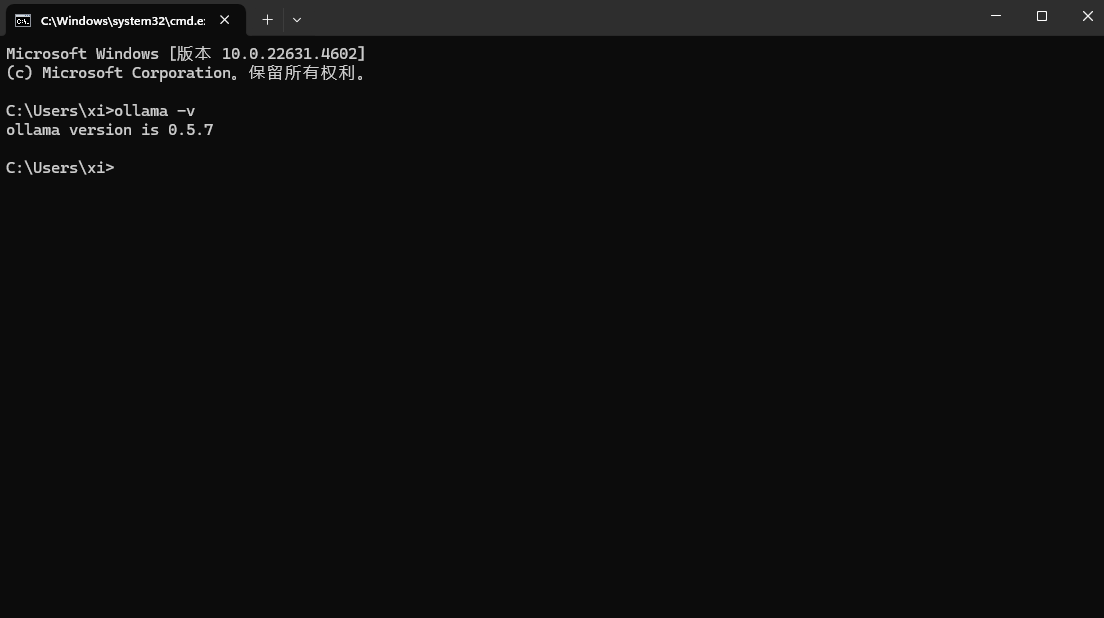

二、验证是否成功安装

按 win+r 输入cmd 回车 打开黑窗口后输入 ollama -v 出现版本号即证明成功安装

三、进行部署

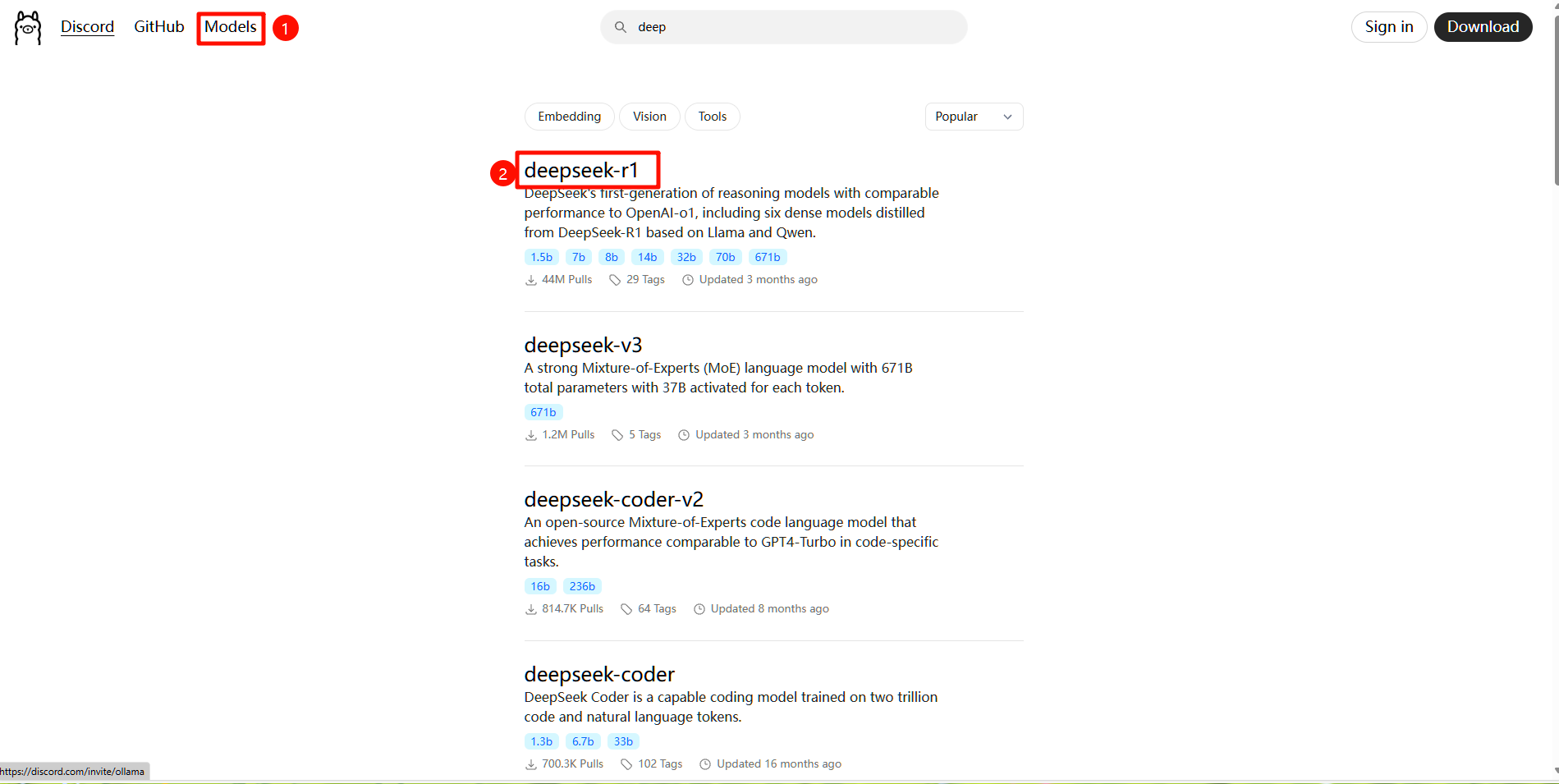

如下图所示跟图操作即可

选择你要下载的版本,根据电脑配置进行选择,如下图所示

这边以7b作为演示,如何部署运行

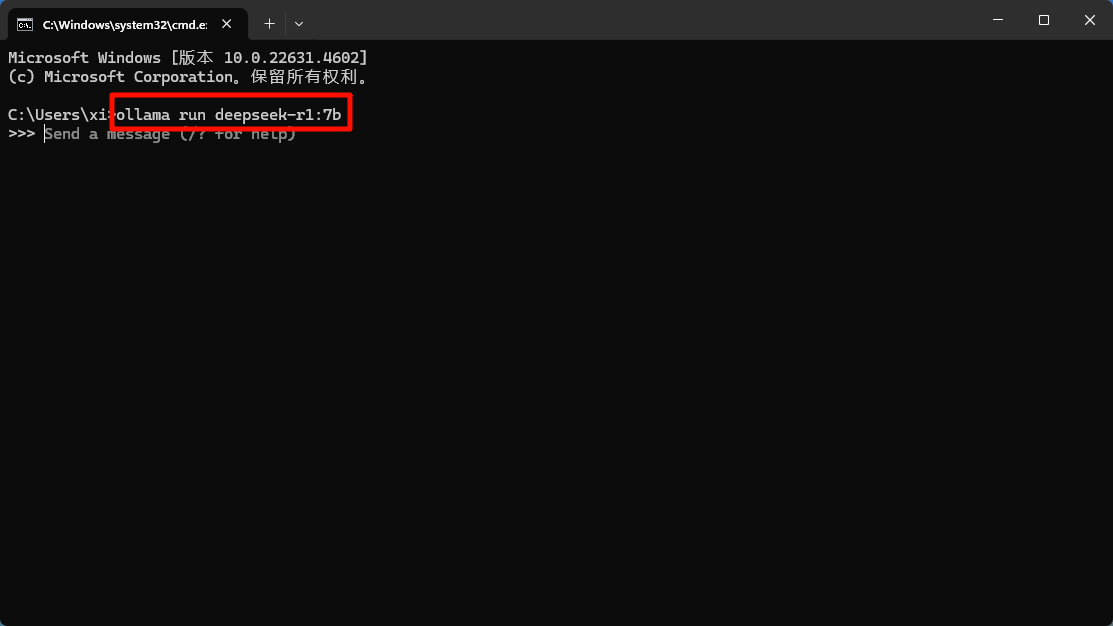

选择好版本后复制这串代码(红框所示)ollama run deepseek-r1:7b

确保你的ollama已经处于运行状态(它没有主界面),接下来还是按 win+r 输入cmd 回车 打开黑窗口,输入刚刚复制的代码后回车(第一次输入后会自动开始下载相关资源,这时候不用管,等待下载完成即可),下载完成后便是下图界面,届时你就可以正常进行对话了

退出输入 /bye 或直接关闭黑窗口即可,至此本地部署就已经完成了

四、相关代码

输入命令/bye可以退出对话

输入神秘代码再次进入

输入命令ollama list可以查看下载好的模型

后记

到此为止你的电脑现在就有一个只服务与你的deep seek了,如有疑问也可私信博主帮您解答;如有帮助还请多多点赞,关注。

440

440

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?