在当今的人工智能领域,大型语言模型(LLM)已成为备受瞩目的研究方向之一。它们能够理解和生成人类语言,为各种自然语言处理任务提供强大的能力。然而,这些模型的训练不仅仅是将数据输入神经网络,还包括一个复杂的管线,其中包括预训练、监督微调和对齐三个关键步骤。本文将详细介绍这三个步骤,特别关注强化学习与人类反馈(RLHF)的作用和重要性。

规范的LLM训练管线

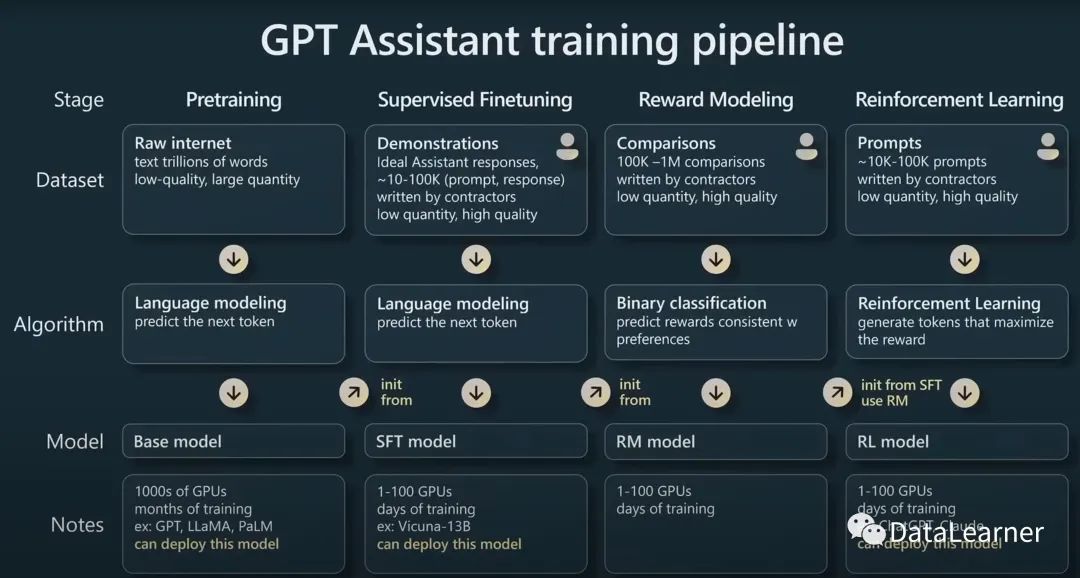

现代基于变换器的LLM,如ChatGPT和Llama 2,通常经历以下三个关键步骤的训练过程:

1. 预训练(Pretraining)

预训练是LLM训练的第一阶段,它在大规模未标记的文本数据集上进行。这个阶段的主要目标是使模型吸收大量的知识和语言结构。预训练阶段采用了自监督学习方法,其中模型预测给定上下文下一个词或令牌是什么。

- 数据集选择:通常使用包含数十亿到数万亿令牌的庞大文本语料库,如互联网文本。

- 自监督学习:模型根据文本数据的上下文预测下一个词,这种任务称为下一个词预测。通过这个任务,模型学习了语法、语义和常识知识。

2. 监督微调(Supervised Fine-Tuning)

监督微调是LLM训练的第二阶段,其目的是根据特定任务或指令微调模型,使其更适合执行具体的自然语言处理任务。与预训练不同,监督微调需要特定的标记数据集,其中包含了指令和相应的期望输出。

- 数据集准备:人类编写指令-输出对,指令是模型的输入,期望输出是我们期望模型生成的内容。这通常需要耗费大量人力和时间。

- 任务多样性:监督微调可以应用于各种任务,如翻译、问题回答、摘要生成等。

- 微调策略:模型参数根据监督数据的误差进行微调,以提高在指定任务上的性能。

3. 对齐(Alignment)与RLHF

对齐阶段是LLM训练的第三阶段,也是本文的重点。它的目标是将LLM的输出与人类偏好对齐,以进一步提高模型的性能、帮助性和安全性。这一阶段常常涉及强化学习与人类反馈(RLHF)的应用。

强化学习与人类反馈(RLHF)

RLHF是对齐阶段的核心。它为模型提供了一个持续学习和改进的机制。在RLHF中,模型生成文本,并接收人类提供的反馈信息。

- 反馈回路:RLHF创建了一个循环,模型生成文本,然后根据人类反馈进行调整。反馈可以是积极的,表示模型生成的文本是合适的,也可以是消极的,表示需要改进。

- 渐进改进:通过多次迭代,模型逐渐提高其生成文本的质量,以更好地满足用户的需求。这种渐进改进有助于模型更好地理解人类的期望和意图。

- 安全性提升:RLHF还可以用于提高模型的安全性,减少不当内容的生成。模型可以通过学习避免不恰当的回应来提高安全性。

结论

规范的大语言模型训练管线包括预训练、监督微调和对齐这三个关键步骤。强化学习与人类反馈(RLHF)在对齐阶段扮演着重要角色,通过不断的学习和调整,模型能够逐渐提高其生成文本的质量,以更好地满足用户的需求。随着LLM领域的不断发展,我们可以期待更多创新的方法和技术,以进一步提升这些语言模型的能力和可用性。如果您对RLHF或LLM训练管线的任何方面有疑问,欢迎随时提出,我们将不断更新并分享最新的研究成果。

如何学习大模型

现在社会上大模型越来越普及了,已经有很多人都想往这里面扎,但是却找不到适合的方法去学习。

作为一名资深码农,初入大模型时也吃了很多亏,踩了无数坑。现在我想把我的经验和知识分享给你们,帮助你们学习AI大模型,能够解决你们学习中的困难。

我已将重要的AI大模型资料包括市面上AI大模型各大白皮书、AGI大模型系统学习路线、AI大模型视频教程、实战学习,等录播视频免费分享出来,需要的小伙伴可以扫取。

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,我下面分享的这个学习路线希望能够帮助到你们学习AI大模型。

二、AI大模型视频教程

三、AI大模型各大学习书籍

四、AI大模型各大场景实战案例

五、结束语

学习AI大模型是当前科技发展的趋势,它不仅能够为我们提供更多的机会和挑战,还能够让我们更好地理解和应用人工智能技术。通过学习AI大模型,我们可以深入了解深度学习、神经网络等核心概念,并将其应用于自然语言处理、计算机视觉、语音识别等领域。同时,掌握AI大模型还能够为我们的职业发展增添竞争力,成为未来技术领域的领导者。

再者,学习AI大模型也能为我们自己创造更多的价值,提供更多的岗位以及副业创收,让自己的生活更上一层楼。

因此,学习AI大模型是一项有前景且值得投入的时间和精力的重要选择。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?