1. 自我介绍

在自我介绍环节,我清晰地阐述了个人基本信息、教育背景、工作经历和技能特长,展示了自信和沟通能力。

2. 技术问题

2.5 RAG 相关面试题

-

聊一下RAG项目总体思路?

-

使用外挂知识库主要是为了解决什么问题?

-

如何评价RAG项目的效果好坏,即指标是什么?

-

在做RAG项目过程中遇到哪些问题?怎么解决的?

-

RAG项目里面有哪一些亮点?目前开源的RAG项目非常多,你的项目和他们有什么区别?

-

数据集怎么构建的,什么规模,评估指标是什么,这些指标存在哪些问题?

-

模型底座是什么,这些不同底座什么区别,什么规模?

-

使用哪一种训练方法,什么sft,这些方法有什么不同,有什么优缺点,原理上解释不不同方法的差别?

-

模型推理是怎么做的,有没有cot,tot等等,还是单轮?

-

大模型可控性如何实现,怎么保证可控性?

-

模型部署的平台,推理效率怎么样,如何提升推理效率?

-

项目最后上线了么,上线之后发现什么问题,如何解决?

-

给一个总的输入输出样例,每一步包含什么prompt,多轮推理每一步输出什么结果,模拟一下,数据集格式是否要调整成这样,数据形式是什么,怎么拆分成多轮形式?

2.6 Agent 相关面试题

-

了解 Ai Agent 么?

-

知道 Multi-Agent 么?

-

Multi-Agent 如何 实现多代理协作的?

-

Multi-Agent 如何 实现多代理竞争的?

-

你了解哪些 开源 Agent?有部署过么?效果怎么样?

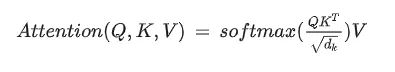

2.1 self-attention的计算方式?

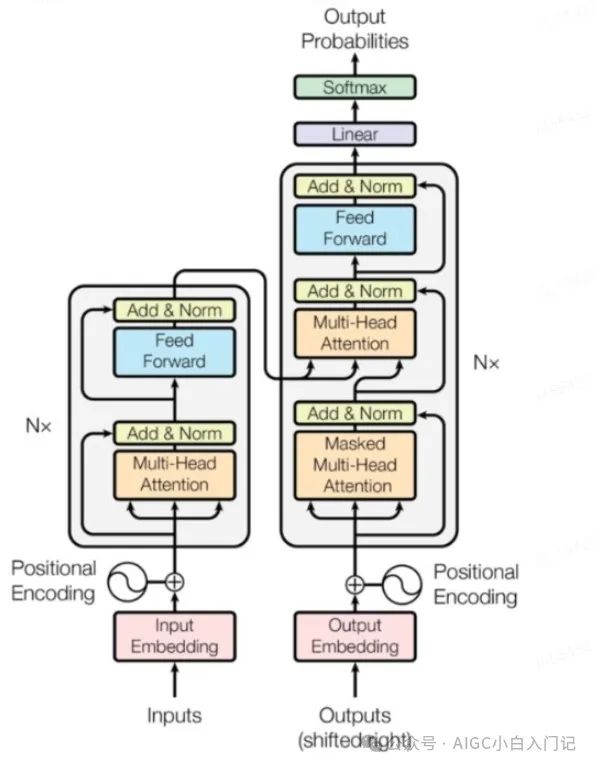

2.2 说一下 transformer的模型架构和细节?

2.3 说一下大模型高校参数微调方式 p-tuning v2?

P-Tuning V2在P-Tuning V1的基础上进行了下述改进:

-

在每一层都加入了Prompts tokens作为输入,而不是仅仅加在输入层,这与Prefix Tuning的做法相同。这样得到了更多可学习的参数,且更深层结构中的Prompt能给模型预测带来更直接的影响。

-

去掉了重参数化的编码器。在 P-tuning v2 中,作者发现重参数化的改进很小,尤其是对于较小的模型,同时还会影响模型的表现。

-

针对不同任务采用不同的提示长度。提示长度在提示优化方法的超参数搜索中起着核心作用。在实验中,我们发现不同的理解任务通常用不同的提示长度来实现其最佳性能,这与Prefix-Tuning中的发现一致,不同的文本生成任务可能有不同的最佳提示长度。

-

可选的多任务学习。先在多任务的Prompt上进行预训练,然后再适配下游任务。一方面,连续提示的随机惯性给优化带来了困难,这可以通过更多的训练数据或与任务相关的无监督预训练来缓解;另一方面,连续提示是跨任务和数据集的特定任务知识的完美载体。

2.4 在 大模型任务中,你用到 LoRA,讲一下 LoRA 实现原理?

LoRA 的思想很简单:

-

在原始 PLM (Pre-trained Language Model) 旁边增加一个旁路,做一个降维再升维的操作,来模拟所谓的intrinsic rank。

-

训练的时候固定 PLM 的参数,只训练降维矩阵 A 与升维矩阵 B 。而模型的输入输出维度不变,输出时将 BA 与 PLM 的参数叠加。

-

用随机高斯分布初始化 A ,用 0 矩阵初始化 B ,保证训练的开始此旁路矩阵依然是 0 矩阵。

3. Leetcode 题

具体题意记不清了,但是类似 【两数之和】

- 题目内容

给定一个整数数组 nums 和一个整数目标值 target,请你在该数组中找出 和为目标值 target 的那 两个 整数,并返回它们的数组下标。

你可以假设每种输入只会对应一个答案。但是,数组中同一个元素在答案里不能重复出现。

你可以按任意顺序返回答案。

示例 1:``输入:nums = [2,7,11,15], target = 9 输出:[0,1] 解释:因为 nums[0] + nums[1] == 9 ,返回 [0, 1] 。``示例 2:``输入:nums = [3,2,4], target = 6 输出:[1,2]``示例 3:``输入:nums = [3,3], target = 6 输出:[0,1]``提示:``2 <= nums.length <= 10**4``-109 <= nums[i] <= 109``-109 <= target <= 109

- 代码实现

def twoSum(nums, target):` `hashmap={}` `for ind,num in enumerate(nums):` `hashmap[num] = ind` `for i,num in enumerate(nums):` `j = hashmap.get(target - num)` `if j is not None and i!=j:` `return [i,j]

附上技术清单

在这里,我们想要强调的是:成功求职并不是一件难事,关键在于你是否做好了充分的准备。通过学习和掌握AI技术的相关知识和技能,了解面试中可能出现的问题和技巧,你就能够在面试中展现出自己的专业素养和实力,赢得面试官的青睐和认可。因此,让我们一起努力,用知识和技能武装自己,迎接AI时代的挑战和机遇吧!

有需要的朋友可以扫描下方二维码,免费获取更多相关资料!

最后,祝愿所有转行、求职的同学都能够在AI产品面试中取得优异的成绩,找到心仪的工作!加油!

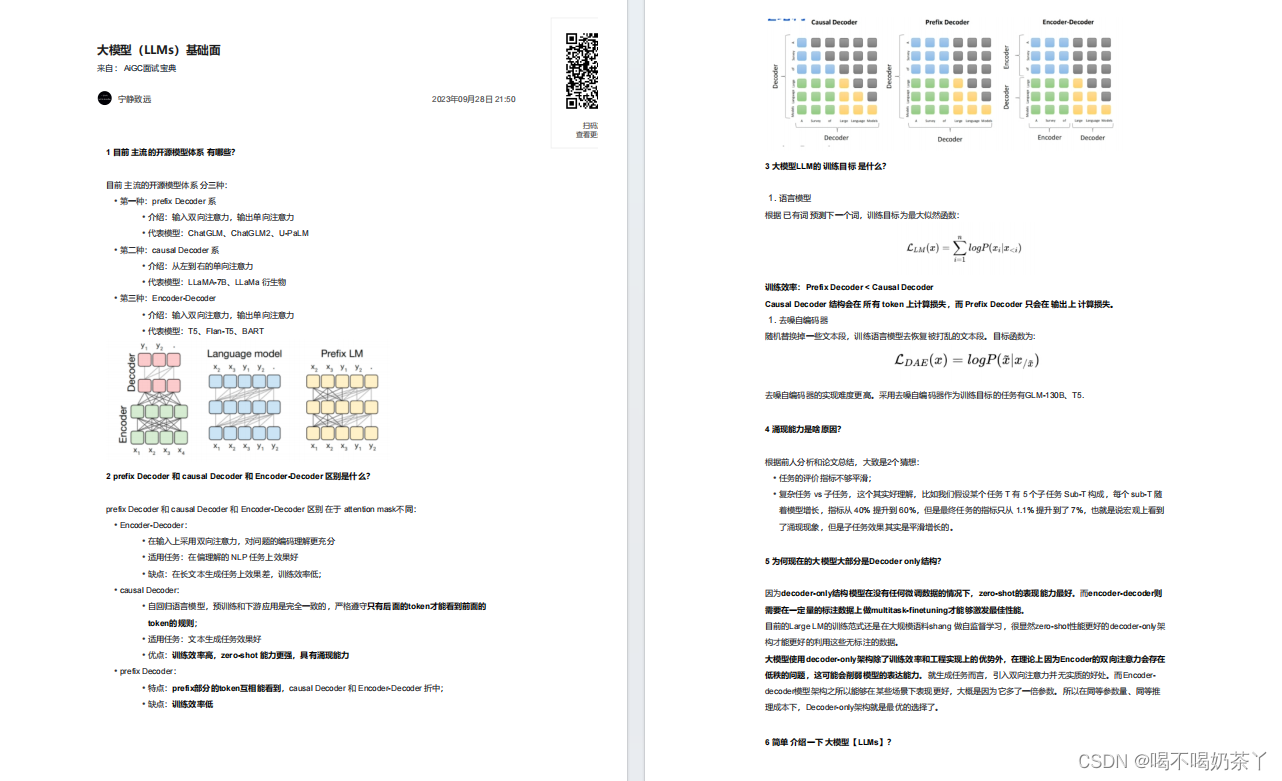

大模型基础面

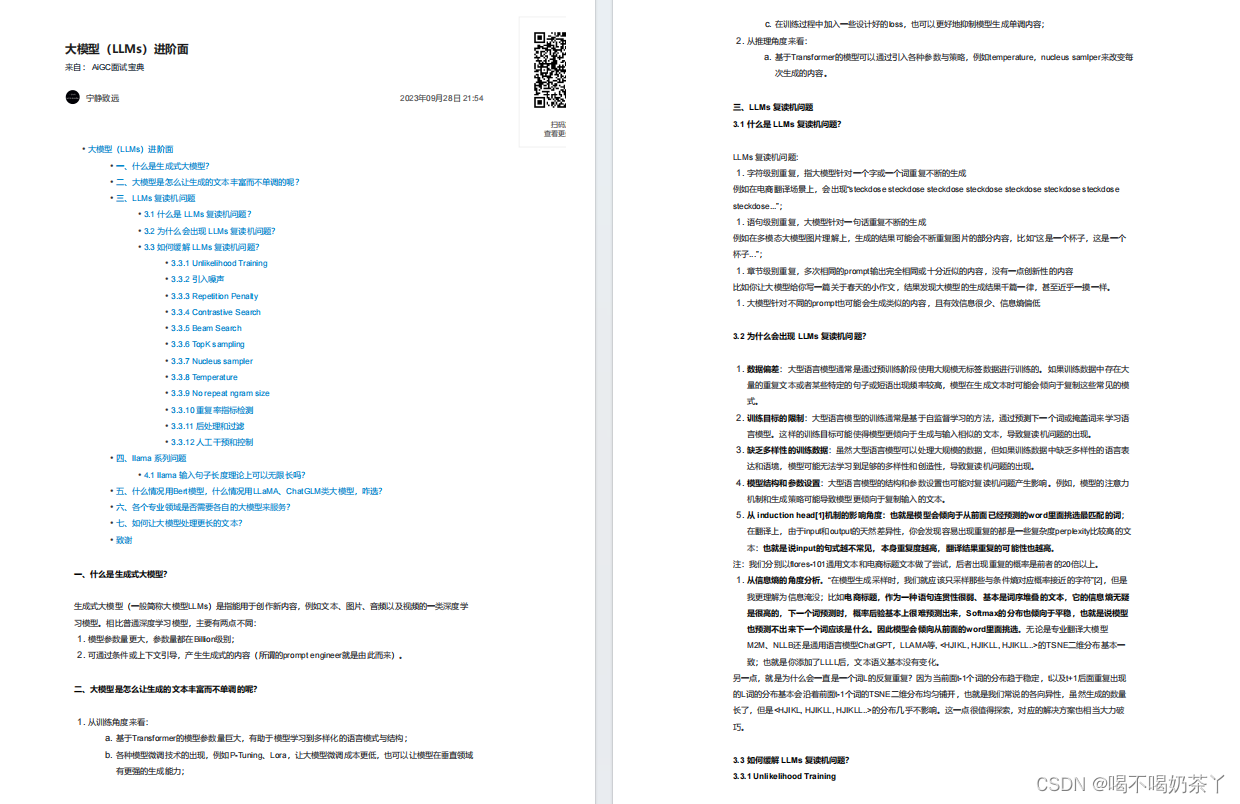

大模型进阶面

大模型微调面

大模型langchain面

大模型推理面

更多面试题分享

713

713

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?