传统的神经网络,也称为前馈神经网络(F eed- Forward Neural Network, FNN),由一系列简单的神经元组成,包括输入层、隐藏层和输出层。其层级结构通常为每层神经元与下一层神经元全连接,同层的神经元之间不存在连接。网络结构上不存在环或者回路,网络的输出和模型本身不存在反馈连接。数据从输入层开始逐层通过网络,直到输出层。这些连接的权重编码了网络的知识。使用x、y分别代表网络的输入和输出,FNN的目标在于近似某个映射关系f,即y=f (x;θ),学习参数θ之后,使其能够得到最佳的近似关系。

在FNN中,所有的观测值都是相互独立地进行处理。然而许多任务中的数据富合大最的上下文信息彼此之间也有复杂的关联性,比如,音频、视频和文本等,因此FNN在许多任务中仍然存在很大的局限性。也有一些方法为输入提供上下文信息比如,通过固定大小的窗口来将当前特征向最和先前的特征向是连接,但是这种方法的缺点也是显而易见的通常可能需要更长的训练时间以及固定的、相对较短的上下文依赖。

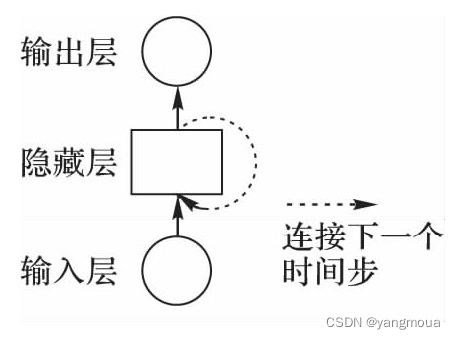

循环神经网络(Recurrent Neural Network, RNN)主要用于处理序列数据,其最大的特点就是神经元在某时刻的输出可以作为输入再次输入到神经元,这种串联的网络结构非常适合于时间序列数据,可以保持数据中的依赖关系。RNN是深度学习领域中一类特殊的内部存在自连接的神经网络, 可以学习复杂的矢量到矢量的映射。

对于展开后的RNN,可以得到重复的结构并且网络结构中的参数是共享的,大大减少了所需训练的神经网络参数。共享参数也使模型可以扩展到不同长度的数据上,所以RNN的输入可以是不定长的序列。虽然RNN在设计之初的目的是为了学习长期的依赖性,但实践表明标准的RNN往往很难实现信息的长期保存。Bengio等提出标准RNN存在梯度消失和梯度爆炸的困扰,这两个问题都是由于RNN的迭代性引起的。

RNN的网络结构,通过隐藏层上的回路连接,使得前一时刻的网络状态能够传递给当前时刻,当前时刻状态也可以传递给下个时刻。

可以将RNN看作所有层共享权值的深度FNN,通过连接两个时间步来扩展。参数共享的概念早在隐马尔可夫模型(Hidden Markov Model, HMM)中就已经出现,HMM也常用于序列数据建模主要应用于语音识别领域。HMM和RNN均使用内部状态来表示序列中的依赖关系。当时间序列数据存在长距离的依赖,并且该依赖的范围目随时间变化或者未知,那么RNN可能是相对较好的解决方案。

图中,在时刻t,隐藏单元h接收来自两方面的数据,分别为网络前一时刻的隐藏单元的值ht-1和当前的输入数据xt,并通过隐藏单元的值计算当前时刻的输出。t-1时刻的输入Xt-1可以在之后通过循环结构影响时刻的输出。RNN的前向计算按照时间序列展开,然后使用基于时间的反向传播算法(Back Propagation Through Time, BPTT) [8]对网络中的参数进行更新,也是目前循环神经网络最常用的训练算法。

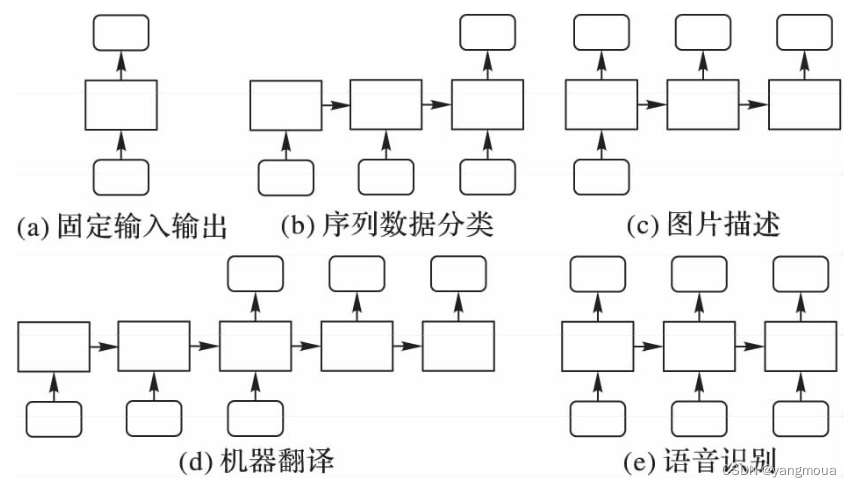

FNN中,通过学习得到的映射关系,可以将输入向量映射到输出向量,从而使得输入和输出向量相互关联,RNN是前馈神经网络在时间维度上的扩展。对于FNN, 它接受固定大小的向量作为输入并产生固定大小的输出,这样对于输入的限制就很大;然而,RNN并没有这个限制,无论是输入序列的长度还是输出序列。

(a)表示传统的、固定尺度的输入到固定尺度的输出; (b) 序列输入,可用于表示例如情感分析等任务,给定句子然后将其与一个情感表示向量关联; (C)序列输出,可以用于表示图片标注等任务,输入固定大小的向量表示的图片,输出图片描述; (d)和(e)中的输入和输出均为序列数据,且输入和输出分别为非同步和同步,(d)可以用于机器翻译等任务,(e)常用于语音识别中。

755

755

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?