来源: AINLPer微信公众号(每日干货分享!!)

编辑: ShuYini

校稿: ShuYini

时间: 2022-10-11

引言

实体作为现实世界知识的重要载体,在许多 NLP 任务中发挥着关键作用,许多实体密集型 NLP 任务需要模型获取实体知识以生成信息输出。现有方法大多采用索引、检索和读取外部文档来获取实体知识,但是这样需要很大的计算开销。为此本文提出了一个带有实体内存(Memory)的Encoder-Decoder框架,即EDMem。

关注 AINLPer公众号,回复:历年EMNLP 获取论文下载列表

背景介绍

大量现实世界的知识与实体有关,例如人、国家和事件。实体知识是描述与实体相关的事实和属性的信息。许多实体密集型 NLP 任务需要模型获取实体知识以生成信息输出,例如回答事实问题、解释声明或进行信息对话。预训练的Encoder-Decoder模型可以直接应用于此类实体密集型任务,但它们存储和使用知识的方法仍然存在一定的问题。将知识纳入生成过程的一种主流做法是从外部来源检索证据文件。但是,它们在索引、检索和读取大量额外文档时会需要巨大的计算开销。因此,在不牺牲太多性能的情况下,让Encoder-Decoder模型访问实体知识非常重要。

最近,有人提议使用模型内部存储,用实体链接任务的实体知识来增强自动编码器模型。实体内存将实体知识存储为密集向量,可以直接合并到Transformer模型的隐藏状态中,而不需要编码额外的文本。然而,以前方法中的自动编码器框架只能从预定义的实体词汇表中选择实体,但是不能给出词汇表以外的实体,更不能生成单个实体以外的答案或文本。

基于以上考虑,本文提出了一个具有实体内存(EDMem)的新的Encoder-Decoder框架。EDMem 是各种实体密集型 QA 和生成任务的统一框架,我们在其中训练实体记忆来实现高效的知识整合。

模型介绍

EDMem的模型架构

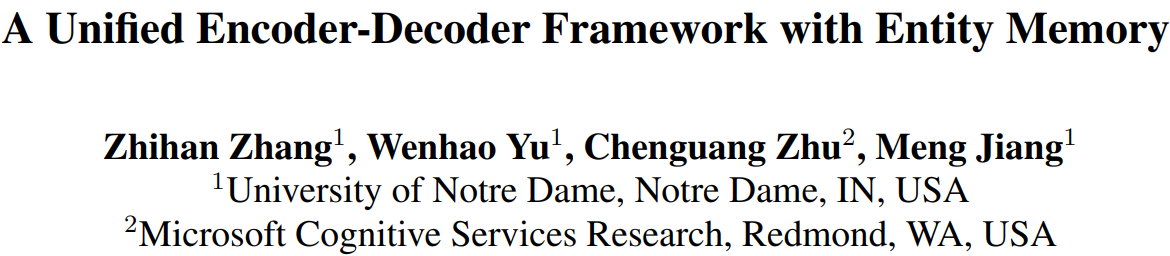

EDMem的模型架构图如下所示。该框架有一个Transformer编码器、一个Transformer解码器、一个实体存储器和两个预测头。

其中,编码器和解码器都有两部分:(L1×)下层和(L2×)上层。 EDMem 中的 Transformer 层与 BART 具有相同的架构。在较低层的末尾,允许 EDMem 使用隐藏状态作为查询来访问实体内存。在上层执行进一步推理之前,将每次内存访问获得的知识表示与隐藏状态相加并归一化。两个预测头使用解码器的最终隐藏状态进行预测:一个用于标记预测的 LM 头和一个用于实体预测的实体链接头。

实体内存

实体内存包含一个大型嵌入表,该表存储实体嵌入。直观地说,实体嵌入包含维基百科文档中所有提及实体的上下文信息。 在编码和解码过程中,EDMem 在遇到提及时会查询实体内存。

模型调优

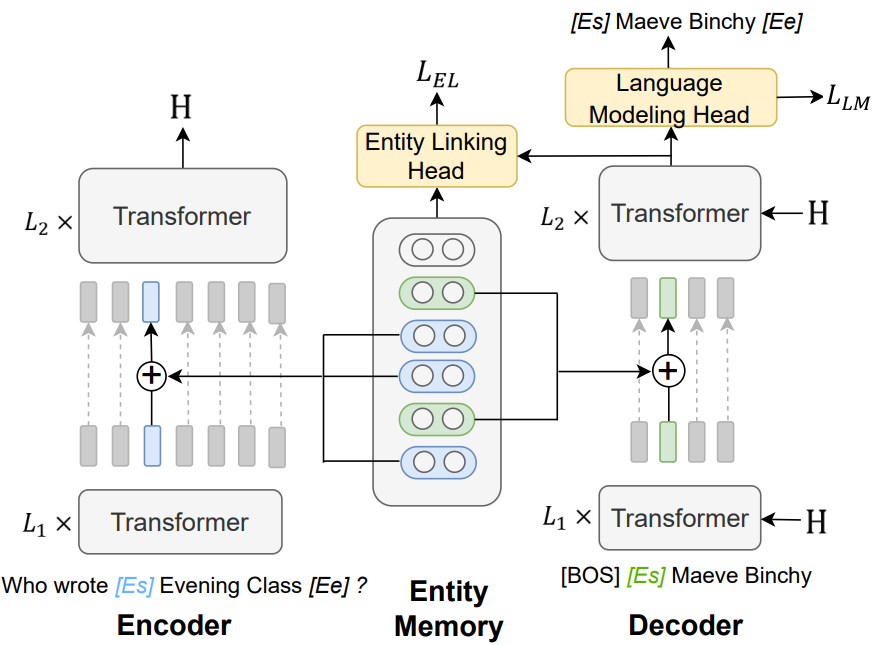

在下游任务上对其进行微调时,为了精确生成实体名称,利用 EDMem 在其生成过程中的实体链接能力,我们设计了三种解码方法。如下图所示:

其中包括:

- (1) 自由形式:使用实体标识符从左到右生成;

- (2)静态实体链接:首先通过实体链接选择实体,为选择的实体构建前缀树,然后利用树进行约束实体生成;

- (3) 动态实体链接:动态选择实体以生成受约束的实体。

实验结果

本文在实体知识的两个测试平台上测试了我们的EDMem框架:开放域QA和实体密集型生成任务。

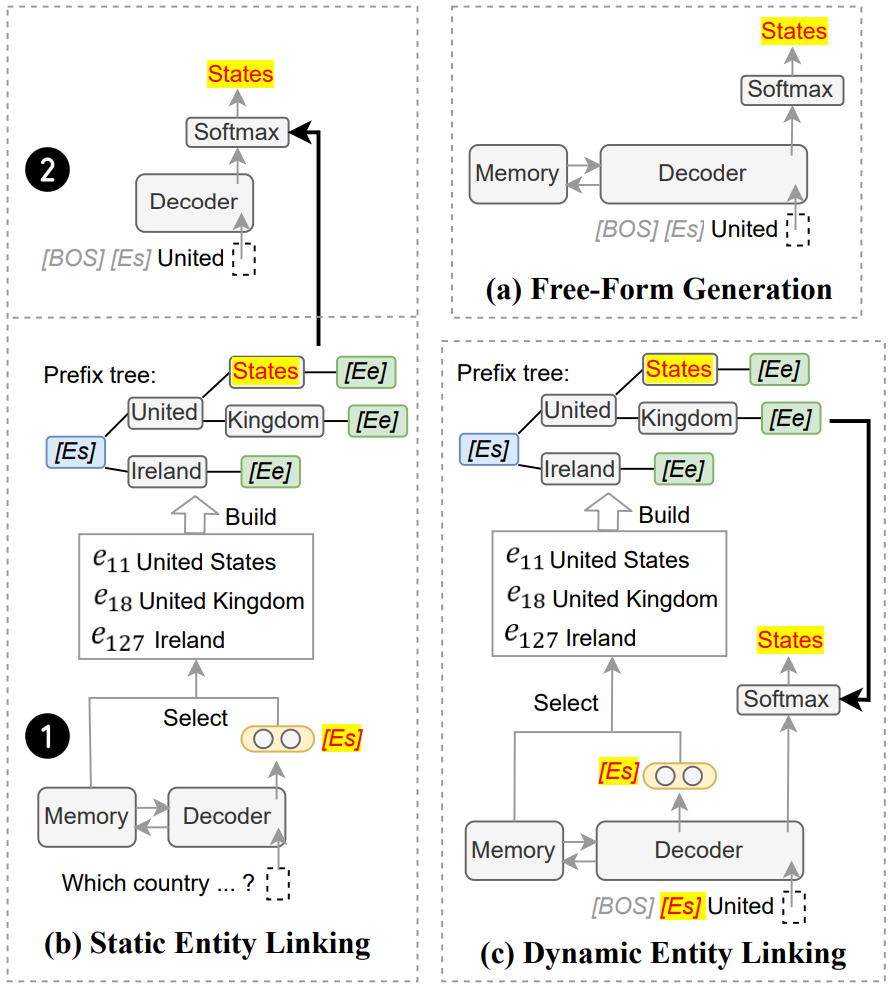

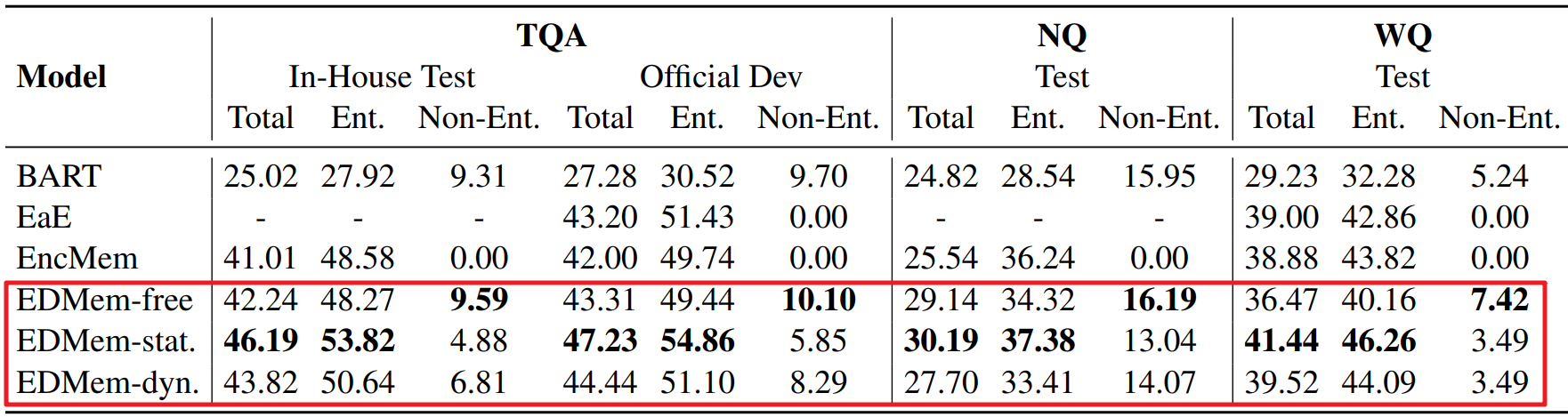

1、开放域 QA 数据集的精确匹配分数如下图。粗体分数和下划线分数是闭卷模型中最好和次优的结果。(*传统的编码器-解码器模型,†基于内存的自动编码器模型)

在开放域QA中,实体答案(“Ent.”)和非实体答案(“Non-Ent.”)的精确匹配分数。

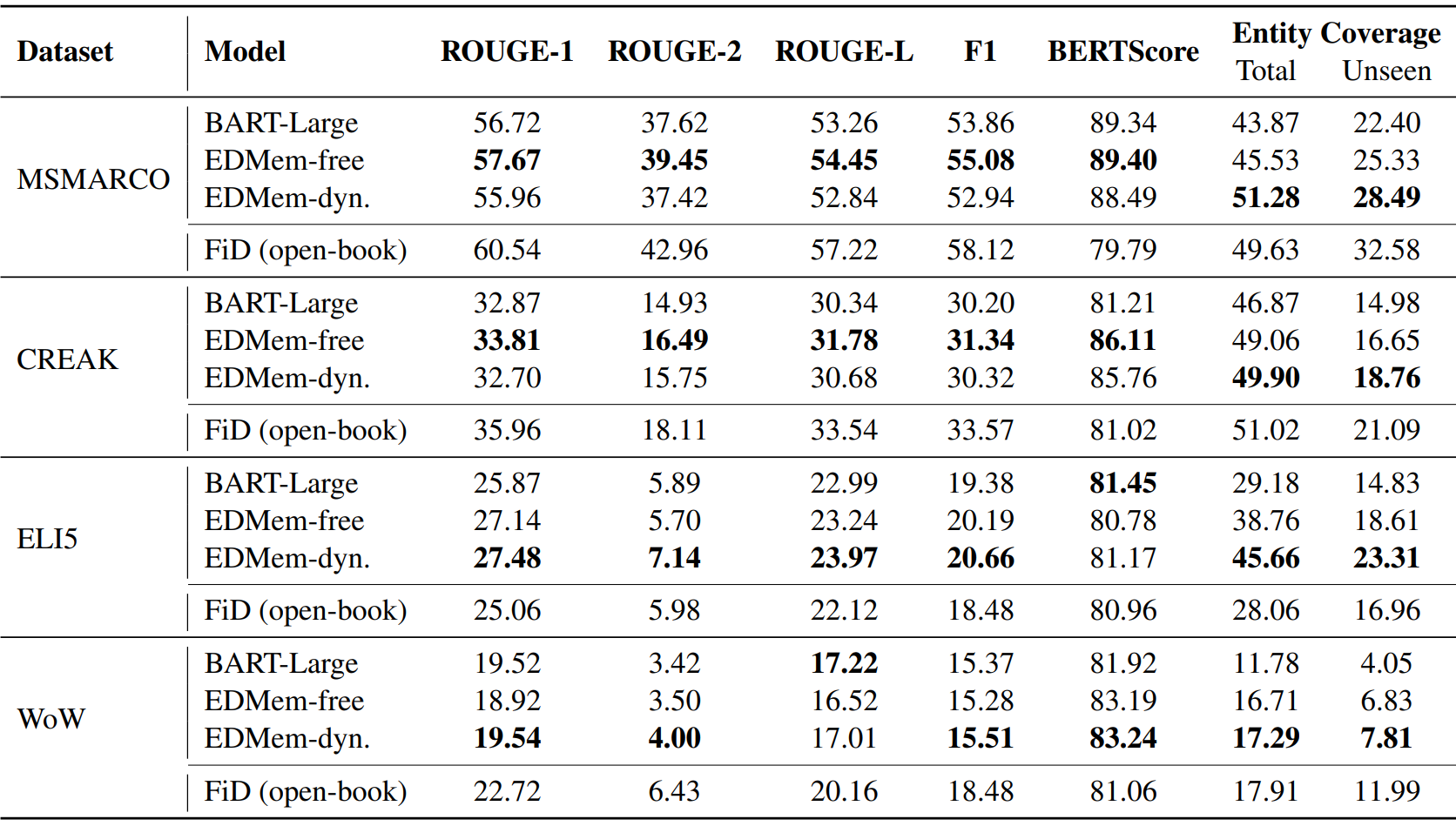

2、实体密集型生成数据集的结果。在close-book模型中,加粗分数是最好的结果。

论文&&源码

Paper:https://arxiv.org/pdf/2210.03273.pdf

推荐阅读

[1] 一文了解EMNLP国际顶会 && 历年EMNLP论文下载 && 含EMNLP2022

[2]【历年NeurIPS论文下载】一文带你看懂NeurIPS国际顶会(内含NeurIPS2022)

[3]【微软研究院 && 含源码】相比黑盒模型,可解释模型同样可以获得理想的性能

[4]【IJCAI2022&&知识图谱】联邦环境下,基于元学习的图谱知识外推(阿里&浙大&含源码)

[5]【NLP论文分享&&语言表示】有望颠覆Transformer的图循环神经网络(GNN)

[6]【NeurIPS && 图谱问答】知识图谱(KG) Mutil-Hop推理的锥形嵌入方法(中科院–含源码)

492

492

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?