25年3月来自台湾清华、Nvidia 公司、台大和 Aeolus 机器人公司的论文“Segment Anything, Even Occluded”。

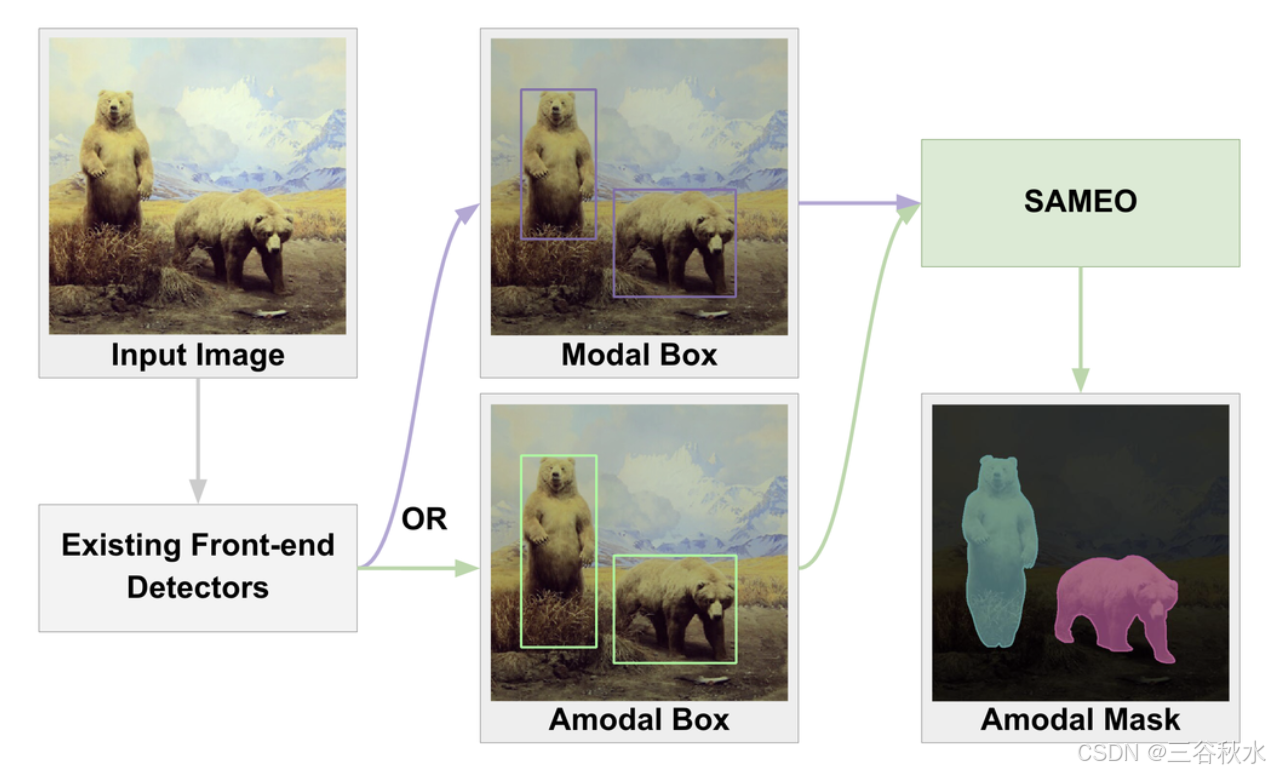

非模态实例分割,旨在检测和分割图像中物体的可见和不可见部分,在自动驾驶、机器人操控和场景理解等各种应用中发挥着至关重要的作用。虽然现有方法需要联合训练前端检测器和掩码解码器,但这种方法缺乏灵活性,无法利用现有模态检测器的优势。为了解决这一限制,SAMEO,采用 Segment Anything 模型 (SAM) 作为多功能掩码解码器,能够与各种前端检测器接口,即使对于部分遮挡的物体也能进行掩码预测。考虑到有限的非模态分割数据集的限制,推出一个大规模合成数据 Amodal-LVIS,包含 300K 张来自模态 LVIS 和 LVVIS 数据集的图像。该数据集大大扩展可用于非模态分割研究的训练数据。实验结果表明,该方法在包括 Amodal-LVIS 在内的新扩展数据集上进行训练时,在 COCOA-cls 和 D2SA 基准上都实现卓越的零样本性能,凸显其泛化到未知场景的潜力。

人类视觉感知的范围超出了场景中直接可见的范围。通过结合物体识别和关于物体类别的先验知识,可以自然地想象和理解部分遮挡物体的完整形状。即使正确分类物体很困难,也常常可以通过分析可见部分和推理常见的遮挡模式来推断部分可见物体的完整形状 [9, 20, 24]。非模态实例分割,试图复制这种非凡的人类能力,通过检测和定位图像中的物体并预测其完整形状(包括可见部分和遮挡部分)(如图所示)。

解决非模态实例分割的一个有效方法是将任务分为两个主要部分:物体检测和掩码分割。近年来,物体检测取得了重大进展,RTMDet [16] 和 ConvNeXt-V2 [28] 等最先进的模型取得令人印象深刻的性能。然而,当前的非模态分割方法通常需要联合训练检测器和掩码解码器,这使得它们无法充分利用这些强大的预训练模态检测器。这一限制促使开发一个更灵活的框架,该框架可以利用现有的模态检测器,同时仍保持强大的非模态分割能力。视觉理解基础模型的出现,为分割任务开辟了新的可能性。其中,分割任何模型 (SAM) [11] 及其高效变型 EfficientSAM [29] 在基于提示的模态分割中表现出卓越的能力。利用 EfficientSAM 的架构,其具有一个轻量级编码器以实现更快的推理,并通过专门的训练使其适应非模态分割。

启用非模态掩码预测

准备工作:EfficientSAM。任何分割模型 (SAM) [11] 是图像分割的基础模型,可以根据任何提示生成高质量的目标掩码。原始 SAM 架构由三个主要组件组成:i)将输入图像转换为图像嵌入的图像编码器,ii)将提示(点,框)转换为统一嵌入的轻量级基于 Transformer 提示编码器,以及 iii)利用具有两个交叉注意层的 Transformer 架构来处理图像和提示嵌入,生成最终分割掩码的掩码解码器。在方法中,主要使用 EfficientSAM [29],这是原始 SAM 模型的紧凑适配。EfficientSAM 用轻量级 ViT 变型 [2] 替换 SAM 的图像编码器,同时保留原始提示编码器和掩码解码器。

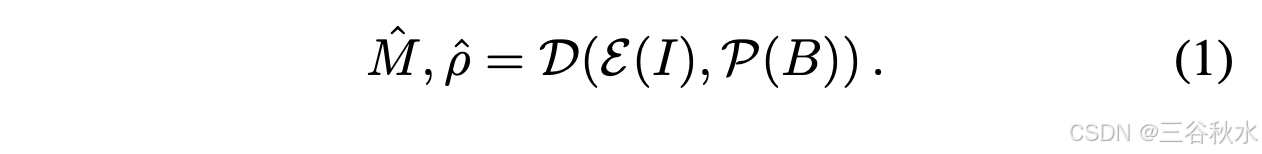

模型架构。提出 SAMEO 用于非模态实例分割,保留 EfficientSAM 原始架构中的轻量级图像编码器 E、基于Transformer 的提示编码器 P 和具有双交叉注意层的掩码解码器 D。给定输入图像 I 和边框提示 B,提出的 SAMEO 流水线预测非模态掩码 Mˆ 和估计的 IoU ρˆ 如下:

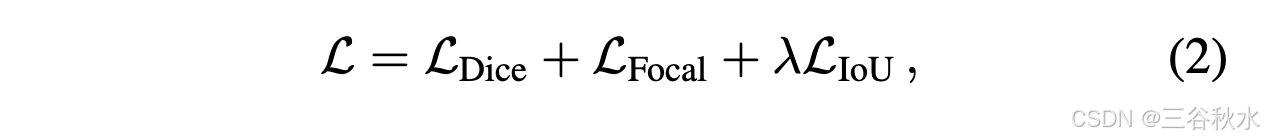

训练策略。在训练期间,专门微调 EfficientSAM 的掩码解码器,同时保持图像编码器和提示编码器的原始权重不变。该模型接收两个输入:图像和来自真值注释的边框提示。边框提示是从模态和非模态真值边框中以相等的概率随机选择的。训练目标结合 Dice 损失 [17]、Focal 损失 [15] 和 L1 损失以进行 IoU 估计:

推理流水线。对于推理,SAMEO 可以灵活地与各种物体检测器集成,包括非模态检测器(例如 AISFormer [25])和传统模态检测器(例如 RTMDet [16])。检测输出作为模型的边框提示,然后生成相应的非模态掩码(如图所示)。这种模块化设计使模型能够通过非模态分割功能增强现有的检测系统,同时实现最先进的性能。

非模态数据集收集

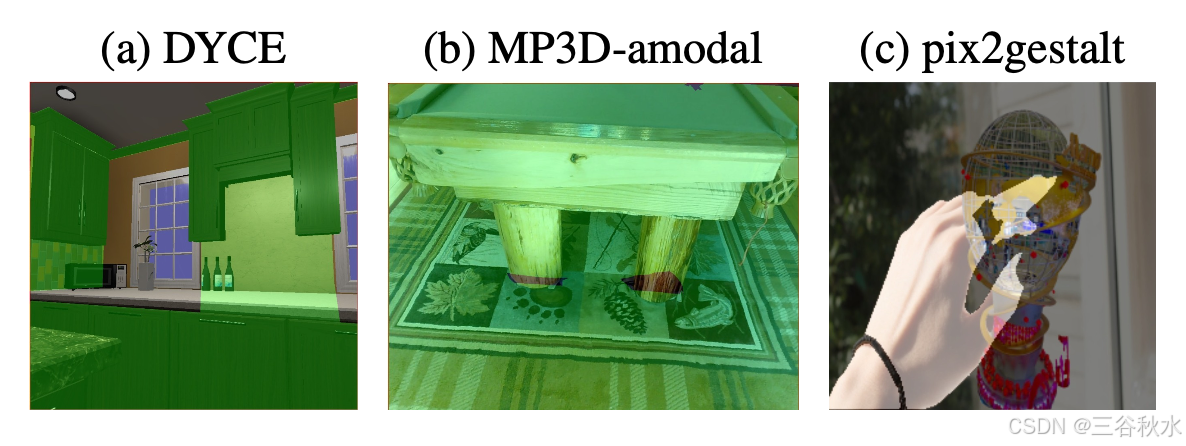

现有非模态数据集的局限性。现有的非模态数据集在手动和合成注释机制方面都存在固有的局限性。人工注释的数据集虽然与现实世界场景非常接近,但制作成本高,并且在遮挡区域估计中容易出错。合成数据集虽然生成效率高,但缺乏可靠的目标完整性验证机制,可能无法准确反映自然遮挡模式(如图所示)。

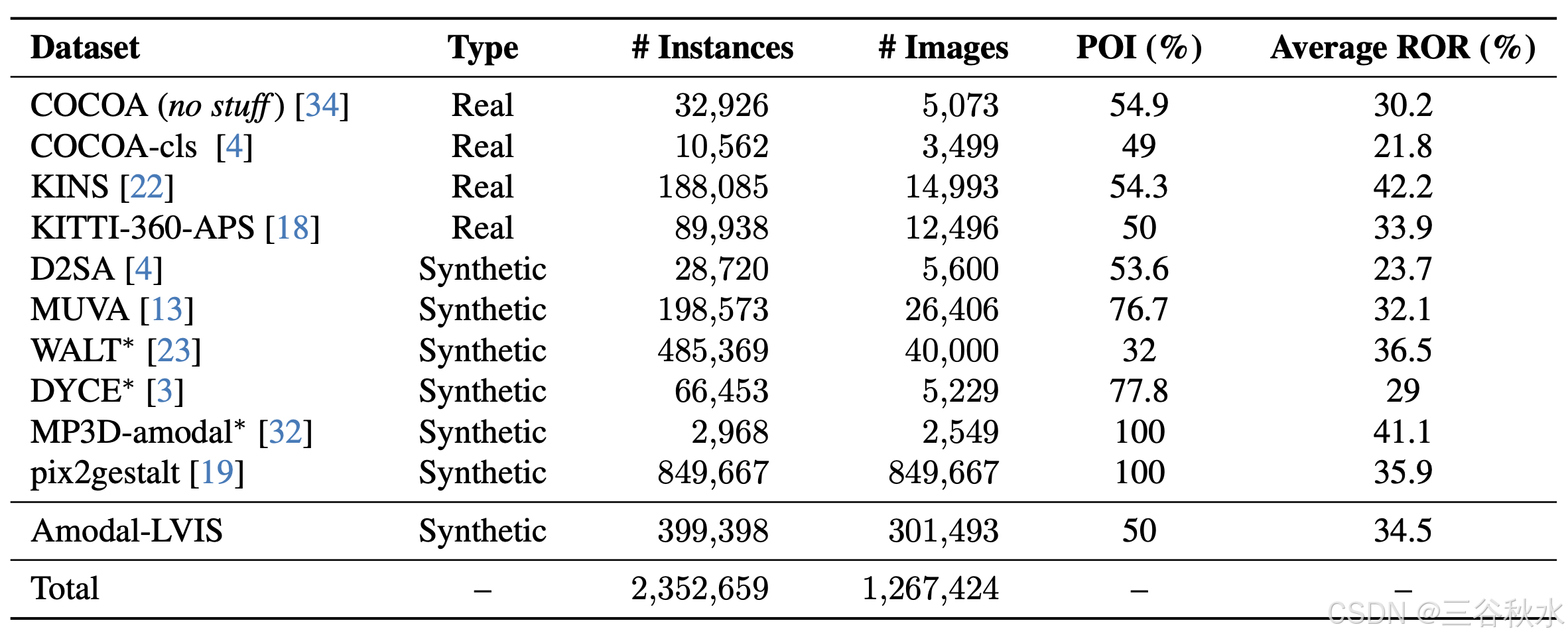

数据集收集和质量控制。为了充分利用这两种机制的优势,收集并过滤两种注释类型的数据集。清理过程解决每个数据集中的特定问题,以确保数据质量,同时保持真实的遮挡表征(下表所示)。

对于使用 3D 家具网格生成的合成数据集 DYCE 和 MP3D-amodal,确定并解决两个主要质量问题:占据大部分图像空间的无意义建筑元素(墙壁、地板、天花板)和可见区域最小的物体。实施过滤器以删除可见部分占整个物体不到 10% 的情况、占图像区域超过 90% 的物体以及建筑元素注释。

WALT 数据集利用道路监控延时(time- lapse)镜头来生成合成数据。它使用预训练的检测器获取汽车和人的边框,然后通过分析这些边框交点来识别完整的物体。然后将这些发现的完整目标重新合成到相同的场景中,以生成合成训练数据。但是,它们的逐层放置可能会产生不切实际的遮挡。通过实施带遮挡阈值的过滤器来确保自然的遮挡模式,从而解决这个问题。

对于具有类注释的其他数据集,例如 CO-COA,语义标签的可用性使直接的质量控制成为可能。在这些数据集中过滤掉“填充”类注释,专注于与非模态实例分割目标一致的有意义目标。

Amodal-LVIS

本文提出一种用于非模态掩模分割的合成数据集,通过精确的目标遮挡生成、结合完整的目标集合、合成遮挡生成和双重注释机制来防止模型偏差。结合现有数据集,该集合总共有 100 万张图像和 200 万个实例注释。

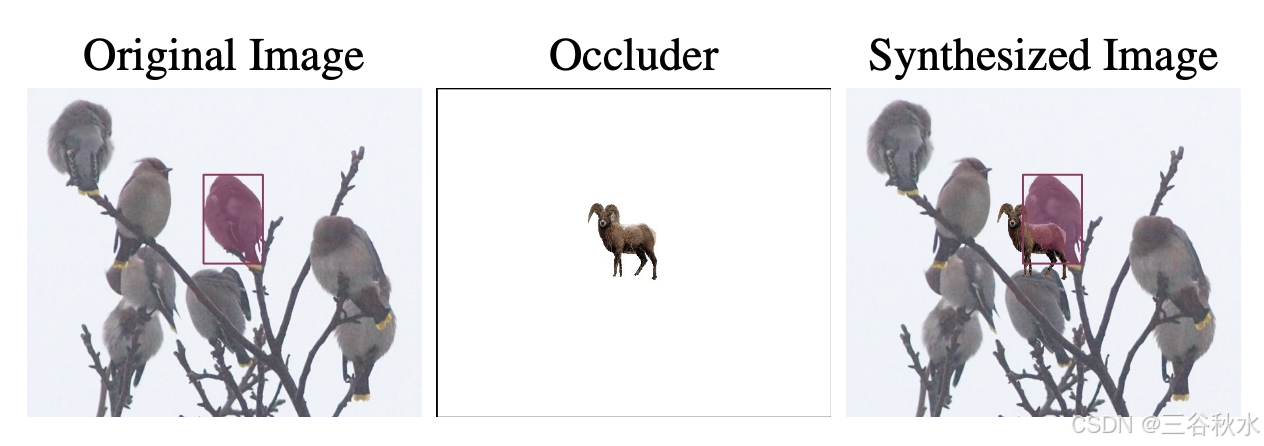

完整目标集合。为了获得用于合成遮挡的完整目标,利用在前面提到的非模态数据集上预训练的 SAMEO 来为 LVIS 和 LVVIS 数据集中的实例生成伪标签。模型预测每个实例的非模态掩码,然后将其与真值可见掩码注释进行比较。这种比较有助于识别完整、未被遮挡的目标。

合成遮挡生成。遮挡生成过程涉及从收集的池中随机配对选择的完整目标。为了确保遮挡看起来逼真,将配对的目标标准化为相似的尺寸,同时保持它们的纵横比。使用边框注释控制目标定位和遮挡率,从而可以精确管理目标如何相互遮挡。

双重注释机制。实验表明,仅对遮挡掩码进行训练会导致模型混乱,即使提示旨在针对前景实例,也会导致对遮挡目标的过度预测。为了解决这个问题,在数据集中同时包含遮挡和原始未遮挡的实例(如图所示)。这种双重注释机制可防止遮挡偏差,同时为这两种状态提供全面的训练示例。

模型在 NVIDIA Tesla V100/A100 GPU 上分别在 COCOA-cls/D2SA/MUVA 上进行 1,440/2,340/22,500 次迭代训练。对于零样本 SAMEO,将批量大小增加到 32 并进行 40,000 次迭代训练。使用 Adam 优化器,学习率为 1 × 10−4,没有任何学习率调度程序。对于训练期间的每个实例,以相等的概率随机选择非模态或模态真值边框作为提示。

对于训练,使用搜集的数据集和提出的 Amodal-LVIS 数据集。至于评估,使用 COCOA-cls、D2SA 和 MUVA 数据集。主要将方法与 AISFormer(目前最先进的非模态实例分割模型)进行比较。与结合目标检测和掩码解码组件的传统实例分割模型不同,SAMEO 仅用作掩码解码器。这使模型可以灵活地与现有的非模态和模态实例分割模型集成,使用它们的目标框预测作为提示来生成精炼的非模态掩码。为了进行全面评估,将结果与这些前端模型的原始掩码预测进行比较。

为了评估零样本性能,将比较范围扩展到 AISFormer 之外,包括配备原始 EfficientSAM 作为掩码解码器的模态和非模态前端模型。这个比较证明了将 EfficientSAM 应用于非模态掩模分割,同时保持零样本能力。

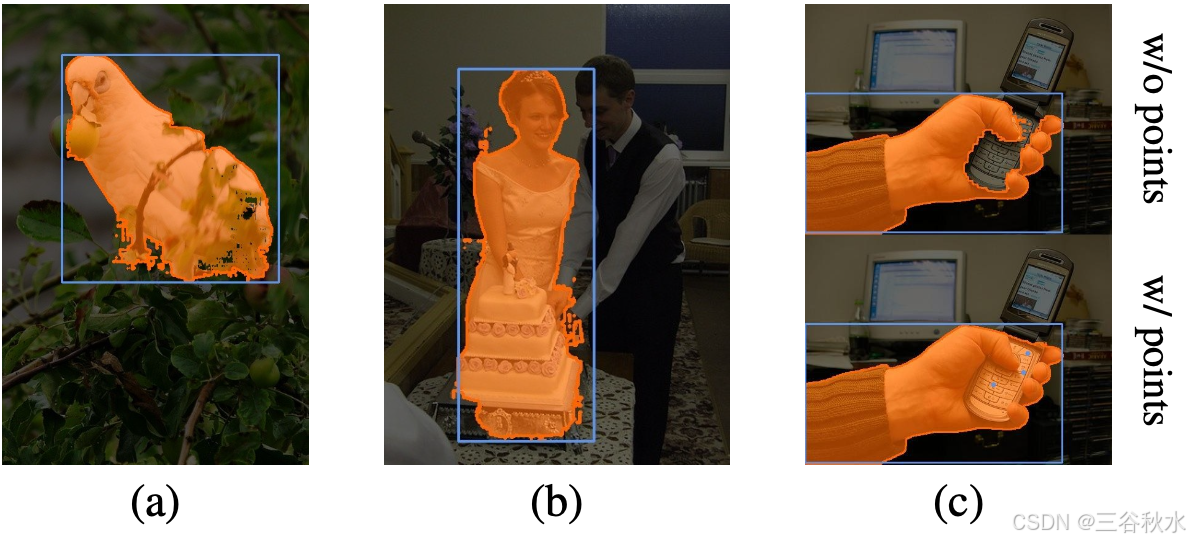

尽管 SAMEO 在得分和质量方面都明显优于 SOTA 方法,但它仍然面临着困难案例的挑战,如图所示:不完整的非模态掩码 (a)、粗糙的边缘 (b) 和意外的模态输出 (© 的顶部)。当多个目标重叠时,单独使用边框提示可能会导致模型混淆。使用边框和点提示的额外实验,显示出在增强目标区域预测方面有希望的结果 (© 的底部)。相信探索不同的提示类型,是未来工作的一个方向。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?