基于关系的知识蒸馏

1、基于响应和基于特征的知识都使用了教师模型中特定层的输出。基于关系的知识进一步探索了不同层或数据样本之间的关系。为了探索不同特征图之间的关系,Yim等人(2017)提出了一种解过程流程(FSP),它由两层之间的克矩阵定义。

Yim, J., Joo, D., Bae, J. & Kim, J. (2017). A gift from knowledge distillation: Fast optimization, network minimization and transfer learning. In: CVPR.

2、FSP矩阵总结了特征映射对之间的关系。它是利用两层特征之间的内积来计算的。利用特征图之间的相关性作为提取的知识,提出通过奇异值分解的知识蒸馏来提取特征图中的关键信息。

Lee, S. H., Kim, D. H. & Song, B. C. (2018). Self-supervised knowledge distillation using singular value decomposition. In: ECCV.

3、为了利用多个教师的知识,Phang和Peng(2018)分别将每个教师模型的对数和特征作为节点,形成了两个图。

Zhang, C. & Peng, Y. (2018). Better and faster: knowledge transfer from multiple self-supervisedlearning tasks via graph distillation for video classification. In: IJCAI.

4、具体来说,不同教师的重要性和关系是通过知识转移前的logit图和表示图来建模的(Zhang and Peng,2018)。基于多头图的知识蒸馏技术由Lee和Song(2019)提出。

Lee, S. & Song, B. (2019). Graph-based knowledge distillation by multi-head attention network. In: BMVC.

5、图知识是通过多头注意网络得到的任意两个特征图之间的数据内关系。为了探索成对的提示信息,学生模型还模拟了来自教师模型的成对提示层的互信息流(Passalis et al.,2020b)。

Passalis, N., Tzelepi, M., & Tefas, A. (2020b). Heterogeneous Knowledge Distillation using Information Flow Modeling. In: CVPR.

6、一般来说,基于特征映射关系的基于关系的知识的蒸馏损失可以表述为:

其中,ft和fs分别为教师模型和学生模型的特征图。Ψt(.)和Ψs(.)是来自教师和学生模型的特征映射对的相似性函数。LR1 (.)表示教师与学生的特征图之间的相关函数。

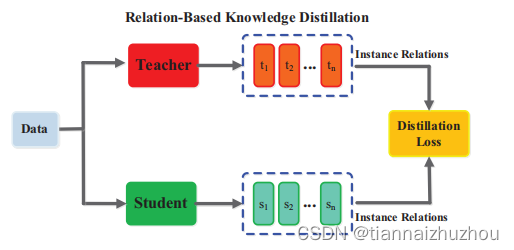

7、传统的知识转移方法往往涉及到个人知识的提炼。教师的个人软目标被直接提炼成学生。事实上,提炼后的知识不仅包含特征信息,还包含数据样本之间的相互关系(You等人,2017;Park等人,2019年)。

You, S., Xu, C., Xu, C. & Tao, D. (2017). Learning from multiple teacher networks. In: SIGKDD.

Park, W., Kim, D., Lu, Y. & Cho, M. (2019). Relational

knowledge distillation. In: CVPR.

8、IRG:具体来说,Liu等人(2019)提出了一种通过实例关系图的鲁棒而有效的知识蒸馏方法。实例关系图中传递的知识包含实例特征、实例关系和特征空间转换跨层。

Liu, Y., Cao, J., Li, B., Yuan, C., Hu, W., Li, Y. & Duan, Y. (2019g). Knowledge distillation via instance relationship graph. In: CVPR.

9、Park等人(2019)提出了一种关系知识蒸馏方法,它将知识从实例关系中转移出来。LP:基于流形学习的思想,通过特征嵌入的方式学习学生网络,它保留了教师网络中间层样本的特征相似性(Chen et al.,2021)。

Chen, H., Wang, Y., Xu, C., Xu, C. & Tao, D. (2021). Learning student networks via feature embedding. IEEE TNNLS 32(1): 25-35.

10、使用数据的特征表示,将数据样本之间的关系建模为概率分布(Passalis和Tefas,2018;Passalis等人,2020a)。

Passalis, N. & Tefas, A. (2018). Learning deep representations with probabilistic knowledge transfer. In:ECCV.

Passalis, N., Tzelepi, M., & Tefas, A. (2020a). Probabilistic Knowledge Transfer for Lightweight Deep Representation Learning. TNNLS. DOI: 10.1109/TNNLS.2020.2995884.

11、SP:教师和学生的概率分布与知识转移相匹配。(Tung和Mori,2019)提出了一种类似的保存知识蒸馏方法。特别是,由教师网络中输入对的相似激活所产生的相似性保留知识被转移到学生网络中,并保留了成对的相似性。

Tung, F. & Mori, G. (2019). Similarity-preserving knowledge distillation. In: ICCV.

12、CCKD:Peng等人(2019a)提出了一种基于相关一致性的知识蒸馏方法,其中提取的知识既包含实例级信息,也包含实例之间的相关性。利用相关一致性进行蒸馏,学生网络可以学习实例之间的相关性。

Peng, B., Jin, X., Liu, J., Li, D., Wu, Y., Liu, Y. & et al. (2019a). Correlation congruence for knowledge distillation. In: ICCV.

13、如上所述,基于实例关系的基于关系的知识的蒸馏损失可以表述为:

其中(ti,tj)∈Ft和(si,sj)∈Fs,Ft和Fs分别是来自教师和学生模型的特征表示集。ψt (.)和ψs(.)是(ti、tj)和(si、sj)的相似性函数。LR2 (.)是教师和学生特征表示之间的相关函数。一个典型的基于实例关系的KD模型如图所示。

总结

蒸馏知识可以从不同的角度进行分类,如数据的结构化知识(IRG;LP;CCKD;SP;tian等人,2020年)

Tian, Y., Krishnan, D. & Isola, P. (2020). Contrastive representation distillation. In: ICLR.

关于输入特征的特权信息(Lopez-Paz等人,2016年;Vapnik, V. & Izmailov,2015年)。

Lopez-Paz, D., Bottou, L., Sch¨olkopf, B. & Vapnik, V. (2016). Unifying distillation and privileged information. In: ICLR.

Vapnik, V. & Izmailov, R. (2015). Learning using privileged information: similarity control and knowledge transfer. J Mach Learn Res 16(1): 2023-2049.

表2显示了基于关系的知识的不同类别的摘要。虽然最近提供了一些类型的基于关系的知识,但如何将特征图或数据样本中的关系信息建模作为知识仍值得进一步研究。

from:Knowledge Distillation: A Survey

1320

1320

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?