一、文章情况介绍

文章题目:《SAN: Scale-Aware Network for Semantic Segmentation of High-Resolution Aerial Images》

文章的下载链接:https://arxiv.org/pdf/1907.03089.pdf

文献引用格式:J. Lin, W. Jing, H. Song. "SAN: Scale-Aware Network for Semantic Segmentation of High-Resolution Aerial Images." IEEE GEOSCIENCE AND REMOTE SENSING LETTERS. 2019 (目前还未正式发表)

项目地址:目前还没有

二、文章导读

语义分割在遥感影像处理中拥有非常大的潜力,但是目前最大的问题就是,遥感图像上的目标具有尺度不连续性。因此作者提出了一个SAM(scale-aware module)方法,在这个方法中,作者对像元进行重采样,使其适应于不同尺度的地表目标,并将作为权重图以引入空间注意力(spatial attention),下面来看一下文章的摘要部分:

High-resolution aerial images have a wide range of applications, such as military exploration, and urban planning. Semantic segmentation is a fundamental method extensively used in the analysis of high-resolution aerial images. However, the ground objects in high-resolution aerial images have the characteristics of inconsistent scale, and this feature usually leads to unexpected predictions. To tackle this issue, we propose a novel scale-aware module (SAM). In SAM, we employ resampling method aimed to make pixels adjust their positions to fit the ground objects with different scales, and it implicitly introduce spatial attention by employing re-sampling map as weighted map. As a result, the network with the proposed module named scale-aware network (SANet) has a stronger ability to distinguish the ground objects with inconsistent scale. Other than this, our proposed modules can easily embed in most of the existing network to improve their performance. We evaluate our modules on International Society for Photogrammetry and Remote Sensing Vaihingen Dataset, and the experimental results and comprehensive analysis demonstrate the effectiveness of our proposed module.

三、文章详细介绍

introduction部分其实没有太多内容,提了一下目前对于遥感图像的处理大多都是用的手动设置的特征,而这些特征很难直接用于大尺度的遥感区域调查。而深度学习则为此提供了新的思路。

对于前面提到的,目标的多尺度问题难以用单尺度特征处理,一般的解决思路就是结合多尺度信息。与传统的方法不同,作者提出了SAM,该方法能够端到端的训练,并且非常容易直接嵌入到现有模型中。SAM方法通过学习二维重采样图(通过输入数据和网络结构学习得到)来扩展采样空间,SAM不仅具有位置适应性(position-adaptive),还有数据适应性(data-adaptive)。最终,作者是将SAM引入到FCN网络中。

下面来看一下SANet的网络结构:

其中的Backbone是用于提取特征的。总的来说整个过程可以分成两步:

第一步是通过重采样卷积来学习重采样图(map),假设I为输入影像,高为H,宽为W,通道数为C,对I进行重采样卷积,可以得到一个重采样点集S,S的高为H,宽为W,通道数为2,分别是重采样的x和y坐标,然后再将S合并到重采样图(re-sampling map)当中,这里要强调的一点是,初始化重采样图的范围为[-1, 1],是通过映射像元坐标到特征图(左上角坐标为[-1, -1],右下角为[1, 1]);

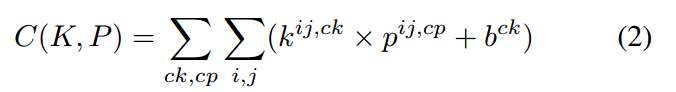

第二步就是基于重采样图的原始特征图进行像元重采样,采样方法采用了双线性内插(bilinear interpolation),假设核(kernal)函数K和图斑(patch)函数P,那么没有经过SAM转换的特征图可以表达为:

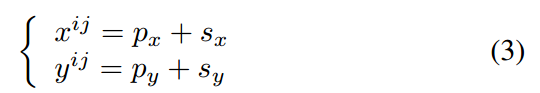

如果忽略上式中的偏置项(bias term),则特征图的像元坐标可以表达为:

式中,(Px,Py)是像元P初始位置的映射坐标(mapped coordinate),(Sx,Sy)是通过重采样卷积所学习到的重采样信息(也就是前面提到的重采样点集的两个通道)。当我们基于重采样图进行双线性内插以获得SAM变换的特征图时,转换的像元值就可以用下式来表示:

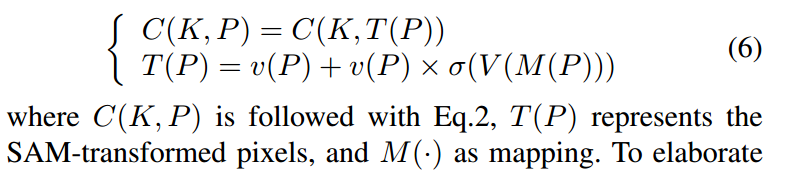

由重采样特征图转换到权重图是采用了sigmoid层和与原始特征图的点积。最终引入SAM变换的特征图的卷积可以表达为:

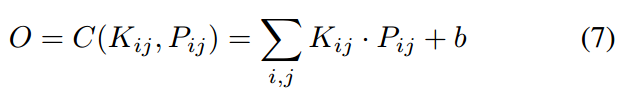

考虑到前面的核函数K和图斑函数P,可以将其标准化为:

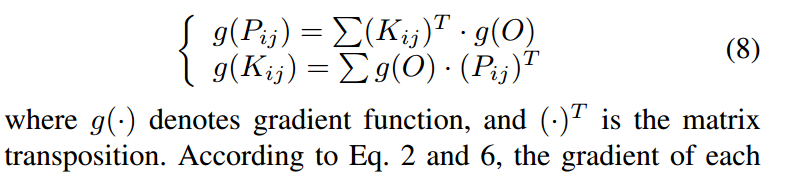

在后向传播过程中,如果给定了输出O的梯度,那么K和P的值的梯度则可以通过下式计算:

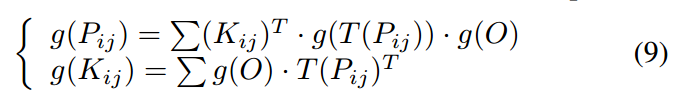

结合方程(2)和(6),在SAM转换的特征图的卷积操作中,每一个值的梯度可以表达为:

如果引入Z,则有:

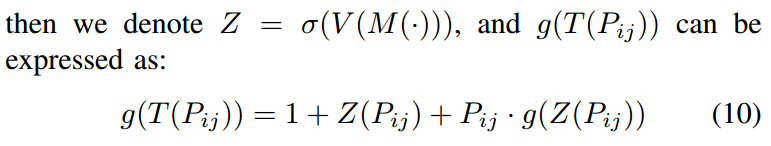

利用方程(5),我们对Z求偏导:

![]()

重采样像元P的坐标:

![]()

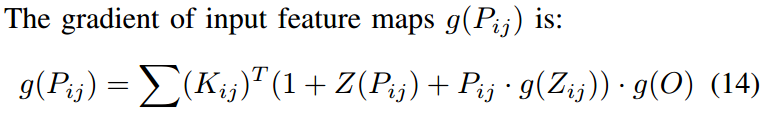

输入特征图的梯度:

以上就是尺度感知机制SAM的一些原理推导,下面来看看他的优点:

(1)trained end-to-end, optimized by stochastic gradient descent algorithms, and does not need any additional supervisions. (直接端到端训练,用随机梯度下降优化,不需要任何监督)

(2)the residual-block-like structure make gradient flow easily. (类似残差网络使得梯度容易下降)

(3)More importantly, SAM make networks have scale adaptive ability. (尺度感知机制SAM有尺度适应性)

关于第三点,作者给出的解释是传统的网络,比如DCNN,都是先训练参数,然后测试的时候再调整参数。但是在SAM机制中,重采样图并不是直接训练得到的,而是由输入数据和网络训练共同得到的。这里可以看一下Fig 2:

这里是输入的图做重采样卷积得到重采样图,然后再与输入图做点乘。

接下来就是作者的实验部分了,作者分别介绍了自己的数据集和实验参数,这里就不详细介绍了,直接放上作者的实验结果:

第一行是FCN的结果,第二行是引入SAM机制的FCN的结果。如果只看前两列,可以看出,没有SAM机制的话,一些比较小的建筑物是难以识别出的,看第三列,没有引入SAM机制的网络是难以识别长条形的建筑物,最后三列,当建筑物几乎占据整张图像时,FCN网络几乎支队建筑物边界的响应良好,对建筑物内部的响应较差。

以上就是文章的核心内容,当然SAM机制也完全可以用于其他的网络。

四、小结

1. 感觉作者提出的方法适合于具有尺度变化的目标,比如大小不一的建筑物。

2078

2078

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?