[1911.06750] Unsupervised Attributed Multiplex Network Embedding (arxiv.org)

目录

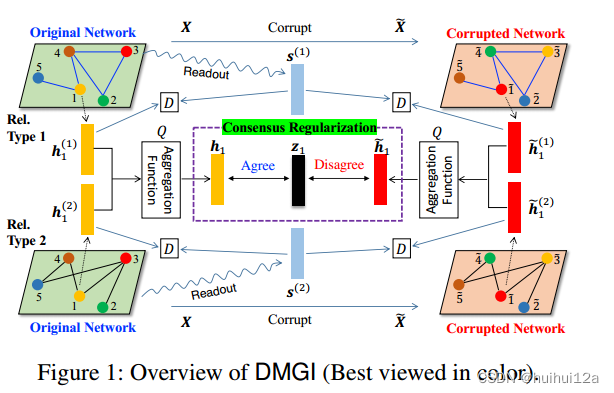

3 Deep Multiplex Graph Infomax: DMGI

Joint Modeling and Consensus Regularization

Extension to Semi-Supervised Learning

Abstract

多路网络中的节点通过多种类型的关系连接。然而,大多数现有的网络嵌入方法都假设节点之间只存在一种类型的关系。即使对于那些考虑网络多样性的人来说,他们也忽略了节点属性,依靠节点标签进行训练,并且无法对图的全局属性进行建模。

提出DMGI,该方法最大化了图局部补丁之间的互信息,以及整个图的全局表示。设计了一种系统的方法来联合集成来自多个图的节点嵌入,引入1)共识正则化框架,最小化特定关系类型节点嵌入之间的分歧,以及2)通用判别器,区分真实样本,而不考虑关系类型。注意机制推断每个关系类型的重要性,因此可以用于过滤不必要的关系类型作为预处理步骤。

1 Introduction

很多现有的图嵌入方法假设节点之间只有一种类型的关系,然而在现实事件中,节点间关系是多路的。

虽然不同类型的关系可以独立形成不同的图,但这些图是相互关联的,因此可以在各种下游任务中相互帮助。图中的节点可能包含属性信息,这在许多应用中起着重要作用。

首先,以前的方法专注于多图的集成,但忽略了节点属性。其次,即使对于那些考虑节点属性的人,他们需要节点标签进行训练。然而,由于节点标记通常既昂贵又耗时,如果一种方法在没有任何标记的情况下也能显示出具有竞争力的性能,那将是最好的。第三,这些方法中的大多数都无法对图的全局属性进行建模,因为它们是基于基于随机游动的skip-gram模型或图卷积网络(GCN) ,这两种方法都被认为是捕获局部图结构的有效方法。更准确地说,图中“接近”的节点(即在相同的上下文窗口或邻域内)被训练为具有相似的表示,而距离较远的节点即使在结构上相似也没有相似的表示。

考虑到上述限制,作者提出了一种简单而有效的无监督方法来嵌入属性复用网络。方法的核心构建块是Deep Graph Infomax (DGI) ,旨在学习一个节点编码器,该编码器可以最大化图的局部补丁之间的相互信息,以及整个图的全局表示。DGI是提出任务的主要方法,因为它:1)通过GCN自然集成节点属性;2)以完全无监督的方式训练;3)捕获整个图的全局属性;但是将为嵌入单一网络而设计的DGI应用于考虑多种关系类型之间的相互作用以及每种关系类型的重要性的多路网络是具有挑战性的。

因此,提出了一种系统的方法来联合整合来自多种类型节点之间关系的嵌入,从而使它们能够相互帮助,学习到对各种下游任务有用的高质量嵌入。更准确地说,作者引入了共识正则化框架,该框架最大限度地减少了关系类型特定节点嵌入之间的分歧,并引入了通用判别器,该判别器区分真实样本,无论关系类型如何,即基础真值“(图级总结,局部补丁)”对。此外,通过注意机制,可以推断出每个关系类型在生成共识节点嵌入中的重要性,这可以用于过滤不必要的关系类型作为预处理步骤。

2 DGI

DGI旨在学习每个节点的低维向量表示,使得图级(全局)汇总表示s与局部patch表示{h1; h2;… hn}之间的平均互信息(MI)最大。每个hi都被期望捕获整个图的全局属性.

尽管它很有效,但DGI是为单属性网络设计的,因此将其应用于多路网络并不直接。作为DGI在复用属性网络中的一种朴素扩展,我们可以将DGI独立应用于由每种关系类型组成的每个图,然后计算从每个图中获得的嵌入的平均值,从而得到最终的节点表示。然而,我们认为这不能模拟网络的多样性,因为来自不同关系类型的节点嵌入之间的相互作用没有被捕获。

3 Deep Multiplex Graph Infomax: DMGI

作者提出了一种无监督的方法,为带有属性的多路网络生成嵌入。作者先描述如何独立于建模属于每种关系类型的每个图,然后解释了如何联合集成它们以最终获得共识节点嵌入矩阵。

(1)先针对某种特定关系r的图G(r),生成G(r)中节点的特定关系类型的节点嵌入矩阵H(r),这个节点嵌入矩阵中每个节点嵌入h(r)i求平均得到图级的嵌入s(r),给定关系类型特定节点嵌入矩阵H(r)及其图级汇总表示s(r),计算关系类型特定交叉熵,使正例和s(r相似性大,负例和s(r)间相似性小,从而使节点嵌入矩阵捕获全局的图级信息;

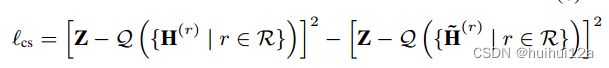

(2)然后为了综合不同关系r下H(r)的交互。引入共识嵌入矩阵 ,每个特定关系类型的节点嵌入矩阵H(r)都可以在其上达成一致。引入了共识正则化框架:1)一个正则化器最小化原始节点嵌入集{H(r)|

}与共识嵌入Z之间的不一致;2)另一个正则化器最大化损坏节点

和共识嵌入节点Z之间的不一致。因此获得最终的共识嵌入矩阵,即时节点的最终嵌入矩阵。

特定关系类型的节点嵌入

对于每个关系类型,引入一个特定于关系类型的节点编码器gr:生成G(r)中节点的特定关系类型的节点嵌入矩阵H(r),为n×d维的。encoder是单层的GCN:

和传统的GCN不同的是,为自环引入一个权重w,w越大,表示该节点本身在生成其嵌入中起着更重要的作用,这反过来又降低了其相邻节点的重要性。

计算图级的总结表示s(r),它总结了图G (r)的全局内容:

h(r)i表示矩阵H(r)的第i行向量.

给定关系类型特定节点嵌入矩阵H(r)及其图级汇总表示s(r),计算关系类型特定交叉熵,从而使节点嵌入矩阵捕获全局的图级信息:

为了生成负节点嵌入,逐行方式对原始属性矩阵进行交换的方式,然后再对属性重新使用encoder gr.其中,对于每个关系r,M矩阵都是相同的,目的是学习通用判别器,无论关系类型如何,都能够将真对评分高于负对。

Joint Modeling and Consensus Regularization

通过上一步骤,得到了关系类型特定的节点嵌入矩阵阵H(r),它捕获了G (r)中的全局信息。然而,由于每个阵H(r)是针对每个r独立训练的,这些嵌入矩阵只包含关于每种关系类型的相关信息,因此无法利用网络的关系多重性,使用它们的交互.

因此作者引入共识嵌入矩阵 ,每个特定关系类型的节点嵌入矩阵H(r)都可以在其上达成一致。引入了共识正则化框架:1)一个正则化器最小化原始节点嵌入集{H(r)|

}与共识嵌入Z之间的不一致;2)另一个正则化器最大化损坏节点

和共识嵌入节点Z之间的不一致。

其中Q是一个聚合函数,它将来自多种关系类型的一组节点嵌入矩阵组合为单个嵌入矩阵,,为了简单起见,Q为平均池化,当然也可以引入注意力机制,为不同关系分配不同权重,表示这种类型关系的重要性。

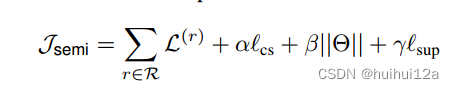

Extension to Semi-Supervised Learning

如果有些节点有标签,还可以引入半监督学习,对这些有标签的节点单独计算下面的交叉熵损失:

最终损失函数变为

2439

2439

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?