近期,一项刚刚发布的最新研究表明,一种名为计算随机存取存储器(Computational Random-Access Memory, CRAM)的新技术能够极大地减少人工智能(AI)处理所需的能量消耗。这项技术由明尼苏达大学双城分校的一组工程研究人员开发,并已发表在《npj非传统计算》期刊上,该期刊是由Nature出版的同行评审期刊。

随着人工智能(AI)和大数据时代的到来,传统的计算范式正面临着前所未有的挑战。特别是在数据密集型应用中,数据在内存和处理器之间频繁传输所消耗的能量和时间成为瓶颈。为了解决这个问题,一种新的计算模式——计算随机存取存储器(Computational Random-Access Memory, CRAM)应运而生。

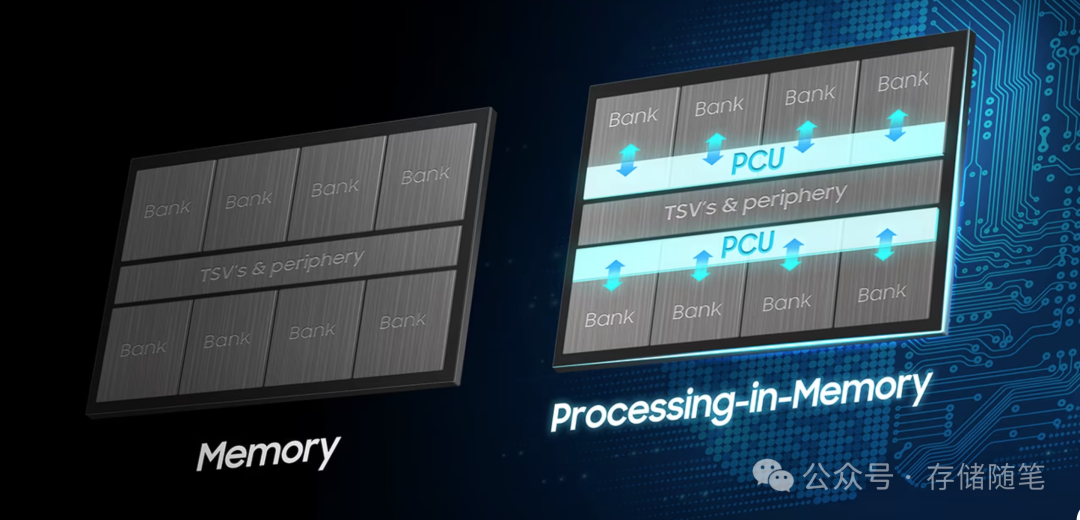

为了应对这一挑战,研究人员转向了CRAM技术。CRAM是一种将计算能力直接嵌入到内存单元中的技术,与现有的内存内处理(Processing-In-Memory, PIM)解决方案不同,后者仅是在内存核心内部放置一个处理计算单元(PCU),而数据仍然需要在内存单元和PCU之间移动,只是距离较短。在CRAM中,数据无需离开内存,而是在内存阵列内部进行处理。这使得运行AI计算应用的系统能够实现高达1000倍的能效提升。

扩展阅读:万物皆可计算|下一个风口:近内存计算

CRAM技术采用了高密度、可重构的自旋电子(spintronic)计算基底,直接嵌入到内存单元中。与三星的PIM技术相比,CRAM技术使数据无需离开内存即可进行处理,消除了数据在内存单元与处理单元之间的长距离传输。CRAM通过消除数据在内存和处理单元之间的移动,显著降低了能耗。此外,由于CRAM的计算直接发生在内存中,它还提供了更好的随机访问能力、可重构性以及大规模并行处理能力。

CRAM的工作原理主要基于磁隧道结(Magnetic Tunnel Junction, MTJ)技术,这是一种利用磁性材料实现存储的新兴技术。MTJ是一种利用磁性层之间的量子隧穿效应来实现存储的器件。在CRAM中,MTJ不仅仅用于存储数据,还被用来执行计算任务。通过精确控制MTJ的状态,可以实现诸如AND、OR、NAND、NOR和多数逻辑运算等基本逻辑操作。这些操作可以在内存单元内部直接完成,而不需要数据离开内存。

这项工作首次在实验中证明了CRAM的可行性,并为评估其计算准确性提供了实证依据。

-

基本操作验证:研究人员首先验证了基本的内存操作,随后展示了2输入、3输入和5输入逻辑门的操作。这些实验结果显示CRAM能够准确执行简单的逻辑运算。

-

1位全加器的设计与演示:接着,研究人员展示了两种不同的1位全加器设计,并进行了实验验证。这些全加器的设计对于构建更复杂的算术逻辑单元至关重要。

-

误差率分析:基于实验结果,研究团队开发了一系列模型来表征CRAM计算的准确性。这些模型考虑了MTJ的隧穿磁阻比(TMR)、逻辑操作脉冲宽度等因素对误差率的影响。

-

功能电路模拟与分析:最后,研究人员基于实验验证的结果,对更大规模的功能电路进行了模拟和分析,包括标量加法、乘法以及矩阵乘法,这些是许多传统和机器智能应用中的核心构建块。

CRAM技术展现了巨大的潜力,尤其是在机器学习、生物信息学、图像处理、信号处理、神经网络和边缘计算等领域。例如,一项基于CRAM的机器学习推理加速器的研究表明,它在能量延迟乘积方面的性能比现有技术提高了大约1000倍。此外,CRAM在执行MNIST手写数字分类任务时,能耗和时间分别降低了2500倍和1700倍。

CRAM技术展现出巨大的潜力,但其真实计算能力的局限在于连续CRAM数组内部。任何需要跨越不同CRAM数组的数据访问和计算都会增加额外的数据移动开销。

尽管CRAM技术目前仍处于早期阶段,但其实验验证和模拟结果显示出良好的准确性和性能。随着MTJ技术的进步和新切换机制的发展,CRAM的门级错误率有望进一步降低。此外,错误校正技术的应用也将有助于抑制CRAM中的误差。这些进展将使得CRAM成为下一代计算技术的重要组成部分,为未来的高性能计算和人工智能应用提供强大的支持。

综上所述,CRAM技术不仅在理论上提供了新的计算方式,而且在实验中也证明了其可行性和实用性。随着技术的不断成熟和完善,CRAM有望在未来成为计算领域的一项关键技术。CRAM技术为AI计算带来了一种全新的方法,有望通过减少数据传输所需的能量消耗来极大提升AI系统的能效。

如果您看完有所受益,欢迎点击文章底部左下角“关注”并点击“分享”、“在看”,非常感谢!

精彩推荐:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?