UNetFormer是用于遥感语义分割任务中的一个算法,是一个类似UNet的transformer结构的算法,他是基于CNN为编码器和基于Transformer为解码器组成的混合架构,其整体结构主要为:

左边是编码器部分,使用的是ResNet18作为编码器,由4个部分组成。每个阶段对输入的图片进行下采样操作,比例因子为2。每个阶段生成的特征映射会和解码器的相应特征映射并进行跳跃连接,即进行1*1的卷积,通道维度为64。其中的具体操作就是进行加权和运算,将ResBlock产生的语义特征和解码器的GLTB产生的特征融合起来。其运算是基于这两个特征对于分割精度的贡献来选择性加权这两个特征。具体加权公式为:

FF为融合特征,RF为ResBlock产生的特征,GLF是GLTB产生的特征。

右边的是解码器部分,使用的是三个global-local Transformer blocks(全局-局部Transformer块),即GLTB和一个feature refinement head(FRH)来构建的一个基于Transformer的轻量的解码器。

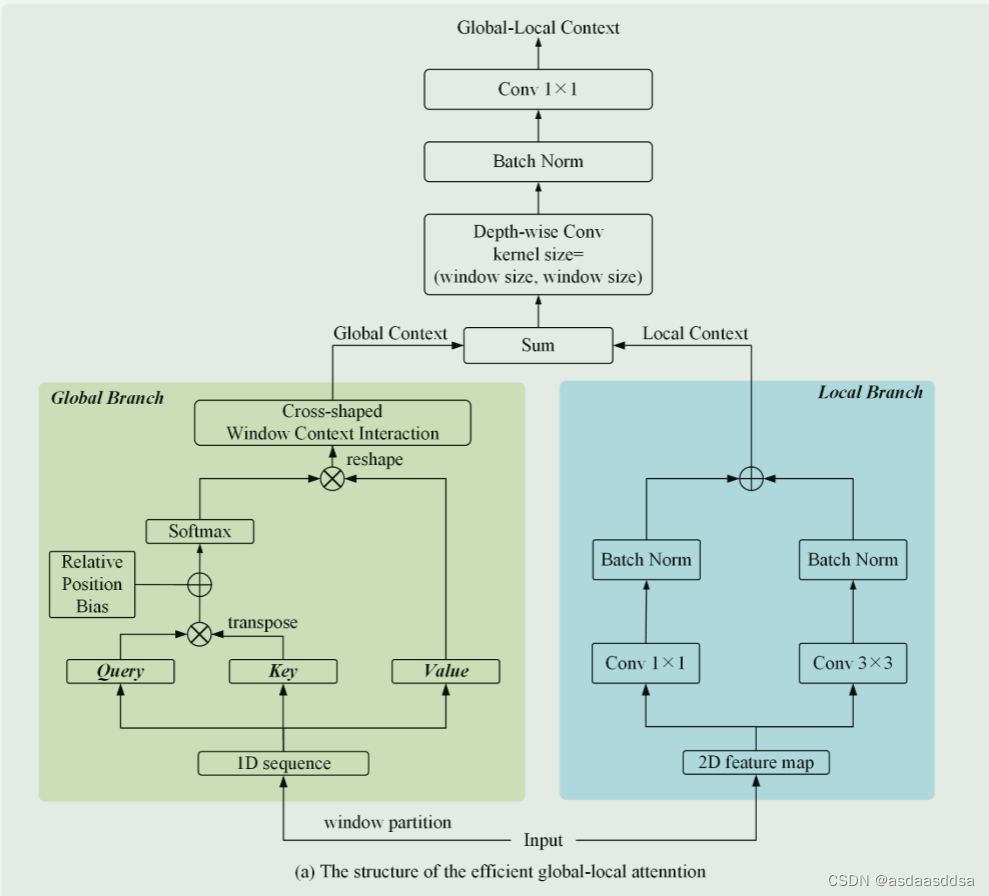

Global-Local Transformer blocks(GLTB)的结构图如下:

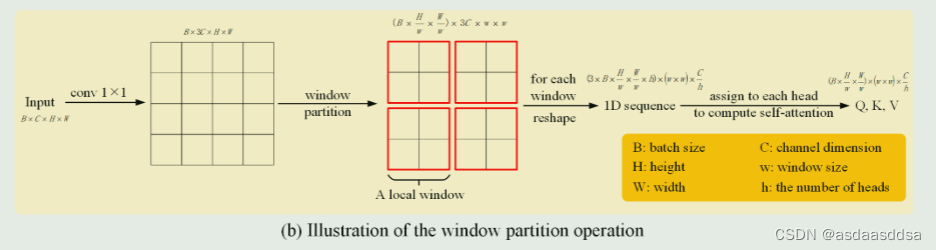

GLTB构造了两个并行的分支来提取全局信息和局部信息,局部分支采用核大小为1和3的两个相互平行的卷积层来提取局部信息,接在在进行求和前进行两个批处理归一化操作。全局分支依靠窗口的多头自注意力机制来捕捉全局上下文。先使用标准的1*1卷积把输入的图片扩展三倍,然后采用窗口划分操作将一维序列拆分为Query(q),Key(K)和Value(V)三个向量,然后将C设为64,w和h都设为8,如下图。

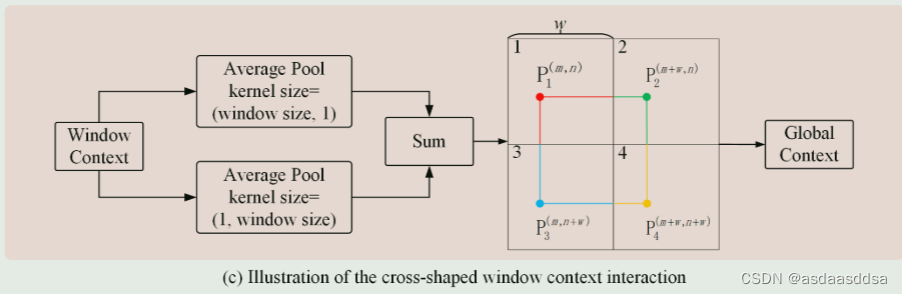

之后使用十字形窗口上下文交互模块来捕捉跨窗口关系,该模块水平平均池化池和垂直平均池化层产生的两个特征图,从而捕获全局上下文,如下图。

之后将全局上下文和局部上下文聚合,产生全局-局部上下文。最后进行深度卷积、批归一化操作和标准的1*1卷积来表示细粒度的全局-局部上下文。

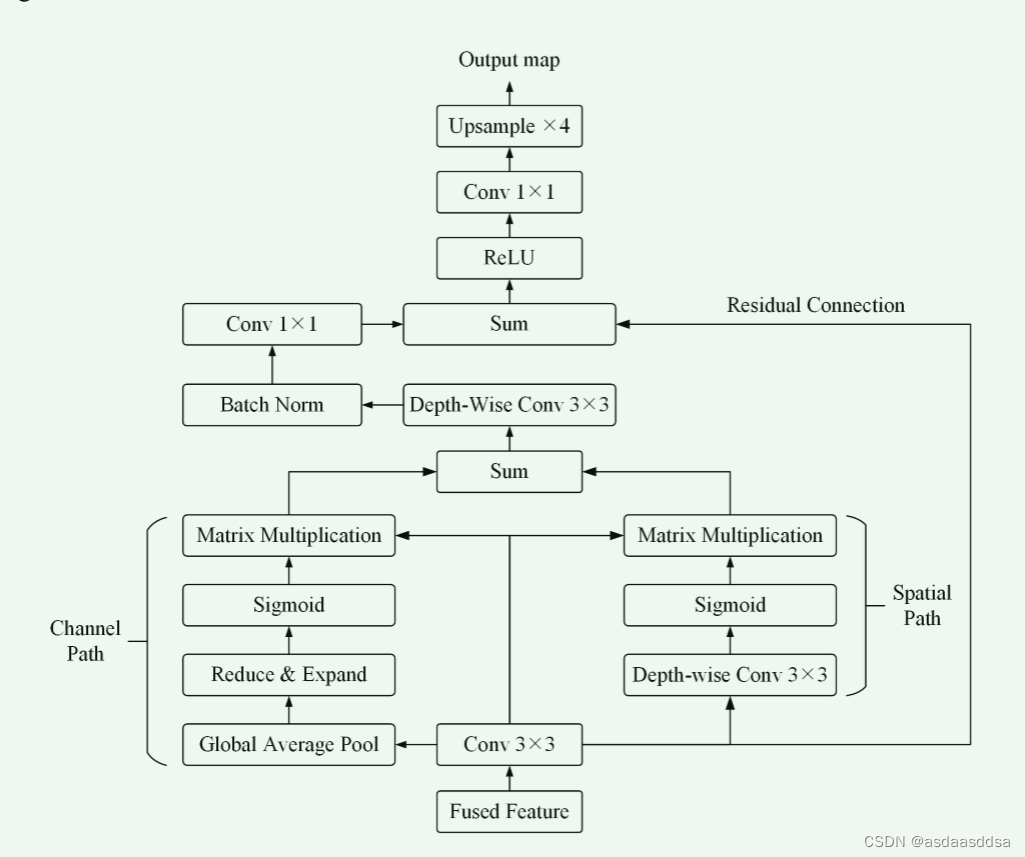

Feature refinement head (FRH)的结构图如下:

第一层的ResBlock产生的浅层特征保留了丰富的细节信息,但是缺乏语义内容;深层特征提供了精确的语义信息但是空间分辨率低。在UNetFormer里面,使用了FRH来解决这个问题。选择融合特征作为FRH的输入,然后构造了两条分支来分别加强空间和通道方向的特征表示。通道方向使用一个全局平均池化层生成一个通道注意映射,缩减和扩展操作包含两个1*1的卷积层,先将信道维度减少4倍,在将其扩展为原始的;空间方向使用深度卷积来产生空间注意图。之后在进行求和运算融合两条路径产生的注意特征,最后采用后处理的1*1卷积以及上采样操作产生最后的分割效果图。

558

558

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?