本文是Deep Learning 之 最优化方法系列文章的AdaGrad方法。主要参考Deep Learning 一书。

整个优化系列文章列表:

Deep Learning 最优化方法之Momentum(动量)

先上结论:

1.简单来讲,设置全局学习率之后,每次通过,全局学习率逐参数的除以历史梯度平方和的平方根,使得每个参数的学习率不同

2.效果是:在参数空间更为平缓的方向,会取得更大的进步(因为平缓,所以历史梯度平方和较小,对应学习下降的幅度较小)

3.缺点是,使得学习率过早,过量的减少

4.在某些模型上效果不错。

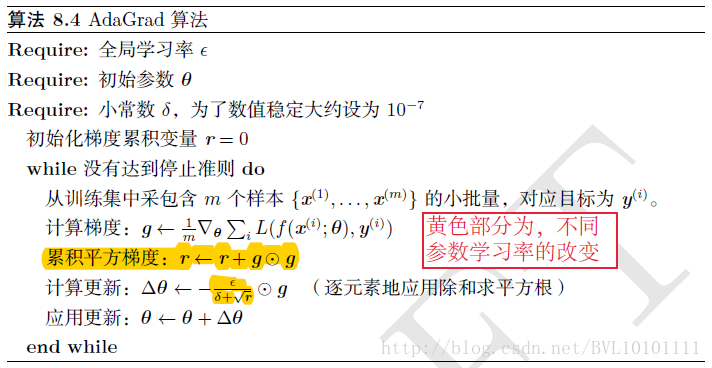

具体见算法:

本文介绍了AdaGrad优化方法,该方法通过将全局学习率按每个参数的历史梯度平方和的平方根进行调整,实现了参数级的学习率自适应调整。这种方法在参数空间中较为平缓的方向上能取得更大的进步,但可能会导致学习率过早减少。

本文介绍了AdaGrad优化方法,该方法通过将全局学习率按每个参数的历史梯度平方和的平方根进行调整,实现了参数级的学习率自适应调整。这种方法在参数空间中较为平缓的方向上能取得更大的进步,但可能会导致学习率过早减少。

4539

4539

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?