1. 牛顿法

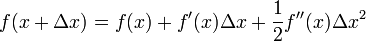

假设任务是优化一个目标函数f,求函 数f的极大极小问题,可以转化为求解函数f的导数f'=0的问题,这样求可以把优化问题看成方程求解问题(f'=0)。为了求解f'=0的根,把f(x)的泰勒展开,展开到2阶形式:

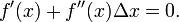

这个式子是成立的,当且仅当 Δx 无线趋近于0。此时上式等价与:

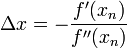

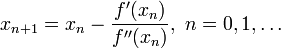

求解:

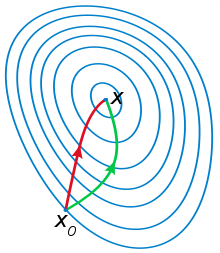

一般认为牛顿法可以利用到曲线本身的信息,比梯度下降法更容易收敛(迭代更少次数),如下图是一个最小化一个目标方程的例子,红色曲线是利用牛顿法迭代求解,绿色曲线是利用梯度下降法求解。

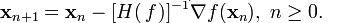

在上面讨论的是2维情况,高维情况的牛顿迭代公式是:

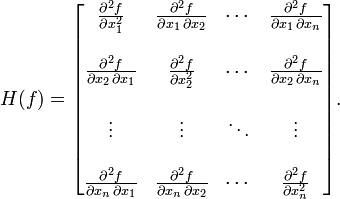

其中H是Hessian矩阵,定义为:

<

本文介绍了机器学习中的优化算法,重点讲解了牛顿法及其局限性,如要求初始点靠近极小点,计算二阶偏导数的难度以及Hessian矩阵正定的问题。接着探讨了拟牛顿法,特别是BFGS算法和L-BFGS算法,作为牛顿法的改进,它们在不需要实际计算Hessian矩阵的情况下提供更优的搜索方向。最后,对比了牛顿法与梯度下降法,解释了牛顿法因二阶收敛性而更快的原因。

本文介绍了机器学习中的优化算法,重点讲解了牛顿法及其局限性,如要求初始点靠近极小点,计算二阶偏导数的难度以及Hessian矩阵正定的问题。接着探讨了拟牛顿法,特别是BFGS算法和L-BFGS算法,作为牛顿法的改进,它们在不需要实际计算Hessian矩阵的情况下提供更优的搜索方向。最后,对比了牛顿法与梯度下降法,解释了牛顿法因二阶收敛性而更快的原因。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4471

4471

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?