一、前言

写这篇文时,突然想到一个问题,大家的词库都是从哪来的?

之所以会这么有些意外的问,是因为从没把词库当成个事儿:平时处理微博,就用程序跑一下微博语料获得微博词库;处理新闻,程序跑一下新闻语料获得新闻词库。甚至没有把跑出来的词库存下来的习惯,谁知道过两天是不是又出什么新词,与其用可能过时的,不如随手生成个新鲜出炉的。

好吧,我承认我这是在显摆。如果你也想和我一样,想要随用随丢,任性它一把,那随我来。

如果你只想要这样一个程序,可以直奔这里下载。

如果你想亲手写一个,那也没什么,百来行代码的事儿。

好,咱们言归正传。

二、词库生成

1、算法分析,先来考虑以下几个问题

问:目标是从文本中抽取词语,是否可以考虑使用遗忘的方法呢?

答:可以,词语具备以相对稳定周期重复再现的特征,所以可以考虑使用遗忘的方法。这意味着,我们只需要找一种适当的方法,将句子划分成若干子串,这些子串即为“候选词”。在遗忘的作用下,如果“候选词”会周期性重现,那么它就会被保留在词库中,相反如果只是偶尔或随机出现,则会逐渐被遗忘掉。

问:那用什么方法来把句子划分成子串比较合适呢?

答:考察句中任意相邻的两个字,相邻两字有两种可能:要么同属于一个共同的词,要么是两个词的边界。我们都会有这样一种感觉,属于同一个词的相邻两字的“关系”肯定比属于不同词的相邻两字的“关系”要强烈一些。

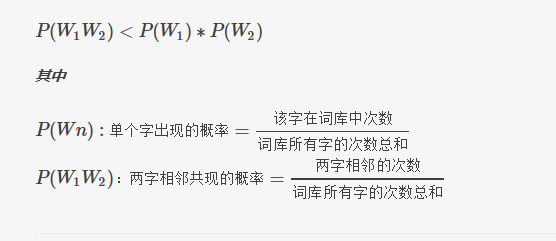

数学中并不缺少刻划“关系”的模型,这里我们选择公式简单并且参数容易统计的一种:如果两个字共现的概率大于它们随机排列在一起的概率,那么我们认为这两个字有关,反之则无关。

如果相邻两字无关,就可以将两字中间断开。逐字扫描句子,如果相邻两字满足下面的公式,则将两字断开,如此可将句子切成若干子串,从而获得“候选词”集,判断公式如下图所示:

公式中所需的参数可以通过统计获得:遍历一次语料,即可获得公式中所需的“单字的频数”、“相邻两字共现的频数”,以及“所有单字的频数总和”。

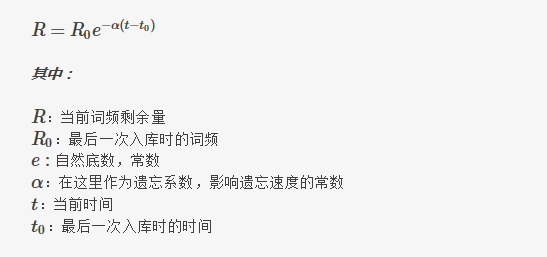

问:如何计算遗忘剩余量?

答:使用牛顿冷却公式,各参数在遗忘算法中的含义,如下图所示:

牛顿冷却公式的详情说明,可以参考阮一峰老师的博文《基于用户投票的排名算法(四):牛顿冷却定律》。

问:参数中时间是用现实时间吗,遗忘系数取多少合适呢?

答:a、关于时间:

可以使用现实时间,遗忘的发生与现实同步。

也可以考虑用处理语料中对象的数量来代替,这样仅当有数据处理时,才会

本文介绍了如何使用遗忘算法进行大规模语料词库的生成。通过分析句子,利用相邻字的关系和牛顿冷却公式计算遗忘剩余量,实现无监督学习的词库构建。算法具有O(N)时间复杂度,适用于流式数据处理,且能适应领域变化。

本文介绍了如何使用遗忘算法进行大规模语料词库的生成。通过分析句子,利用相邻字的关系和牛顿冷却公式计算遗忘剩余量,实现无监督学习的词库构建。算法具有O(N)时间复杂度,适用于流式数据处理,且能适应领域变化。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3029

3029

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?