Andrew NG 《machine learning》week 5,class1 —Cost functions and Backpropagation

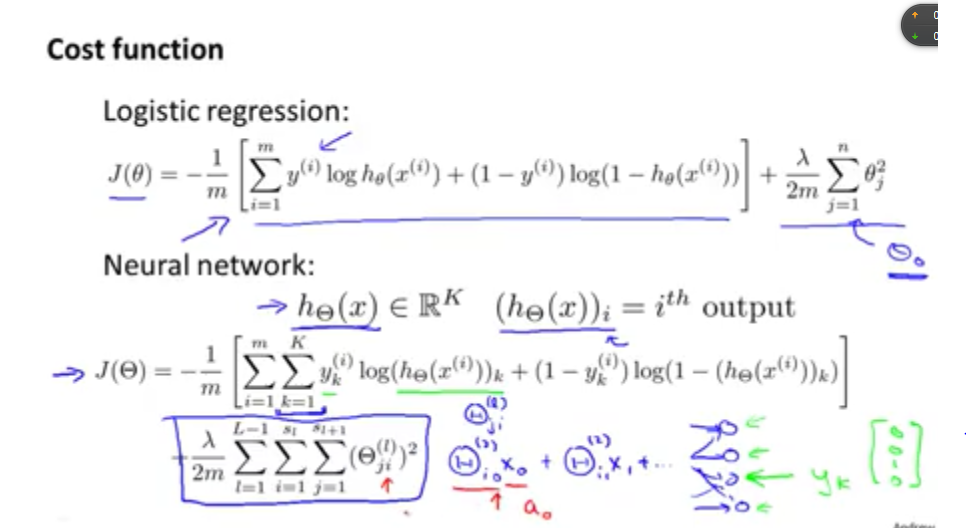

1.1 cost function

如下图所示,本小节主要讲述了神经网络的代价函数的表达式。

与其它算法不同的是:神经网络的输出是一个实数。

接下来就要讲解神经网络的参数求解算法。

1.2 Backpropagation Algorithm

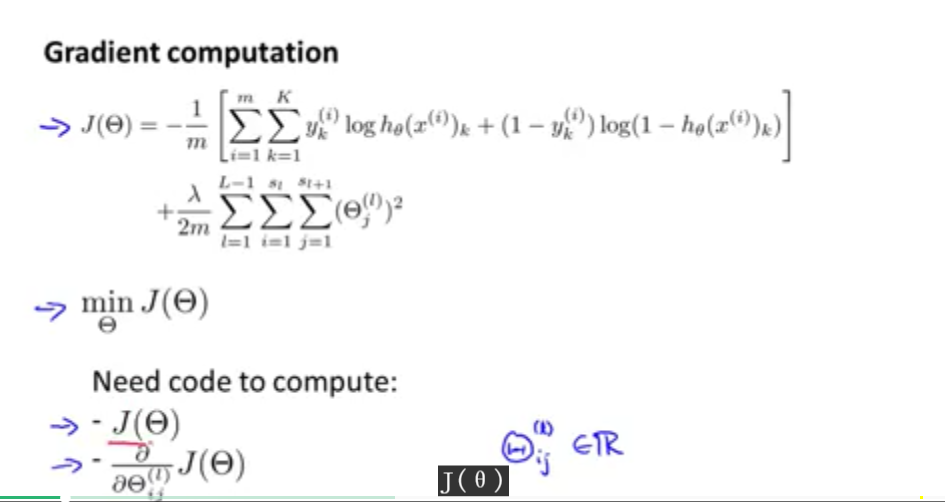

同其他的算法一样,我们需要求解神经网络算法中的参数,具体可以用梯度下降、正则化等方法求解。

如上图所示,需要通过最小化代价函数来求得参数threa。要求解代价函数的最小值,主要是需要编码计算上图所示的偏导和代价函数。

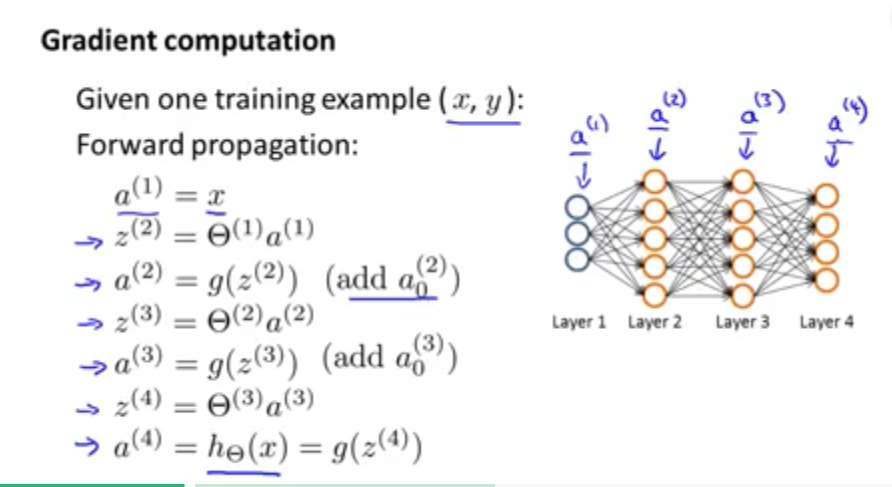

为了求解最小代价函数以及偏导数,先从一个训练集开始。如下图所示,只有一个训练数据集(x,y).下图展示的神经网络算法的前向传播的思想。

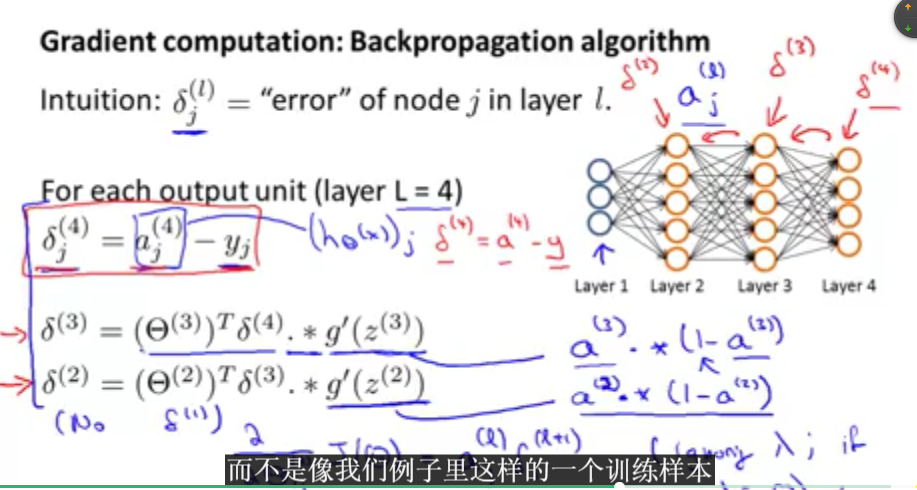

下面为了计算导数项,将采用反向传播的算法。如下图所示,反向传播的算法思想就是先得出最终的误差,然后不断的反向传递到前面的网络结构,从而计算出导数值。

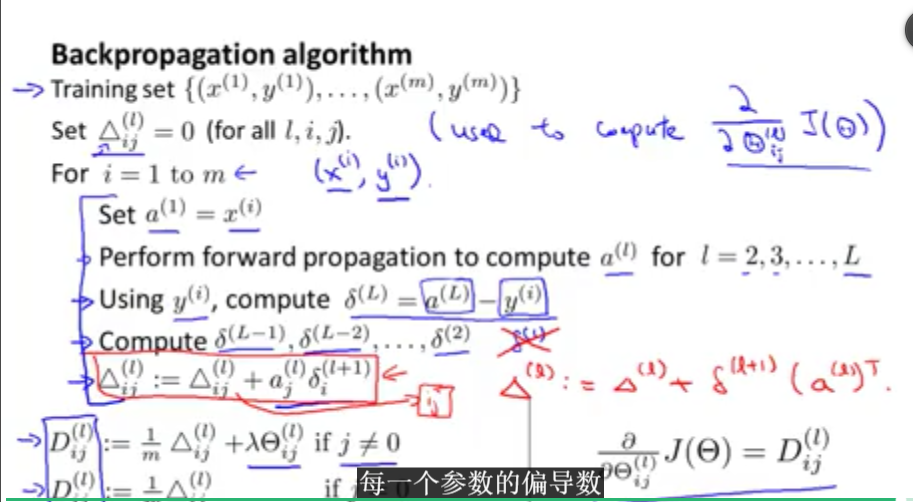

反向传播函数算法如下图所示:(可以去掉下标,表示成向量形式)

反向传播算法可以用来计算代价函数以及偏导数。接下来将做一些详细的说明和总体的总结。

1.3 Backpropagation Intuition

本小节主要是详细讲解反向传播算法的应用。

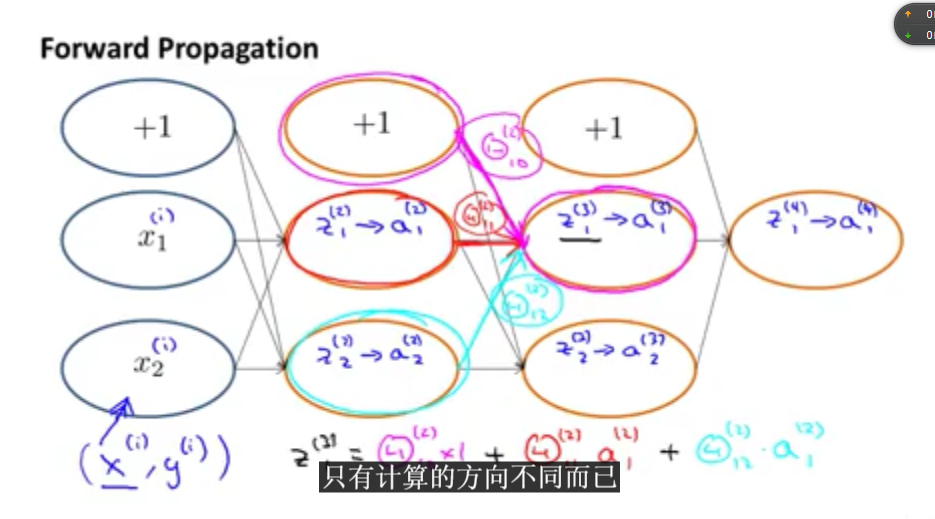

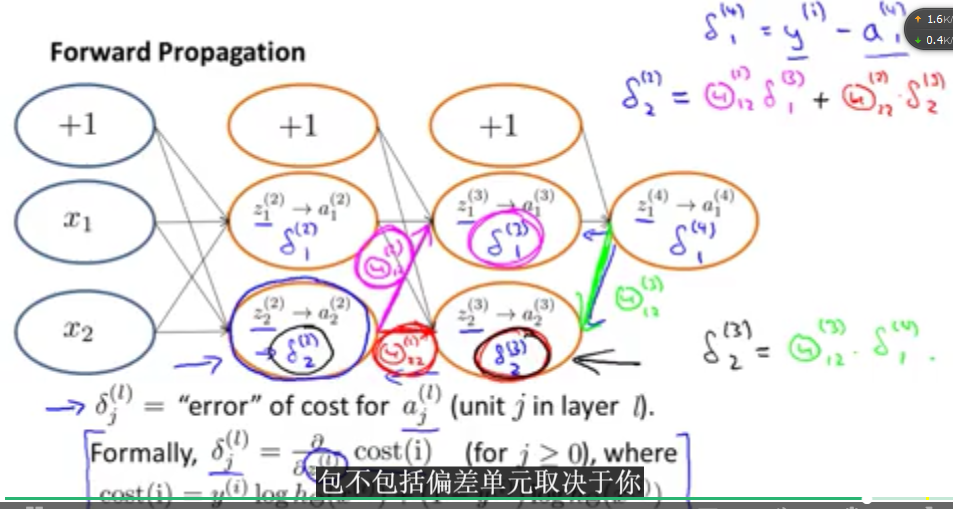

下图先是详细讲解了正向传播的思想、表达式之类的。反向传播的算法思想只需要反过来就可以啦。

下图是反向传播的算法思想:

图中所展示的均是算法的一部分表达式,接下来的课程将会将其合并起来。

3190

3190

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?