本文主要对最基本的 ELM 算法做一个简要介绍。

作者: peghoty

出处: http://blog.csdn.net/peghoty/article/details/9277721

欢迎转载/分享, 但请务必声明文章出处.

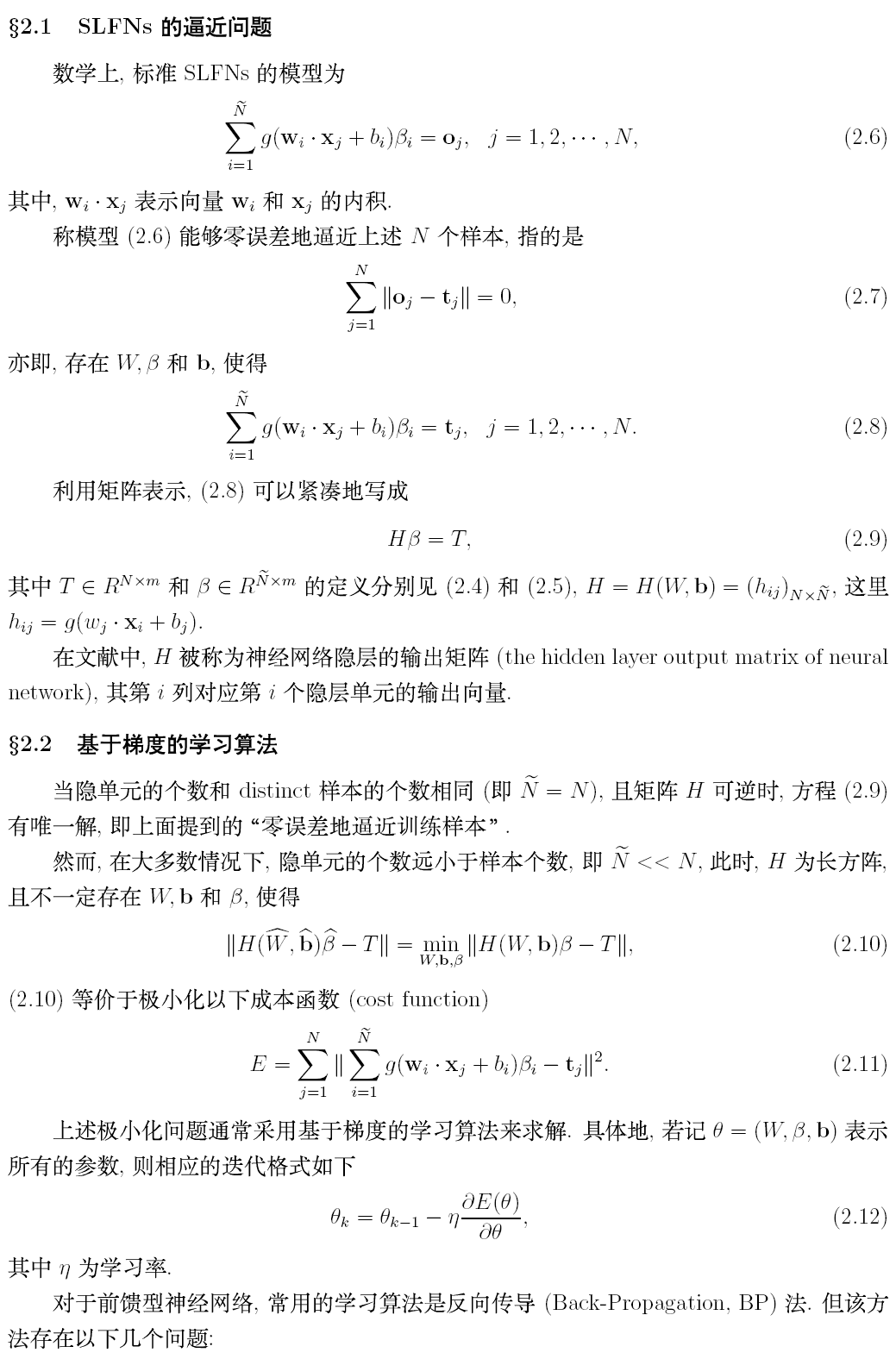

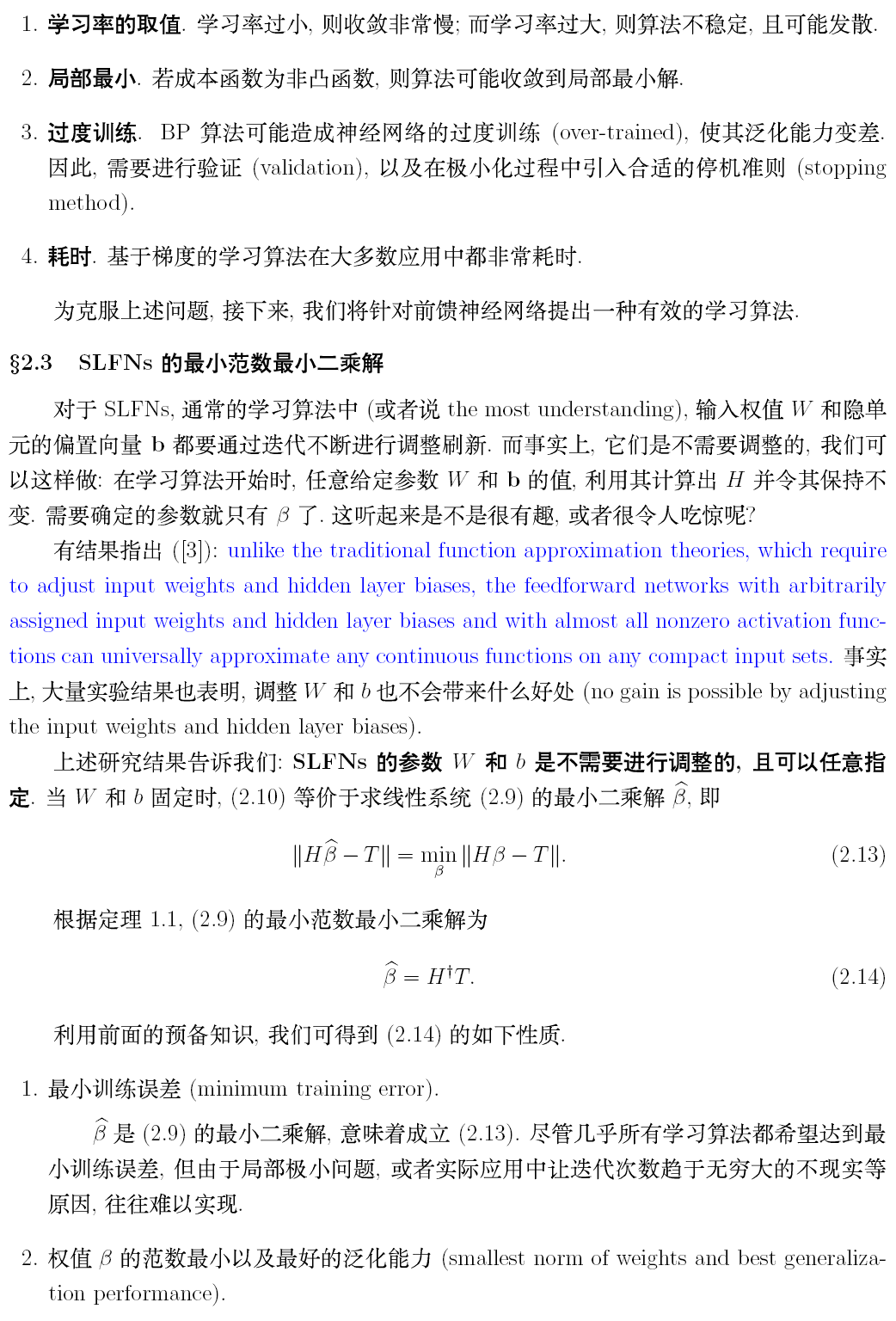

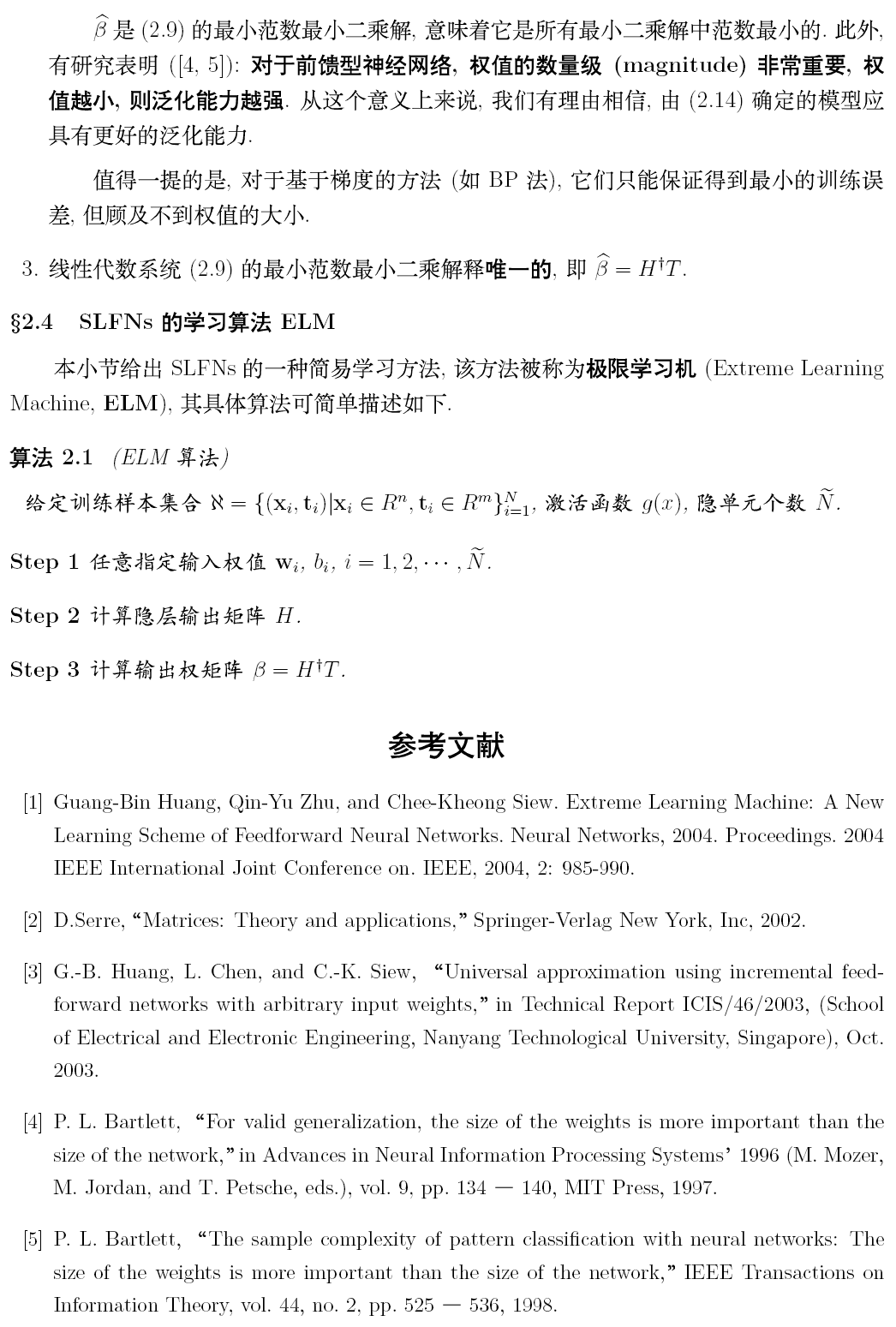

本文介绍了由黄广斌教授提出的极限学习机(ELM)算法,这是一种针对单隐藏层前馈型神经网络的监督学习算法。ELM算法通过直接求解最小范数最小二乘问题,实现快速训练,具有训练参数少、速度快的优点。

本文介绍了由黄广斌教授提出的极限学习机(ELM)算法,这是一种针对单隐藏层前馈型神经网络的监督学习算法。ELM算法通过直接求解最小范数最小二乘问题,实现快速训练,具有训练参数少、速度快的优点。

12万+

12万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?