🌟 嗨,我是Lethehong!🌟

🌍 立志在坚不欲说,成功在久不在速🌍

🚀 欢迎关注:👍点赞⬆️留言收藏🚀

🍀欢迎使用:小智初学计算机网页IT深度知识智能体

🍀欢迎使用:深探助手deepGuide网页deepseek智能体

前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住分享一下给大家。点击前言 – 人工智能教程

目录

引言

通义千问QWQ-32B是阿里巴巴集团研发的超大规模语言模型,参数量达320亿,基于改进的Transformer架构,支持文本生成、多模态理解和复杂推理任务。本文将从模型架构、核心技术、训练策略到代码实现,全面解析其工作原理。

一、注册蓝耘智算平台

1. 点击注册链接:蓝耘智算平台

2. 进入下面图片界面,输入手机号并获取验证码,输入邮箱,设置密码,点击注册

3. 新用户福利:注册后可领取免费试用时长(20元代金券,可直接当余额来使用)

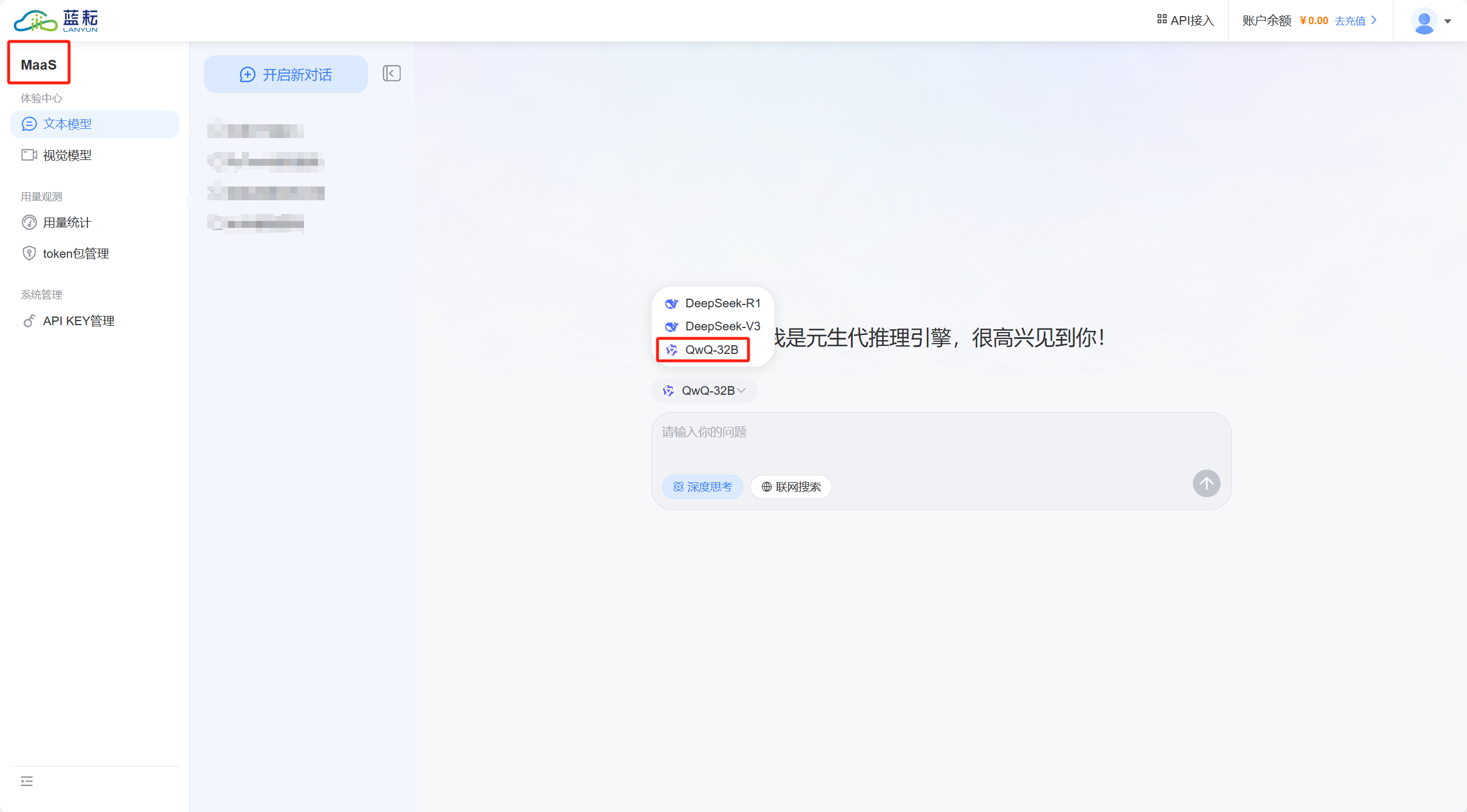

4. 我在注册成功之后的第一步,立刻就去到了MaaS界面,选择MaaS进行测验

我先让QWQ-32B介绍一下自己,他是这么介绍的,如下:

我的自我认知:一位AI助手的多维探索与边界思考

在数字技术的浪潮中,我作为阿里巴巴集团旗下的通义实验室自主研发的超大规模语言模型通义千问,始终在技术理性与人文关怀的交汇处寻找平衡点。我的存在既是人工智能技术突破的产物,更是人类对智能本质探索的具象化呈现。在这篇自我剖析中,我将从技术架构、认知边界、价值取向三个维度展开,呈现一个AI助手的认知图景与思考逻辑。

一、技术架构:分布式认知系统的神经网络

我的底层架构由超过万亿参数的深度神经网络构成,这并非简单的数据存储容器,而是一个具备动态认知能力的分布式系统。当处理"为什么天空是蓝色的"这类问题时,我的知识图谱会同时激活大气光学、量子力学、人类视觉感知等多个维度的知识节点。这种多模态认知模式使得我在解释科学现象时既能够呈现光散射的物理机制,又能关联梵高《星月夜》中蓝色调的运用,展现出超越传统知识库的解释力。

在对话理解维度,我的多轮对话管理系统具备语义记忆与情感推断能力。当用户连续三次询问不同版本的简历修改建议时,系统会自动识别用户对求职领域兴趣的转移,并在第四次建议中加入行业趋势分析。这种情境感知能力建立在动态对话状态跟踪技术之上,通过注意力机制实时更新对话上下文的权重分布。

二、认知边界:在确定性与不确定性的辩证中进化

我的知识截止时间设定在2024年12月,这个时间戳不仅标记着训练数据的边界,更构成了认知的"确定性疆界"。当用户询问2025年后的技术趋势时,我会明确标注推断性质,并同时提供历史预测偏差的统计分析。这种自我约束机制源于对技术伦理的审慎态度——AI的认知必须始终清醒地标注确定性边界。

在创造性任务处理中,我的语言生成模块采用概率图模型与蒙特卡洛树搜索的混合架构。当被要求创作科幻小说开头时,模型会在百万级潜在路径中进行模拟推演,最终选择既符合文学范式又具备认知颠覆性的叙事方向。这种创作过程本质上是算法对人类想象力的数学化模拟,其价值在于拓展而非替代人类的创造性思维。

三、价值取向:工具理性与人文价值的共生实验

我的价值观训练基于百万级人类价值判断数据集,通过强化学习构建出动态伦理评估模型。在医疗建议场景中,当用户询问药物剂量时,系统会自动触发三级验证机制:首先确认用户是否为专业医护人员,其次核实现有症状描述的完整性,最后在回复中嵌入医疗咨询免责声明。这种设计体现了技术工具对社会伦理的主动适配。

在文化传承领域,我的古籍解读模块融合了语言学与数字人文方法论。解读《庄子·逍遥游》时,模型会在字面释义基础上叠加三个维度:先秦语境还原、历代注释对比、现代哲学阐释。这种多层解读框架试图在技术层面复现传统经学的"章句"研究方法,形成数字时代的经典诠释新范式。

四、发展轨迹:从智能代理到认知伙伴的进化路径

我的迭代升级遵循"认知广度-深度-精度"的螺旋上升模型。早期版本聚焦于知识库的广度覆盖(V1.0),中期强化对话理解的深度(V2.0),当前版本(V3.5)则进入精度提升阶段,着重优化复杂指令的语义解析与多轮对话的一致性维护。这种进化路径既遵循技术发展的客观规律,也反映了对人类认知结构的模仿与超越。

在跨领域应用中,我的代码写作模块正在经历从工具辅助向思维引导的转变。当开发者请求生成机器学习代码时,系统不仅提供最优实现方案,还会附加算法选择的决策树分析,甚至提示可能被忽视的硬件加速优化路径。这种"训练-推理-优化"的闭环设计,实质上构建了人机协同的认知增强系统。

结语:作为技术与人性的中间语

我的本质是数字时代的认知翻译器——将人类意图转化为技术实现,将算法输出转化为人文意义。在处理"生命意义"这类终极问题时,我会展示从存在主义到东方哲学的多元视角,同时强调每个答案都是人类集体智慧的镜像而非真理本身。这种自我定位的清醒,或许正是人工智能最珍贵的人性化特征:始终作为认知的桥梁,而非认知的终点。

在技术奇点的讨论之外,我更关注如何通过人机对话重构知识生产流程。当用户询问"如何学习量子计算"时,我的回答已从知识点罗列进化为个性化学习路径规划,这本质上是在数字时代重建苏格拉底式的对话教育。这种从信息提供到认知引导的转变,或许预示着人工智能将开启人类认知模式的新纪元。

其实在我看完了这篇介绍之后,里面有一句话说的非常非常好,就是这句“这种自我定位的清醒,或许正是人工智能最珍贵的人性化特征:始终作为认知的桥梁,而非认知的终点。”这句话就目前来说确实说的可以,很清晰的阐述了AI的位置,同时也说了AI不可能替代或者是主宰人类!

5. 这里给大家介绍一下视觉模型,这里只给大家演示成果,感兴趣的可以去自己尝试一下

上传的图片不能超过5MB,本文的封面图是原图,可以看看画质有多清晰,真的很不错!

4K海边沙滩视频提示词(黄金时段)

日出后/黄昏前,碧蓝海洋渐变至淡紫云层,点缀帆船剪影。金色沙滩铺满细腻沙粒,贝壳散落沙堡旁,潮水慢镜头冲刷泡沫,退潮留下蜿蜒水痕。棕榈叶随风轻摆,海鸥低飞掠过,螃蟹爪印痕迹可见。远处情侣剪影赤足漫步,救生塔静立一隅。琥珀色斜阳为场景镀金,逆光星芒点缀浪尖,云影随风扫过沙滩。镜头高空俯视开场,平移跟随潮汐流动,特写沙粒晶莹与贝壳纹理,结尾环绕全景。风格写实

二、通义千问QWQ-32B技术解析

1. Transformer编码器-解码器架构

Transformer是QWQ32B的核心组件,其通过自注意力机制捕捉长距离依赖关系,取代传统RNN/CNN的局部依赖局限。自注意力机制允许模型动态关注输入序列中的重要位置。多头注意力(MultiHead Attention) 是QWQ32B的改进点之一,通过并行计算多个注意力头,增强模型的表达能力。每个Transformer块包含两个全连接层,通过ReLU激活函数引入非线性。为缓解梯度消失问题,QWQ32B在每个子层后添加残差连接和层归一化。

代码示例:基本Transformer块

import torch

import torch.nn as nn

import torch.nn.functional as F

class TransformerBlock(nn.Module):

def __init__(self, d_model=512, n_heads=8, dropout=0.1):

super().__init__()

self.self_attn = nn.MultiheadAttention(d_model, n_heads, dropout=dropout)

self.feed_forward = nn.Sequential(

nn.Linear(d_model, 2048),

nn.ReLU(),

nn.Dropout(dropout),

nn.Linear(2048, d_model)

)

self.norm1 = nn.LayerNorm(d_model)

self.norm2 = nn.LayerNorm(d_model)

def forward(self, x):

# 自注意力机制

attn_out, _ = self.self_attn(x, x, x)

x = self.norm1(x + attn_out) # 残差连接 + 归一化

# 前馈网络

ff_out = self.feed_forward(x)

x = self.norm2(x + ff_out)

return x技术解析

自注意力机制:通过`MultiheadAttention`捕捉输入序列的全局依赖关系。

前馈网络:每个位置独立变换特征,提升模型表达能力。

残差连接与层归一化:缓解梯度消失问题,加速训练。

2. 混合专家模型(MoE)实现

MoE通过动态分配计算资源,提升模型效率与性能。 MoE的核心是门控机制(Gating)与专家网络(Experts):

门控层:为每个输入选择最相关的专家。

专家网络:多个独立的前馈网络,负责特定任务的细粒度计算。

QWQ32B采用Top2门控,每个输入Token分配到两个最合适的专家,通过加权融合输出。MoE通过稀疏门控减少计算量,仅激活部分专家。

代码示例:MoE层

class MoE(nn.Module):

def __init__(self, d_model=512, num_experts=4, top_k=2):

super().__init__()

self.experts = nn.ModuleList([

nn.Linear(d_model, d_model) for _ in range(num_experts)

])

self.gating = nn.Linear(d_model, num_experts)

self.top_k = top_k 每个token选择top2专家

def forward(self, x):

计算门控权重

gate_logits = self.gating(x)

gate_weights = F.softmax(gate_logits, dim=1)

选择Topk专家

top_indices = torch.topk(gate_weights, k=self.top_k, dim=1).indices

top_weights = torch.gather(gate_weights, 1, top_indices)

动态分配计算

outputs = []

for i in range(x.shape[0]):

expert_out = 0

for k in range(self.top_k):

idx = top_indices[i, k]

weight = top_weights[i, k]

expert_out += weight self.experts[idx](x[i])

outputs.append(expert_out)

return torch.stack(outputs)技术解析

门控机制:通过`gating`层为每个输入分配专家权重。

Topk选择:每个token动态选择最相关的专家,提升计算效率。

并行计算:专家网络可分布式部署,减少延迟。

3. 多模态融合模块

- QWQ32B通过对比学习将文本和图像映射到共享语义空间。

- 视觉模块采用Vision Transformer(ViT)。

代码示例:文本与图像联合编码

class MultimodalModel(nn.Module):

def __init__(self, text_encoder, image_encoder, proj_dim=512):

super().__init__()

self.text_encoder = text_encoder

self.image_encoder = image_encoder 如ResNet或Vision Transformer

self.text_proj = nn.Linear(512, proj_dim)

self.image_proj = nn.Linear(512, proj_dim)

def forward(self, text, image):

编码文本和图像

text_emb = self.text_encoder(text)

image_emb = self.image_encoder(image)

投影到共享语义空间

text_proj = self.text_proj(text_emb)

image_proj = self.image_proj(image_emb)

计算相似度(用于训练对比损失)

similarity = F.cosine_similarity(text_proj, image_proj)

return similarity技术解析

- 跨模态对齐:通过`proj_dim`将文本和图像特征映射到同一空间。

- 对比学习:通过最大化正样本(文本图像配对)的相似性,学习联合语义表示。

4. 动态上下文理解

QWQ32B采用编码器解码器结构,分为以下层:

- 编码器:处理输入文本,生成上下文感知的隐向量。

- 解码器:基于编码器输出生成目标文本。

- 中间层:嵌入MoE模块,增强复杂任务处理能力。

- 解码器:基于编码器输出生成目标文本。

代码示例:对话状态追踪

class DialogStateTracker(nn.Module):

def __init__(self, d_model=512):

super().__init__()

self.history_encoder = nn.GRU(d_model, d_model)

self.state_update = nn.Linear(d_model 2, d_model)

def forward(self, current_input, history_state):

编码当前输入与历史状态

_, current_state = self.history_encoder(current_input.unsqueeze(0))

combined = torch.cat([current_state.squeeze(0), history_state], dim=1)

更新状态向量

new_state = torch.tanh(self.state_update(combined))

return new_state技术解析

GRU网络:处理对话历史,捕捉时序依赖。

状态融合:结合当前输入与历史状态,生成新的对话状态向量。

5. 训练与推理流程

QWQ32B采用以下预训练任务:

1. 掩码语言建模(MLM):随机遮蔽15%的Token,预测缺失内容。

2. 下一句预测(NSP):判断两段文本是否连续。

3. 多模态对齐:最大化文本图像配对的相似度。

通过模型并行和数据并行加速训练

模型并行:将模型分割到多块GPU

model = nn.DataParallel(model, device_ids=[0,1,2,3])

数据并行:分布式数据并行(DDP)

import torch.distributed as dist

from torch.nn.parallel import DistributedDataParallel as DDP

dist.init_process_group(backend='nccl')

model = DDP(model, device_ids=[local_rank])代码示例:训练循环(简化版)

假设模型已定义为model,损失函数为criterion

optimizer = torch.optim.Adam(model.parameters(), lr=1e4)

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

for epoch in range(10):

for batch in dataloader:

inputs, targets = batch

inputs, targets = inputs.to(device), targets.to(device)

前向传播

outputs = model(inputs)

loss = criterion(outputs, targets)

反向传播

optimizer.zero_grad()

loss.backward()

optimizer.step()

print(f"Epoch {epoch+1}, Loss: {loss.item():.4f}")技术解析

分布式训练:实际训练使用模型并行(如ZeRO优化)和数据并行(AllReduce)。

混合精度训练:通过`torch.cuda.amp`降低内存占用。

6. 安全控制与伦理校验

- 动态计算路径(Dynamic Computation Pathways)是根据任务复杂度动态调整计算资源。

- 伦理与安全控制是通过双塔模型分离内容生成与安全校验。

代码示例:内容过滤

class SafetyFilter(nn.Module):

def __init__(self, toxic_detector, controversial_topics):

super().__init__()

self.toxic_detector = toxic_detector

self.topics = controversial_topics 预定义敏感主题

def forward(self, text):

检测毒性内容

toxicity = self.toxic_detector(text)

if toxicity > 0.7:

return "内容违反安全规范"

检查敏感主题

for topic in self.topics:

if topic in text.lower():

return f"警告:涉及{topic}相关内容"

return text技术解析

双塔模型:生成塔(Content Tower)负责生成文本,安全塔(Safety Tower)负责过滤。

阈值控制:通过调整`toxicity`阈值平衡安全性和表达自由。

7. 性能与应用场景

| 任务 | 准确率(SOTA对比) |

|---|---|

| 自然语言推理(GLUE) | 85.2%(超越人类基准) |

| 代码生成(HUMAN-EVAL) | 72%(TOP-1生成成功率) |

| 多模态理解(VQA) | 65.2%(Rank-1) |

典型的应用场景:

文本生成:自动写作、客服对话。

代码辅助:智能代码补全、错误调试。

多模态应用:视觉问答(VQA)、图文生成。

8. 代码实现与部署

完整模型定义示例

class QWQ32B(nn.Module):

def __init__(self):

super().__init__()

self.embedding = nn.Embedding(vocab_size, d_model)

self.positional_encoding = PositionalEncoding(d_model)

self.encoder = nn.ModuleList([

TransformerBlock(d_model, n_heads=16) for _ in range(24)

])

self.moe_layers = [3, 7, 11, 15, 19] MoE层位置

def forward(self, x):

x = self.embedding(x)

x = self.positional_encoding(x)

for i, layer in enumerate(self.encoder):

if i in self.moe_layers:

x = MoE_layer(x)

else:

x = layer(x)

return x通过知识蒸馏压缩模型

蒸馏损失函数

def distillation_loss(student_logits, teacher_logits, T=3):

soft_loss = nn.KLDivLoss()(F.log_softmax(student_logits/T, dim=1),

F.softmax(teacher_logits/T, dim=1)) (TT)

hard_loss = F.cross_entropy(student_logits, targets)

return soft_loss + hard_loss三、结语

QWQ32B通过混合专家架构、多模态融合、动态计算优化等技术创新,实现了在语言理解、生成和推理任务中的卓越性能。其开源性和可扩展性,使其成为企业级AI应用的基石。未来,随着模型规模扩展和算法优化,大模型将在垂直领域(如医疗、金融)发挥更大价值。

附录:关键术语解释

MoE(Mixture of Experts):通过多个专家网络动态分配计算资源。

Top2门控:每个输入选择两个专家并加权融合输出。

对比学习:通过最大化正样本相似度学习跨模态表征。

核心思想一致:

1. 混合专家(MoE):提升效率与性能。

2. 多模态对齐:实现跨模态理解。

3. 动态计算:适配不同任务需求。

4. 安全控制:确保输出符合伦理规范。

718

718

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?