1.多模态微调

首先创建开发机,然后安装XTuner。

# 如果你是在 InternStudio 平台,则从本地 clone 一个已有 pytorch 的环境:

# pytorch 2.0.1 py3.10_cuda11.7_cudnn8.5.0_0

cd ~ && studio-conda xtuner0.1.17

# 如果你是在其他平台:

# conda create --name xtuner0.1.17 python=3.10 -y

# 激活环境

conda activate xtuner0.1.17

# 进入家目录 (~的意思是 “当前用户的home路径”)

cd ~

# 创建版本文件夹并进入,以跟随本教程

mkdir -p /root/xtuner0117 && cd /root/xtuner0117

# 拉取 0.1.17 的版本源码

git clone -b v0.1.17 https://github.com/InternLM/xtuner

# 无法访问github的用户请从 gitee 拉取:

# git clone -b v0.1.15 https://gitee.com/Internlm/xtuner

# 进入源码目录

cd /root/xtuner0117/xtuner

# 从源码安装 XTuner

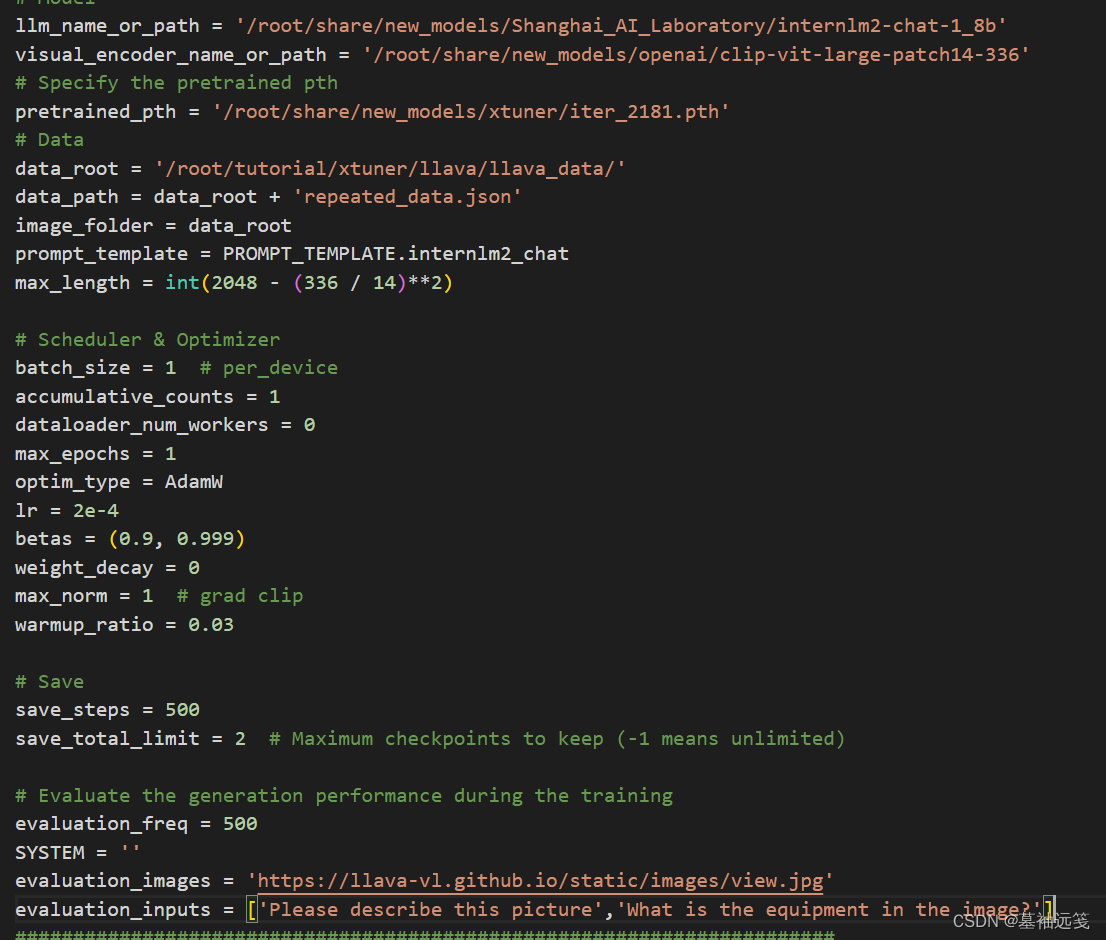

pip install -e '.[all]' && cd ~然后创建配置文件和修改,后开始Finetune

cd /root/tutorial/xtuner/llava/

xtuner train /root/tutorial/xtuner/llava/llava_internlm2_chat_1_8b_qlora_clip_vit_large_p14_336_lora_e1_gpu8_finetune_copy.py --deepspeed deepspeed_zero2

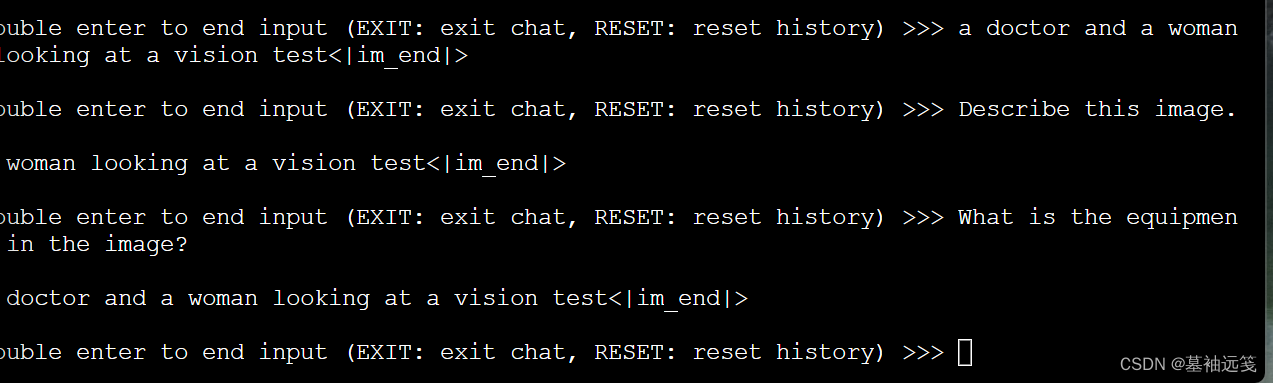

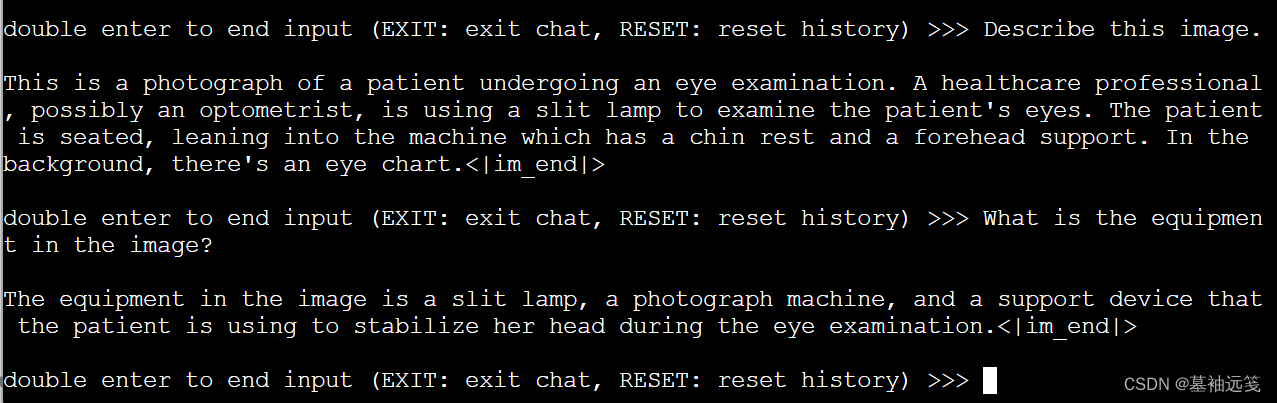

对比Finetune前后的性能差异

这是微调前

微调后,可以更好的回答问题。

2.将自我认知的模型上传到 OpenXLab,并将应用部署到 OpenXLab

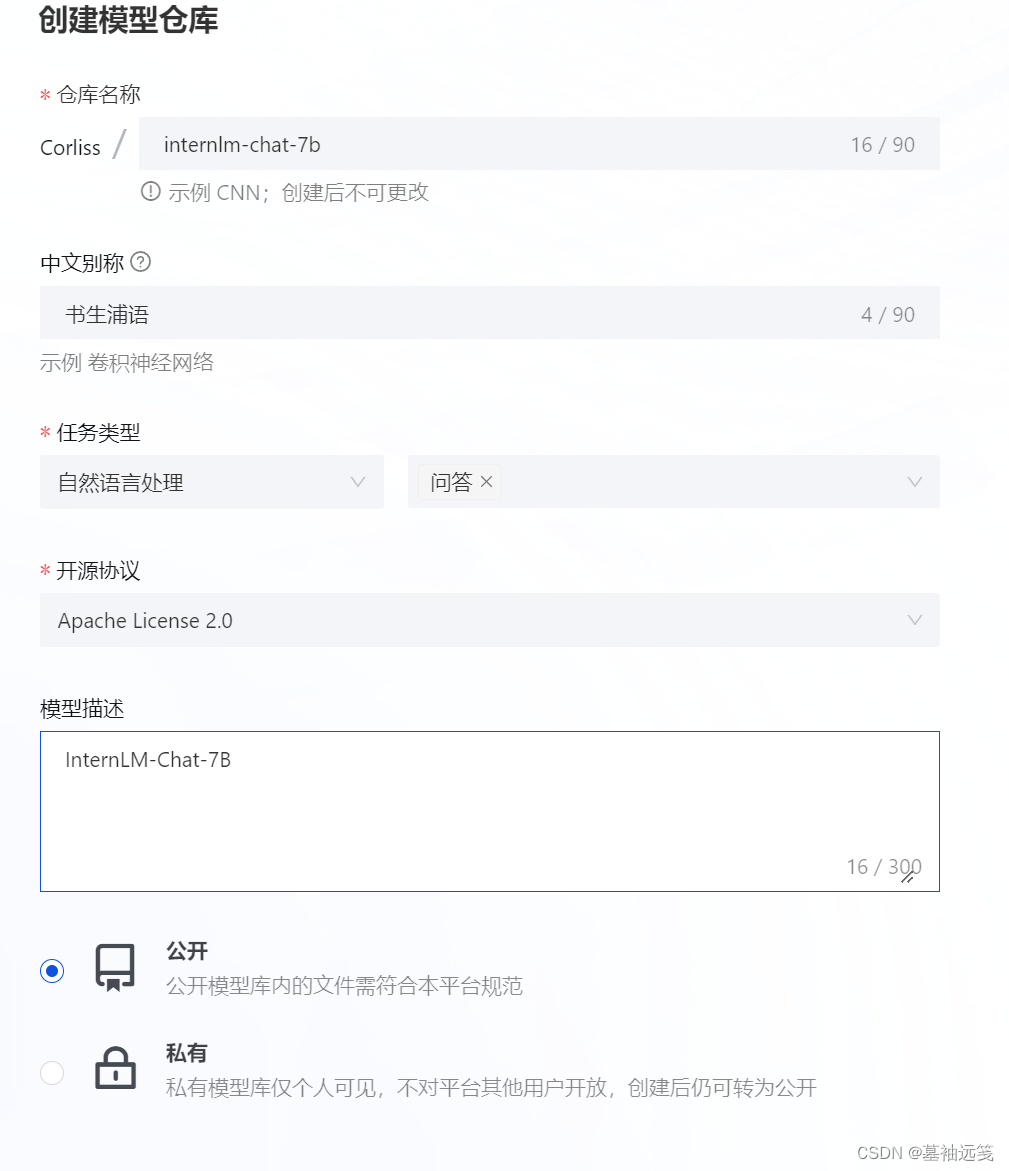

准备InternLM2-Chat-7B的预训练模型,然后初始化git配置,并设置 Git 用户名,OpenXLab 使用你在平台的用户名作为 Git的用户名。在 OpenXLab 先创建一个空仓库,填写模型仓库的基本信息,创建完成空的模型仓库后,找到该仓库的 git 地址并拉取该空仓库至本地,空仓库的地址在模型文件的下载,找到空仓库下的 git 地址,执行 git clone 操作。

在 OpenXLab 的密钥管理添加 Git 令牌,

在克隆的仓库目录中整理模型文件,即将你的模型文件放入至clone的目录中,并执行git push命令将模型推送至远程仓库,本地 clone 的文档目录结构如下所示:

├─internlm2-chat-7b

│ ├─.gitattributes

│ ├─README.md

│ ├─config.json

| ├─configuration_internlm.py

| ├─generation_config.json

| ├─modeling_internlm2.py

| ├─pytorch_model-00001-of-00008.bin

| ├─pytorch_model-00002-of-00008.bin

| ├─pytorch_model-00003-of-00008.bin

| ├─pytorch_model-00004-of-00008.bin

| ├─pytorch_model-00005-of-00008.bin

| ├─pytorch_model-00006-of-00008.bin

| ├─pytorch_model-00007-of-00008.bin

| ├─pytorch_model-00008-of-00008.bin

| ├─pytorch_model.bin.index.json

| ├─special_tokens_map.json

| ├─tokenization_internlm.py

| ├─tokenizer.model

│ └─tokenizer_config.json

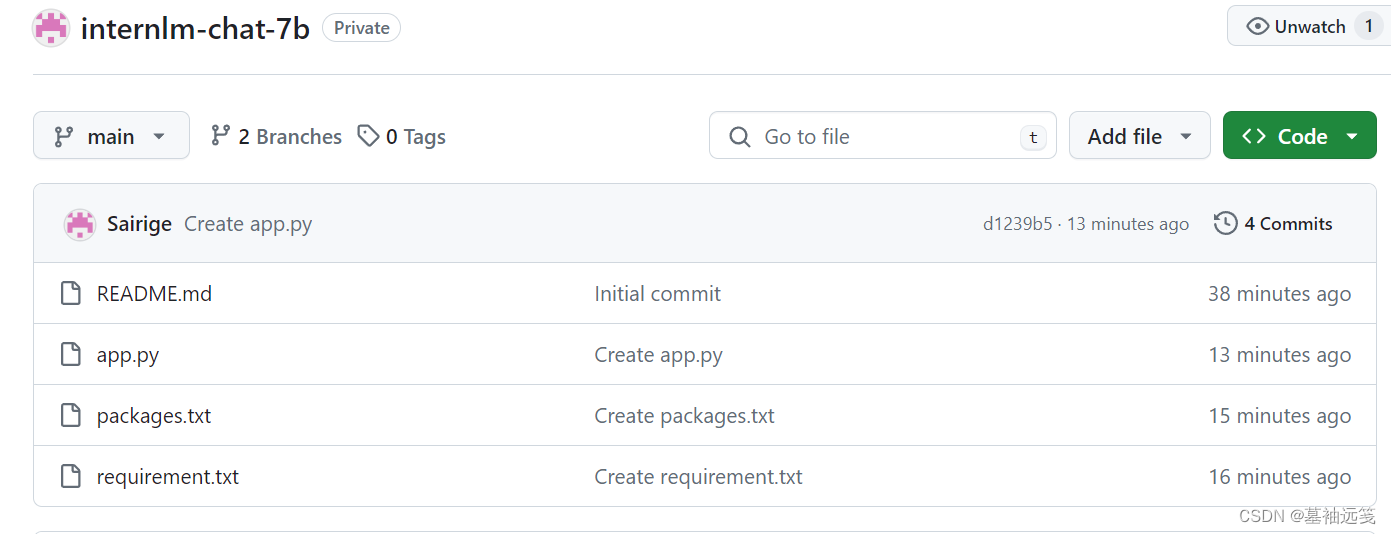

然后编写代码,创建一个新的 GitHub 仓库来存放您的 gradio 应用代码。

编写完应用代码,记得推动您的应用代码至 GitHub 仓库中,推送本地代码至 GitHub 的命令如下:

cd internlm2-chat-7b-git

git add -A

git commit -m "add app.py requirements.txt packages.txt"

git push在OpenXLab浦源平台选择Gradio组件,开始创建,填入 GitHub 仓库的地址,创建

应用构建成功后就可以使用了。

参考资料

视频地址: https://b23.tv/QUhT6ni

课程文档:https://github.com/InternLM/Tutorial/blob/camp2/xtuner/readme.md

117

117

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?