具体代码在之前已经大致讲过了,这里讲讲微调的过程和最终的结果。

一、租借服务器

我的笔记本只有CPU跑的太慢,Google的colab虽然提供免费的GPU资源但是有限制的,基本一天只能用一会然后就中断了……所以还是去租了服务器。

网站:Autodl算力云

注册一个账号,充值一些金额,然后就可以选需要的服务器了。

租用的时候尽量选GPU充足的:

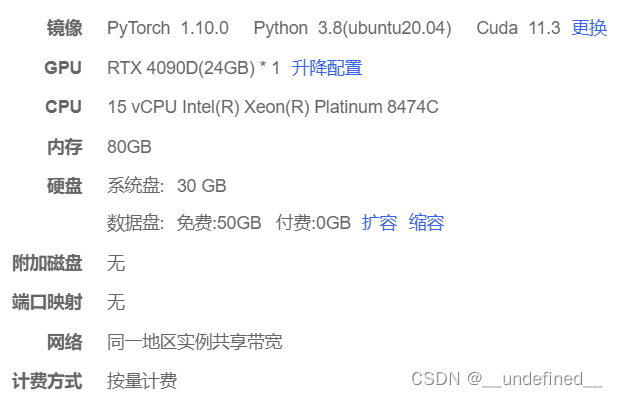

我的配置:

开机之后,可以点击Jupyter lab线上跑,也不用登录,很方便。

直接在jupyter lab中上传自己的数据集、sam原始模型、训练代码。

新建终端

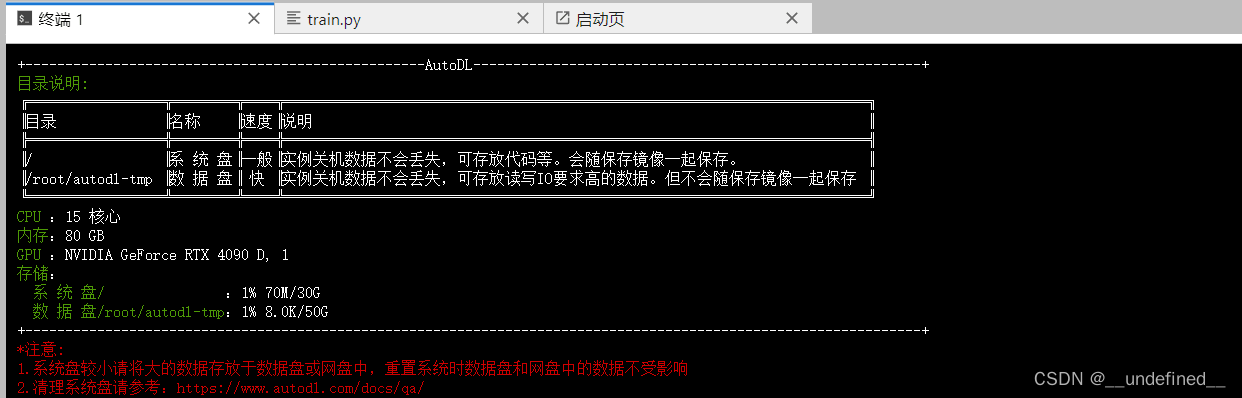

点击新建终端,就会出现这个页面,代表已经在服务器上了。

配置环境

服务器上只有一些基本的包,比如torch之类的,如果需要其他的包需要手动安装:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?