本文全面概述了大型语言模型(LLMs)在持续学习(CL)背景下的研究进展。涵盖垂直与水平持续学习,学习阶段,评估协议及当前数据源。

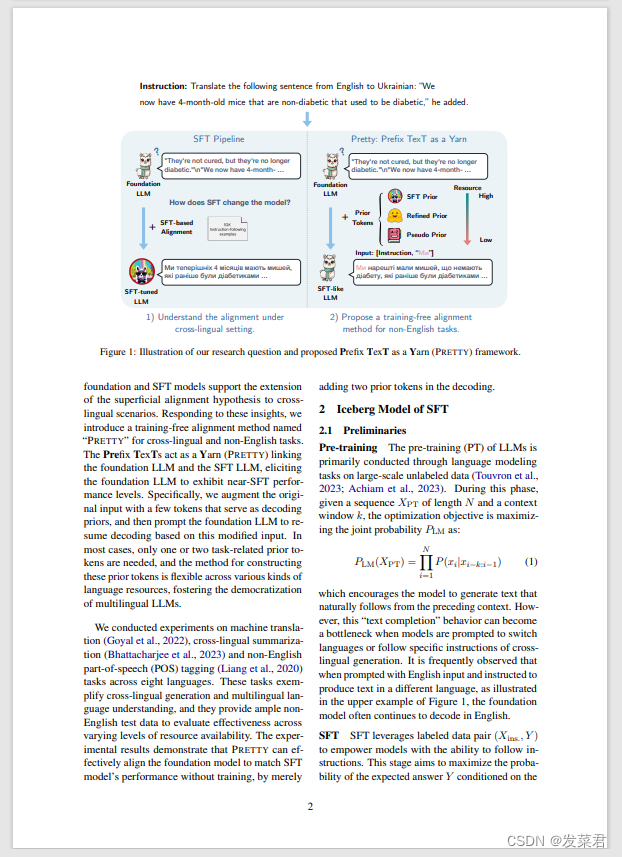

虽然监督微调 (SFT) 是一种根据特定偏好定制基础大型语言模型 (LLM) 输出的直接方法,但人们对这种一致性的深度提出了担忧,一些批评认为它只是“肤浅的”。我们在跨语言生成任务的范围内批判性地检验了这一假设,提出SFT的有效性可能受到其对先前标记的依赖来指导跨语言生成的限制。基于这一关键的见解,并为了应对SFT非英语数据昂贵且可用性有限的挑战,我们引入了一种名为PreTTY的新型免训练对齐方法,该方法使用最少的任务相关先验标记来桥接基础LLM和SFT LLM,无需训练即可实现可比的性能。八种语言的机器翻译和词性标记实验证明了 PreTTY 在跨语言环境中的功效。值得注意的是,通过仅使用一个或两个先前的标记启动解码过程,基金会 LLM 可以实现与 SFT 对应物相当的性能。这种方法提供了一种具有成本效益的SFT替代方案,并促进了多语言LLM的民主化。

想要论文资源的可以找我拿 ******

******

4559

4559

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?