前言

久章智能

Stable Diffusion是一种基于扩散模型(Diffusion Models)的生成技术,近年来在图像生成和其他生成任务中取得了显著的进展。该技术以其高质量的生成效果、稳定的训练过程和广泛的应用前景,迅速在学术界和工业界引起了广泛关注。

以下是关于Stable Diffusion的详细介绍。

01 Diffusion Model的概念

所有的AI设计工具,模型和插件,都已经整理好了,👇获取~

在前向的过程中,不断地向数据中加入噪音,让图像由原本的状态转化为噪音点,最后变成纯噪声。加入的噪声要满足固定的分布,比如标准的高斯分布。前向的过程也称为扩散的过程。

图:向原始图片中线性添加噪声的变化过程

扩散模型的逆向过程是利用贝叶斯公式,从噪声图片中一步一步的去噪,倒推拟合加上噪音前的那张图片。扩散模型的逆向过程也可以用信息熵的变化来解释。从高熵的纯噪声状态开始,逐步减少数据的随机性和不确定性,通过去噪过程逐步恢复原始数据的结构和特征。

Diffusion Model总结为“前向加噪-反向降噪-训练”的结构。

02 Stable Diffusion介绍

Stable Diffusion建立在Latent Diffusion Models的基础上,借鉴了Google的Imagen,实现了将文字prompt作为条件参与到扩散模型的生成过程中。扩散模型不同于VAE和GAN,扩散模型是从噪音点中一步一步生成,因此需要的计算资源更多。Stable Diffusion可以规避模式坍塌的问题,这类问题常常存在于GAN训练的过程中。(模型坍塌,Mode-collapse,是指生成器倾向于生成同一类别的样本,而忽略了数据集中其他模式的存在。)

图:用Stable Diffusion和DALL-E、VQGAN生成图与原始图片的对比

此外,通过引入交叉注意力层到Stable Diffusion的模型可以将文本、边界框与图像通过统一的方式折射到扩散模型中。由此可实现Stable Diffusion在图像修复、以类别为条件的图像生成、文本生成图像、无条件的图像生成等任务上很好的性能。

图:交叉注意力机制调节LMDs的原理图

03 Stable Diffusion与VAE、GAN的对比

表:Stable Diffusion、VAE、GAN在原理、优缺点等方面的对比表格

综上,Stable Diffusion通过扩散过程生成样本,可以产生高质量的结果,但计算成本较高。VAE提供了一种概率框架,可以学习潜在空间并从中采样,但生成的样本可能不够锐利。GAN通过对抗学习生成高度逼真的样本,但训练过程较为复杂且不稳定。

尽管这三种模型各有优缺点,但在某些情况下,Stable Diffusion相比于VAE和GAN可能更具优势。特别是当需要高质量的图像生成、支持丰富的条件生成任务(如文本到图像)、并且可以接受较高的计算成本时,Stable Diffusion是一个很好的选择。此外,Stable Diffusion 的训练和使用相对更加稳定,这使得它在实际部署中更为可靠。

最终,选择哪种模型取决于具体的应用需求、可用的计算资源以及对生成样本质量的要求。例如,如果项目预算有限且对生成速度有要求,则可能更倾向于使用VAE;如果需要生成非常真实的图像且愿意投入更多的时间和计算资源,则Stable Diffusion可能更适合。

参考文献

[1] Improved Denoising Diffusion Probabilistic Models.Alex Nichol, Prafulla Dhariwal. Alexander Quinn Nichol, Prafulla Dhariwal Proceedings of the 38th International Conference on Machine Learning, PMLR 139:8162-8171, 2021. Available:https://proceedings.mlr.press/v139/nichol21a/nichol21a.pdf

[2] High-Resolution Image Synthesis with Latent Diffusion ModelsRobin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, Bjorn Ommer , Available: https://arxiv.org/pdf/2112.10752.pdf

[3] J. Li, S. Wang, and D. Chen, Hierarchical Variational Autoencoders with Dynamic Latent Structure Learning, IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 46, no. 7, pp. 1374-1388, July 2024, doi: 10.1109/TPAMI.2023.3300123.

[4] M. Kim, L. Zhou, and Y. Lee, Disentangled Representation Learning with Adversarial Regularization in Variational Autoencoders, Journal of Machine Learning Research, vol. 25, no. 1, pp. 1-30, March 2024, doi: 10.5555/3349152.3349178.

[5] E. Odena, A. Olah, and J. Shlens, Conditional Image Synthesis with Auxiliary Classifier GANs, arXiv preprint arXiv:2403.01248, Mar. 2024. [Online]. Available: http://arxiv.org/abs/2403.01248

[6] S. Ioffe, C. Szegedy, and J. Shlens, Improved Techniques for Training Generative Adversarial Networks, Advances in Neural Information Processing Systems, vol. 30, pp. 246-256, Dec. 2023, doi: 10.5555/3327846.3327878.

感兴趣的小伙伴,赠送全套AIGC学习资料和安装工具,包含AI绘画、AI人工智能等前沿科技教程,模型插件,具体看下方。

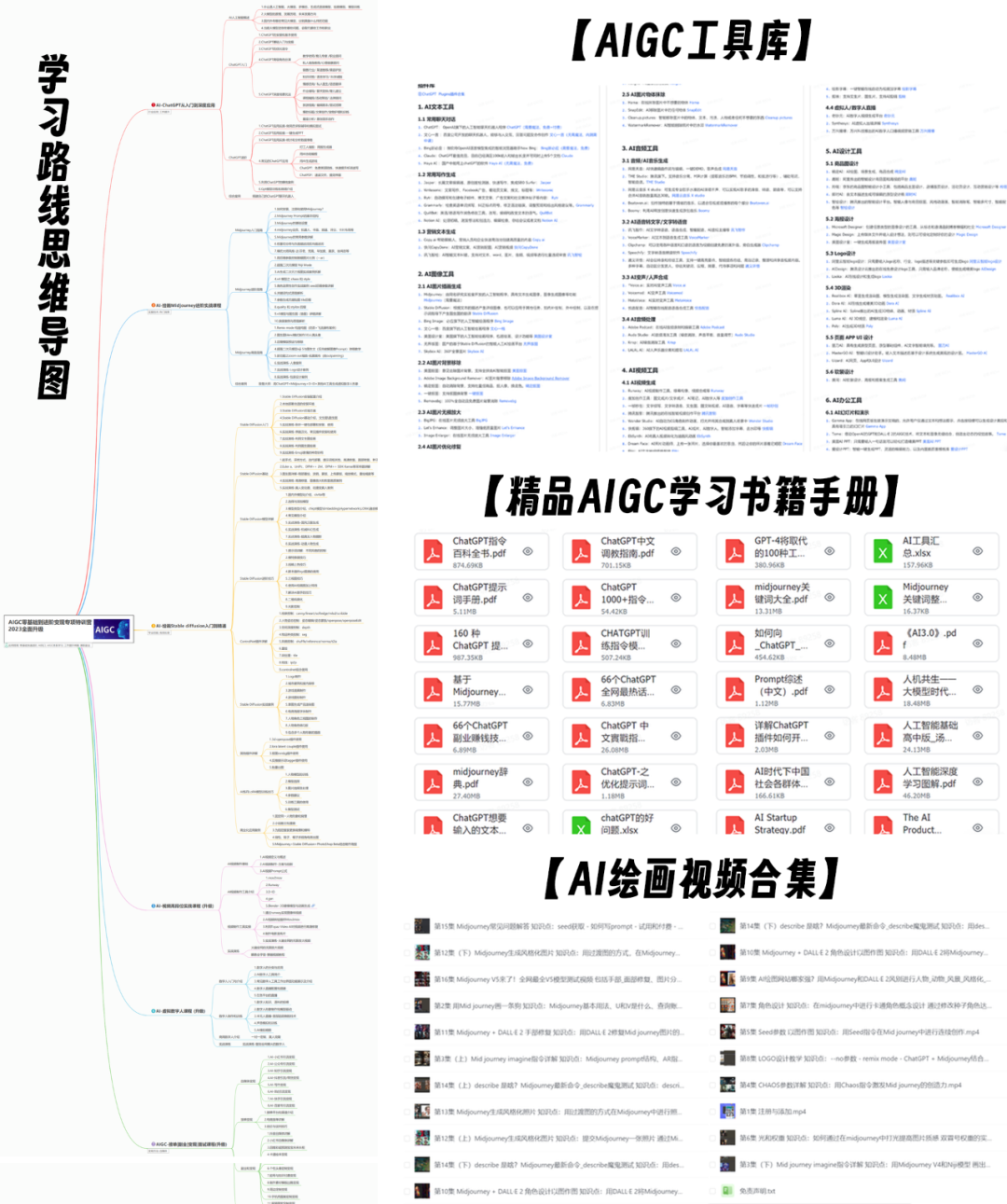

一、AIGC所有方向的学习路线

AIGC所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

二、AIGC必备工具

工具都帮大家整理好了,安装就可直接上手!

三、最新AIGC学习笔记

当我学到一定基础,有自己的理解能力的时候,会去阅读一些前辈整理的书籍或者手写的笔记资料,这些笔记详细记载了他们对一些技术点的理解,这些理解是比较独到,可以学到不一样的思路。

四、AIGC视频教程合集

观看全面零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

五、实战案例

纸上得来终觉浅,要学会跟着视频一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

这份完整版的AIGC全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

350

350

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?